1、熵

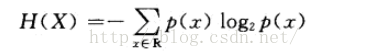

如果X是一个离散型随机变量,取值空间为R,其概率分布为p(x)=P(X=x),x∈R。那么,X的熵H(X)定义为式:

熵又称为自信息,可以视为描述一个随机变量的不确定性的数量。它表示信源X每一个符号所提供的平均信息量。一个随机变量的熵越大,它的不确定性越大,那么,正确估计其值的可能性就越小。越不确定的随机变量越需要大的信息量用以确定其值。

2、联合熵

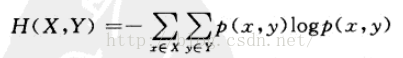

如果X,Y是一对离散型变量X,Y~p(x,y),X,Y的联合熵,H(X,Y)定义为

联合熵是描述一对随机变量平均所需要的信息量

3、条件熵

给定随机变量X的情况下,随机变量Y的条件熵H(Y|x)为

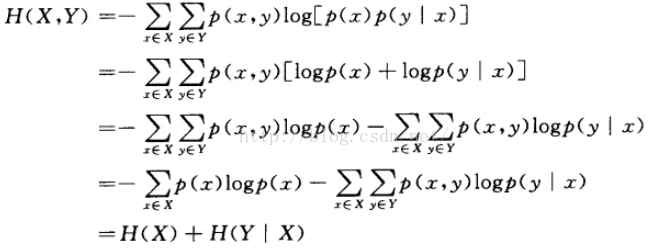

将联合熵中的联合概率log(x,y)展开,可得

一般得,有以下式成立:

4、互信息

1、根据熵的连锁规则,有 H(X,Y)=H(X)+H(Y|X)=H(Y)+H(X|Y)。 因此, H(X)-H(X|Y)=H(Y)-H(Y|X)

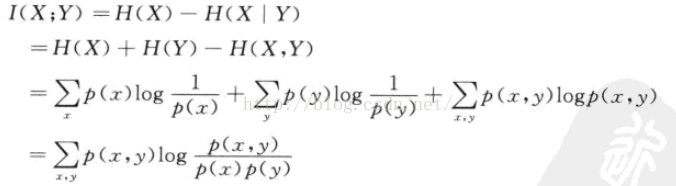

这个差叫做X和Y的互信息,记作 I(x;y)。或者定义为如果 (X,Y)~p(x,y),则X,Y之间的互信息 I(X;Y)=H(X)-H(X|Y)

2、 I(X;Y)反映的是在知道了Y的值以后X的不确定性的减少量

3、将定义中的H(X)和H(X|Y)展开,可得:

4、由于H(X|X)=0,因此, H(X)=H(X)-H(X|X)=I(X;X)

这说明了熵为什么又称为自信息,也说明了两个完全依赖的变量之间的互信息并不是一个常量,而是取决于它们的熵

5、互信息体现了两变量之间的依赖成都,如果I(X;Y)>>0,表明X和Y是高度相关的;

如果I(X,Y)=0,表明X和Y是相互独立的; 如果I(X;Y)<<0,表明X和Yahi互不相关的分布

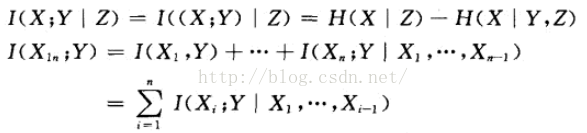

6、同样,条件互信息和互信息的连锁规则:

5、相对熵

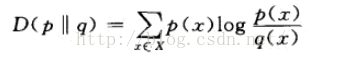

1、相对熵又称KL距离,是衡量相同事件空间里两个概率分布相对差距的测度。两个概率分布p(x)和q(x)的相对熵定义为:

当两个随机分布完全相同时,即p=q,其相对熵为0。当两个随机分布的差别增加时,其相对熵期望值也增大。

2、互信息实际上就是衡量一个联合分布与独立性差距多大的测度:

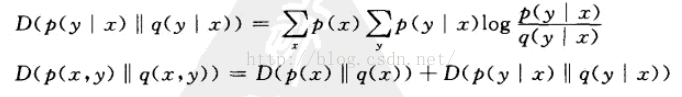

3、可推导出条件相对熵和相对熵的连续规则:

6、交叉熵

1、交叉熵就是用来衡量估计模型与真实模型分布之间差异情况的。

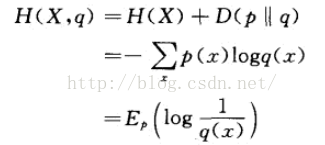

2、如果一个随机变量X~p(x),q(x)为用于近似p(x)的概率分布,那么,随机变量和模型q之间的交叉熵定义为:

最后一步为用期望表示

1815

1815

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?