此文同步到 : 卷积神经网络与图像识别基本概念

一 卷积神经网络的组成

图像分类可以认为是给定一副测试图片作为输入

IϵRW×H×C

,输出该图片

属于哪一类。参数 W 是图像的宽度,H 是高度,C 是通道的个数;彩色图像中 C = 3,灰度图像

中 C = 1。一般的会设定总共类别的个数,例如在ImageNet竞赛中总共有 1000 个类别;在CIFAR10 中有 10 个类别。卷积神经网络则可以看成这样的黑匣子。输入是原始图片 I,输出是 L 维的向量

vϵRL

。L表示预先设定的类别个数。向量 v 的每一个维度代表图像属于对应类别的可能性的大小。如果是

单类别识别问题,也就是说每一幅图像只分配 L 个标签中的一个标签,那么可以对 v 中的元素进行比较,选取最大的值对应的标签作为分类的结果。v 可以是一个概率分布的形式,即每一个元素

0≤vi≤1

,并且

∑ivi=1

。其中

vi

表示 v 的第 i 个元素。也可以是从负无穷大到正无穷大的实数,越大代表属于对应类别的可能性越大。在卷积神经网络的内部,是由很多的层构成。每一个层可以认为是一个函数,输入是信号 x,输出是信号

y=f(x)

。输出的 y 又可以作为其他层的输入。以下从网络的前段,中端,末端的角度调研常用的层的定义。前端主要考虑对于图像的处理过程,中端是各种神经元,末端主要考虑与训练网络有关的损失函数。

二 网络的前段

前段指 的是对图像数据的处理,可以称之为数据层。

2.1 数据裁减

输入的图像的大小可能各不相同,有一些图像的分辨率较大,有一些比较小。而且长宽比也不一定会一样。对于这样的不一致性,理论上而言,可以不予处理,但是这要求网络中其他的层次支持这样的输入。目前大部分情况下采用的是通过裁剪的方法使得输出的图像是固定分辨率的。

在网络训练的阶段,裁剪的位置从原始的图像上随机选择,只需要满足裁剪

的子图完全落在图像中即可。通过随机的方式,是因为相当于增加了额外的数据,能够缓解过拟合的问题。

2.2 颜色干扰

裁剪之后的原图,每一个像素的是 0 到 255 的固定的数值。进一步的处理,包括减去均值,以及等比例缩放像素值使得像素值的分部基本在 [−1, 1] 之间。除了这些常规的操作之外,也会对图像进行归一化,相当于图像增强,比如 [9, 18, 17] 中对 CIFAR10 的数据预处理中。比如,对于每一个像素,随机选择 RGB 三个通道中的一个,然后在原像素值的基础上,随机添加一个从 [-20,20] 之间的数值。

三 网络的中段

以下介绍在卷及神经网络中常用的层的定义,即输入的数据 x 是什么维度,输出 y 是什么维度以及如何从输入得到输出。

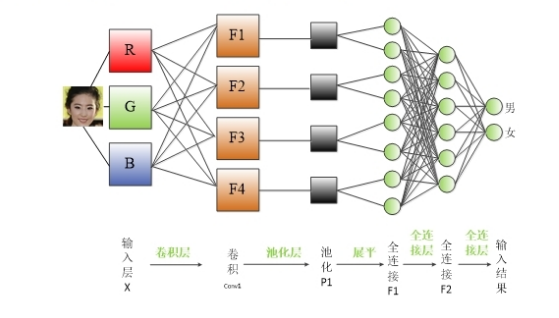

3.1 卷积神经网络的基本组成

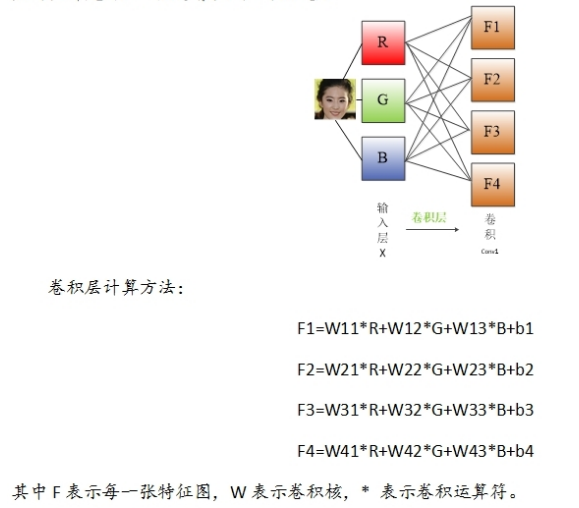

如下图:

3.2 卷积层

卷积层输入表示为

xϵRW×H×C

,是一个三维的数据。表示有C个矩阵,每个矩阵这里表示为

xcϵRW×H

,也称之为特征图。输出

yϵRW0×H0×C0

,也是一个三维数据。特征图分辨率从

W×H

变为

W0×H0

,特征图的个数也从C变为

C0

。

从输入到输出的一般公式为:

矩阵

wc,c1ϵRw×h

称之为卷积核。属于卷积层的参数,一般通过随机梯度下降更新。

xc

为输入数据的第 c 个特征图,但在一些情况下,也会在图像的周围补白。符号 ∗ 表示二维数据的卷积运算。卷积定义为

符号 ()u,v 表示对应矩阵的 u 行 v 列的元素值。在有一些的网络结构中,并不是选择所有的 (u, v),而是每隔一定数量选择一个。

直观而言,卷积层相当于对图像进行滤波,希望能够抽象出来局部信息。局部信息通过较小的卷积核在图像不同的局部位置上扫描而得。

下图是是一个动态示例,来源于 convolutional-networks

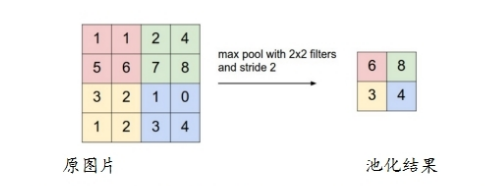

3.3 池化层

输入的信号表示为 xϵRW×H×C ,具有 C 个通道,每一个通道是一个特征图。输出 yϵRW0×H0×C 具有的通道个数与输入相同,但是特征图的分辨率一般是降低。

池化层是对每一个特征图单独进行操作并且输出一个对应的特征图。假设池化范围是 w×h ,那么输入的特征图提取出来 w×h 的小图,然后寻找子图的最大值,或者计算子图的均值,作为一个输出。签证一般称之为最大化池化,后者是均值池化。从图像中提出小图的方式可以是任意一个子图,也可以是每隔多个像素值得到一个子图。池化层的作用包括降低特征图的分辨率,从而减少计算量,以及增强网络的鲁棒性。比如对于最大化池化的方式,对于图像的平移具有一定的鲁棒性。

池化层的作用包括降低特征图的分辨率,从而减少计算量,以及增强网络的鲁棒性。比如对于最大化池化的方式,对于图像的平移具有一定的鲁棒性。

实例,对于如下特征图 4x4,使用最大池化效果如下:

图中每个像素点的值是上面各个格子的数值,然后要对这张 4*4的图片进行池化;那么采用最大池化也就是对上面 4*4的图片分块,每块大小为2*2,然后统计每个块的最大值,作为下采样后图片的像素值。

3.4 CCCP

CCCP层的输入是

xϵRW×H×C

,输出是

yϵW×H×C

。特征层的分辨率保持不变,但是通道数有所改变。其定义为:

等效于卷积核为 1x1的卷积层。

CCCP 层相当于在多个全连接层,每一个全连接将信号从 C 维度映射为 C0 维度。

3.5 ReLU 层及相关变体

该层的输入认识是一个信号 x。ReLU 并不要求输入信号的维度必须是一维或者几维的,因为该层的操作是对输出的每一个元素单独操作。但依然可以认为输入的

xϵRW×H×C

。输出是一个和输入维度一样的信号y。

假设从输入到输出的一个示例为:

显然这是一个非线性操作,ReLU 的存在使得网络的表达更加丰富。同时从定义中容易得出,该操作非常简单,并且在不同的输入点之间进行并行。ReLU 在一定程度上也是 S 行函数的近似。

进一步将ReLU改进为:

当元素值为负数的时候,通过 yi=0.01xi 的方式,避免了导数为 0,无法传播的情况。

进一步使用修正的ReLu为:

其中斜率 α 不再是一个固定的数值,而是通过梯度下降的方式就行优化

3.6 Dropout层

Dropout层的输入为

xϵRW×H×C

。这里并不要求输入是三维的信号,任意可能的维度都是可以。Dropout 同样是针对每一个数据进行操作。输出 y 与输入的大小一致。在网路进行训练的时候,对于输入的每一个数值

xi

,按照概率 p 设置为 0,否则保留。数学形式可以写为:

其中 ϵ 是随机变量,并且满足 ϵ=0 的概率为 p, ϵ=1 的概率为 1 − p。实际中,概率 p 往往设置

为 1。

然而在进行测试的时候,计算公式更正为 yi=(1−p)xi 相当于一个期望。

Dropout层的引入主要是为了减少过拟合的问题,减少不同参数的耦合性。

3.7 全连接层

输入时

xϵRD

。这里要求将输入认识是一个列向量。输出为

yϵRP

。从输入到输出的关系是:

其中 WϵRP×D,bϵRP ,是投影矩阵阵以及阈值,是该层的参数,通过随机梯度下降的方式更新优化。

全连接层是一个非常常用的层,然而该层在一定程度上会损失图像的空间信息,故而在有一些网络中,抛弃了全连接层。

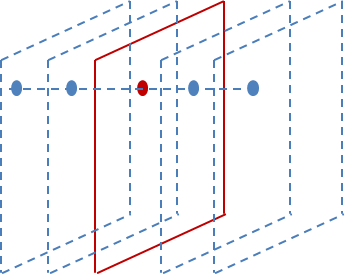

3.8 局部响应归一化(LRN)

LRN层做的事是对当前层的输出结果做平滑处理。下图是示例:

前后几层(对应位置的点)对中间这一层做一下平滑约束。

输入时一个三维信号 xϵRW×H×C ,输出也是一个三维信号 yϵRW×H×C 局部响应一体化层(Local Response Normalization)通过如下公式计算:

其中

xc,v

代表第

c

个通道上位置是

3.9 批归一化层(Batch Normalization)

详细理解参考:Batch Normalization

批归一化层的输入依然是三维的信号

xϵRW×H×C

,输

出 y 与输入具有相同的大小。其归一化的基本思路是对输入的每一个元素按照如下方式归一化:

使得输出的 yi 均值尽量的为 0,以及方差尽量为 1。通过这样的方式,每一层的数据分布基本上一致。该方法能够提升优化的速度。

其优点如下:

- 可以选择比较大的初始学习率,此算法有快速训练收敛的特性。

- 可以不用考虑过拟合中的 Dropout ,L2正则项选择问题,采用BN之后可以移除这两个参数,或者可以选择更小的L2正则约束参数了,因为BN具有提高网络泛化能力的特性。

- 不再需要局部响应归一化层,因为BN本身就是一个归一化网络层。

- 可以完全打乱训练数据,防止每批训练时某些样本经常被挑选到。

四 网络的末端

从网络训练的角度,末端主要是损失函数。也就是将数据映射为一个标量。通过随机梯度下降的方式,使得损失函数逐渐的降低。目前使用比较广泛的是 Softmax 回归和 Hinge 损失函数。

4.1 Softmax回归

较通俗易懂的理解Softmax回归的一篇博客是 Softmax回归

输入时 vϵRL ,表示输入图像在各个类别上的可能性;同时需要输入图像的标签 k。输出是损失值。首先将输入归一化到 [0, 1] 之间,通过 Softmax 函数:

然后通过交叉熵定义损失值,也就是:

该损失函数主要应用与单类别分类问题中。

参考文章:

273

273

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?