作者: 大树先生

博客: http://blog.csdn.net/koala_tree

GitHub:https://github.com/KoalaTree

2017 年 09 月 22 日

以下为在Coursera上吴恩达老师的DeepLearning.ai课程项目中,第一部分《神经网络和深度学习》第三周课程“浅层神经网络”部分关键点的笔记。笔记并不包含全部小视频课程的记录,如需学习笔记中舍弃的内容请至Coursera 或者 网易云课堂。同时在阅读以下笔记之前,强烈建议先学习吴恩达老师的视频课程。

同时我在知乎上开设了关于机器学习深度学习的专栏收录下面的笔记,方便在移动端的学习。欢迎关注我的知乎:大树先生。一起学习一起进步呀!_

神经网络和深度学习—浅层神经网络

1. 神经网络表示

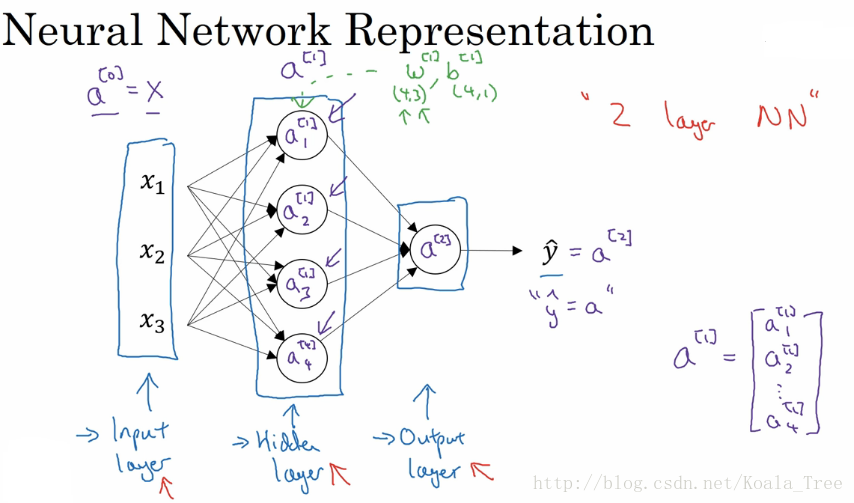

简单神经网络示意图:

神经网络基本的结构和符号可以从上面的图中看出,这里不再复述。

主要需要注意的一点,是层与层之间参数矩阵的规格大小:

- 输入层和隐藏层之间

- w [ 1 ] − > ( 4 , 3 ) w^{[1]}->(4,3) w[1]−>(4,3):前面的4是隐层神经元的个数,后面的3是输入层神经元的个数;

- b [ 1 ] − > ( 4 , 1 ) b^{[1]}->(4,1) b[1]−>(4,1):和隐藏层的神经元个数相同;

- 隐藏层和输出层之间

- w [ 1 ] − > ( 1 , 4 ) w^{[1]}->(1,4) w[1]−>(1,4):前面的1是输出层神经元的个数,后面的4是隐层神经元的个数;

- b [ 1 ] − > ( 1 , 1 ) b^{[1]}->(1,1) b[1]−>(1,1):和输出层的神经元个数相同;

由上面我们可以总结出,在神经网络中,我们以相邻两层为观测对象,前面一层作为输入,后面一层作为输出,两层之间的w参数矩阵大小为 ( n o u t , n i n ) (n_{out},n_{in}) (nout,nin),b参数矩阵大小为 ( n o u t , 1 ) (n_{out},1) (nout,1),这里是作为 z = w X + b z = wX+b z=wX+

本文是吴恩达在Coursera上的DeepLearning.ai课程中关于浅层神经网络的笔记,涵盖了神经网络表示、计算输出、向量化实现、激活函数选择、梯度下降法和随机初始化等内容。重点讲解了激活函数如sigmoid、tanh和ReLU的优缺点,以及神经网络参数的初始化策略。

本文是吴恩达在Coursera上的DeepLearning.ai课程中关于浅层神经网络的笔记,涵盖了神经网络表示、计算输出、向量化实现、激活函数选择、梯度下降法和随机初始化等内容。重点讲解了激活函数如sigmoid、tanh和ReLU的优缺点,以及神经网络参数的初始化策略。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1134

1134

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?