感知机的学习算法非常简单,就是每次选取一个样本,如果预测错误,则根据样本真值,权重加减一个输入向量。这和一般使用的附有学习率的优化算法不一样,没有一个超参数,使其快速而且简洁。而为什么这样一个简单的算法可以work,Hinton在这节加以说明。注意此部分是直观层次的解释,不是严谨的数学推导。

上一节有提到感知机的几何解释,其中有一个结论是在权重空间内,感知机的合法解是连续的,位于一个被多个超平面限制的锥体内,合法解的限制超平面是垂直于样本输入向量的。

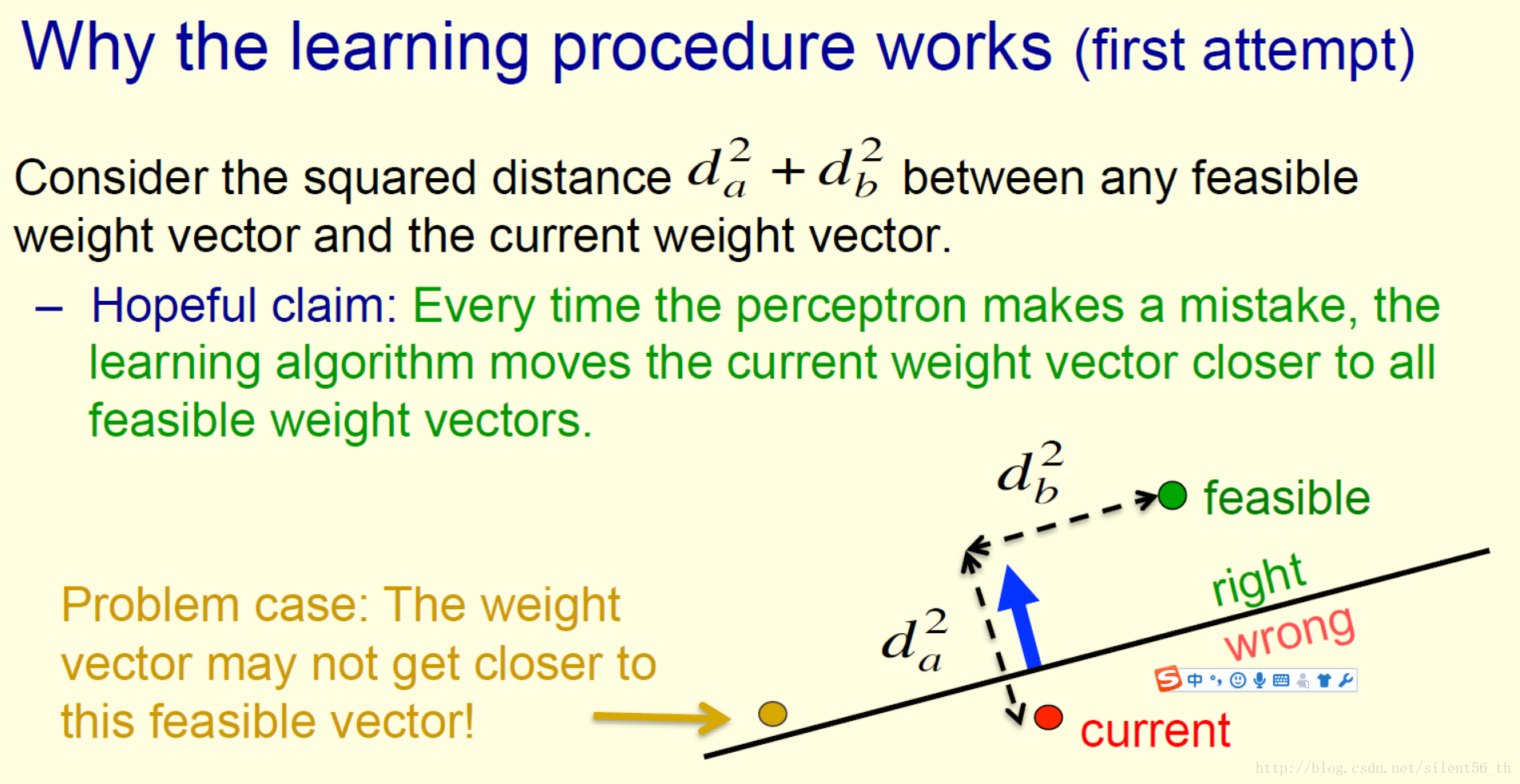

第一个尝试(当然失败了)

想要证明每次移动权重向量的位置,都使得其与所有合法权重向量的位置更近了(欧式距离)。这个目标很让人渴望,但轻易举出了反例。上图右下展示了反例,其中变化前权重向量的位置为红点所示,黄点为一个合法权重向量,因为两者在垂直于超平面方向的距离很小,大于输入向量(蓝色箭头所示)的长度,所以变化后的权重向量距离黄色合法向量的距离反而更远了。

成功的解释

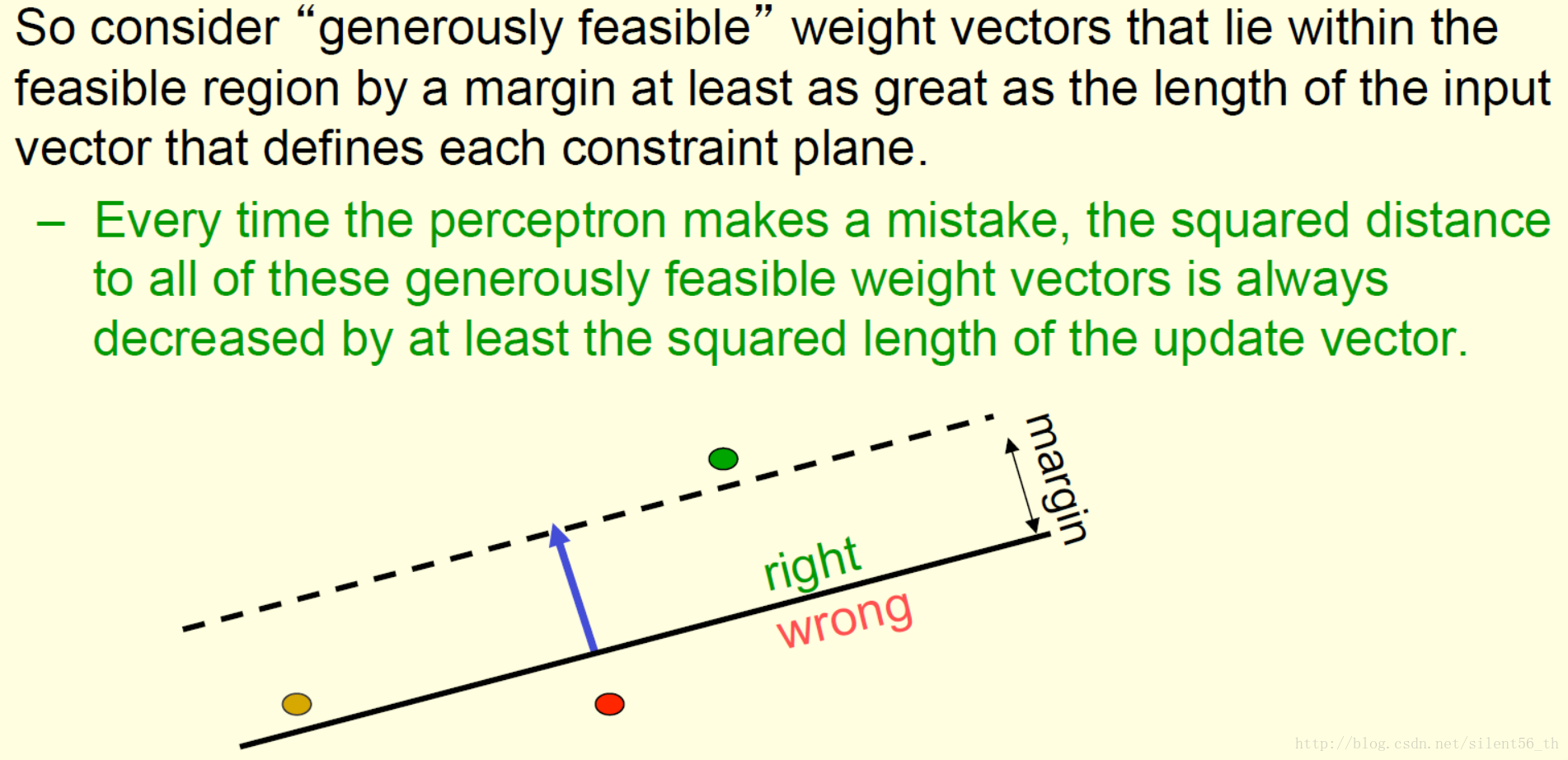

注意到第一次尝试失败的原因在于没有对合法向量做限制,为了证明最终权重向量会变化到合理范围内,只需要证明每一次变化,权重向量距离固定部分合法向量距离越来越近即可。这里考虑到上诉反例主要是因为输入向量的长度大于两者原有垂直距离了,所以对此部分反例的合法向量做了排除,如下图所示:

只考虑距离所有超平面都超过相应输入向量长度的合法向量。如此,即可证明每次优化算法,都使得权重离所有位于generously feasible的合法向量距离更近了,进而因为向量之间的距离有限大、向量的长度有限小,所以必然收敛。(注意,这是基于存在合法向量空间的情况下讨论的;若不存在,则不一定收敛)

笔者的一点思考:

这个优化算法的优点真的很吸引人,简单有效,方便快捷。但也有很大的限制,如上诉证明方法也需要存在一个合法向量空间、合法向量空间很大(只是通过一个超平面切割)等等条件。

4833

4833

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?