Break Point 对成长函数的限制

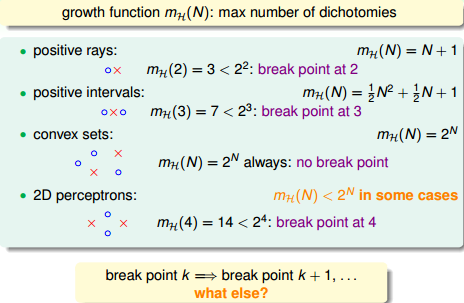

上一讲重点是一些分析机器学习可行性的重要思想和概念,尤其是生长函数(growth function) 和突破点(break point) 的理解(上一节提到的4个成长函数):

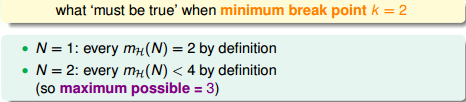

假设对于一个问题,minimum break point k = 2(对于任意2个输入,H不能穷尽所有划分),基于该条件我们做出推论:

即当 N=2 时,成长函数一定 < 2^2=4,所以此时成长函数的 maximum possible value = 3。

当 N=3 时,我们看看成长函数的 maximum possible value 等于多少?

任意3个输入(x1, x2, x3),我们一定能找到以下3个合法的划分:

本文详细探讨了机器学习中的VC界限(VC Bound)和VC维度的概念。通过成长函数、边界函数的分析,解释了VC Bound如何提供机器学习结果可靠性的衡量。讨论了VC Dimension的物理意义,指出其与模型复杂度的关系,并举例说明了VC Bound在数据量估算中的应用。此外,文章还介绍了PLA的VC Dimension,展示了如何证明其等于d+1。

本文详细探讨了机器学习中的VC界限(VC Bound)和VC维度的概念。通过成长函数、边界函数的分析,解释了VC Bound如何提供机器学习结果可靠性的衡量。讨论了VC Dimension的物理意义,指出其与模型复杂度的关系,并举例说明了VC Bound在数据量估算中的应用。此外,文章还介绍了PLA的VC Dimension,展示了如何证明其等于d+1。

订阅专栏 解锁全文

订阅专栏 解锁全文

2523

2523

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?