概要

主要介绍Standalone部署模式下,从命令行执行spark-submit命令提交任务开始,到最后计算结果返回driver的完整过程,主要涉及到spark-core中deploy、executor和scheduler部分,但DAGScheduler相关的部分涉及到内容较多,留作后面详细分析。

Spark Doc中的介绍

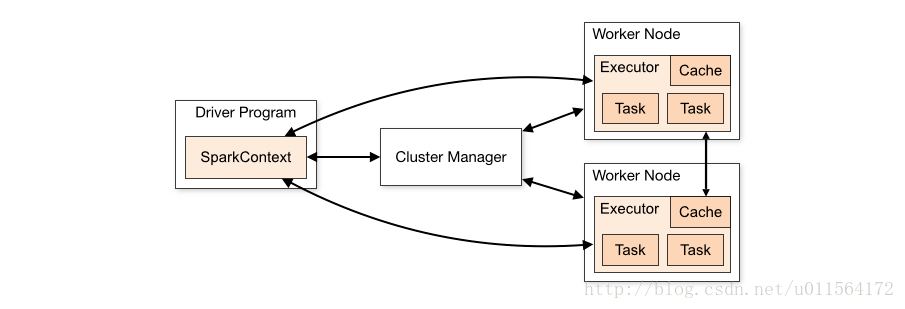

Spark官方文档中,Cluster Mode Overview部分对执行的流程做了简要的介绍,如下

上图涉及到的概念spark文档中给出了解释,后续的分析会从代码层面有更直观的介绍,从上图能够得出Spark执行的大致过程,如下

- Driver程序(即用户编写的Spark程序)初始化SparkContext对象。

- SparkContext对象初始化过程中,连接集群资源管理器Cluster Manager,申请资源,注册APP信息。

- CM根据Driver申请的资源,在Worker上创建Executor。

- 创建好的Executor将其自身信息发送给Driver。

- Driver将用户编写的代码转为Task,发送给相应到Executor,进行计算。

- Executor计算结果返回给Driver,最后Executor的关闭及APP信息的修改等。

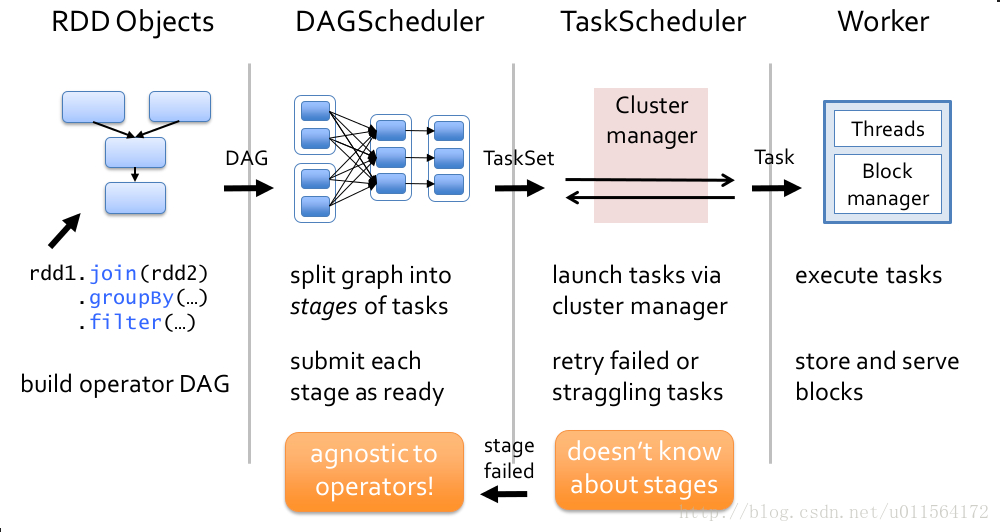

下图描述了Driver提交task的流程,详细流程中的Spark 任务调度之Driver send Task 会大致介绍这部分,后续会详解DAGScheduler的作用。

结合上面两幅图,对任务的提交和调度有了初步的认识。

详细流程

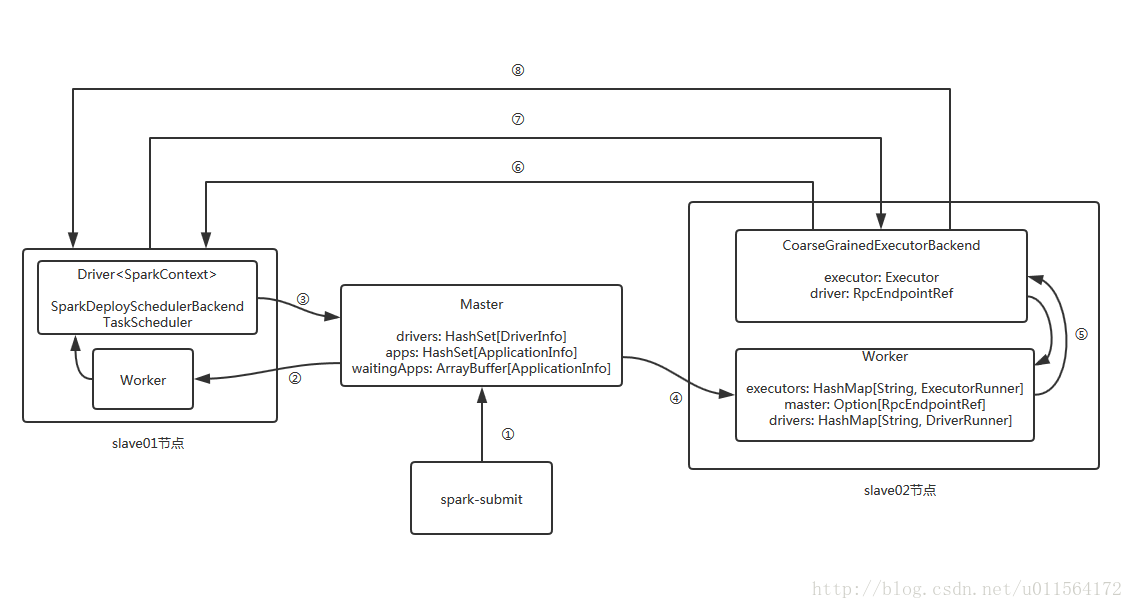

以上面两幅图为基础,接下来结合源码详细介绍Standalone部署模式下,deploy-mode为cluster的任务调度流程,完整流程如下,将整个流程大致分为了八部分,如下图中小标,并对每个部分详细介绍

- submit Driver

Spark 任务调度之Submit Driver - launch Driver

Spark 任务调度之Launch Driver - registerApp

Spark 任务调度之Register App - launch Executor

Spark 任务调度之Launch Executor - start CoarseGrainedExecutorBackend

Spark 任务调度之启动CoarseGrainedExecutorBackend - create Executor && register Executor

Spark 任务调度之创建Executor - Driver send Task

Spark 任务调度之Driver send Task - Executor sendback Result

Spark 任务调度之Executor执行task并返回结果

本文详细介绍了在Standalone部署模式下,从提交Spark任务到计算结果返回的完整流程,包括Driver程序初始化、资源申请、Executor创建及任务调度等关键步骤。

本文详细介绍了在Standalone部署模式下,从提交Spark任务到计算结果返回的完整流程,包括Driver程序初始化、资源申请、Executor创建及任务调度等关键步骤。

308

308

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?