DeepLearning tutorial(4)CNN卷积神经网络原理简介+代码详解

@author:wepon

@blog:http://blog.csdn.net/u012162613/article/details/43225445

本文介绍多层感知机算法,特别是详细解读其代码实现,基于python theano,代码来自:Convolutional Neural Networks (LeNet)。经详细注释的代码和原始代码:放在我的github地址上,可下载。

一、CNN卷积神经网络原理简介

要讲明白卷积神经网络,估计得长篇大论,网上有很多博文已经写得很好了,所以本文就不重复了,如果你了解CNN,那可以往下看,本文主要是详细地解读CNN的实现代码。如果你没学习过CNN,在此推荐周晓艺师兄的博文:Deep Learning(深度学习)学习笔记整理系列之(七),以及UFLDL上的卷积特征提取、池化

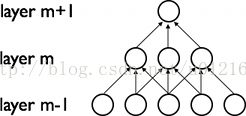

CNN的最大特点就是稀疏连接(局部感受)和权值共享,如下面两图所示,左为稀疏连接,右为权值共享。稀疏连接和权值共享可以减少所要训练的参数,减少计算复杂度。

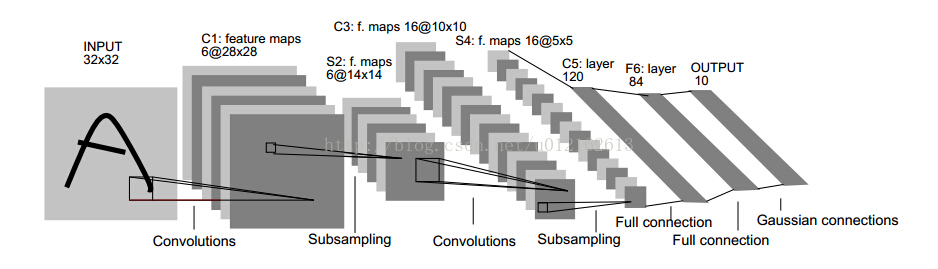

至于CNN的结构,以经典的LeNet5来说明:

这个图真是无处不在,一谈CNN,必说LeNet5,这图来自于这篇论文:Gradient-Based Learning Applied to Document Recognition,论文很长,第7页那里开始讲LeNet5这个结构,建议看看那部分。

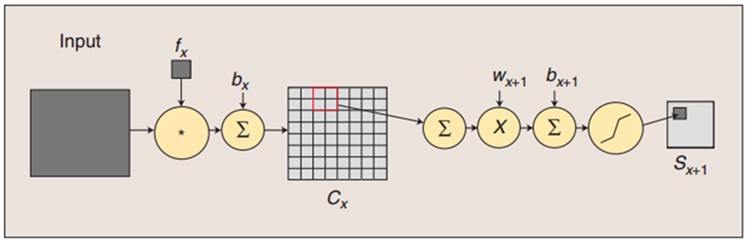

我这里简单说一下,LeNet5这张图从左到右,先是input,这是输入层,即输入的图片。input-layer到C1这部分就是一个卷积层(convolution运算),C1到S2是一个子采样层(pooling运算),关于卷积和子采样的具体过程可以参考下图:

CNN卷积神经网络原理与Python+Theano实现

CNN卷积神经网络原理与Python+Theano实现

本文深入浅出地介绍了CNN卷积神经网络的基本原理,并基于Python和Theano详细解读了LeNet5的实现过程,包括卷积、子采样、全连接层的构建和训练方法。同时,文章指出了代码实现与经典LeNet5结构的差异。

本文深入浅出地介绍了CNN卷积神经网络的基本原理,并基于Python和Theano详细解读了LeNet5的实现过程,包括卷积、子采样、全连接层的构建和训练方法。同时,文章指出了代码实现与经典LeNet5结构的差异。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5320

5320