================================================

OpenMP中工作量的划分与调度

================================================

前面我看到在使用工作量共享(work-sharing)这种方式的时候,工作量是自动给我们划分好并分配给各个线程的。下面,我们来看看如何来控制工作量的划分与调度。

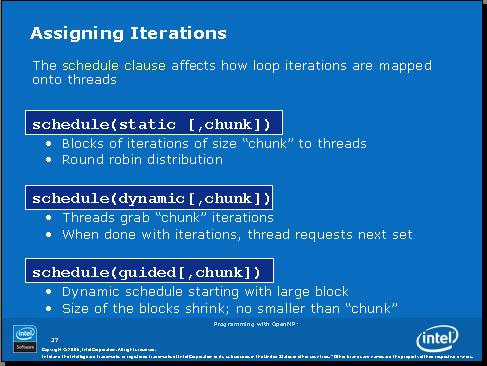

如上图所示,工作量的划分与调度有3种方式:

1、静态:把循环的迭代按照每x次(x=chunk)迭代分为一块,这样你的总工作量就被划分成了n/x块(n为迭代次数、循环次数),然后将这些块按照轮转法依次分配给各个线程。举个例子:比如我们有100次迭代,x=chunk=4,那么我们的工作就被分为25块,假设我们有2个线程可以做工作,那么线程1分到的块是1,3,5,7....,25,线程2分到的块是2,4,6,...,24;

2、动态:迭代分块方法同上,但是工作块被放到一个队列中,每个线程每次拿一块,做好了才能到队列里去拿下一块;

3、Guided:这个方式是动态方式的改进。在这个方式里,分块的x是不固定的,一开始块的大小(x)比较大,随着剩余工作量的减小,块的大小也随之变小。

我们总结一下每种方式适合什么样的工作量

静态方式:比较适合每次迭代的工作量相近(主要指工作所需时间)的情况

动态方式:比较适合每次迭代的工作量非常不确定的情况

Guided方式:类似动态方式,但是队列相关的开销会比动态方式小

下面我们看一个例子:

#pragma omp parallel for schedule (static, 8)

for( int i = start; i <= end; i += 2 )

{

if ( TestForPrime(i) ) gPrimesFound++;

}

在这个例子中,如果start=3,那第一块就={3,5,7,9,11,13,15,17}

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?