如果你也是看准了Python,想自学Python,在这里为大家准备了丰厚的免费学习大礼包,带大家一起学习,给大家剖析Python兼职、就业行情前景的这些事儿。

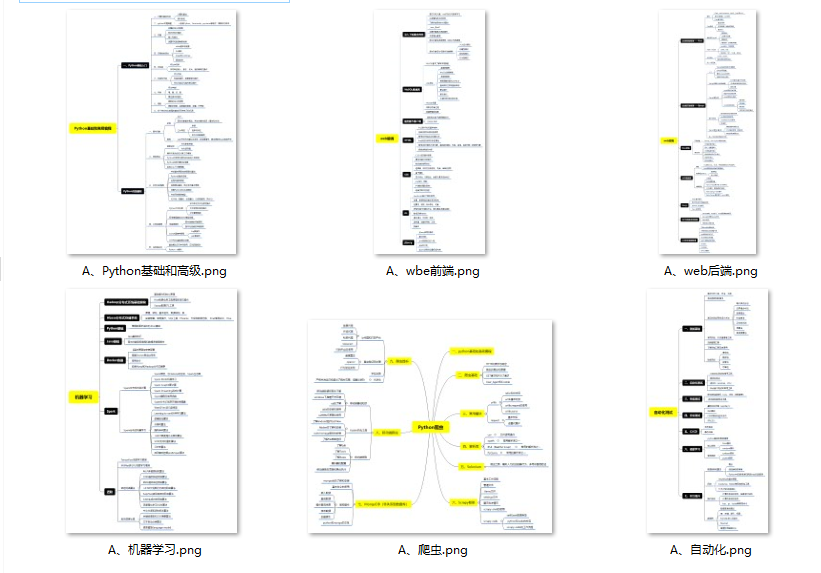

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

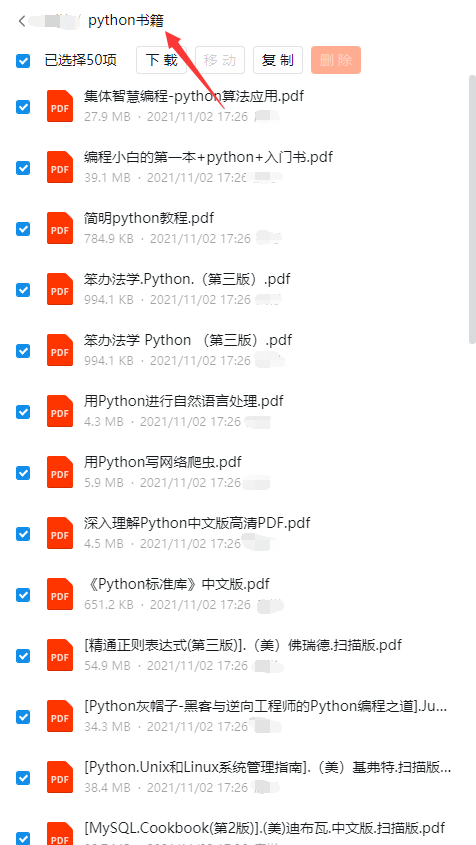

三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

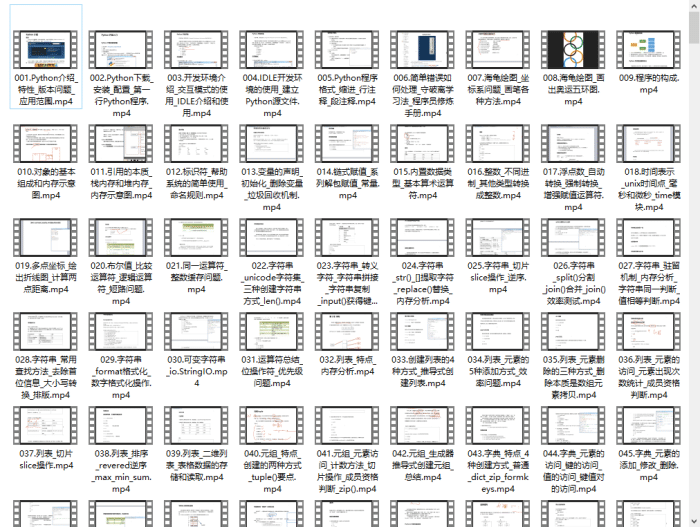

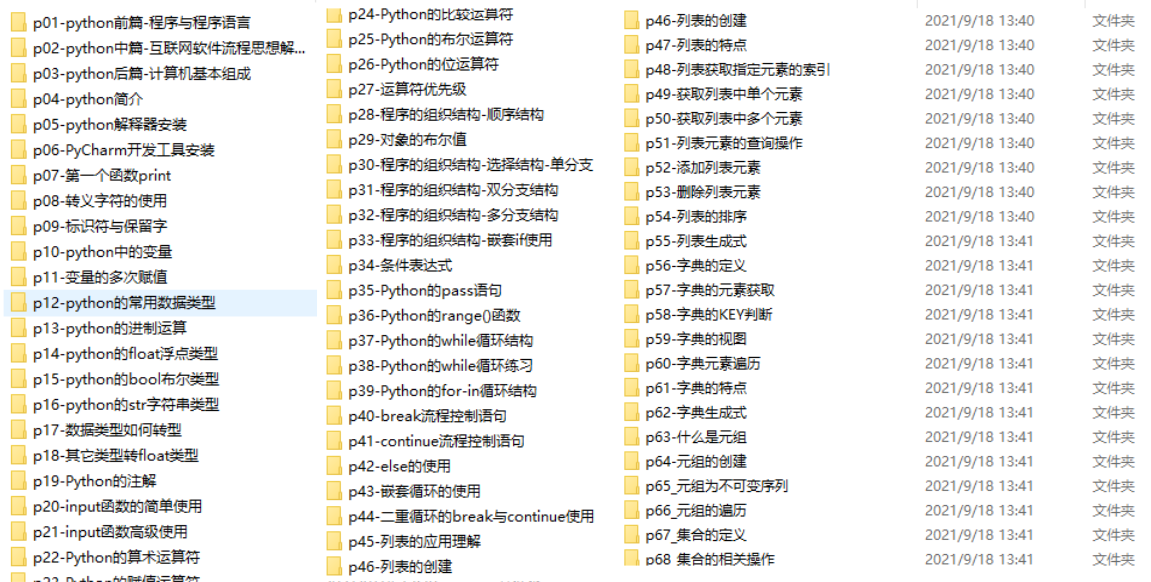

四、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

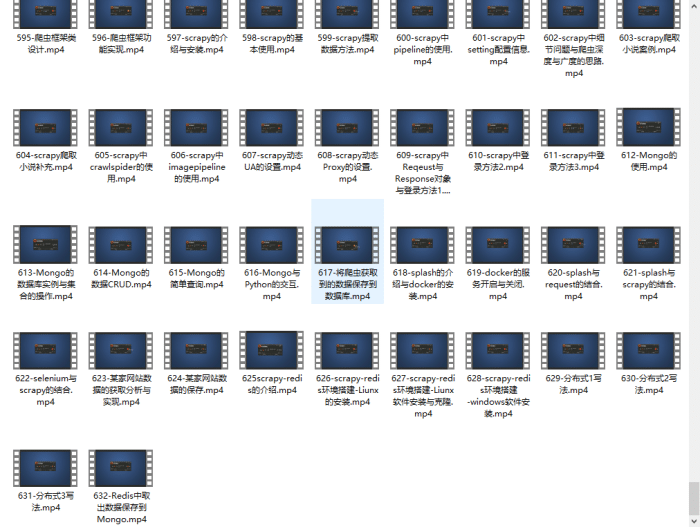

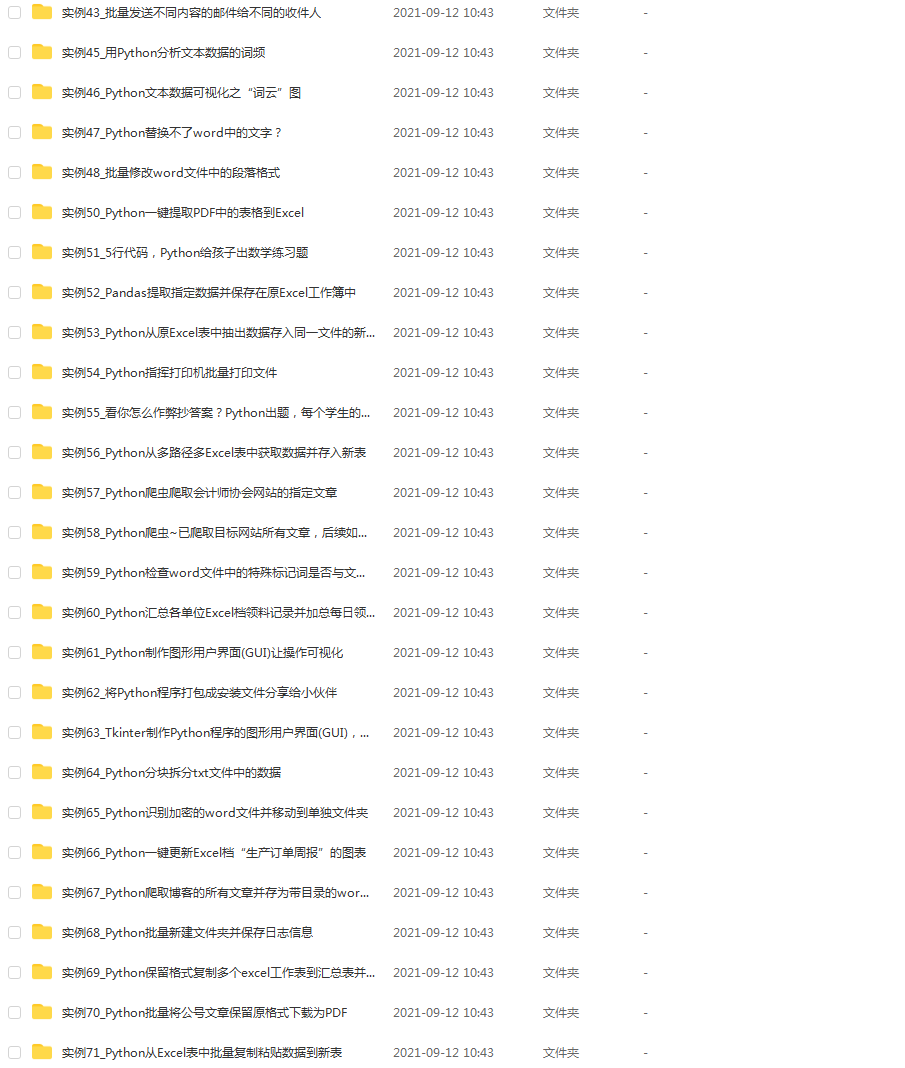

四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

五、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

成为一个Python程序员专家或许需要花费数年时间,但是打下坚实的基础只要几周就可以,如果你按照我提供的学习路线以及资料有意识地去实践,你就有很大可能成功!

最后祝你好运!!!

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

def get_target_urls(self):

response = requests.get(self.url,headers=self.headers)

text = response.content

html = etree.HTML(text)

target_urls = html.xpath(‘//h2/a/@href’)

return target_urls

4.第四步完成第二个函数 --get_target_images():

老套路,写下下面的代码:

for url in target_urls:

response = requests.get(url,headers=self.headers)

text = response.content.decode(‘utf-8’)

print(text)

#这里强烈建议加上break测试

break

于是,得到下面的结果:

好吧,显然这并不是我们需要的结果,那这是什么呢?这段代码(html代码)会自动把我们重定向到首页,这样我们显然获取不成功,于是,我们怎么办呢?在访问一次就可以了,我们仅需要在加上一次请求即可获取所需的html代码。如下:

for url in target_urls:

response = requests.get(url,headers=self.headers)

response = requests.get(url,headers=self.headers)

text = response.content

#这里同上面,不解码,直接解析,原因同上

print(text)

break

结果如下(部分结果):

b’\r\n\r\n\r\n\r\n\r\n…

好的,解决了这个大麻烦,我们下面的工作就很简单了。

可以得到以下内容:

我们需要获取img标签里面的src属性,仅需获取div标签下的p标签下的img标签即可。下面是代码:

for url in target_urls:

response = requests.get(url,headers=self.headers)

time.sleep(2) #一定要加上,不然会访问太快会被禁止的

response = requests.get(url,headers=self.headers)

text = response.content

#开始解析

html = etree.HTML(text)

target_images = html.xpath(‘//div[@id=“post_content”]//p//img/@src’)

print(target_images)

break

部分结果如下:

[‘http://wx1.sinaimg.cn/mw690/6a04b428ly1g19akwia0rg209b09qwgf.gif’, ‘http://wx1.sinaimg.cn/mw690/6a04b428ly1g19al1td90g209q08sq4i.gif’,…]

好的,我们仅仅剩最后一步,下载图片,这里我给出两者方式:

方式一:使用urllib库里的urlretrieve()函数,代码如下:

#该段代码添加至获得target_images后面

#大家使用这个方法的话,一定要记得导入库:from urllib import request

for image_url in target_images:

request.urlretrieve(image_url,‘./info/test.gif’)

break

方式二:获取链接的源代码后保存至本地,代码如下:

#该段代码添加至获得target_images后面

for image_url in target_images:

response = requests.get(image_url,headers=self.headers)

f = open(‘./info/test.gif’,‘wb’)

f.write(response.content)

f.close()

break

两者的结果都如下:

ok,到此处,恭喜大家,已经完成了99%的任务了。下面就是完善和补充一些代码了。

此函数完整代码如下:

def get_target_images(self,target_urls):

for url in target_urls:

response = requests.get(url,headers=self.headers)

time.sleep(2)

response = requests.get(url,headers=self.headers)

text = response.content

html = etree.HTML(text)

target_images =html.xpath(‘//div[@id=“post_content”]//p//img/@src’)

for image_url in target_images:

request.urlretrieve(image_url,‘./info/test.gif’)

break

break

#建议大家测试的时候,加上break,如果有基础的可以考虑代理或者多线程

5.第五步优化与完善:

一个优秀的人,总是想写出点优秀的代码,所以优化必不可少

1.优化角度一:文件存储的优化:

首先,上面我在这个py文件下面创建了一个info文件夹,所以才能写"./info/…"这样的代码,但是我相信大家的目录下肯定没有。所以必须优化。

其次,我们可以这样考虑:使用os模块自动创建一个images的文件夹,其次可以在获取图片集合的url时顺便获取每个图片集合的标题,所以开始改写代码:

修改完成后如下(只需修改第二个函数):

def get_target_images(self,target_urls):

os.mkdir(‘./images’)

for url in target_urls:

response = requests.get(url,headers=self.headers)

time.sleep(2)

response = requests.get(url,headers=self.headers)

text = response.content

html = etree.HTML(text)

target_images = html.xpath(‘//div[@id=“post_content”]//p//img/@src’)

title = html.xpath(‘//div[@id=“post_content”]//p//img/@title’)[0]

os.mkdir(‘./images/’+title)

for index,image_url in enumerate(target_images):

response = requests.get(image_url, headers=self.headers)

#这里我是用文件方式下载,因为不知道为什么我运行urlretrieve下载时下太久了

f = open(‘./images/%s/%s.gif’%(title,index), ‘wb’)

f.write(response.content)

f.close()

break

示例结果;

2.优化角度二:速度优化:

我相信如果直接去掉break去爬取所有的肯定会报错,因为访问太快了,所以可以采取一定的优化手段去优化它,这里我推荐两种方式,第一种是多线程,第二种是代理。这里我就不给出如何实现这种优化了,因为这篇文章的目的不在于此。

3.优化角度三:代码本身优化:

这里第二个函数的代码其实有点长了,因为里面有两个循环。所以可以考虑将其中的每一个循环封装为一个新的函数。这个结果我将给在最后的全部代码里面。

4.优化角度四:异常捕获:

想要捕获异常,有简单的方式,也有复杂的方式。下面只给出简单方式的代码:

这里我们只需修改主函数:

def run(self):

try:

#首先我们需要一个函数获取每一个url

target_urls = self.get_target_urls()

#其次我们需要去获取每一个url里面的图片

self.get_target_images(target_urls)

except Exception as e:

print(‘错误原因:’,e)

复杂的方式就是分别去获取一些常见的异常,如404或者其他异常。

5.完善代码:

下面给出如何爬取多页的思路:

首先我们需要提取出第一、二、三页的url,如下:

第一页:http://www.bbsnet.com/doutu

第二页:http://www.bbsnet.com/doutu/page/2

第三页:http://www.bbsnet.com/doutu/page/3

好的,下面提出共同的部分:http://www.bbsnet.com/doutu/page/ + 页数

这里为了验证上面对于第一页这个特殊页是否适用,访问http://www.bbsnet.com/doutu/page/1,结果可以成功访问,因此下面我们只需去一个个迭代即可获取一页页的图片。

代码我将给在整体代码中。

三、全部代码:

# -- coding:utf-8 --

# Author: 自学小白菜

‘’’

既然选择了前进,那每一步都要认真的去做

‘’’

#导包

from lxml import etree

import requests

from urllib import request

import time

import os

class MySpider(object):

def init(self):

#显然我们需要最基础的headers信息

self.headers = {

‘User-Agent’:‘Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.75 Safari/537.36’,

}

#其次我们需要url

self.url = ‘http://www.bbsnet.com/doutu/page/{page}’

def run(self):

try:

pages = int(input(‘请输入需要获取多少页:’))

for page in range(1,pages+1):

url = self.url.format(page = page)

#首先我们需要一个函数获取每一个url

target_urls = self.get_target_urls(url)

#其次我们需要去获取每一个url里面的图片

self.get_target_images(target_urls)

except Exception as e:

print(‘错误原因:’,e)

def get_target_urls(self,url):

‘’‘这里我们使用一个东西,比如列表等来存储url的结果并返回’‘’

response = requests.get(url,headers=self.headers)

text = response.content

#下面开始解析

html = etree.HTML(text)

target_urls = html.xpath(‘//h2/a/@href’)

return target_urls

最后

Python崛起并且风靡,因为优点多、应用领域广、被大牛们认可。学习 Python 门槛很低,但它的晋级路线很多,通过它你能进入机器学习、数据挖掘、大数据,CS等更加高级的领域。Python可以做网络应用,可以做科学计算,数据分析,可以做网络爬虫,可以做机器学习、自然语言处理、可以写游戏、可以做桌面应用…Python可以做的很多,你需要学好基础,再选择明确的方向。这里给大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

👉Python所有方向的学习路线👈

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉Python必备开发工具👈

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

👉Python全套学习视频👈

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

👉实战案例👈

学python就与学数学一样,是不能只看书不做题的,直接看步骤和答案会让人误以为自己全都掌握了,但是碰到生题的时候还是会一筹莫展。

因此在学习python的过程中一定要记得多动手写代码,教程只需要看一两遍即可。

👉大厂面试真题👈

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

3946

3946

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?