神经信息处理系统大会(Neural Information Processing Systems,简称 NeurIPS)是全球机器学习和人工智能领域最具影响力的学术会议之一,与国际机器学习大会(ICML)和国际学习表征会议(ICLR)并列为“机器学习三大顶会”。NeurIPS 的研究涵盖从理论到应用的广泛领域,包括深度学习、强化学习、计算神经科学等。NeurIPS 2024 将于 12 月 9 日至 15 日 在加拿大温哥华的 Vancouver Convention Center 举行,预计将汇聚来自世界各地的顶尖研究人员和行业专家,共同探讨机器学习领域的最新进展与突破。

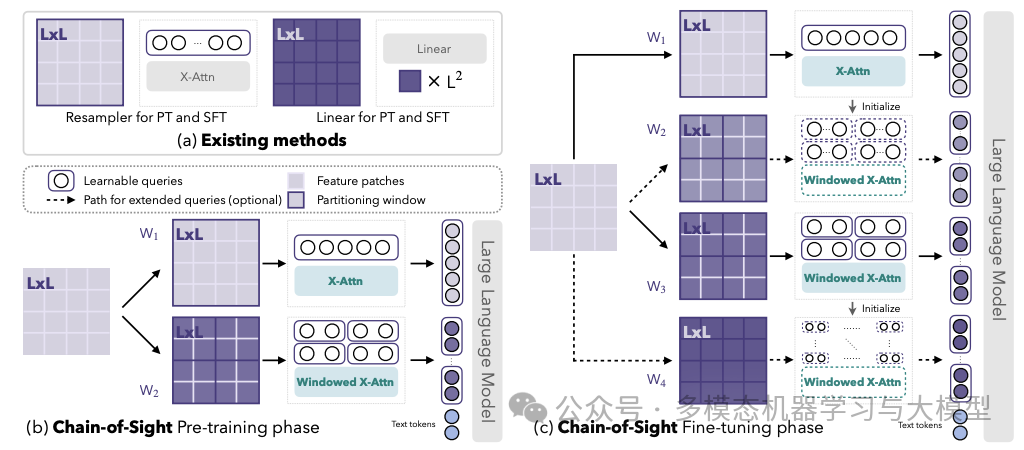

1、 Accelerating Pre-training of Multimodal LLMs via Chain-of-Sight

本文介绍了一种视觉语言桥接模块Chain-of-Sight,可加速多模态大型语言模型 (MLLM) 的预训练。采用了一系列视觉重采样器,可捕捉各种空间尺度的视觉细节。该架构不仅有效地利用了全局和局部视觉上下文,而且还通过复合标记缩放策略促进了视觉标记的灵活扩展,允许预训练后的标记数量增加 16 倍。因此,与微调阶段相比,Chain-of-Sight 在预训练阶段需要的视觉标记要少得多。在预训练期间有意减少视觉标记可显著加快预训练过程,将挂钟训练时间缩短73%。

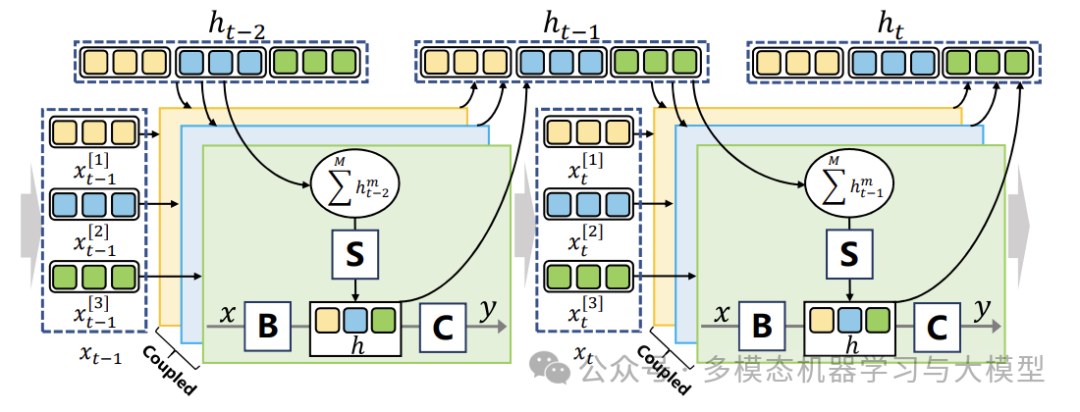

2、 Coupled Mamba: Enhanced Multimodal Fusion with Coupled State Space Model

论文链接:

https://arxiv.org/pdf/2405.18014

摘要: 多模态融合的本质在于利用不同模态中固有的互补信息。然而,大多数流行的融合方法依赖于传统的神经架构,不足以捕捉跨模态交互的动态,特别是在存在复杂的模态内和模态间相关性的情况下。本文提出了耦合状态空间模型 (SSM),用于耦合多种模态的状态链,同时保持模态内状态过程的独立性。具体而言,设计了一种模态间隐藏状态转换方案,其中当前状态取决于其自身链的状态以及前一时间步的相邻链的状态。为了完全遵循硬件感知的并行性,引入历史状态并推导状态方程来获得全局卷积核。在三个数据集上分别将F1-Score提高了0.4%,0.9%和2.3%,推理速度提高了49%,GPU内存节省了83.7%。结果表明,耦合Mamba模型能够增强多模态融合。

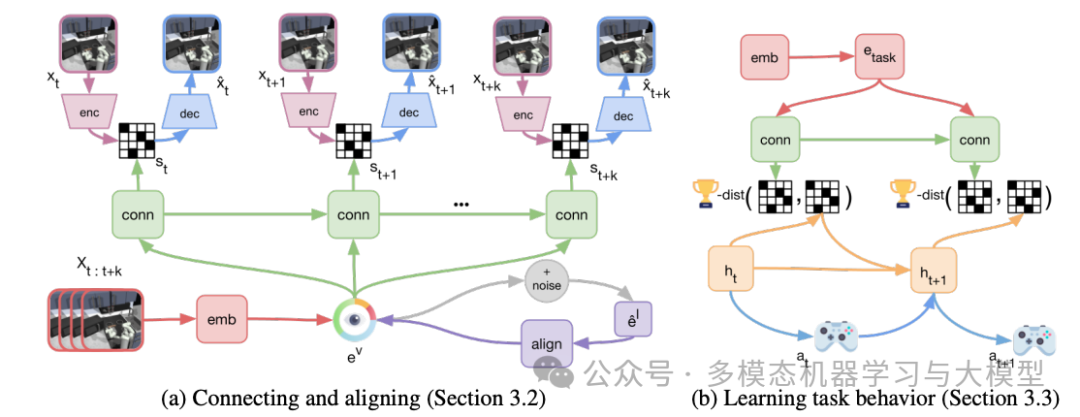

3、 Multimodal foundation world models for generalist embodied agents

论文链接:

https://arxiv.org/pdf/2406.18043

摘要: 提出多模态基础世界模型,够将基础 VLM 的表示与 RL 的生成世界模型的潜在空间连接和对齐,而无需任何语言注释。由此产生的代理学习框架 GenRL 允许人们通过视觉和/或语言提示指定任务,将它们扎根于具身领域的动态中,并在想象中学习相应的行为。通过大规模多任务基准测试评估,GenRL 在多个运动和操作领域表现出强大的多任务泛化性能。此外,通过引入无数据 RL 策略,它为通用化智能体基于基础模型的 RL 奠定了基础。

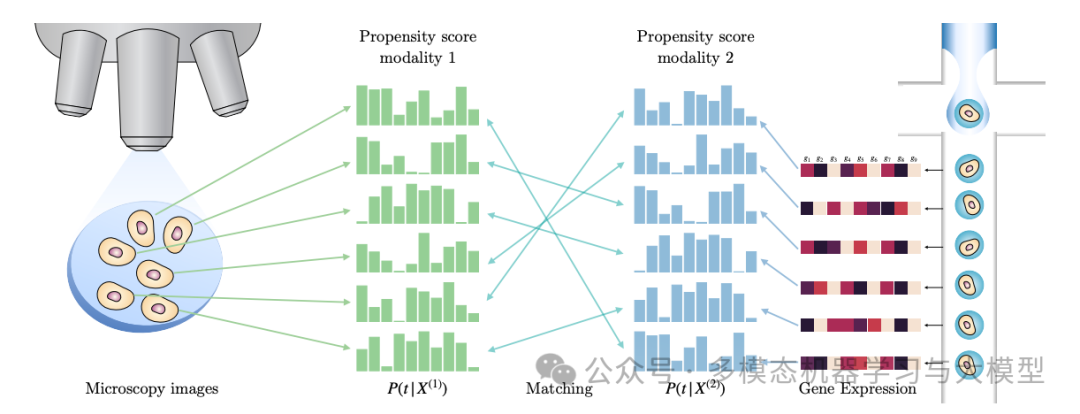

4、 Propensity Score Alignment of Unpaired Multimodal Data

论文链接:

https://arxiv.org/pdf/2404.01595

摘要: 多模态表征学习技术通常需要配对样本来学习共享表征,但在生物学等领域,收集配对样本可能具有挑战性,因为测量设备经常会破坏样本。本文提出了一种方法来解决多模态表征学习中跨不同模态对齐未配对样本的挑战。将因果推理中的潜在结果与多模态观察中的潜在观点进行了类比,利用 Rubin 的框架来估计匹配样本的共同空间。假设样本受到治疗的实验干扰,并利用这一点来估计每种模态的倾向得分。倾向得分囊括了潜在状态和治疗之间的所有共享信息,可用于定义样本之间的距离。

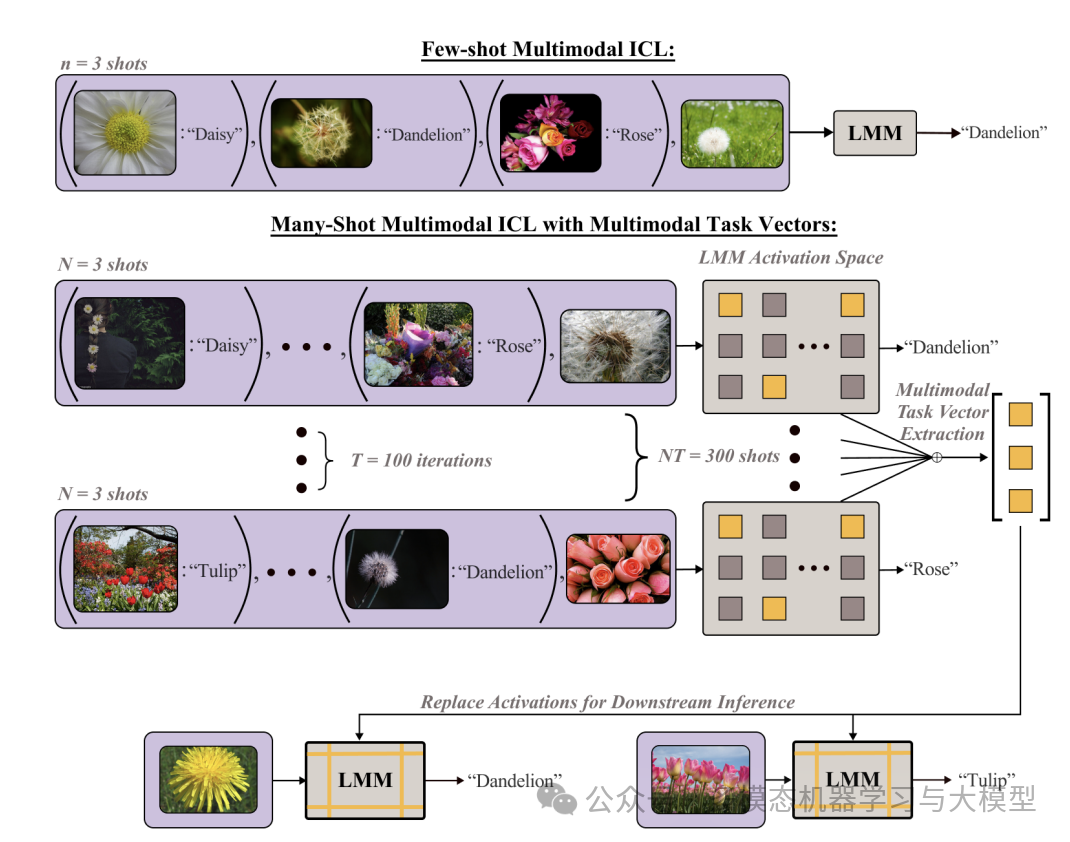

5、 Multimodal Task Vectors Enable Many-Shot Multimodal In-Context Learning

论文链接:

https://arxiv.org/pdf/2406.15334

摘要: 多样本多模态 ICL 设置有一个关键问题:它从根本上受到预训练时设置的模型上下文长度的限制。在这项工作中,利用多模态任务向量 (MTV)——模型注意力头中压缩的上下文示例的紧凑隐式表示——使 LMM 能够执行多模态、多样本上下文学习。具体而言,首先证明 LMM 中存在这样的 MTV,然后利用这些提取出的 MTV 为各种视觉和语言任务实现多样本上下文学习。实验表明,MTV 可以随着压缩镜头的数量而扩展性能,并可以推广到类似的域外任务,而无需额外的上下文长度进行推理。

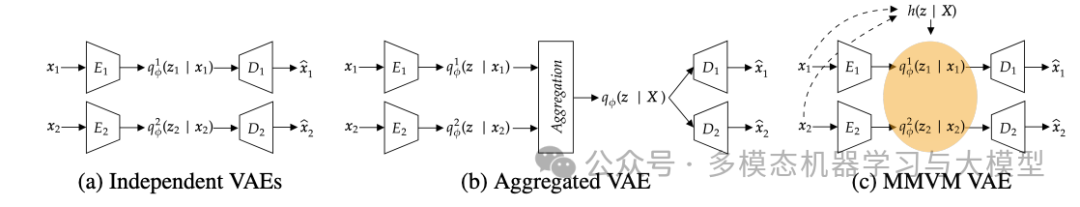

6、Unity by Diversity: Improved Representation Learning for Multimodal VAEs

论文链接:

https://arxiv.org/pdf/2403.05300

摘要: 用于多模态数据的变分自动编码器有望用于数据分析中的许多任务,例如表示学习、条件生成和插补。当前的架构要么跨模态共享编码器输出、解码器输入,要么两者兼而有之,以学习共享表示。这种架构对模型施加了硬约束。在这项工作中表明可以通过用软约束替换这些硬约束来获得更好的潜在表示。我们提出了一种新的混合专家先验,将每种模态的潜在表示软引导至共享的聚合后验。这种方法可以产生更优越的潜在表示,并允许每种编码更好地从未压缩的原始特征中保留信息。与现有方法相比,改进学习潜在表示和缺失数据模态的插补。

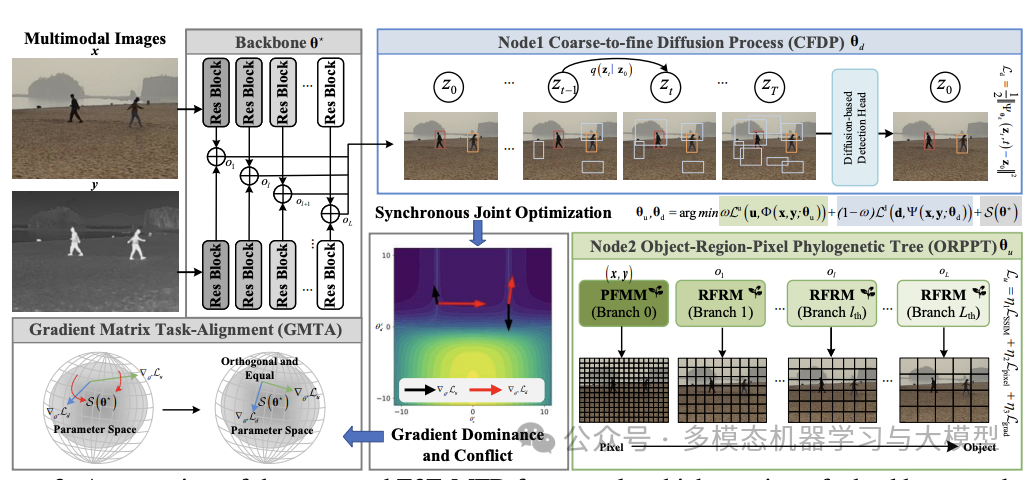

7、 E2E-MFD: Towards End-to-End Synchronous Multimodal Fusion Detection

论文链接:

https://arxiv.org/pdf/2403.09323

摘要: 多模态图像融合和物体检测对于自动驾驶至关重要。虽然当前的方法已经推进了纹理细节和语义信息的融合,但它们复杂的训练过程阻碍了更广泛的应用。为了应对这一挑战,我们引入了一种用于多模态融合检测的新型端到端算法 E2E-MFD。E2E-MFD 简化了流程,通过单个训练阶段实现了高性能。它采用跨组件的同步联合优化,以避免与单个任务相关的次优解决方案。此外,它在共享参数的梯度矩阵中实现了全面的优化策略,确保收敛到最佳融合检测配置。与最先进的方法相比,水平物体检测数据集 M3FD 和定向物体检测数据集 DroneVehicle 上的准确率分别有所提高。

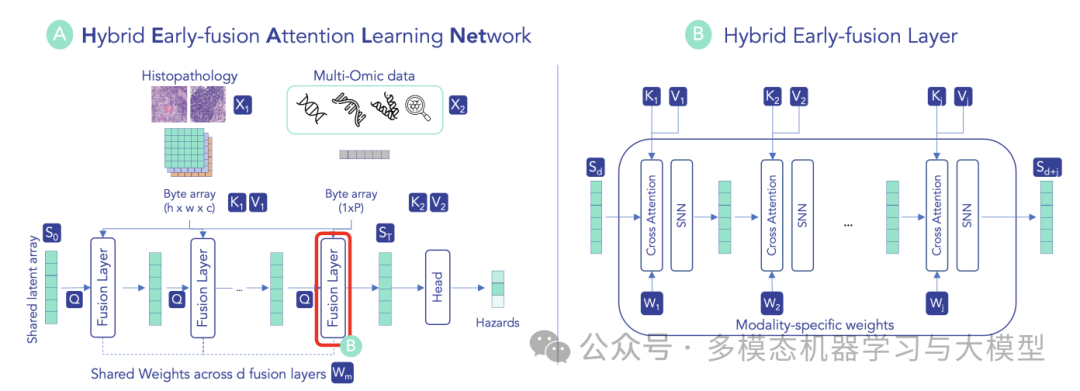

8、HEALNet: Multimodal Fusion for Heterogeneous Biomedical Data

论文链接:

https://arxiv.org/pdf/2311.09115

摘要: 大多数多模态深度学习方法使用特定于模态的架构,这些架构通常是单独训练的,无法捕获促使不同数据源集成的关键跨模态信息。本文介绍了混合早期融合注意力学习网络 (HEALNet)——一种灵活的多模态融合架构,它 a) 保留特定于模态的结构信息,b) 在共享潜在空间中捕获跨模态交互和结构信息,c) 可以在训练和推理期间有效处理缺失的模态,以及 d) 通过学习原始数据输入而不是不透明的嵌入来实现直观的模型检查。HEALNet 实现了最先进的性能,比单模态和多模态融合基线有了显著的改进,同时在缺少模态的场景中也具有很强的稳健性。

9、 Balancing Multimodal Learning with Classifier-guided Gradient Modulation

论文链接: 无

摘要: 近年来,多模态学习发展迅速。然而,在多模态训练过程中,模型往往只依赖于一种模态,从而可以更快地学习,从而导致其他模态的使用不足。现有的平衡训练过程的方法总是对损失函数、优化器和模态数量有一些限制,并且只考虑调节梯度的大小而忽略梯度的方向。为了解决这些问题,本文提出了一种平衡多模态学习的新方法,即分类器引导梯度调制( CGGM ) ,同时考虑梯度的大小和方向。

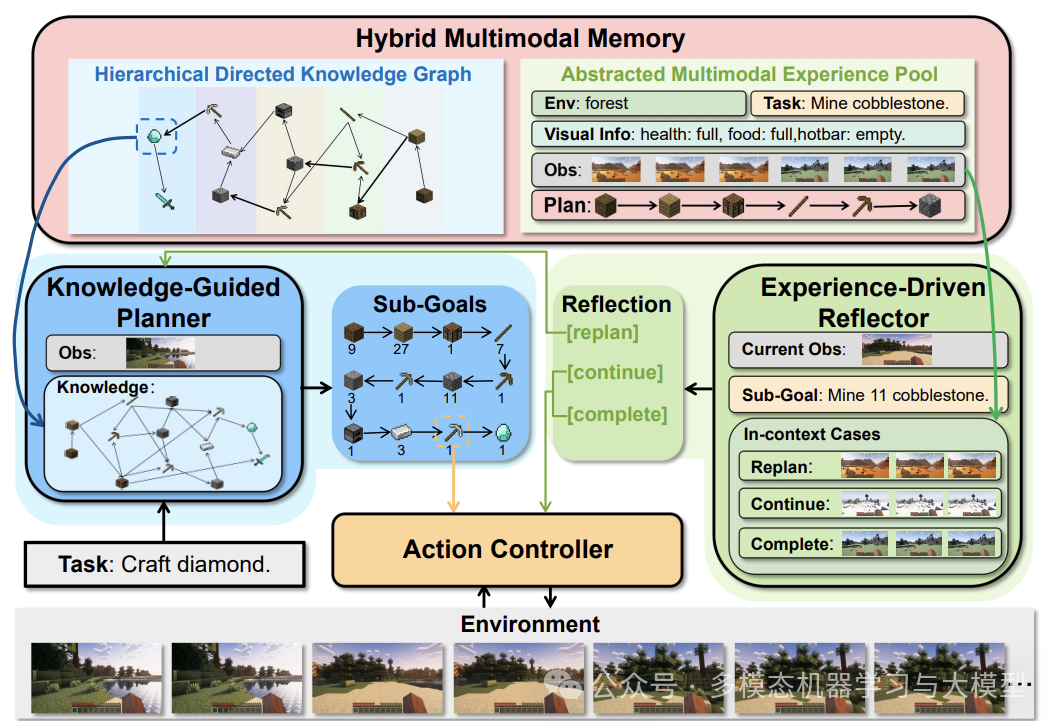

10、 Optimus-1: Hybrid Multimodal Memory Empowered Agents Excel in Long-Horizon Tasks

论文链接:

https://arxiv.org/pdf/2408.03615

摘要: 现有的agent缺乏必要的世界知识和多模态经验来指导代理完成各种长期任务。在本文中,提出了一个混合多模态记忆模块来解决上述挑战。它 1)将知识转换为分层有向知识图谱,使代理能够明确地表示和学习世界知识;2)将历史信息总结到抽象多模态经验池中,为代理提供丰富的情境学习参考。在混合多模态记忆模块之上,多模态代理 Optimus-1 构建了专用的知识引导规划器和经验驱动反射器,有助于在 Minecraft 中面对长期任务时进行更好的规划和反思。大量实验结果表明,Optimus-1 在具有挑战性的长视界任务基准上显著优于所有现有智能体,并且在许多任务上表现出接近人类水平的表现。

那么,如何系统的去学习大模型LLM?

作为一名从业五年的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?