目录

1、通过SparkSession中的createDataset来创建Dataset

2、DataFrame通过“as[ElementType]”方法转换得到Dataset

一、Spark SQL的简介

Spark SQL是Spark用来处理结构化数据的一个模块,它提供了一个编程抽象结构叫做DataFrame的数据模型(即带有Schema信息的RDD),Spark SQL作为分布式SQL查询引擎,让用户可以通过SQL、DataFrames API和Datasets API三种方式实现对结构化数据的处理。

1.1 Spark SQL主要的三个功能

- Spark SQL可从各种结构化数据源中读取数据,进行数据分析

- Spark SQL包含行业标准的JDBC和ODBC连接方式,因此它不局限于在Spark程序内使用SQL语句进行查询。

- Spark SQL可以无缝地将SQL查询与Spark程序进行结合,它能够将结构化数据作为Spark中的分布式数据集(RDD)进行查询。

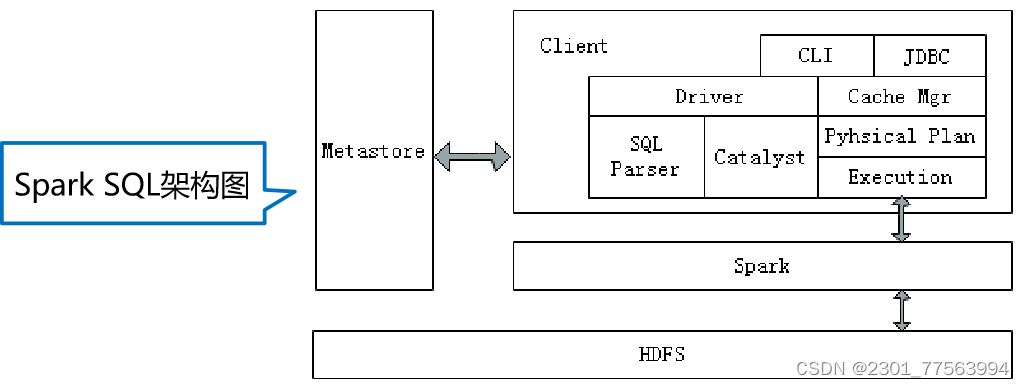

1.2 Spark SQL架构

Spark SQL架构与Hive架构相比,把底层的MapReduce执行引擎更改为Spark,还修改了Catalyst优化器,Spark SQL快速的计算效率得益于Catalyst优化器。从HiveQL被解析成语法抽象树起,执行计划生成和优化的工作全部交给Spark SQL的Catalyst优化器进行负责和管理。

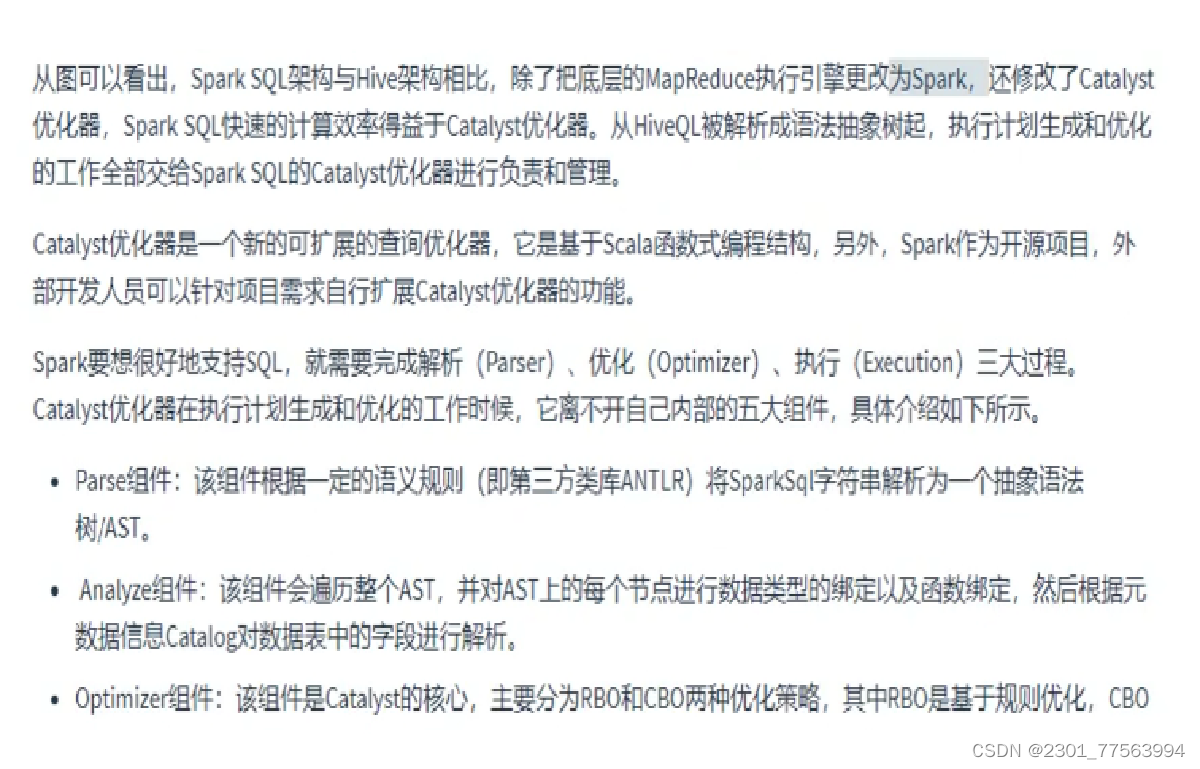

Spark要想很好地支持SQL,需要完成解析(Parser)、优化(Optimizer)、执行(Execution)三大过程。

Catalyst优化器在执行计划生成和优化的工作时,离不开内部的五大组件。

- SqlParse:完成SQL语法解析功能,目前只提供了一个简单的SQL解析器。

- Analyze:主要完成绑定工作,将不同来源的Unresolved LogicalPlan和元数据进行绑定,生成Resolved LogicalPlan。

- Optimizer:对Resolved Lo;gicalPlan进行优化,生成OptimizedLogicalPlan。

- Planner:将LogicalPlan转换成PhysicalPlan.

- CostModel:主要根据过去的性能统计数据,选择最佳的物理执行计划

1.2.1 Spark SQL工作流程:

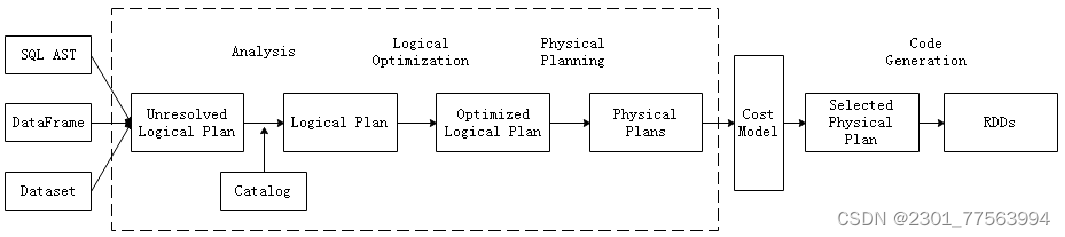

- 下在解析SQL语句之前,会创建SparkSession,涉及到表名、字段名称和字段类型的元数据都将保存在SessionCatalog中;

- 当调用SparkSession的sql()方法时就会使用SparkSqlParser进行解析SQL语句,解析过程中使用的ANTLR进行词法解析和语法解析;

- 使用Analyzer分析器绑定逻辑计划,在该阶段,Analyzer会使用Analyzer Rules,并结合SessionCatalog,对未绑定的逻辑计划进行解析,生成已绑定的逻辑计划;

- 使用Optimizer优化器优化逻辑计划,该优化器同样定义了一套规则(Rules),利用这些规则对逻辑计划和语句进行迭代处理;

- 使用SparkPlanner对优化后的逻辑计划进行转换,生成可以执行的物理计划SparkPlan;

- 使用QueryExecution执行物理计划,此时则调用SparkPlan的execute()方法,返回RDDs。

二、DataFrame概述

2.1 DataFrame简介

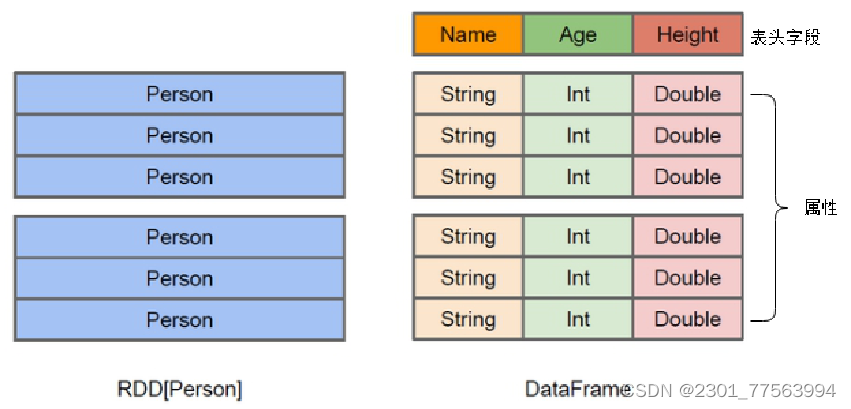

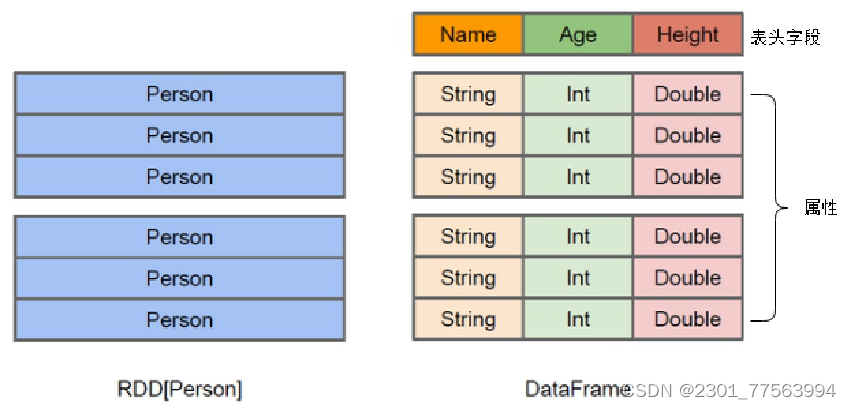

- Spark SQL使用的数据抽象并非是RDD,而是DataFrame。

- 在Spark 1.3.0版本之前,DataFrame被称为SchemaRDD。

- DataFrame使Spark具备处理大规模结构化数据的能力。

- 在Spark中,DataFrame是一种以RDD为基础的分布式数据集。 DataFrame的结构类似传统数据库的二维表格,可以从很多数据源中创建,如结构化文件、外部数据库、Hive表等数据源

DataFrame可以看作是分布式的Row对象的集合,在二维表数据集的每一列都带有名称和类型,这就是Schema元信息,这使得Spark框架可获取更多数据结构信息,从而对在DataFrame背后的数据源以及作用于DataFrame之上数据变换进行针对性的优化,最终达到提升计算效率。

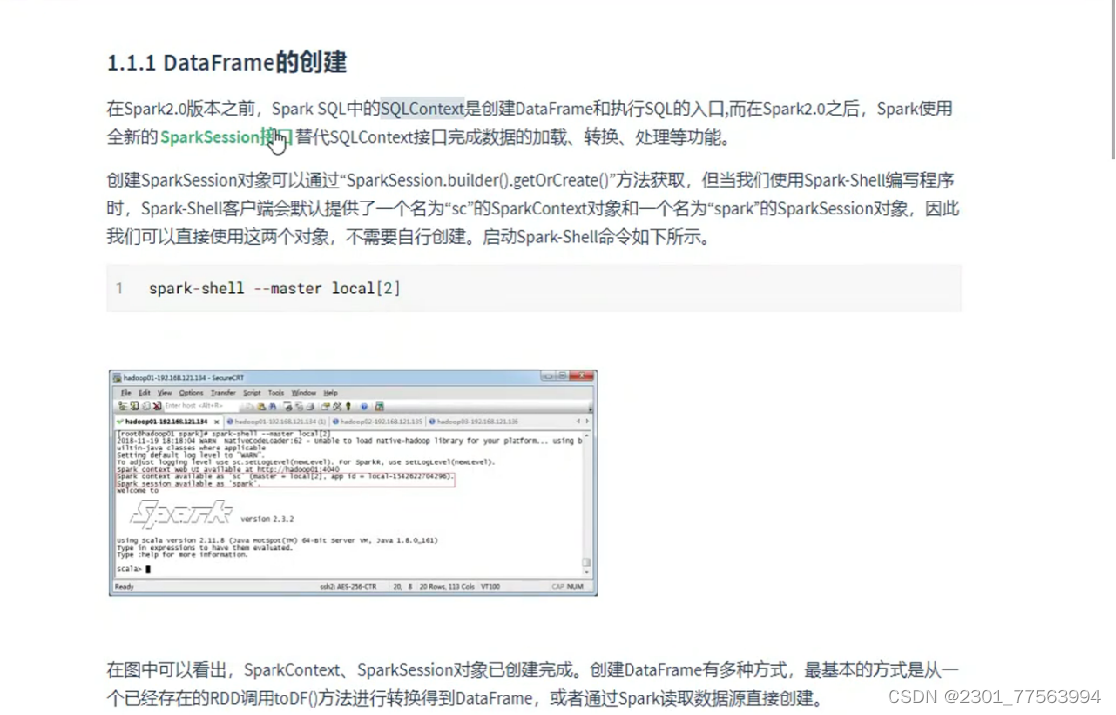

2.2 DataFrame的创建

创建DataFrame的两种基本方式:

- 已存在的RDD调用toDF()方法转换得到DataFrame。

- 通过Spark读取数据源直接创建DataFrame。

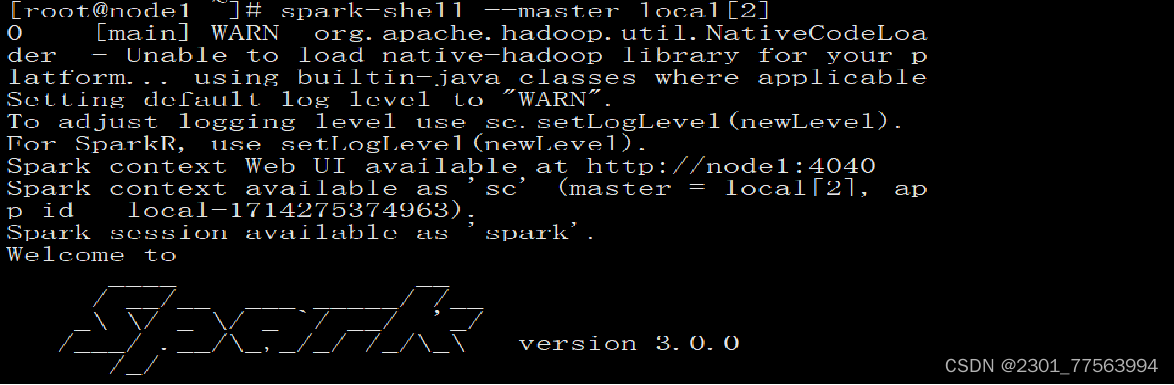

若使用SparkSession方式创建DataFrame,可以使用spark.read从不同类型的文件中加载数据创建DataFrame。spark.read的具体操作,在创建Dataframe之前,为了支持RDD转换成Dataframe及后续的SQL操作,需要导入import.spark.implicits._包启用隐式转换。若使用SparkSession方式创建Dataframe,可以使用spark.read操作,从不同类型的文件中加载数据创建DataFrame,具体操作API如表4-1所示。

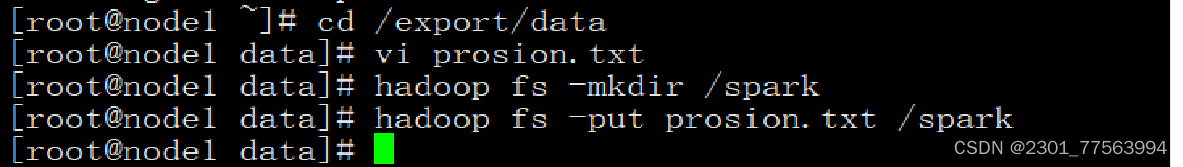

1.数据准备

在HDFS文件系统中的/spark目录中有一个person.txt文件,内容如下:

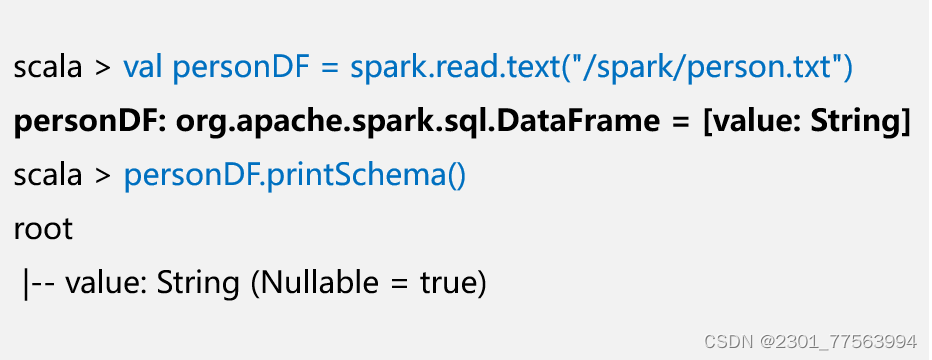

2.通过文件直接创建DataFrame

我们通过Spark读取数据源的方式进行创建DataFrame

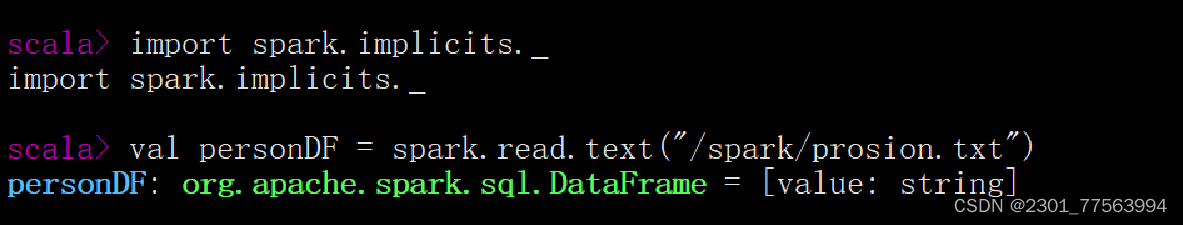

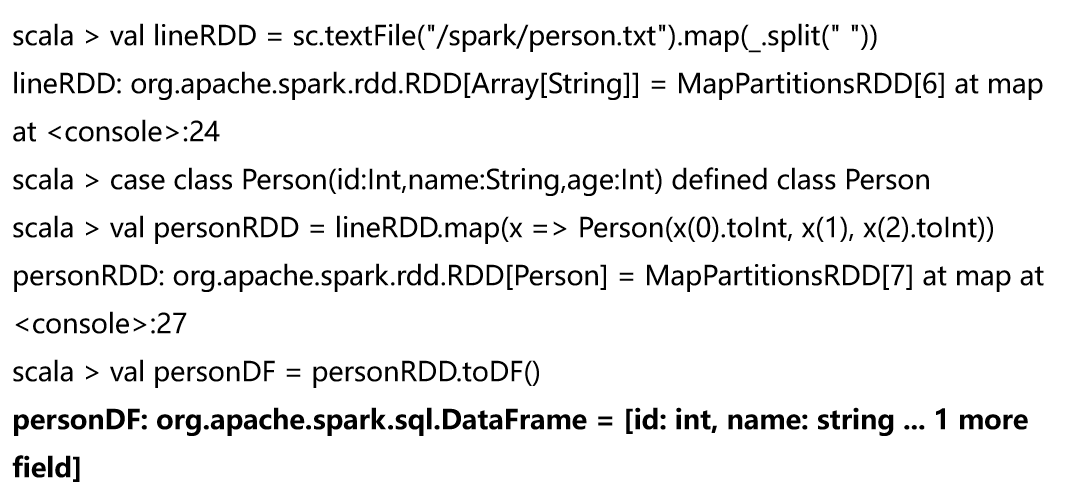

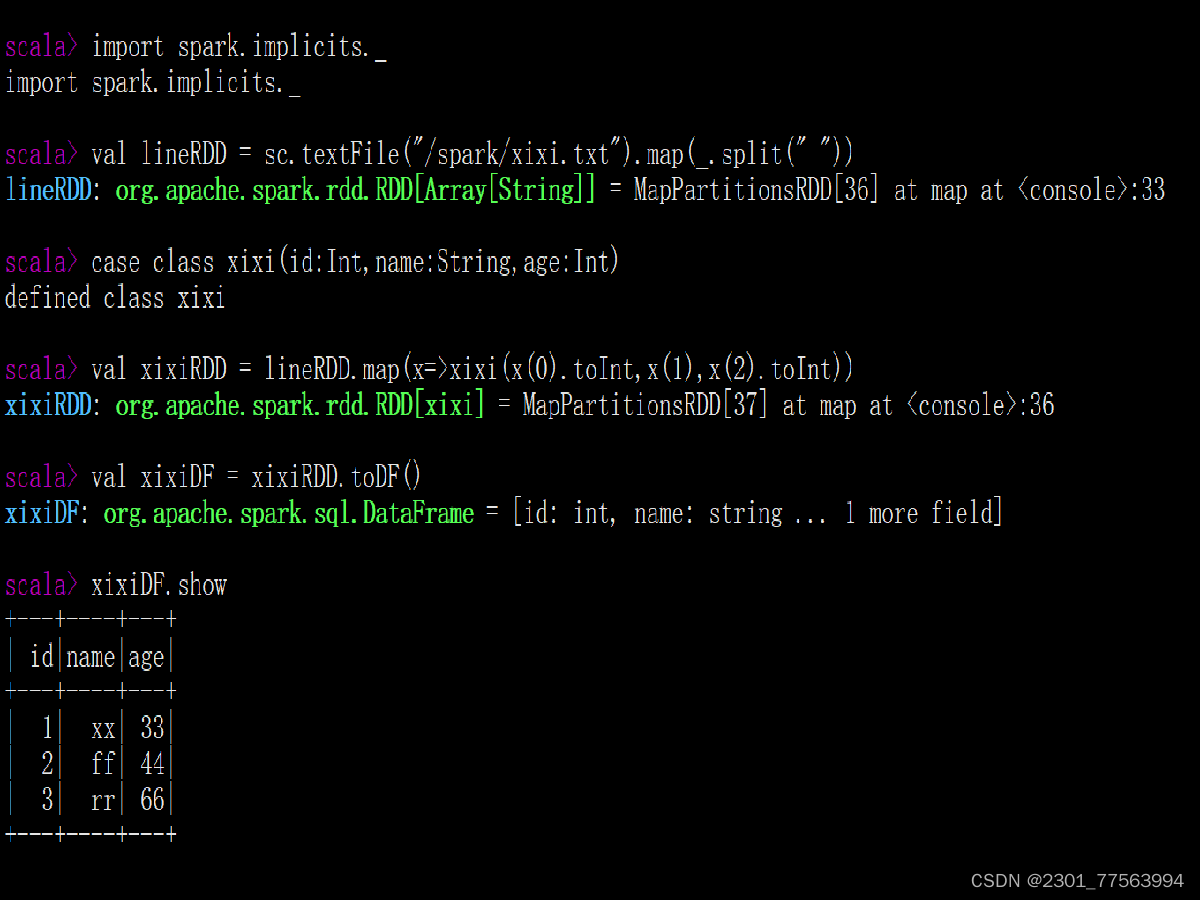

3.RDD直接转换为DataFrame

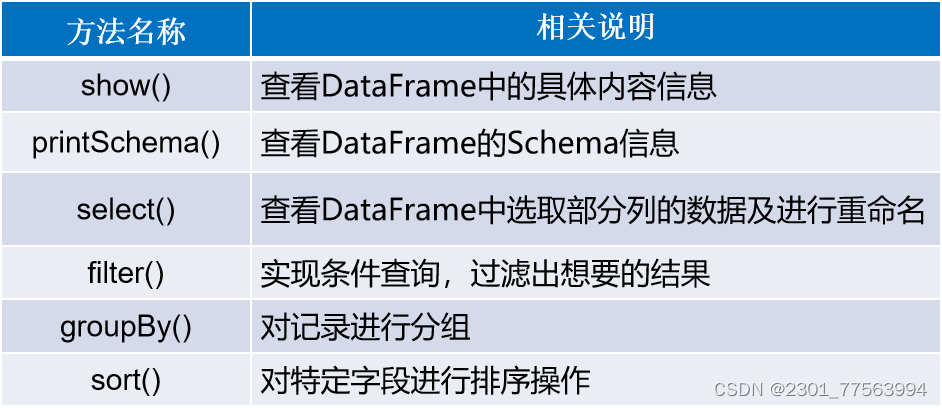

2.3 DataFrame的常用操作

DataFrame提供了两种语法风格,即DSL风格语法和SQL风格语法。二者在功能上并无区别,仅仅是根据用户习惯,自定义选择操作方式。

2.3.1 DSL风格操作DataFrame

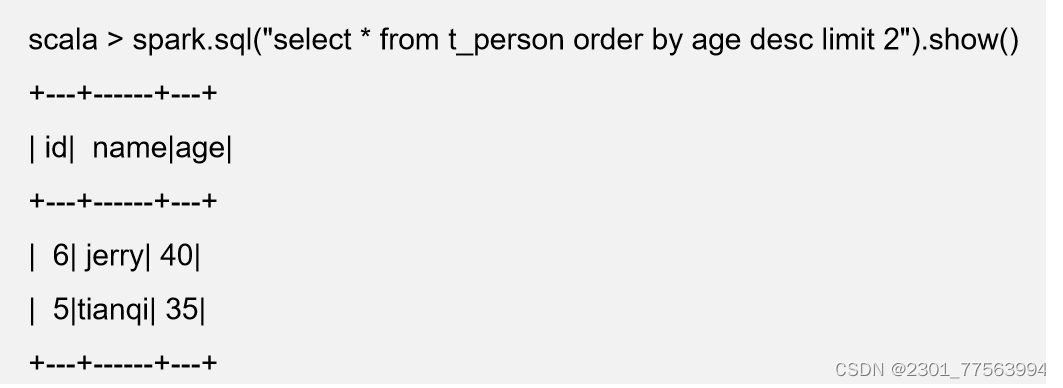

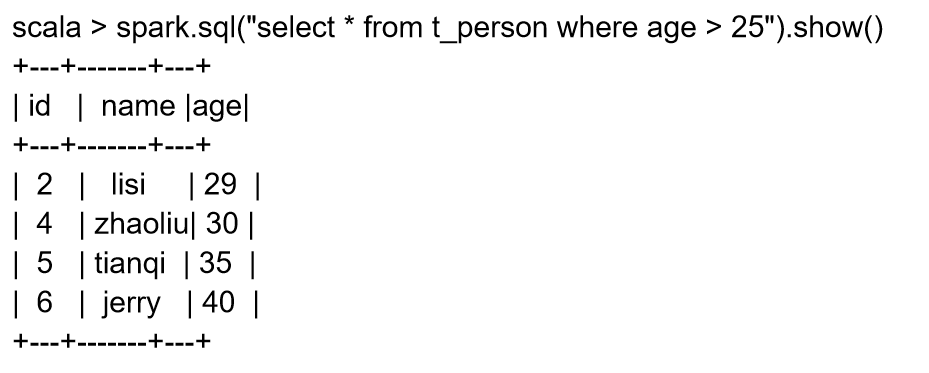

2.3.2 SQL风格操作DataFrame

1. 将DataFrame注册成一个临时表

2. 查询年龄最大的前两名人的信息

3. 查询年龄大于25的人的信息

三、Dataset简介

Dataset是从Spark1.6 Alpha版本中引入的一个新的数据抽象结构,最终在Spark2.0版本被定义成Spark新特性。Dataset提供了特定域对象中的强类型集合,也就是在RDD的每行数据中添加了类型约束条件,只有约束条件的数据类型才能正常运行。Dataset结合了RDD和DataFrame的优点,并且可以调用封装的方法以并行方式进行转换等操作。

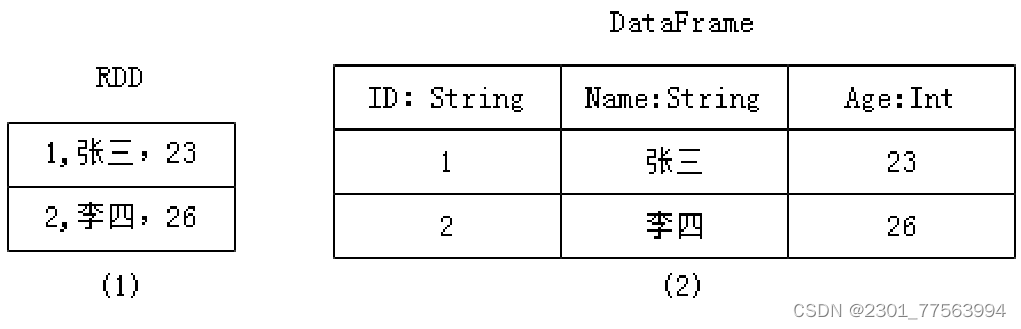

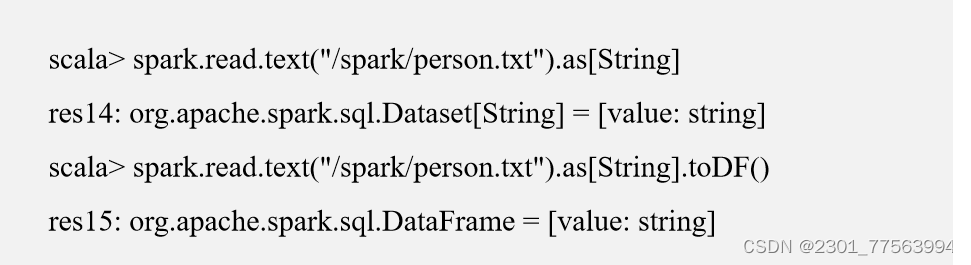

3.1 RDD、DataFrame及Dataset的区别

- RDD数据的表现形式,即序号(1),此时RDD数据没有数据类型和元数据信息。

- DataFrame数据的表现形式,即序号(2),此时DataFrame数据中添加Schema元数据信息(列名和数据类型,如ID:String),DataFrame每行类型固定为Row类型,每列的值无法直接访问,只有通过解析才能获取各个字段的值。

Dataset数据的表现形式,序号(3)和(4),其中序号(3)是在RDD每行数据的基础之上,添加一个数据类型(value:String)作为Schema元数据信息。而序号(4)每行数据添加People强数据类型,在Dataset[Person]中里存放了3个字段和属性,Dataset每行数据类型可自定义,一旦定义后,就具有错误检查机制。

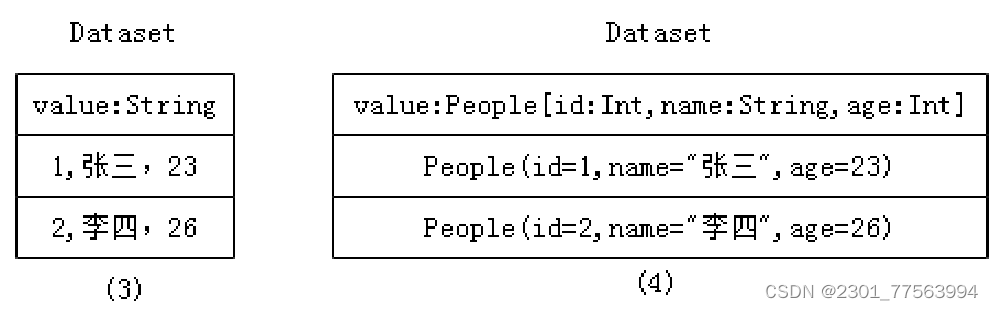

3.2 Dataset对象的创建

1、通过SparkSession中的createDataset来创建Dataset

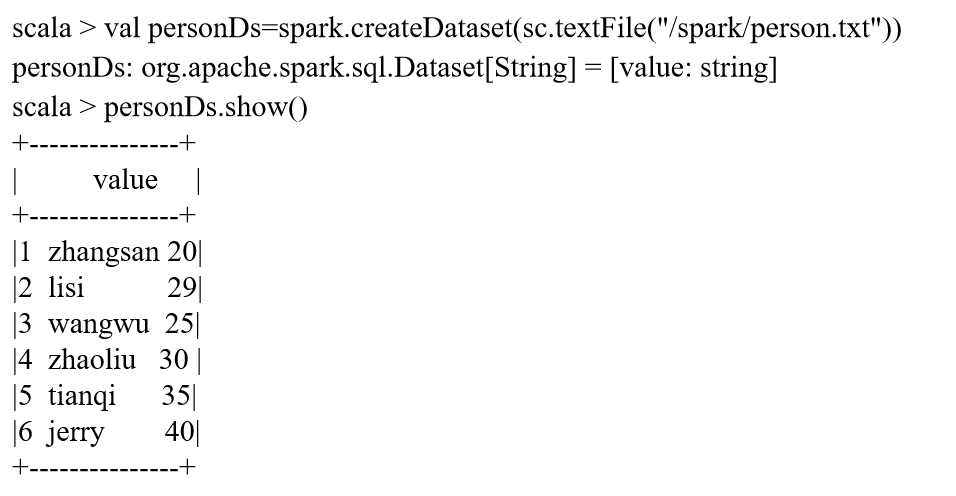

2、DataFrame通过“as[ElementType]”方法转换得到Dataset

四、RDD转换DataFrame

- Spark官方提供了两种方法实现从RDD转换得到DataFrame。

- 第一种方法是利用反射机制来推断包含特定类型对象的Schema,这种方式适用于对已知数据结构的RDD转换

- 第二种方法通过编程接口构造一个Schema,并将其应用在已知的RDD数据中。

4.1 反射机制推断Schema

Windows系统开发Scala代码,可使用本地环境测试(需要先准备本地数据文件)。我们可以很容易的分析出当前数据文件中字段的信息,但计算机无法直观感受字段的实际含义,因此需要通过反射机制来推断包含特定类型对象的Schema信息,实现将RDD转换成DataFrame。

- 创建Maven工程。 打开IDEA开发工具,创建名为“spark_chapter04”的Maven工程。

- 添加依赖。在pom.xml文件中添加Spark SQL依赖。

- 定义case class样例类、字段和属性,样例类的参数名会被利用反射机制作为列名。通过sc对象读取文件生成一个RDD,将RDD 与样例类匹配,调用toDF()方法将RDD转换为DataFrame。

4.2 编程方式定义Schema

当Case类不能提前定义Schema时,就需要采用编程方式定义Schema信息,实现RDD转换DataFrame的功能。

- 创建一个Row对象结构的RDD。

- 基于StructType类型创建Schema。

- 通过SparkSession提供的createDataFrame()方法来拼接Schema,来实现RDD转换成DataFrame。

五、Spark SQL操作数据源

5.1 Spark SQL操作MySQL

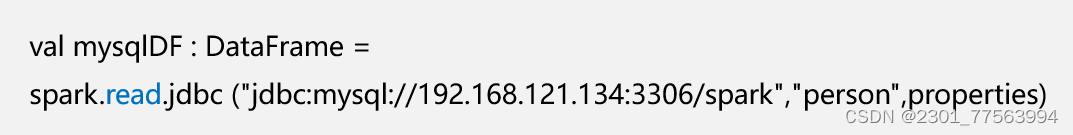

1. 读取MySQL数据库

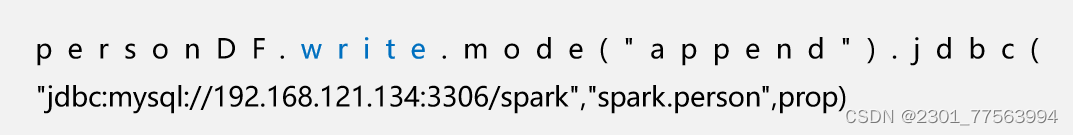

2. 向MySQL数据库写入数据

5.2 操作Hive数据集

- 准备环境,使Spark可以访问Hive,Spark SQL连接Hive。

- 在Hive中创建数据库和表。

- Spark SQL操作Hive数据库。

- 向Hive表写入数据。

598

598

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?