你是不是觉得学习编程很难?你是不是羡慕那些天生就会编程的人?你是不是觉得自己没有天分,学不会编程?如果你有这样的想法,那么请听听我要说的话,或许能让你改变看法。

今天我们要深入探讨学习编程到底需不需要拥有那些所谓的“天赋”。你可能听说过那些天生聪明、自学成才、轻松通关编程领域的天才,但对于普通人来说,是不是也有机会成为编程高手呢?

“学霸”和普通人的对决

首先,我们需要摒弃“学霸”和“普通人”的标签。编程并不是天才的专利,任何人都可以尝试,学习编程的成功与否与你的天赋关系并不是唯一决定因素。

我们都听说过那些自学编程,仅仅凭借着坚定的决心和勤奋,最终成为编程高手的人。但对于大多数普通人来说,学习编程是一项充满挑战的任务,需要持之以恒的努力和学习。

持之以恒

学习编程需要一颗坚定的决心。不能只是兴趣一来就开始,兴趣一走就抛弃。编程是一门需要时间和耐心的技能,持之以恒至关重要。那些天赋出众的人也需要时间来不断练习和提升。

如果你一开始感兴趣,那是好事,但要记住,只有持之以恒才能走得更远。不要期望能在短时间内变成一位编程专家。毕竟,罗马不是一天建成的。请给自己一些时间和空间,让自己慢慢地进步。只要你持之以恒,你就能走得更远。

挑战自己

学习编程不是一帆风顺的。你会遇到各种各样的困难和挫折,比如语法错误、逻辑错误、调试错误、兼容性问题、性能问题等等。这些困难可能会让你感到沮丧和气馁,甚至想要放弃。但是,请不要被困难吓倒。困难是成长的催化剂,只有克服困难,才能不断成长。

不要怕犯错,因为犯错是学习的一部分。当你遇到错误时,不要沮丧,相反,要视之为宝贵的学习机会。这些错误会帮助你更好地理解编程原理和问题解决方法。

扎实基础

学习编程不是一件容易的事情。你需要掌握很多知识和技能,比如语法、逻辑、数据结构、算法、设计模式、框架、工具等等。这些知识和技能都是建立在一些基础之上的。如果你没有打牢基础,你就很难学习更高级的内容。

不要急功近利,不要好高骛远。很多人在简历上写得天花乱坠,但实际掌握的知识却有限。这样做只会让自己陷入尴尬和困境。请从基础开始,打牢扎实的基础,这才是成功的捷径。

可以从简单的语法和逻辑开始学习,逐渐深入。不要跳过基础知识,因为它们是你编程之路的基石。扎实的基础能够帮助你更好地理解复杂的概念和编程语言。只有掌握了基础知识,你才能更容易地学习更高级的内容。

大量练习

学习编程不是读一本书或看一堆教程就行的。需要通过实际操作不断巩固知识。初学者可能无法一开始就掌握所有,但经过多次尝试,理解和熟练度都会提高。

建议你尝试解决各种编程问题,参与编程挑战,编写小型项目,甚至是开源项目的贡献。这些建议可以帮助你将理论知识转化为实际应用能力。

永不满足

学习编程不是一件满足的事情。你不能停滞不前,认为自己已经学到了足够的知识和技能。这个领域在不断发展,新的技术层出不穷。所以,要保持好奇心,勇于尝试新事物。记住,不进则退。

随着技术的进步,编程领域也在不断演化。学习编程的人必须保持对新知识和新技术的开放态度。不要认为你学到的就是最好的,因为在技术领域,一切都在迅速变化。

在结论之前,让我们再次重申,学习编程不仅仅是关于天赋,更是关于热情、坚韧和不断进步。在这篇文章中,和你分享了一些学习编程的条件和方法。希望你能从中受益,并且对编程有更多的信心和兴趣。

如果你想学习编程,小编这次带来的,是整理了三个月的一套完整的学习路线图,以及配套学习资料,它涵盖了Python学习的方方面面,且文献全彩,字迹清晰,很适合我们学习观看。

下面来看看资料详细内容:

一、Python基础

基础真的蛮重要的,因为Python的易应用性很容易让大家产生我什么都会了的感觉,但实际上还是不怎么会。

二、爬虫阶段

应该有很多人都对爬虫感兴趣吧?

爬虫不只是爬虫工程师会用到,业余时间也可以用来爬点自己想要的东西,又或者是做兼职也是可以的,比如日常办公自动化、电商抓取商品信息、分析销售数据做报表等等。

大部分爬虫都是按“发送请求——获得页面——解析页面——抽取并储存内容”这样的流程来进行,这其实也是模拟了我们使用浏览器获取网页信息的过程。

所以爬虫的简要学习路径大概有:

- 学习 Python 包并实现基本的爬虫过程

- 了解非结构化数据的存储

- 学习scrapy,搭建工程化爬虫

- 学习数据库知识,应对大规模数据存储与提取

- 掌握各种技巧,应对特殊网站的反爬措施

- 分布式爬虫,实现大规模并发采集,提升效率

三、Python数据分析

数据分析也是当下的一大热门方向,用Python来做的话比其他语言强很多。

但往往只会数据分析还是差点意思,如果能具备爬虫能力来爬取数据就更好了。(分析爬虫抓取的数据,分析规律,用于商业化)

相关的学习资料:

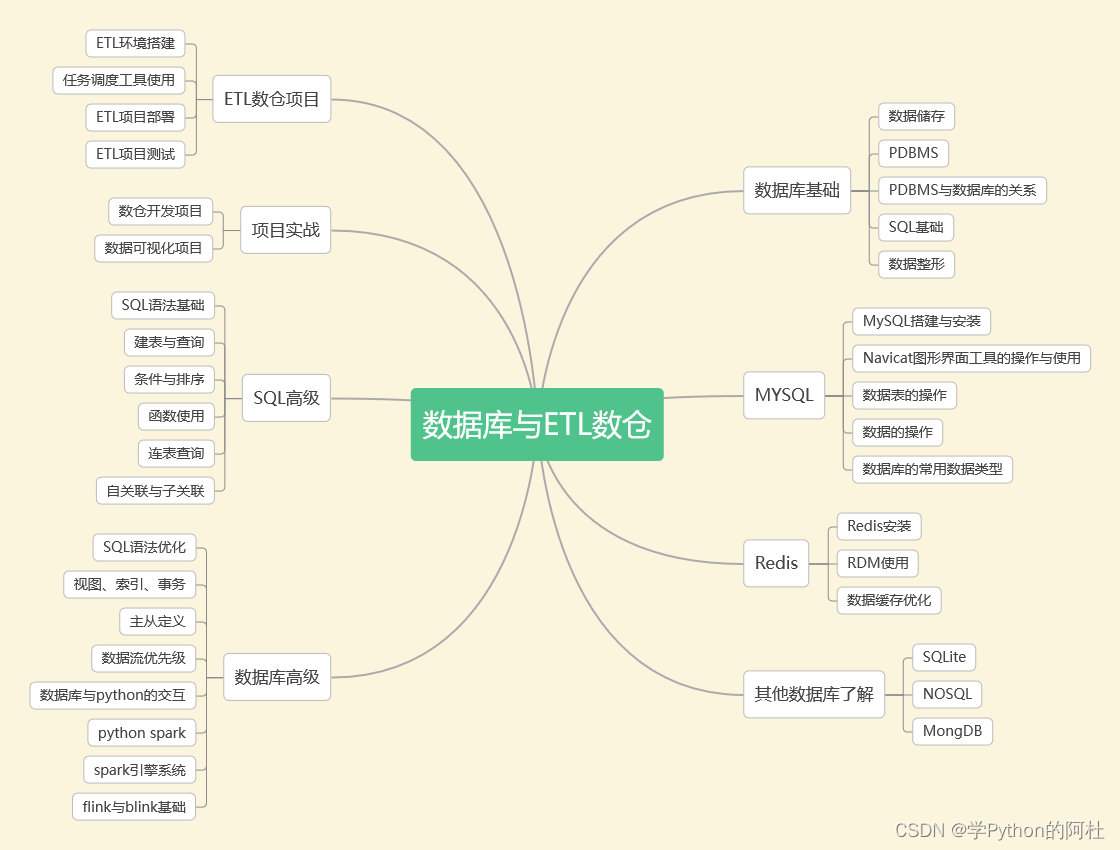

四、数据库与ETL数仓

企业需要定期将冷数据从业务数据库中转移出来存储到一个专门存放历史数据的仓库里面,各部门可以根据自身业务特性对外提供统一的数据服务,这个仓库就是数据仓库。

传统的数据仓库集成处理架构是ETL,利用ETL平台的能力,E=从源数据库抽取数据,L=将数据清洗(不符合规则的数据)、转化(对表按照业务需求进行不同维度、不同颗粒度、不同业务规则计算进行统计),T=将加工好的表以增量、全量、不同时间加载到数据仓库。

五、Python机器学习

现在不是各种吹人工智能么,机器学习就是人工智能的一个分支,它的应用太广泛了,比如自然语言处理,搜索引擎,各种识别技术,数据挖掘等等。

这难度不用我多说了吧,不会点算法就别碰,一碰就是各种高斯过程回归、线性判别分析、决策树、线性回归…

1692

1692

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?