在本文中,我们将使用PyTorch库来实现一个简单的逻辑回归模型。逻辑回归是一种广泛应用于二分类问题的机器学习算法。我们将通过以下步骤来实现这个模型:

1. 准备数据集

首先,我们需要准备一个包含输入特征和标签的数据集。

import torch:导入PyTorch库,这是一个用于深度学习和机器学习的开源库。

import torch.nn.functional as F:导入PyTorch中的函数模块,这里将其命名为F,方便后续调用。

import numpy as np:导入NumPy库,它是一个用于科学计算的Python库。

import matplotlib.pyplot as plt:导入Matplotlib库,它是一个用于绘制图表和可视化数据的Python库。

接下来是准备数据集的部分:

x_data = torch.Tensor([[1.0], [2.0], [3.0]]):创建一个包含三个样本的输入数据张量(tensor),每个样本是一个一维向量。这里的输入数据为[1.0, 2.0, 3.0]。

y_data = torch.Tensor([[0], [0], [1]]):创建一个包含三个样本的标签数据张量(tensor),每个样本是一个标量。这里的标签数据为[0, 0, 1]。

import torch

import torch.nn.functional as F

import numpy as np

import matplotlib.pyplot as plt

x_data = torch.Tensor([[1.0], [2.0], [3.0]])

y_data = torch.Tensor([[0], [0], [1]])2. 设计模型

接下来,我们需要定义一个逻辑回归模型。定义一个名为LogisticRegressionModel的类,该类继承自torch.nn.Module。这个类实现了一个简单的逻辑回归模型。

在类的构造函数__init__中,通过调用父类的构造函数来初始化模型。然后,创建了一个线性层self.linear,输入维度为1,输出维度也为1。

在forward方法中,将输入数据x传递给线性层进行前向传播计算,得到线性层的输出结果。接着,使用F.sigmoid函数对线性层的输出结果进行激活操作,得到最终的预测值y_pred。最后,返回预测值y_pred作为模型的输出。

接下来,创建了一个LogisticRegressionModel的实例对象model。

这里我们使用PyTorch的`torch.nn.Module`类来定义一个线性层和一个Sigmoid激活函数。

class LogisticRegressionModel(torch.nn.Module):

def __init__(self):

super(LogisticRegressionModel, self).__init__()

self.linear = torch.nn.Linear(1, 1)

def forward(self, x):

y_pred = F.sigmoid(self.linear(x))

return y_pred

model = LogisticRegressionModel()3. 构建损失函数和优化器

为了训练模型,我们需要定义一个损失函数和一个优化器。

1.`criterion = torch.nn.BCELoss(size_average=False)`:这行代码定义了一个二元交叉熵损失函数(Binary Cross Entropy Loss)。`torch.nn.BCELoss`是一个PyTorch中的类,用于计算二元分类任务的损失。`size_average=False`表示在计算损失时,不对每个样本的损失进行平均,而是将所有样本的损失相加。

2. `optimizer = torch.optim.SGD(model.parameters(), lr=0.01)`:这行代码定义了一个随机梯度下降优化器(Stochastic Gradient Descent Optimizer)。`torch.optim.SGD`是一个PyTorch中的类,用于实现随机梯度下降算法。`model.parameters()`表示优化器需要更新的参数,即模型的参数。`lr=0.01`表示学习率为0.01,即每次更新参数时,参数的变化量与梯度成正比,比例系数为0.01。

criterion = torch.nn.BCELoss(size_average=False)

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)4. 训练模型

现在我们可以开始训练模型了。我们将进行1000次迭代,每次迭代都会更新模型的参数以最小化损失函数、计算预测值、计算损失、反向传播梯度并更新模型参数。通常用于训练神经网络模型,通过多次迭代更新模型参数来逐渐提高模型的性能。

for epoch in range(1000):

y_pred = model(x_data)

loss = criterion(y_pred, y_data)

print(epoch, loss.item())

optimizer.zero_grad()

loss.backward()

optimizer.step()5. 测试和绘制结果

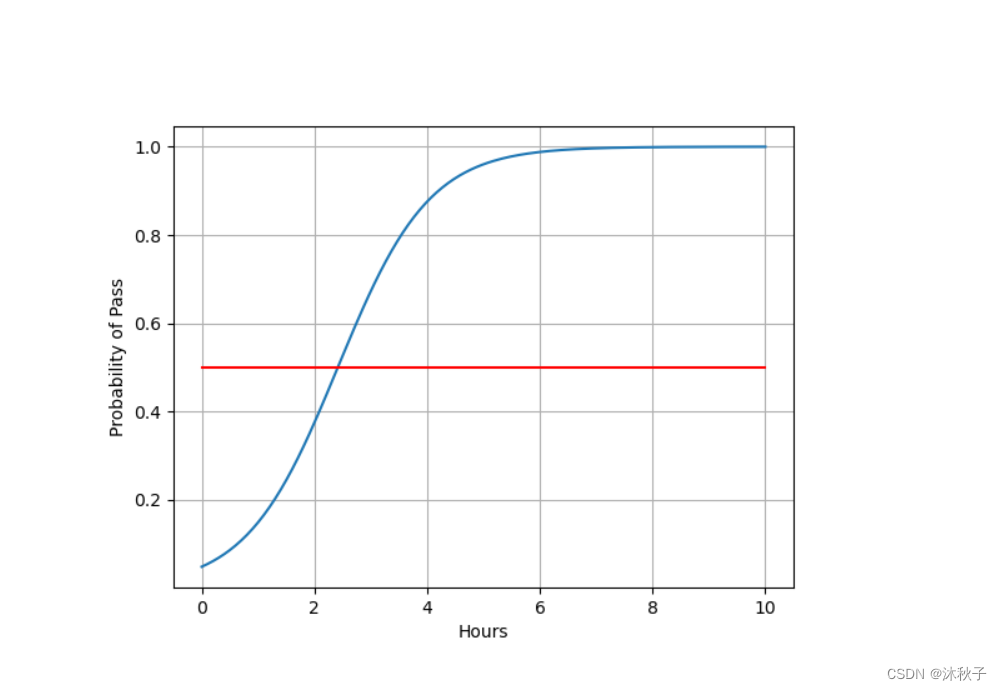

训练完成后,我们可以使用训练好的模型对新的数据进行预测,并将结果绘制成图。在这个例子中,我们使用了一个从0到10的等差数列作为输入特征,并计算了对应的预测概率。最后,我们在概率为0.5的地方画了一条红色直线。

x = np.linspace(0, 10, 200)

x_t = torch.Tensor(x).view((200, 1))

y_t = model(x_t)

y = y_t.data.numpy()

plt.plot(x, y)

plt.plot([0, 10], [0.5, 0.5], c='r')

plt.xlabel('Hours')

plt.ylabel('Probability of Pass')

plt.grid()

plt.show()通过以上步骤,我们成功地使用PyTorch实现了一个简单的逻辑回归模型,并将其应用于一个新的数据集。

下面是运行结果和全部代码

import torch

import torch.nn.functional as F

import numpy as np

import matplotlib.pyplot as plt

# 1.Prepare dataset

x_data = torch.Tensor([[1.0], [2.0], [3.0]])

y_data = torch.Tensor([[0], [0], [1]])

#-------------------------------------------------------#

# 2.Design model using Class

class LogisticRegressionModel(torch.nn.Module):

def __init__(self):

super(LogisticRegressionModel, self).__init__()

self.linear = torch.nn.Linear(1, 1)

def forward(self, x):

y_pred = F.sigmoid(self.linear(x))#多了一个sigmid函数

return y_pred

model = LogisticRegressionModel()

# 3.Construct loss and optimizer

#-------------------------------------------------------#

criterion = torch.nn.BCELoss(size_average=False)

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

#-------------------------------------------------------#

# 4.Training cycle

for epoch in range(1000):

y_pred = model(x_data)

loss = criterion(y_pred, y_data)

print(epoch, loss.item())

optimizer.zero_grad()

loss.backward()

optimizer.step()

# test and plot

x = np.linspace(0, 10, 200)

x_t = torch.Tensor(x).view((200, 1))#将转换为tensor,变成200行,1列

y_t = model(x_t)

y = y_t.data.numpy()#tensor转化为numpy形式

plt.plot(x, y)

plt.plot([0, 10], [0.5, 0.5], c='r')#在概率=0.5时画一条红色直线

plt.xlabel('Hours')

plt.ylabel('Probability of Pass')

plt.grid()

plt.show()

希望这篇文章能帮助你理解如何使用PyTorch实现逻辑回归模型。

本文详细介绍了如何使用PyTorch库实现逻辑回归模型,包括准备数据集、定义模型结构、构建损失函数和优化器,以及训练和测试过程。最后展示了模型预测结果的可视化。

本文详细介绍了如何使用PyTorch库实现逻辑回归模型,包括准备数据集、定义模型结构、构建损失函数和优化器,以及训练和测试过程。最后展示了模型预测结果的可视化。

263

263

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?