前言

在当今信息爆炸的时代,获取准确、大量的数据对于决策和分析至关重要。而网络爬虫作为一种高效的数据获取工具,正在被越来越多的人所关注和应用。在本文中,我将与大家分享网络爬虫的5种数据获取方式,帮助你在数据分析中事半功倍!

1. HTML解析器(HTML Parser):

HTML解析器是最常用的一种数据获取方式。它通过解析HTML页面的结构和标签,提取出所需的数据。Python中的BeautifulSoup和lxml库是常用的HTML解析器工具,它们可以根据标签、类名、ID等特征来定位和提取数据。使用HTML解析器,你可以轻松地从网页中抓取文本、图片、链接等信息。

2. API接口:

随着互联网的发展,越来越多的网站和服务提供了API接口,允许开发者通过接口直接获取数据。使用API接口进行数据获取,不仅可以获得结构化的数据,还可以避免解析网页的复杂过程。通过调用API接口,你可以获取到特定网站或服务中的数据,比如天气数据、股票行情、新闻信息等。只需要了解API接口的使用方法和参数,你就可以轻松地获取所需的数据。

3. 数据库抓取:

有些网站将数据存储在数据库中,而不是通过网页展示。在这种情况下,你可以直接连接到数据库,并编写SQL查询语句来提取数据。通过数据库抓取,你可以获取到更加结构化和完整的数据,方便后续的分析和处理。例如,你可以连接到某个电商网站的商品数据库,获取商品信息、价格、销量等数据。

4. RSS订阅:

如果你想追踪特定网站或博客的更新,RSS订阅是一个很好的选择。RSS订阅可以帮助你获取到网站的最新内容,而不需要每次都访问网站。通过订阅RSS源,你可以获取到网站的标题、摘要、发布时间等信息。这对于新闻聚合、博客追踪和舆情监控非常有用。

5. 网络爬虫框架:

除了自己编写爬虫代码,你还可以使用网络爬虫框架来加快开发速度。网络爬虫框架是预先编写好的、可配置的爬虫程序,可以根据你的需求自动抓取网页并提取数据。知名的Python网络爬虫框架包括Scrapy和PySpider,它们提供了丰富的功能和灵活的配置选项,使你能够更加高效地获取数据。

通过掌握以上5种数据获取方式,你可以根据具体情况选择最适合的方法来进行数据采集。网络爬虫的应用范围非常广泛,可以用于数据分析、市场调研、舆情监测等多个领域。然而,在进行网络爬虫时,务必遵守法律法规和网站的规定,尊重他人的隐私和权益。

总结一下,网络爬虫是一种强大的数据获取工具,可以帮助你快速获取所需的数据。通过使用HTML解析器、API接口、数据库抓取、RSS订阅和网络爬虫框架,你可以轻松地收集大量的数据,并进行进一步的分析和应用。希望本文能够帮助你更好地理解和应用网络爬虫技术,从而在数据获取和分析方面取得更大的成就!

如果你对网络爬虫还有其他问题或者有更多的经验分享,欢迎在评论区与我们互动。

读者福利:知道你对Python感兴趣,便准备了这套python学习资料

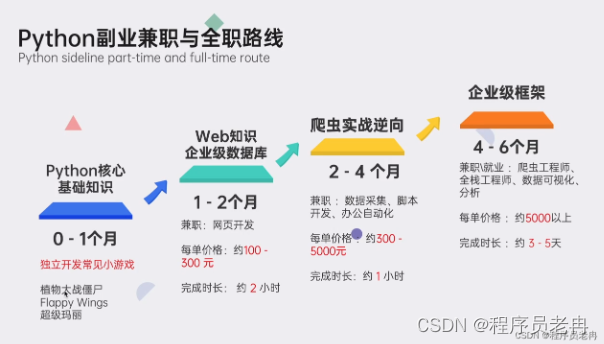

对于0基础小白入门:

如果你是零基础小白,想快速入门Python是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

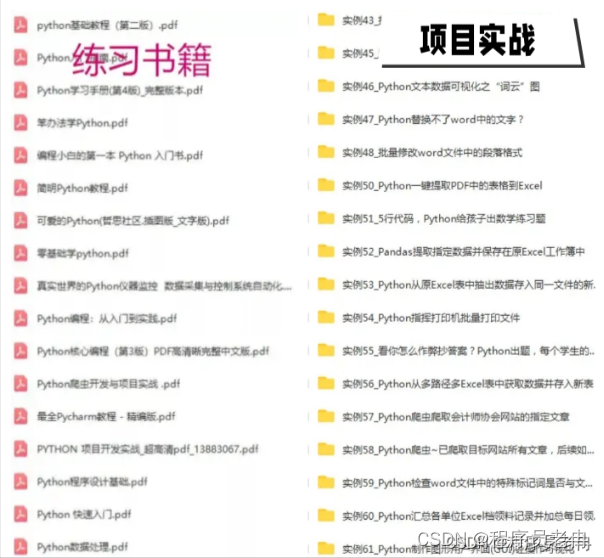

包括:Python永久使用安装包、Python web开发,Python爬虫,Python数据分析,人工智能、机器学习等学习教程。带你从零基础系统性的学好Python!

▍学习资源推荐

零基础Python学习资源介绍

👉Python学习路线汇总👈

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。(学习教程文末领取哈)

👉Python必备开发工具👈

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

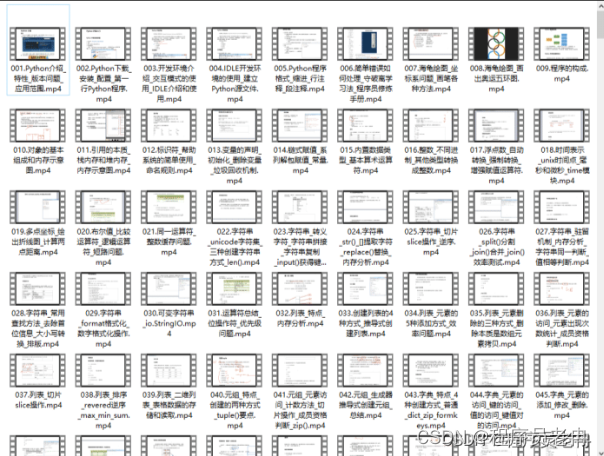

👉Python学习视频600合集👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉实战案例👈

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

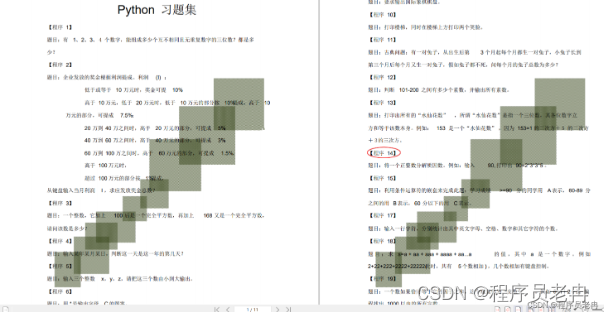

👉100道Python练习题👈

检查学习结果。

👉面试刷题👈

资料领取

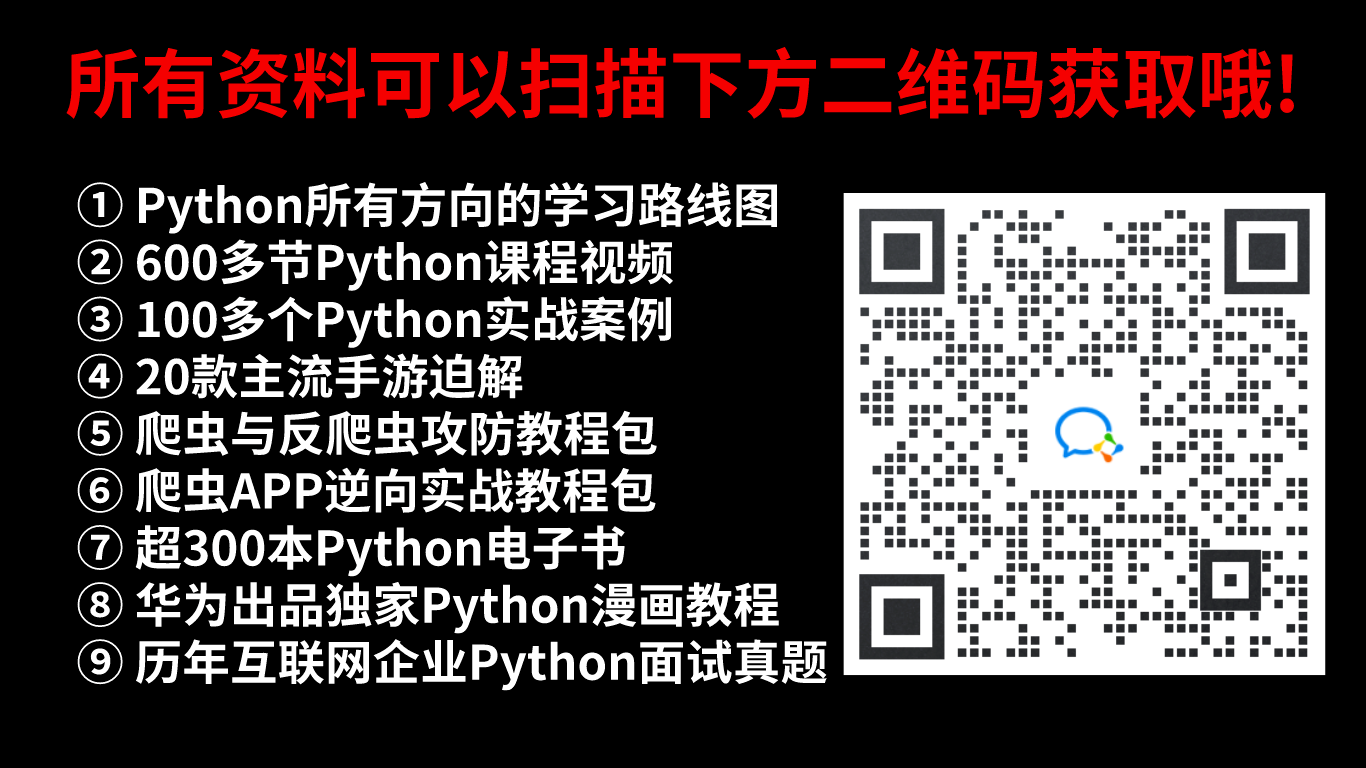

上述这份完整版的Python全套学习资料已经上传CSDN官方,朋友们如果需要可以微信扫描下方CSDN官方认证二维码输入“领取资料” 即可领取。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?