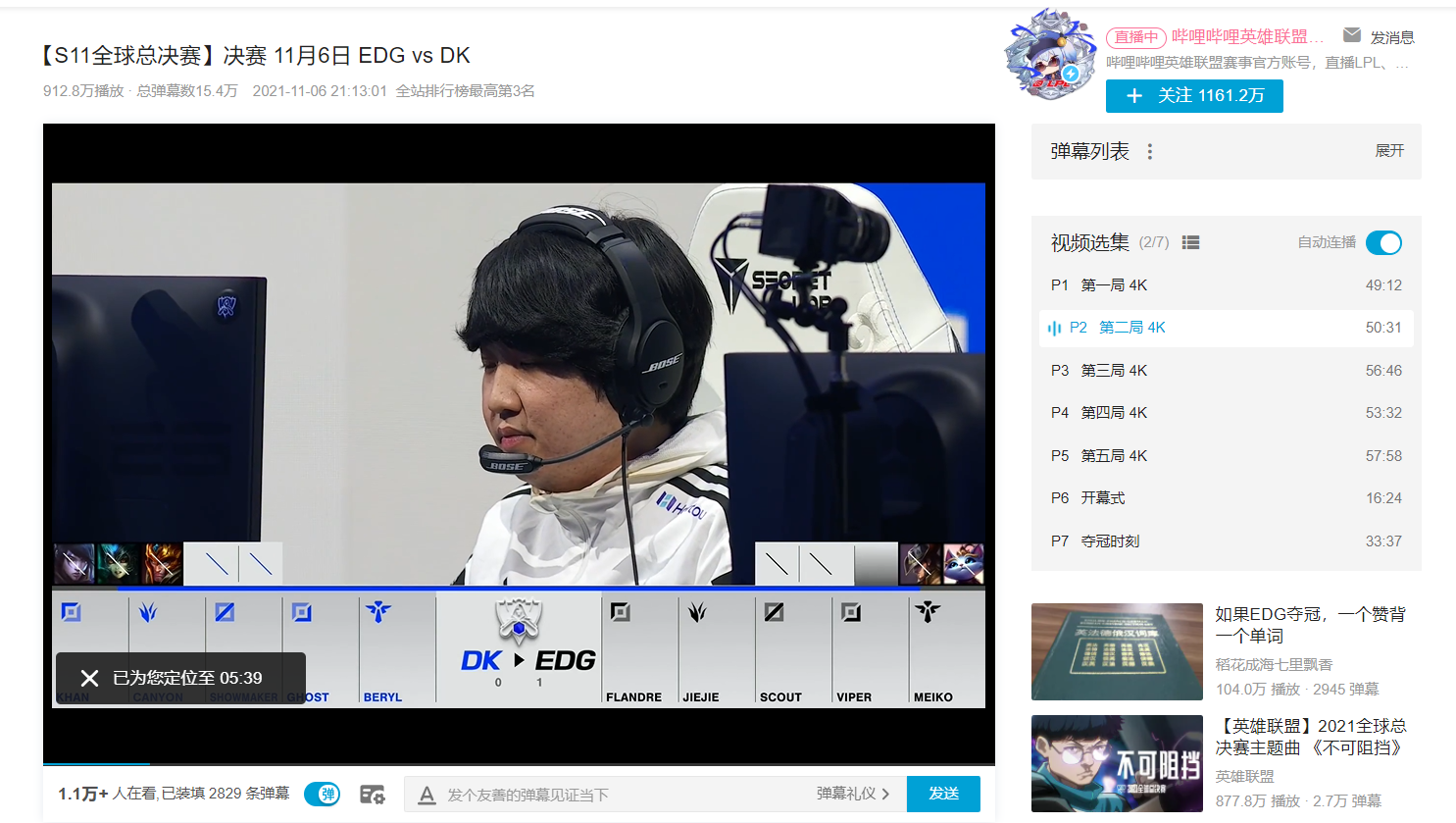

找到你需要采集的视频地址(EDG牛逼!!!!)

网址:【S11全球总决赛】决赛 11月6日 EDG vs DK_哔哩哔哩bilibili_英雄联盟

爬虫采集数据首先要找到对应的数据目标地址,可以明显看出当前的网页的评论数据是在不断变化的,需要找到对应的评论接口,习惯性的去找动态数据。

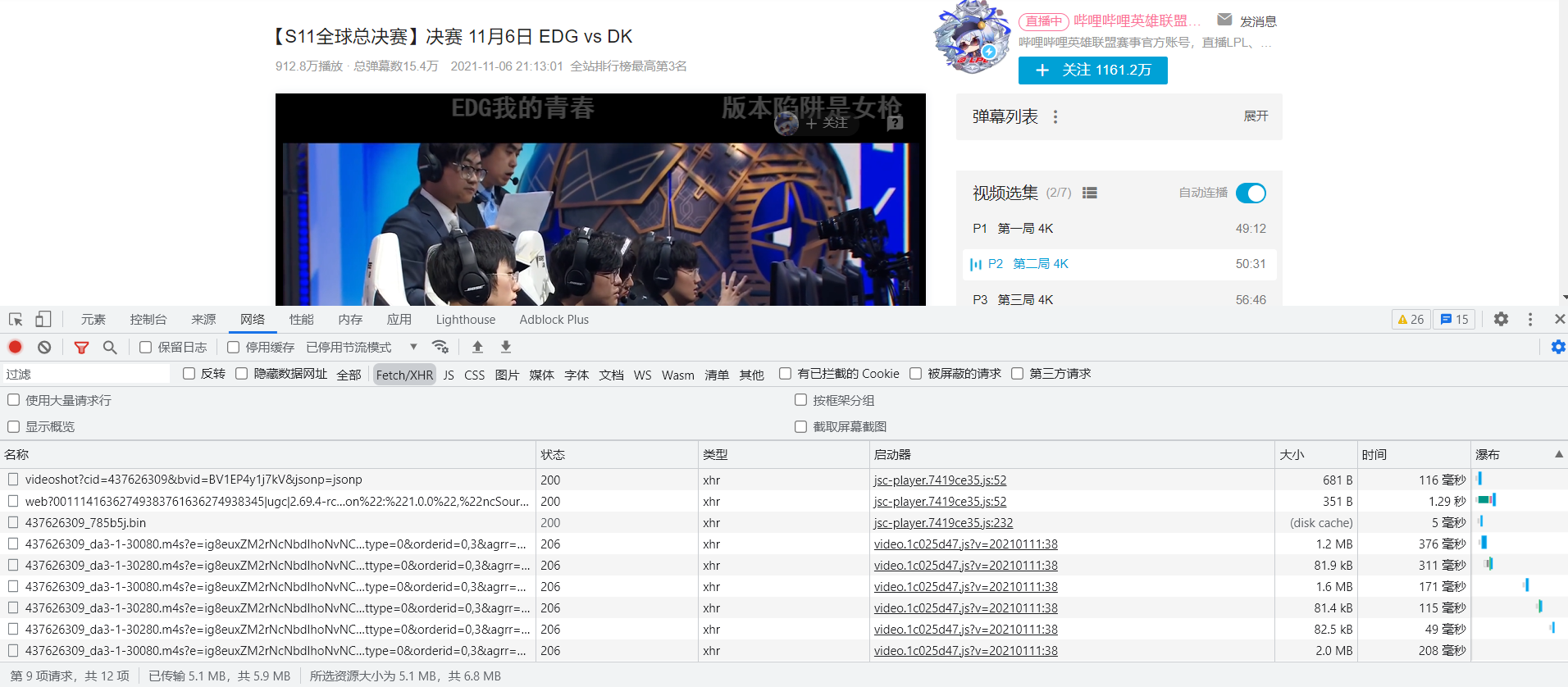

数据并没有在动态数据里,清空数据加载新的评论数据,触发加载条件。

加载的数据在all里,明确数据之后就好处理了,获取到对应的网页接口,通过requests发送网络请求。

url = ‘https://api.bilibili.com/x/v2/reply/main?jsonp=jsonp&next={}&type=1&oid=891511588&mode=3&plat=1&_=1636272184444’.format(i)

response = requests.get(url)

print(response.text)

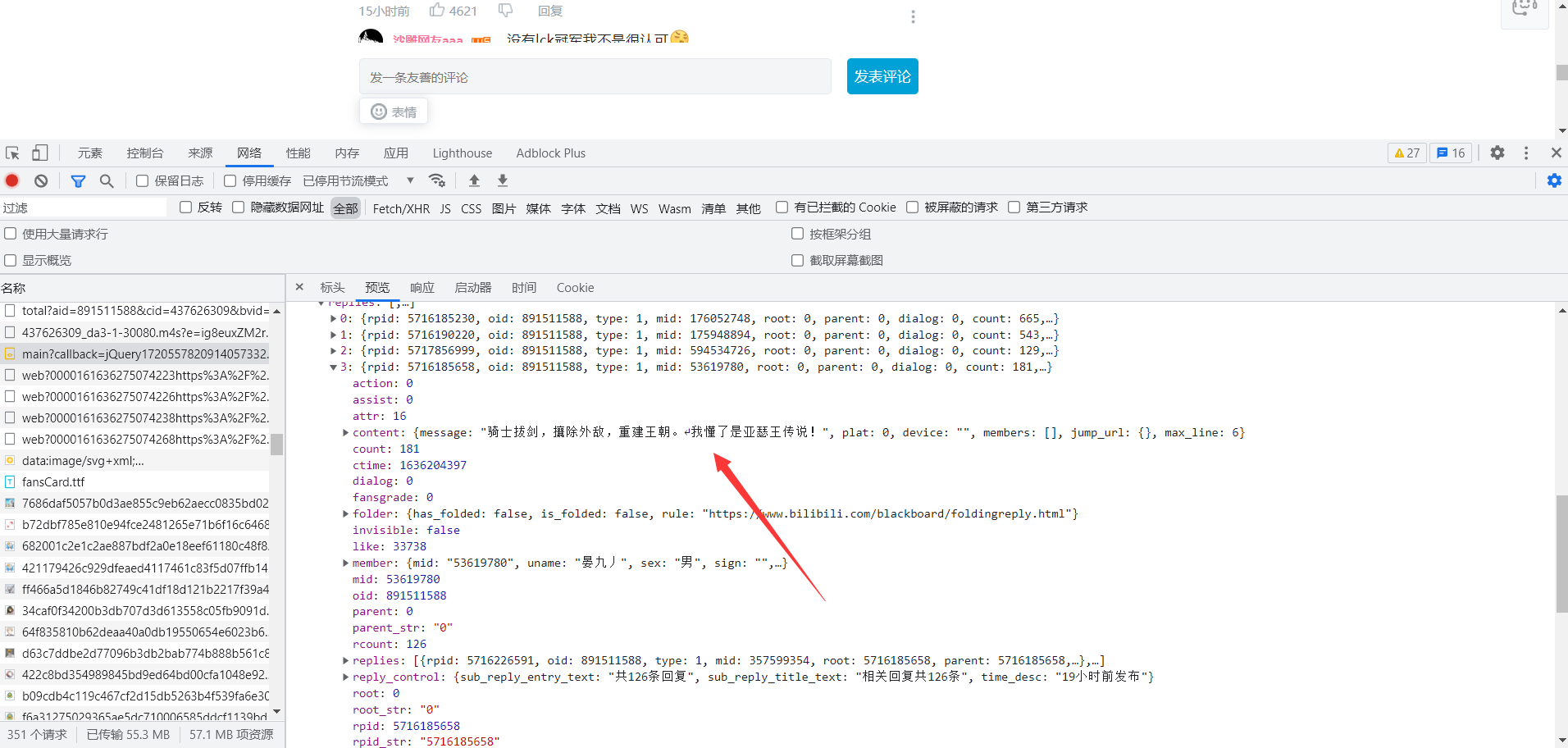

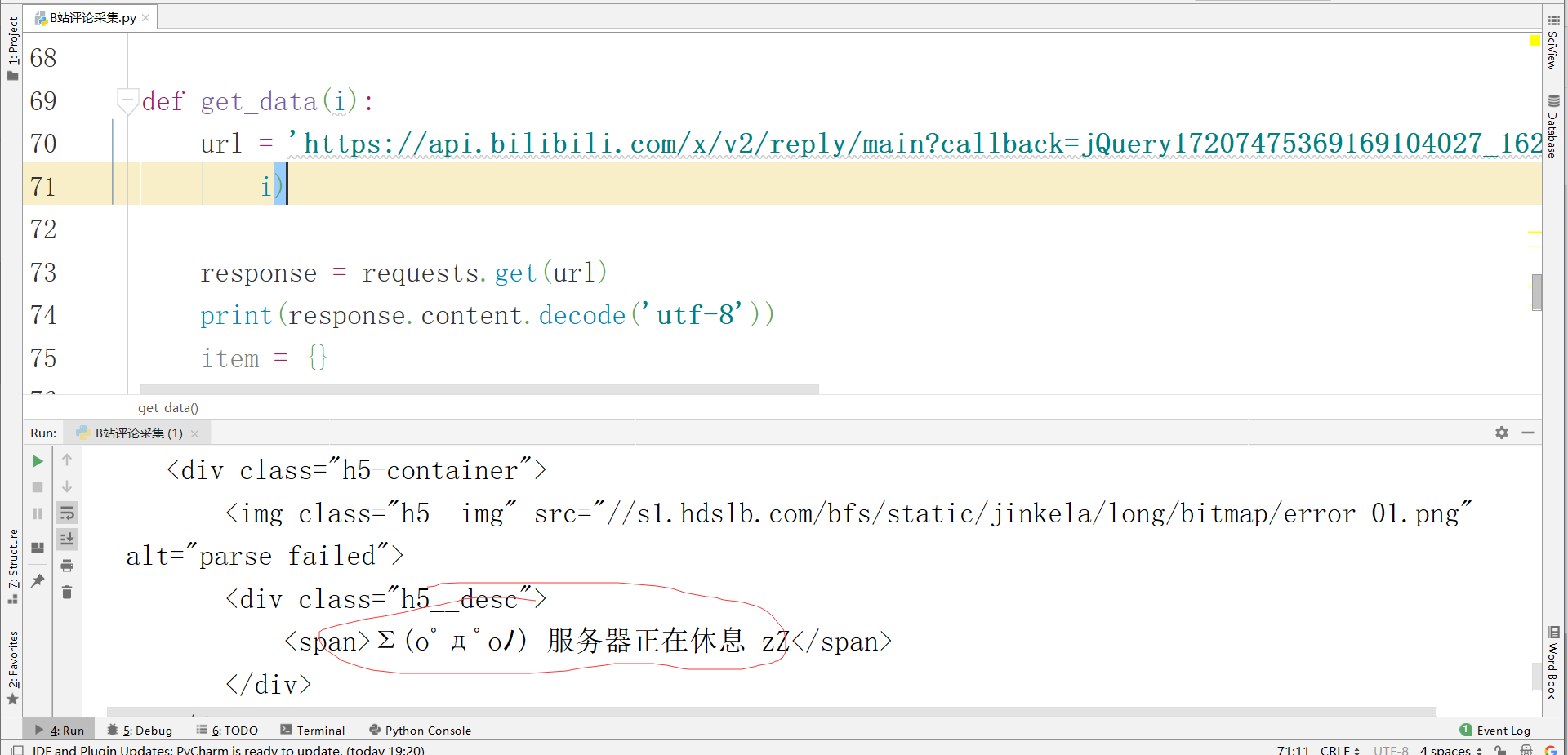

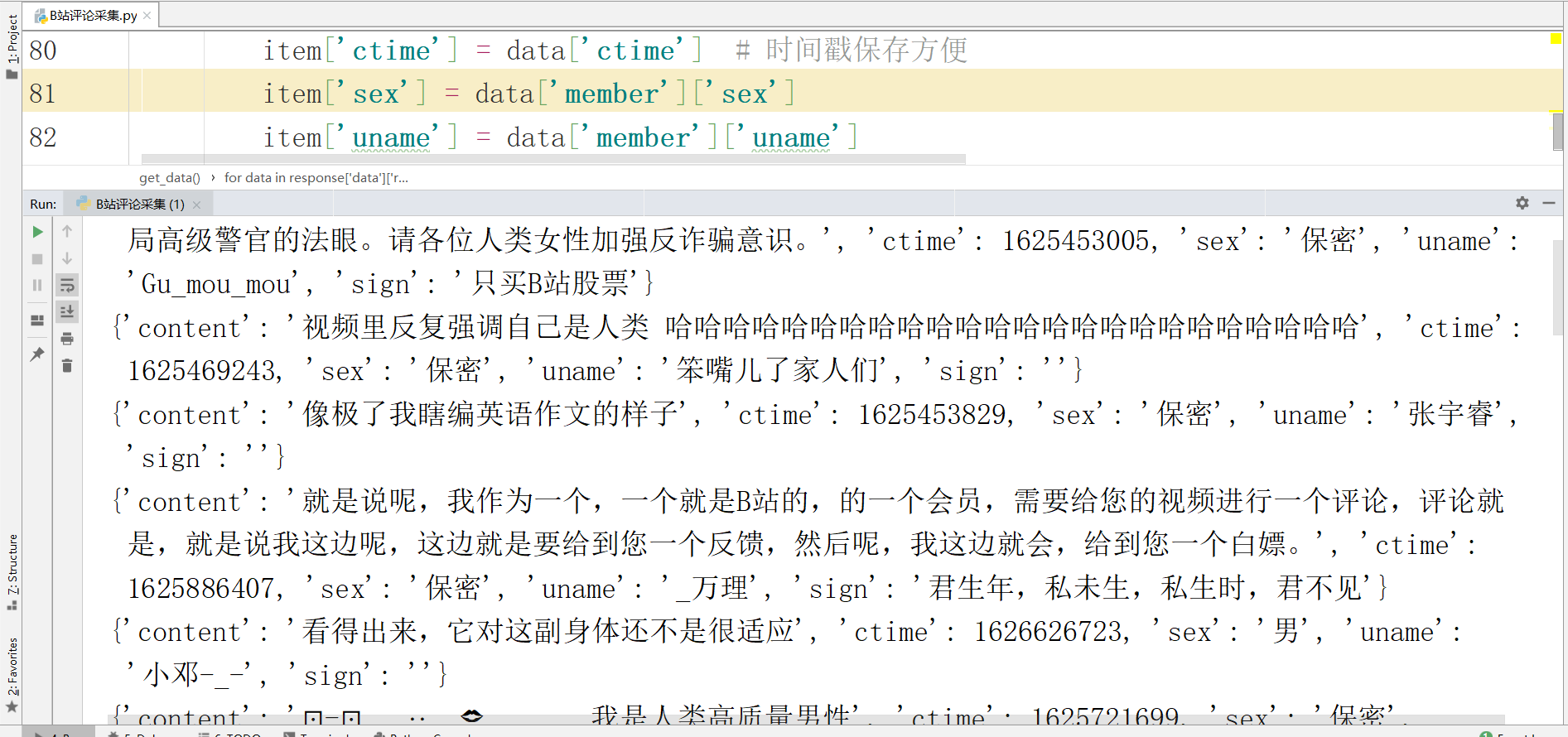

数据请求失败请求头没有做反爬策略 添加对应的ua,以及refere 主要是防盗链的请求头措施,在浏览器请求也是得不到数据的,获取到准确的数据,提取自己想要的数据信息。

-

评论的内容

-

评论的时间

-

评论的作者

-

作者的性别

-

作者的个性签名

-

(各位大佬可以根据自己的需求进行自动的采集数据)

处理json数据时要注意, json数据前有jQuery1720892078778784086_1627994582044 可以通过正则的方式进行匹配提取 这里我选择修改url的参数 讲网址的jQuery1720892078778784086_1627994582044进行删除 最终的网址是:

https://api.bilibili.com/x/v2/reply/main?jsonp=jsonp&next={}&type=1&oid=891511588&mode=3&plat=1&_=1636272184444

获取到数据后进行数据保存,数据保存在csv文件。

def save_data(item):

with open(‘小破站1.csv’, “a”, newline=‘’, encoding=“utf-8”)as f:

filename = [‘content’, ‘ctime’, ‘sex’, ‘uname’, ‘sign’]

csv_data = csv.DictWriter(f, fieldnames=filename)

csv_data.writerow(item)

简易源码分享

import requests

import csv

def save_data(item):

with open(‘EDG牛逼!.csv’, ‘a’, newline=‘’, encoding=‘utf-8’)as f:

filename = [‘content’, ‘uname’, ‘sign’, ‘sex’]

csv_data = csv.DictWriter(f, fieldnames=filename)

csv_data.writeheader()

csv_data.writerow(item)

def get_data(url):

headers = {

‘referer’: ‘https://www.bilibili.com/bangumi/play/ss5852/?from=search&seid=6248919601957945511’,

‘accept’: ‘text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,/;q=0.8’,

‘user-agent’: ‘Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36’,

}

response = requests.get(url, headers=headers).json()

item = {}

for data in response[‘data’][‘replies’]:

item[‘content’] = data[‘content’][‘message’].strip()

print(content)

item[‘uname’] = data[‘member’][‘uname’]

item[‘sign’] = data[‘member’][‘sign’]

(1)Python所有方向的学习路线(新版)

这是我花了几天的时间去把Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

最近我才对这些路线做了一下新的更新,知识体系更全面了。

(2)Python学习视频

包含了Python入门、爬虫、数据分析和web开发的学习视频,总共100多个,虽然没有那么全面,但是对于入门来说是没问题的,学完这些之后,你可以按照我上面的学习路线去网上找其他的知识资源进行进阶。

(3)100多个练手项目

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了,只是里面的项目比较多,水平也是参差不齐,大家可以挑自己能做的项目去练练。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

本文介绍了如何使用Python爬虫技术从Bilibili网站抓取【S11全球总决赛】EDGvsDK决赛的评论数据,涉及到了如何找到动态数据接口、处理请求头以避免反爬、解析JSON数据并保存到CSV文件的过程。

本文介绍了如何使用Python爬虫技术从Bilibili网站抓取【S11全球总决赛】EDGvsDK决赛的评论数据,涉及到了如何找到动态数据接口、处理请求头以避免反爬、解析JSON数据并保存到CSV文件的过程。

1014

1014

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?