先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

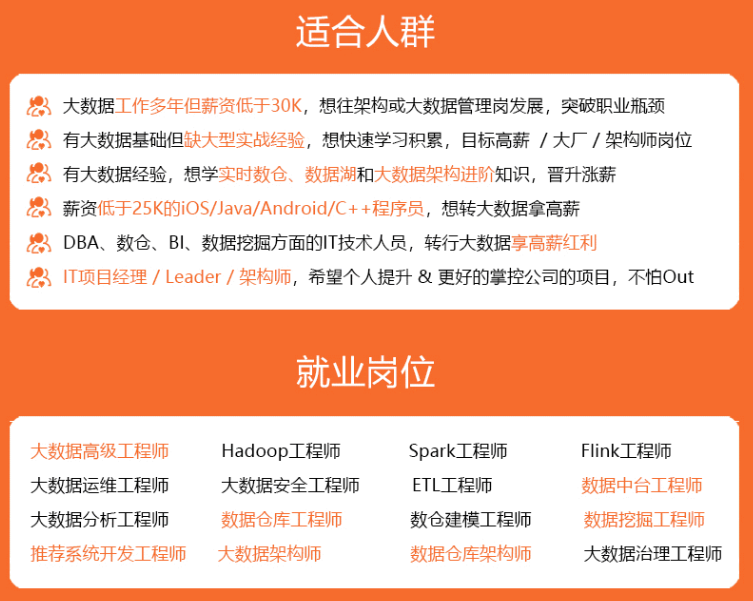

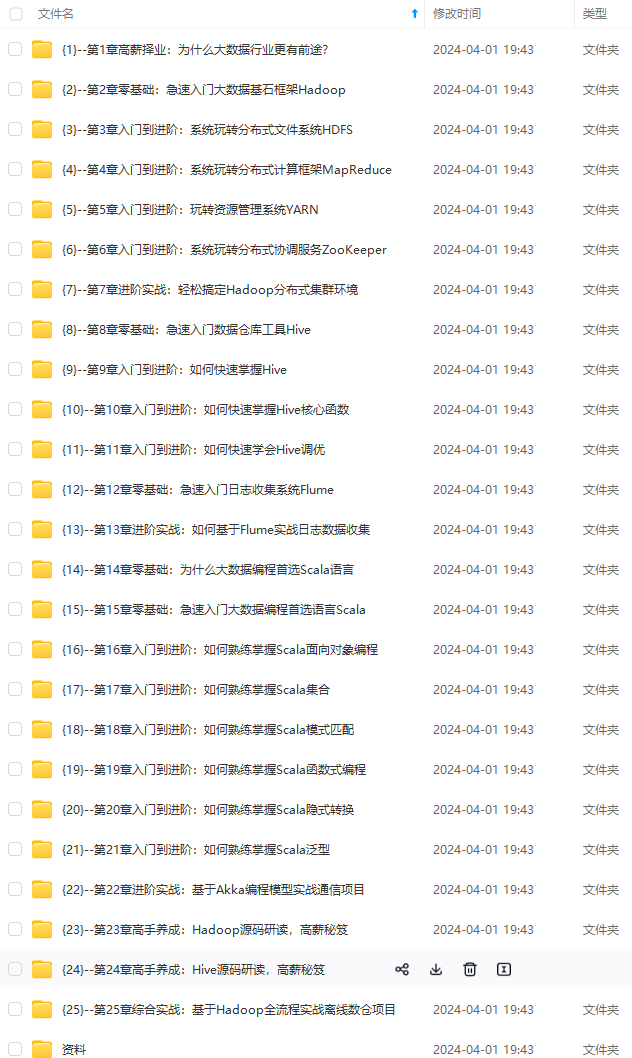

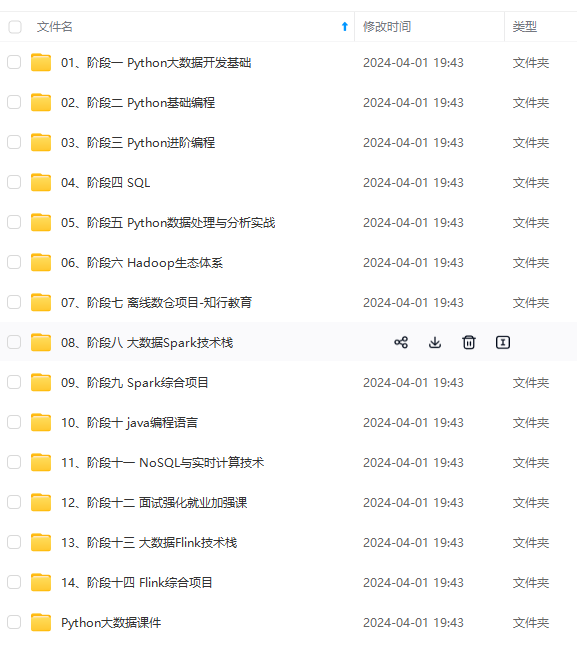

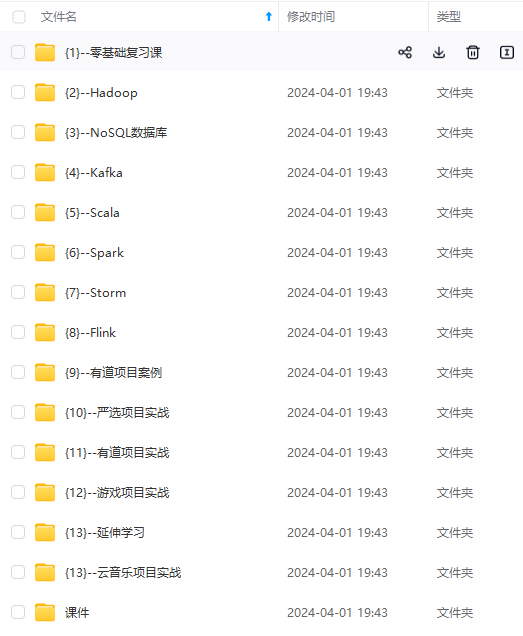

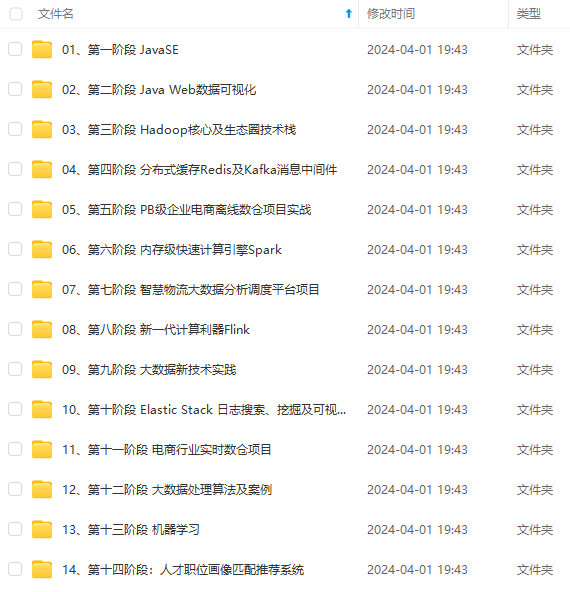

因此收集整理了一份《2024年最新大数据全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip204888 (备注大数据)

正文

node1和node2、node3执行

/export/server/flink-ha/bin/taskmanager.sh start # 每台机器执行

#### 08-Flink on YARN之运行流程

在一个企业中,为了最大化的利用集群资源,一般都会在一个集群中同时运行多种类型的Workload,因此 Flink 也支持在 Yarn 集群运行。

>

> 为什么使用`Flink on Yarn或Spark on Yarn?`

>

>

>

* 1)、Yarn的资源可以按需使用,提高集群的资源利用率

* 2)、Yarn的任务有优先级,根据优先级运行作业

* 3)、基于Yarn调度系统,能够自动化地处理各个角色的 Failover(容错)

`当应用程序(MR、Spark、Flink)运行在YARN集群上时,可以实现容灾恢复。`

#### 09-Flink on YARN之安装部署

Flink on YARN安装配置,此处考虑高可用HA配置,集群机器安装软件框架示意图:

1)、关闭YARN的内存检查(`node1`操作)

yarn-site.xml中添加配置

vim /export/server/hadoop/etc/hadoop/yarn-site.xml

添加如下内容:

2)、 配置Application最大的尝试次数(`node1`操作)

yarn-site.xml中添加配置

vim /export/server/hadoop/etc/hadoop/yarn-site.xml

添加如下内容:

3)、同步yarn-site.xml配置文件(`node1`操作)

cd /export/server/hadoop/etc/hadoop

scp -r yarn-site.xml root@node2: P W D s c p − r y a r n − s i t e . x m l r o o t @ n o d e 3 : PWD scp -r yarn-site.xml root@node3: PWDscp−ryarn−site.xmlroot@node3:PWD

4)、启动HDFS集群和YARN集群(`node1`操作)

[root@node1 ~]# start-dfs.sh

[root@node1 ~]# start-yarn.sh

5)、添加`HADOOP_CONF_DIR`环境变量(**集群所有机器**)

添加环境变量

vim /etc/profile

添加内容:

export HADOOP_CONF_DIR=/export/server/hadoop/etc/hadoop

环境变量生效

source /etc/profile

6)、上传软件及解压(`node1`操作)

[root@node1 ~]# cd /export/software/

[root@node1 software]# rz

上传软件包:flink-1.13.1-bin-scala_2.11.tgz

[root@node1 software]# chmod u+x flink-1.13.1-bin-scala_2.11.tgz

[root@node1 software]# tar -zxf flink-1.13.1-bin-scala_2.11.tgz -C /export/server/

[root@node1 ~]# cd /export/server/

[root@node1 server]# chown -R root:root flink-1.13.1

[root@node1 server]# mv flink-1.13.1 flink-yarn

7)、将Flink依赖Hadoop 框架JAR包上传至`/export/server/flink-yarn/lib`目录

[root@node1 ~]# cd /export/server/flink-yarn/lib/

[root@node1 lib]# rz

commons-cli-1.4.jar

flink-shaded-hadoop-3-uber-3.1.1.7.2.1.0-327-9.0.jar

8)、配置HA高可用,依赖Zookeeper及重试次数(`node1`操作)

修改配置文件

vim /export/server/flink-yarn/conf/flink-conf.yaml

添加如下内容:

high-availability: zookeeper

high-availability.storageDir: hdfs://node1:8020/flink/yarn-ha/

high-availability.zookeeper.quorum: node1:2181,node2:2181,node3:2181

high-availability.zoo

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

997

997

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?