网上有一幅漫画,一个机器人正在对着画板提笔作画,然后配文:人工智能方向是不是搞错了,本来想是AI帮我们洗碗扫地,我们就有空去写诗画画,现在AI开始写诗画画了而我们还在洗碗扫地……

的确,随着人工智能的发展,尤其是ChatGPT的横空出世,人工智能确实能够写诗作画了,而利用人工智能来写一些文章,已经是一些打工人的常规操作。随着人工智能的发展,国内的大模型也层出不穷。

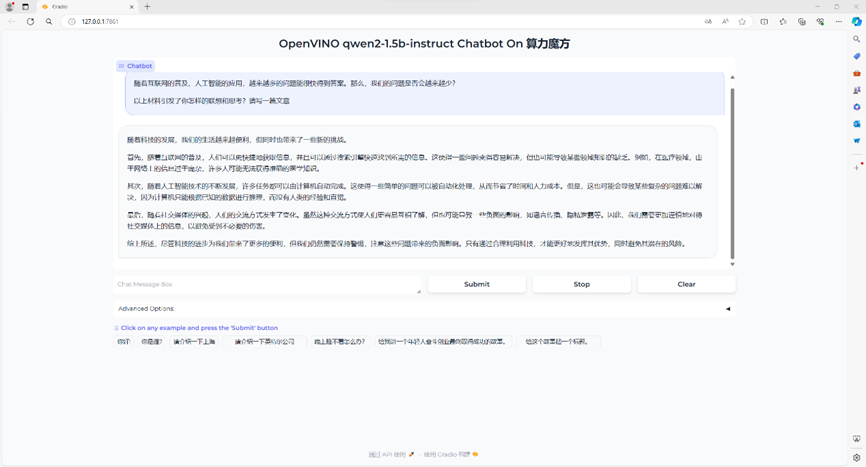

正值高考之季,能否利用人工智能来写高考作文呢?答案是肯定的,这次我们就用Qwen2的模型通过OpenVINO™的加速,让大模型运行在本地,让他写一篇作文。

首先,选一个高考题目:

2024高考题目:

新课标 I 卷

试题内容:

阅读下面的材料,根据要求写作。

“随着互联网的普及、人工智能的应用,越来越多的问题能很快得到答案。那么,我们的问题是否会越来越少?”

以上材料引发了你怎样的联想和思考?请写一篇文章。

接下来就为大家展示是如何在算力魔方®上实现Qwen2-1.5B-Instruct模型的创作。

一,Qwen2简介

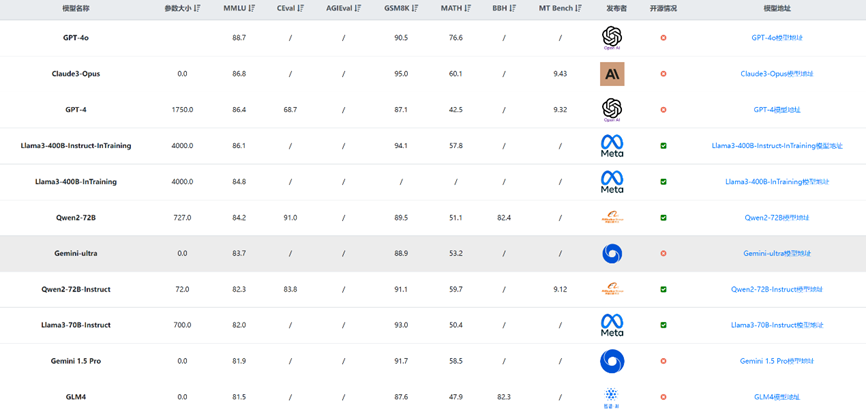

Qwen2是由阿里云通义千问团队开源的新一代大语言模型,该系列涵盖了从0.5B到72B不等的五个规模模型,在中文和英文基础上增加了27种语言的高质量数据,大幅提升了模型的自然语言理解、代码编写、数学解题和多语言处理能力。

引用自:https://qwenlm.github.io/zh/blog/qwen2/

Qwen2支持最长达128K tokens的上下文长度,优化了模型的泛化性和应用潜力。该系列模型在多个评测基准上表现优异,赶超Meta的Llama-3-70B。

模型排行榜引用来源:

https://www.datalearner.com/ai-models/leaderboard/datalearner-llm-leaderboard左滑查看更多

魔搭社区已提供Qwen2 1.5B、7B、72B预训练权重下载,实测下载速度平均17MB/s。

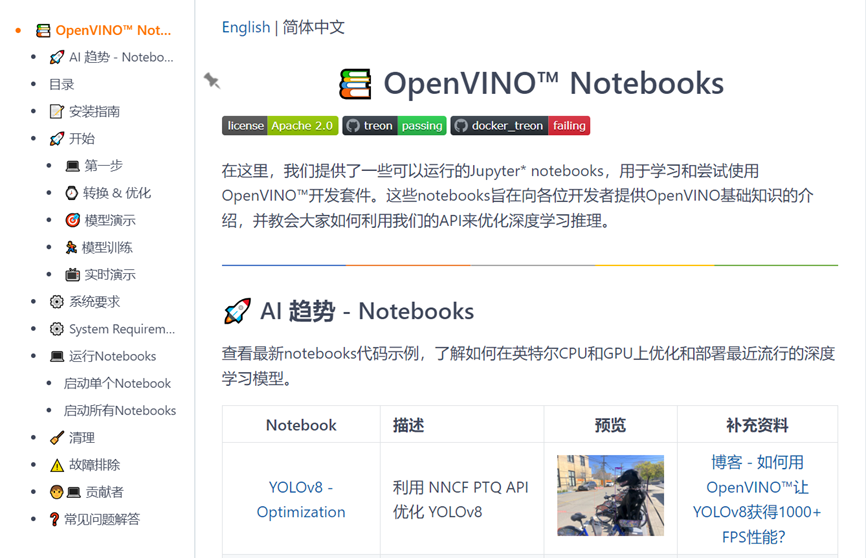

二,OpenVINO™ Notebook简介

OpenVINO™ Notebooks是一套以 Jupyter Notebook 为载体的交互式编程教程和示例代码合集,由英特尔®公司开发和维护。这套资源专为使用 OpenVINO™工具套件的开发者设计,旨在帮助他们更快地理解和掌握如何利用 OpenVINO™进行深度学习模型的优化与推理。

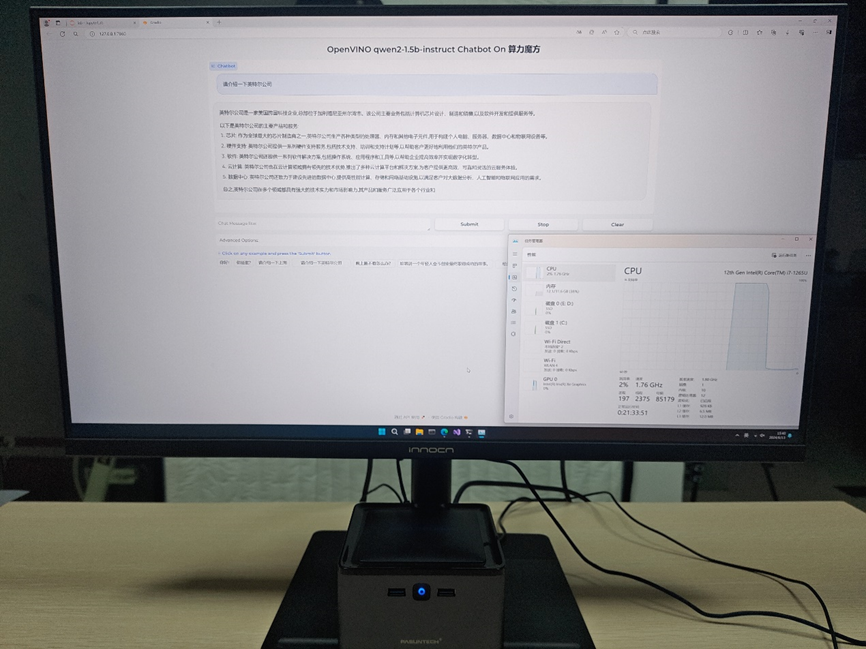

三,平台简介

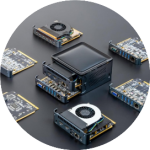

算力魔方®是一款可以DIY的迷你主机,采用了抽屉式设计,后续组装、升级、维护只需要拔插模块。通过选择不同算力的计算模块,再搭配不同的 IO 模块可以组成丰富的配置,适应不同场景。

性能不够时,可以升级计算模块提升算力;IO 接口不匹配时,可以更换 IO 模块调整功能,而无需重构整个系统。

本文以下所有步骤将在带有英特尔®i7-1265U处理器的算力魔方®上完成验证。

通过OpenVINO™ Notebooks三步完成Qwen2的INT4量化和本地部署

Optimum Intel作为Transformers和Diffusers库与Intel提供的各种优化工具之间的接口层,它给开发者提供了一种简便的使用方式,让这两个库能够利用Intel®针对硬件优化的技术,例如:OpenVINO™、IPEX等,加速基于Transformer或Diffusion构架的AI大模型在英特尔®硬件上的推理计算性能。

Optimum Intel代码仓链接:

https://github.com/huggingface/optimum-intel。

第一步,搭建OpenVINO™开发环境:

请下载并安装Anaconda,然后用下面的命令创建并激活名为qwen2的虚拟环境:

conda create -n qwen2 python=3.10 #创建虚拟环境conda activate qwen2 #激活虚拟环境python -m pip install --upgrade pip #升级pip到最新版本

使用下面的指令进行存储库克隆、软件包安装、启动笔记本。

git clone https://github.com/openvinotoolkit/openvino_notebooks.git #克隆存储库pip install -r requirements.txt #安装软件包jupyter lab notebooks #启动笔记本

Qwen2在算力魔方上写2024高考作文!

第二步,使用OpenVINO™ Notebooks内置的推理程序对Qwen2模型进行INT4量化;

基于OpenVINO™内部的llm-chatbotc推理程序,运行后选择中文和qwen2-1.5B模型。

通过内部推理程序的代码:

optimum-cli export openvino --model Qwen2-1.5B-Instruct --task text-generation-with-past --weight-format int4 --group-size 128 --ratio 0.8 qwen2-1.5b-instruct_int4将模型进行IN4量化减少模型占用空间的同时并提高推理速度。

第三步,选择用于推理模型的硬件设备和Optimum-CLI 工具转换模型;

可以在此处选择要进行推理的硬件设备(CPU/IGPU)运行。

Qwen2在算力魔方上写2024高考作文!2

运行结果如下:

Qwen2在算力魔方上写2024高考作文!

四,总结

可以看到,通过短短的几个步骤即可完成开发环境搭建,就能在本地的计算终端——算力魔方®上面,通过OpenVINO™ Notebooks工具包的部署与Qwen2模型INT4量化和推理程序调试。方便快捷的实现将Qwen2本地化部署在基于英特尔®处理器的算力魔方®上。的确实现在本地部署大模型,并且写出了高考作文,至于这篇作文的质量嘛,则还需要提示词的进一步优化。

更多“算力魔方®”内容请点击下方名片,关注“算力魔方”公众号!

470

470

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?