一、hive的概念和由来

1,hive的概念

Hive最早是由Facebook开源用于解决海量结构化日志的数据统计,后贡献给开源社区,成为Apache顶级开源项目。它是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张表,并提供类SQL查询功能,其本质是将HQL转化成MapReduce程序。

2,hive的由来

MapReduce编程十分繁琐,在大多情况下,每个MapReduce程序需要包含Mapper、Reduceer和一个Driver,之后需要打成jar包扔到集群上运 行。如果mr写完之后,且该项目已经上线,一旦业务逻辑发生了改变,可能就会带来大规模的改动代码,然后重新打包,发布,非常麻烦(这种方式,也是最古老的方式)

二、hive的优缺点

Hive:由Facebook开源用于解决海量结构化日志的数据统计。

Hive是管理,读和写数据的工具.

说简单了就是用SQL分析数据.

Hive只能处理结构化数据,处理hadoop里面的数据,你在HDFS上传的数据有很多,比如说软件,视频啥的.只要是文件都能上传到HDFS上面去.但是Hive只能分析结构化的数据,Hive是坐落在hadoop之上的(使用hive前提是必须要安装了hadoop),用来分析大数据的,可以让你的查询和分析更简单.

1.hive处理的数据都在hdfa中,但是hive还会存储一个schema(元数据,就是表结构)在数据库里面.

2.hive是基于在线分析处理,主要为了实现分析功能,分析功能特点是不在乎程序运行时间的,只在乎给大型数据的结果分析出来就行了.

3.hive提供了类似sql的语言,和sql语法还是有点区别的,这个语言主要是用来查询的,叫做hiveql 或者是hql.

三、hive的组件架构

(

1)、用户接口:Client

CLI(command-line interface)、JDBC/ODBC(jdbc 访问 hive)、WEBUI(浏览器访问 hive)

(2)、元数据:Metastore

元数据包括:表名、表所属的数据库(默认是 default)、表的拥有者、列/分区字段、 表的类型(是否是外部表)、表的数据所在目录等;

默认存储在自带的 derby 数据库中,推荐使用 MySQL 存储 Metastore

(3)、Hadoop

使用 HDFS 进行存储,使用 MapReduce 进行计算。

(4)、驱动器:Driver

1.解析器(SQL Parser):将 SQL 字符串转换成抽象语法树 AST,这一步一般都用第 三方工具库完成,比如 antlr;对 AST 进行语法分析,比如表是否存在、字段是否存在、SQL 语义是否有误。

2.编译器(Physical Plan):将 AST 编译生成逻辑执行计划。

3.优化器(Query Optimizer):对逻辑执行计划进行优化。

4.执行器(Execution):把逻辑执行计划转换成可以运行的物理计划。对于 Hive 来 说,就是 MR/Spark。

四、基础环境准备和安装准备

Hive组件需要基于Hadoop系统进行安装。因此,在安装Hive组件前,需要确保Hadoop系统能够正常运行。内容是基于之前已部署完毕的Hadoop全分布系统(HDFS),在master节点上实现Hive组件安装。

(1)Hive组件的部署规划和软件包路径如下:

(1)当前环境中已安装Hadoop全分布系统。

(2)本地安装MySQL数据库(账号root,密码Password123$),编写者软件包在/opt/software/mysql-5.7.18路径下。

(3)MySQL端口号(3306)。

(4)MySQL的JDBC驱动包/opt/software/mysql-connector-java-5.1.47.jar,

在此基础上更新Hive元数据存储。

(5)Hive软件包/opt/software/apache-hive-2.0.0-bin.tar.gz。

(缺一不可)

(2)解压安装文件

(1)使用root用户,将Hive安装包

/opt/software/apache-hive-2.0.0-bin.tar.gz路解压到/usr/local/src路径下。

[root@master ~]# tar -zxvf /opt/software/apache-hive-2.0.0-bin.tar.gz -C /usr/local/src

(2)将解压后的apache-hive-2.0.0-bin文件夹更名为hive;

[root@master ~]# mv /usr/local/src/apache-hive-2.0.0-bin usr/local/src/hive

(3)修改hive目录归属用户和用户组为hadoop

[root@master ~]# chown -R hadoop:hadoop /usr/local/src/hive

四、设置Hive环境

(1)关闭防火墙

(1)关闭 Linux 系统防火墙,并将防火墙设定为系统开机并不自动启动。

# 关闭防火墙服务

[root@master ~]# systemctl stop firewalld

# 设置防火墙服务开机不启动

[root@master ~]# systemctl disable firewalld

(2)卸载 Linux 系统自带的 MariaDB。

# 查询已安装的 mariadb 软件包

[root@ master ~]# rpm -qa | grep mariadb

#卸载已经查询到的mariadb软件包

[root@master ~]# rpm -e --nodeps mariadb-libs-5.5.56-2.el7.x86_64(这是写者自身查到的包)

(3)安装MySQL的mysql common、mysql libs、mysql client、mysql server软件包

[root@master ~]# cd /opt/software/tools-software/

[root@master ~]# rpm -ivh mysql-community-common-5.7.18-1.el7.x86_64.rpm

[root@master ~]# rpm -ivh mysql-community-libs-5.7.18-1.el7.x86_64.rpm

[root@master ~]# rpm -ivh mysql-community-client-5.7.18-1.el7.x86_64.rpm

[root@master ~]# rpm -ivh mysql-community-server-5.7.18-1.el7.x86_64.rpm

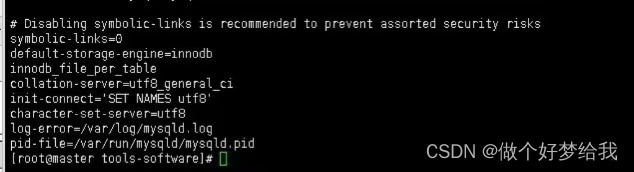

(4)修改 MySQL 数据库配置,在/etc/my.cnf 文件中添加以下数据(在symbolic-links=0 配置信息的下方添加数据)

default-storage-engine=innodb

innodb_file_per_table

collation-server=utf8_general_ci

init-connect='SET NAMES utf8'

character-set-server=utf8

(5)启动mysql数据库

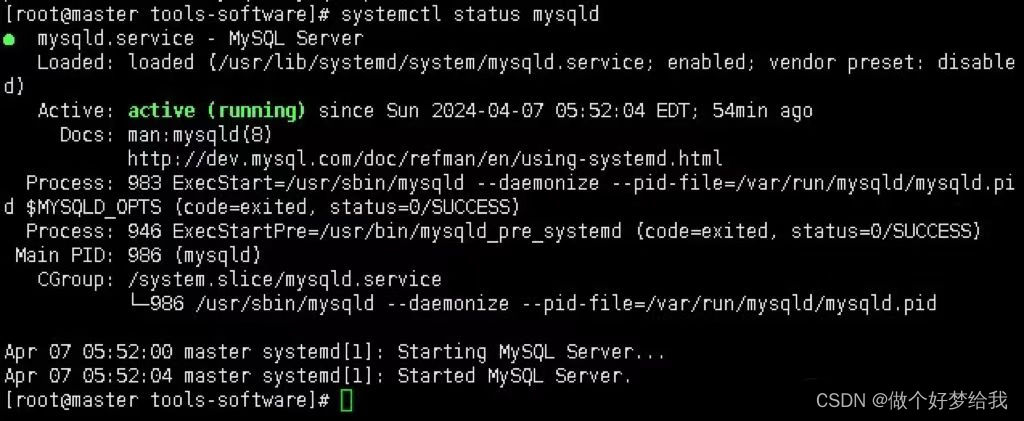

[root@master ~]# systemctl start mysqld

(启动后查看mysql的状态(一定是要running))

(6)查看mysqld自动提供给的随机密码

[root@master ~]# cat /var/log/mysqld.log | grep password

(

7)MySQL 数据库初始化。

(1)执行 mysql_secure_installation 命令初始化 MySQL 数据库,初始化过程中需要设定 数据库 root 用户登录密码,密码需符合安全规则,包括大小写字符、数字和特殊符号, 可设定密码为 Password123$。

在进行 MySQL 数据库初始化过程中会出现以下交互确认信息:

1)Change the password for root ? ((Press y|Y for Yes, any other key for No)表示是否更改 root 用户密码,在键盘输入 y 和回车。

2)Do you wish to continue with the password provided?(Press y|Y for Yes, any other key for No)表示是否使用设定的密码继续,在键盘输入 y 和回车。

3)Remove anonymous users? (Press y|Y for Yes, any other key for No)表示是 否删除匿名用户,在键盘输入 y 和回车。

4)Disallow root login remotely? (Press y|Y for Yes, any other key for No) 表示是否拒绝 root 用户远程登录,在键盘输入 n 和回车,表示允许 root 用户远程登录。

5)Remove test database and access to it? (Press y|Y for Yes, any other key for No)表示是否删除测试数据库,在键盘输入 y 和回车。

6)Reload privilege tables now? (Press y|Y for Yes, any other key for No) 表示是否重新加载授权表,在键盘输入 y 和回车。

(8)添加 root 用户从本地和远程访问 MySQL 数据库表单的授权。

[root@master ~]# mysql -uroot -p

Enter password: #输入自己设置好的密码,写者的密码为:Password123$

进入mysql界面后(mysql的界面为mysql>)

mysql> grant all privileges on *.* to root@'localhost' identified by 'Password123$'; # 添加 root 用户本地访问授权

mysql> grant all privileges on *.* to root@'%' identified by 'Password123$'; # 添加 root 用户远程访问授权

mysql> flush privileges; # 刷新授权

mysql> select user,host from mysql.user where user='root'; #查询root用户授权情况

五、配置Hive组件

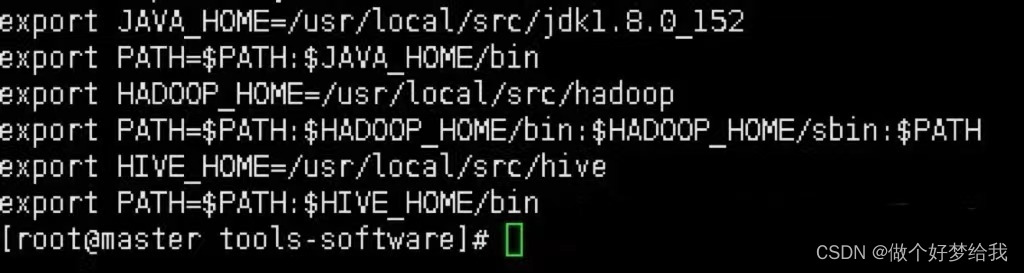

(1)更改环境变量

# 在文件末尾追加以下配置内容

[root@master ~]# vi /etc/profile

# set hive environment

export HIVE_HOME=/usr/local/src/hive

export PATH=$PATH:$HIVE_HOME/bin

# 使环境变量配置生效

[root@master ~]# source /etc/profile

(2)修改 Hive 组件配置文件。

切换到 hadoop 用户执行以下对 Hive 组件的配置操作。 将/usr/local/src/hive/conf 文件夹下 hive-default.xml.template 文件,更名为 hive-site.xml。

[root@master ~]# su - hadoop

[hadoop@master ~]$ cp /usr/local/src/hive/conf/hive-default.xml.template /usr/local/src/hive/conf/hive-site.xml

(3)通过 vi 编辑器修改 hive-site.xml 文件实现 Hive 连接 MySQL 数据库,并设定 Hive 临时文件存储路径。

[hadoop@master ~]$ vi /usr/local/src/hive/conf/hive-site.xml

1)找出<name>javax.jdo.option.ConnectionURL</name>(此项为设置mysql数据库连接)

更改value值,改为<value>jdbc:mysql://master:3306/hive?createDatabaseIfNotExist=true&us eSSL=false</value>

2)找出<name>javax.jdo.option.ConnectionPassword</name>(此项为设置mysql数据库中root的密码)

更改value值,改为<value>Password123$</value>

3)找出<name>hive.metastore.schema.verification</name>(此项为验证元存储版本的一致性)

value值默认为false,如果有错,则更改为<value>false</value>

4)找出<name>javax.jdo.option.ConnectionDriverName</name>(配置数据库驱动)

更改value值,改为<value>com.mysql.jdbc.Driver</value>

5)找出<name>javax.jdo.option.ConnectionUserName</name>(配置数据库用户名 javax.jdo.option.ConnectionUserName 为 root)

更改value值,改为<value>root</value>

6)将<name>hive.querylog.location</name>

<name>hive.exec.local.scratchdir</name>

<name>hive.downloaded.resources.dir</name><name>hive.server2.logging.operation.log.location</name>这四个name的value值改为<value>/usr/local/src/hive/tmp</value>

7)在 Hive 安装目录中创建临时文件夹 tmp

[hadoop@master ~]$ mkdir /usr/local/src/hive/tmp

五、初始化元数据

1)将 MySQL 数据库驱动(/opt/software/mysql-connector-java-5.1.46.jar)拷贝到 Hive 安装目录的 lib 下;

[hadoop@master ~]$ cp /opt/software/mysql-connector-java-5.1.46.jar /usr/local/src/hive/lib/

2)重新启动 hadooop 即可

[hadoop@master lib]$ stop-all.sh

[hadoop@master lib]$ start-all.sh

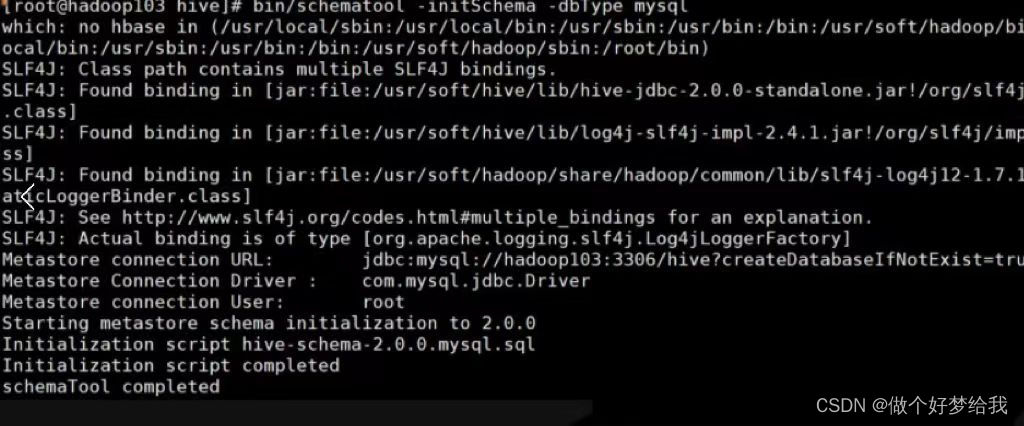

3)初始化数据库

[hadoop@master ~]$schematool -initSchema -dbType mysql

4)启动 hive

[hadoop@master ~]$ hive

5715

5715

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?