最近这一两周看到不少互联网公司都已经开始秋招发放Offer。

不同以往的是,当前职场环境已不再是那个双向奔赴时代了。求职者在变多,HC 在变少,岗位要求还更高了。

最近,我们又陆续整理了很多大厂的面试题,帮助一些球友解惑答疑,分享技术面试中的那些弯弯绕绕。

喜欢本文记得收藏、关注、点赞。更多实战和面试交流,文末加入我们

技术交流

问题1、介绍unet结构

U-Net 是一种用于图像分割的卷积神经网络(CNN),最初在生物医学图像处理领域提出。其结构主要由两个部分组成:

-

编码器(下采样部分):逐层提取特征,使用卷积层和池化层进行下采样。每个卷积层后通常跟着一个 ReLU 激活函数,以增加网络的非线性表达能力。

-

解码器(上采样部分):逐层恢复图像的空间分辨率。通过上采样(如转置卷积)和跳跃连接(skip connections)将编码器中的特征图与对应的解码层特征图结合,从而保留了空间信息。

U-Net 的关键特征是跳跃连接,这有助于保持低层次特征的信息,避免在信息流失的情况下提高特征的抽象层次。最终的输出是一个与输入图像同样大小的分割图。

问题2、介绍GAN,损失函数

GAN 是一种深度学习框架,由两部分组成:生成器(Generator)和判别器(Discriminator)。生成器的目标是生成尽可能真实的样本,而判别器的目标是区分真实样本与生成样本。

-

损失函数:

-

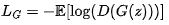

生成器的损失:通常是最大化判别器对生成样本的判别概率,可以表示为

,其中 D 是判别器,G是生成器,z是随机噪声。

,其中 D 是判别器,G是生成器,z是随机噪声。 -

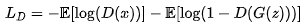

判别器的损失:最小化对真实样本和生成样本的判别误差,可以表示为 ,

,其中 x 是真实样本。

,其中 x 是真实样本。

这两个网络相互博弈,通过训练生成器和判别器来提高生成样本的质量。

问题3、介绍下diffusion,为什么没采用GAN

扩散模型是一种通过逐步添加噪声并在生成过程中反向去噪来生成样本的概率模型。这种模型最早用于生成图像,并且因其生成质量高而受到广泛关注。

为何没采用GAN:

-

训练复杂性:扩散模型通常需要较长的训练时间,且涉及复杂的步骤和参数设置。

-

推理速度:生成过程可能较慢,因为需要多次迭代来逐步去噪。

-

应用领域:在某些应用场景下,传统的 GAN 或 VAE 可能更易于实现或优化。

问题4、transformer 的block结构

Transformer 的基本 Block 结构包含两个主要组件:

-

自注意力层(Self-Attention Layer):通过计算输入序列中所有单词对的权重,允许模型在处理当前单词时考虑上下文。这一层使用了查询(Q)、键(K)和值(V)的概念。

-

前馈神经网络(Feed-Forward Neural Network):通常包含两个线性变换和一个激活函数(如 ReLU),每个输入位置都独立应用。

每个 Transformer Block 还包括层归一化和残差连接,以提高训练稳定性和加速收敛。

问题5、transformer的attention公式

自注意力的计算过程如下:

-

输入:序列中的每个单词表示为一个向量。

-

计算 Q、K 和 V:通过线性变换将输入向量映射为查询(Q)、键(K)和值(V)。

-

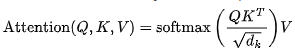

注意力得分:计算 Q 和 K 的点积,然后通过 Softmax 函数得到注意力权重:

,其中d_k是键向量的维度。

,其中d_k是键向量的维度。

问题6、gpt和llama区别

架构:GPT(Generative Pre-trained Transformer)是基于解码器的 Transformer,而 LLaMA(Large Language Model Meta AI)是一个多层次的模型,通常也基于解码器,但设计上可能包含更多的优化策略。

训练数据:LLaMA 在更广泛的数据集上进行训练,GPT 的训练数据则依赖于特定的源。

任务:GPT 通常用于文本生成和对话系统,LLaMA 可能在更多的语言理解任务上表现出色。

问题7、gpt和bert的区别

模型结构:GPT 采用的是解码器架构,而 BERT(Bidirectional Encoder Representations from Transformers)采用的是编码器架构。

训练目标:

-

GPT 的目标是生成下一个单词(自回归)。

-

BERT 的目标是掩蔽语言模型(Masked Language Model),在训练中随机掩蔽一些单词并预测它们。

上下文处理:GPT 主要是单向的上下文,而 BERT 是双向的,能够同时考虑左侧和右侧的上下文信息。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?