现在能在网上找到很多很多的学习资源,有免费的也有收费的,当我拿到1套比较全的学习资源之前,我并没着急去看第1节,我而是去审视这套资源是否值得学习,有时候也会去问一些学长的意见,如果可以之后,我会对这套学习资源做1个学习计划,我的学习计划主要包括规划图和学习进度表。

分享给大家这份我薅到的免费视频资料,质量还不错,大家可以跟着学习

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

Fiddler也在官网上有提供非常详细的文档和教程,如果使用的时候遇到问题,可以直接查阅官网文档。我们可以利用Fiddler详细的对HTTP请求进行分析,并模拟对应的HTTP请求。

fiddler本质就是一个HTTP代理服务器,功能非常强大,除了可以清晰的了解每个请求与响应之外,还可以进行断点设置,修改请求数据、拦截响应内容。

技巧三:解析数据库

解析库有非常多可以选择,比如CSS、pyqery、re、xpath等,比较建议掌握Beautiful Soup和Xpath

Beautiful Soup解析库

为第三方库需要安装使用,在命令行用pip安装就可以了:

pip install bs4

具体用法:变量名称 = BeautifulSoup(需要解析的数据,"html.parser’)

它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序,能自动转换编码。

BeautifulSoup支持的解析器

1.Python标准库:内置库、执行速度适中、文档容错能力强;

2.lxml HTML解析器:速度快,文档容错能力强(推荐);

3.lxml XML解析器:速度快,唯一支持xml的解析器;

4.html5lib:最好的容错性、以浏览器方式解析文档,生成HTML5格式的文档。

具体用法:soup=BeautifulSoup(markup,from_encoding=“编码方式”)

Xpath解析库

提供了非常简洁明了的路径选择表达式,XPath相对于正则表达式显得更加简洁明了,对于网页的节点来说,它可以定义id、class或其他属性。而且节点之间还有层次关系,在网页中可以通过XPath来定位一个或多个节点

规则:

技巧四:保存数据

学到这里就比较容易了,主要是对数据的存储和处理,有两种方式:

小规模数据可以使用txt文件、json文件、csv文件等方式来保存文件。

大规模数据就需要使用数据库了像mysql,mongodb、redis等,就比较方便查询管理。

这一块掌握主流的MongoDB 就可以了,可以方便你去存储一些非结构化的数据,比如各种评论的文本,图片的链接等等。

以上这些核心技巧Python都有相应的库帮你去做,你只需要知道如何去应用它们,掌握精通每一部分的一到两种方法就可以了。

还想对爬虫了解更多的话继续往下看吧

反爬虫应对

当你能够独自爬取80%以上的网站后,再学点反爬技巧,爬虫之路不会有太大的阻碍。

一般爬虫过程中可能会碰到像奇奇怪怪的验证码、被封IP(例如豆瓣和github,在检测到某一客户端频繁访问后,会直接封锁ip)、userAgent访问限制、动态数据加载、加密数据等这种反爬虫的手段。

简单一点的根据User-Agent过滤,例如知乎,我们只需要设置为和浏览器相同即可。常规的解决办法通常有比如控制访问频率、抓包、反加密字体、验证码OCR处理、使用代理IP池等,简单一点的根据User-Agent过滤,例如知乎,我们只需要设置为和浏览器相同即可。能够掌握常规的反爬技巧,绝大部分的网站爬虫不是问题。

这里需要提示一点的是:不要去挑战某宝的反爬!后果很严重!

如果不满足自己的爬虫效率,觉得爬取速度太慢了,可以去学习爬虫框架scrapy和分布式爬虫。

爬虫框架scrapy:

Python开发的一个快速、高层次的屏幕抓取和web抓取框架,用于抓取web站点并从页面中提取结构化的数据。Scrapy用途广泛,可以用于数据挖掘、监测和自动化测试.

Scrapy框架主要由五大组件组成,分别是调度器(Scheduler)、下载器(Downloader)、爬虫(Spider)和实体管道(Item Pipeline)、Scrapy引擎(Scrapy Engine)。

在复杂的情况下,scrapy框架不仅能够便捷地构建request,还有强大的 selector 能够方便地解析 response,这是一个功能十分强大的爬虫框架,可以实现爬虫工程化和模块化。

分布式爬虫

企业级爬虫,能实现数据的大规模采集,通俗一点来理解就是它可以实现多台电脑使用一个共同的爬虫程序,同时将爬虫任务部署到多台电脑上运行,这样可以提高爬虫速度和效率,需要掌握 Scrapy + MongoDB + Redis 这三种工具。

但是分布式爬虫对电脑的CPU和网速都有一定的要求,这个看个人需要,如果你需要用于大规模的数据爬取,分布式爬虫可以帮你解决很多的麻烦。大部分情况下单一爬虫都能满足一般的爬取需要,只是爬取效率比不了分布式爬虫,有条件的可以尝试学学分布式爬虫。

关于Python学习指南

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后给大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

包括:Python激活码+安装包、Python web开发,Python爬虫,Python数据分析,人工智能、自动化办公等学习教程。带你从零基础系统性的学好Python!

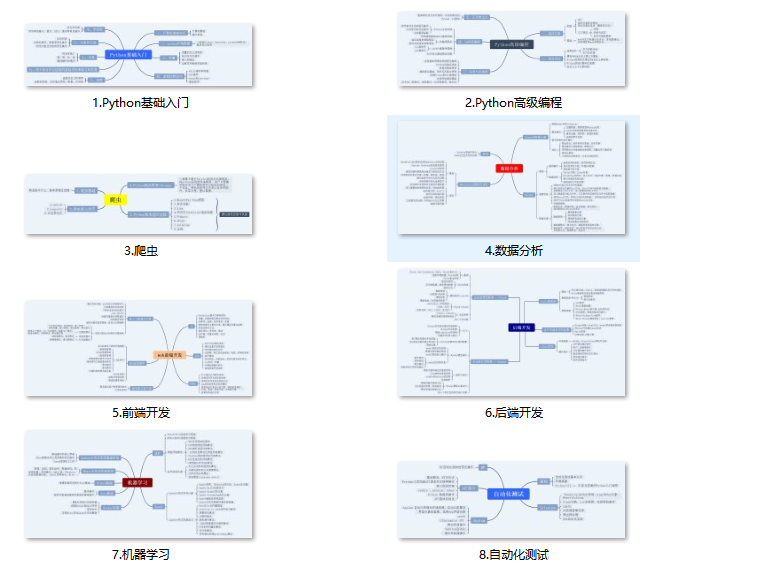

👉Python所有方向的学习路线👈

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。(全套教程文末领取)

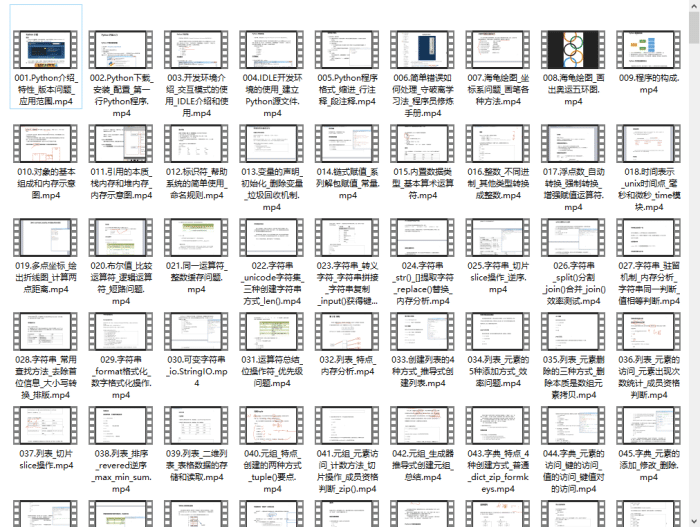

👉Python学习视频600合集👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉Python70个实战练手案例&源码👈

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉Python大厂面试资料👈

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

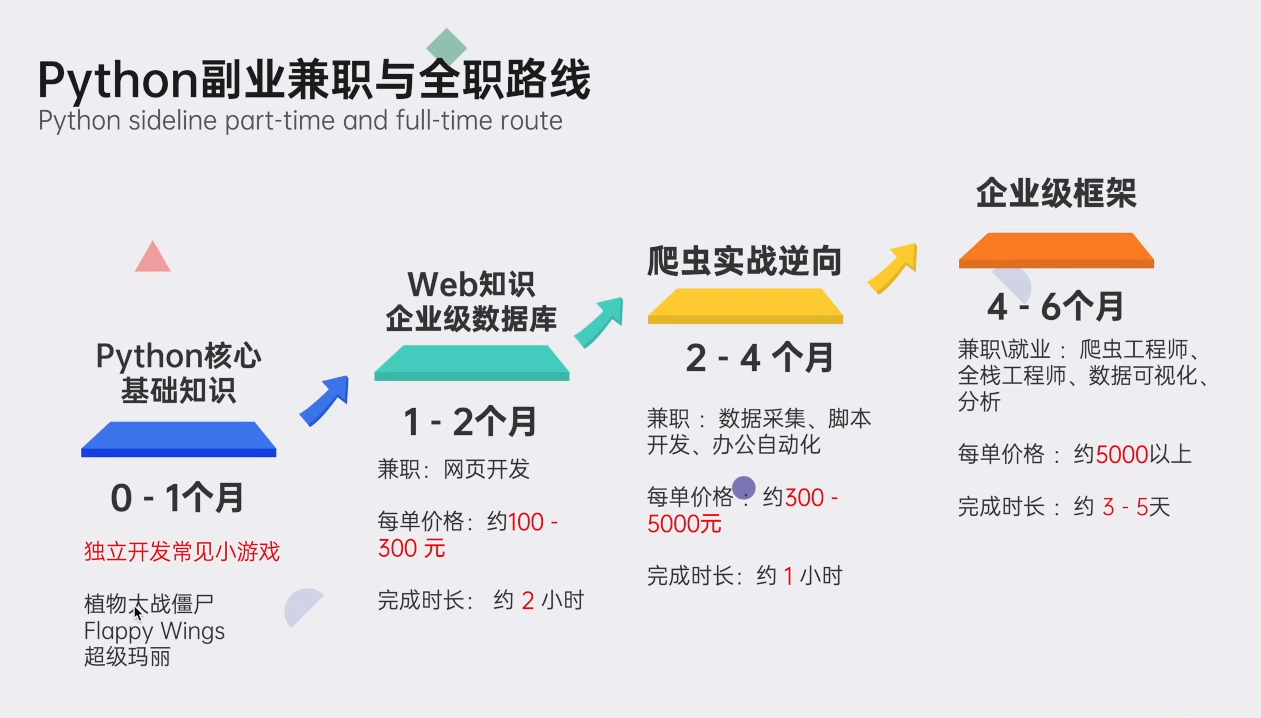

👉Python副业兼职路线&方法👈

学好 Python 不论是就业还是做副业赚钱都不错,但要学会兼职接单还是要有一个学习规划。

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

四、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

五、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

54万+

54万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?