先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

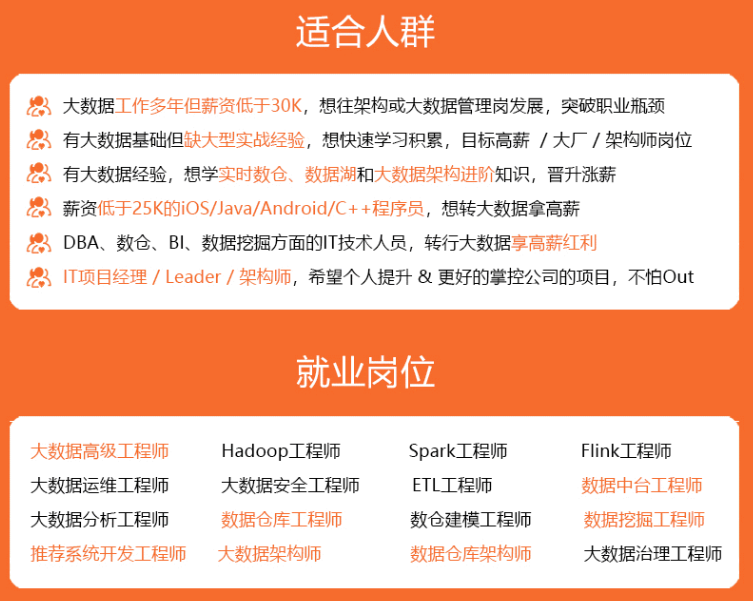

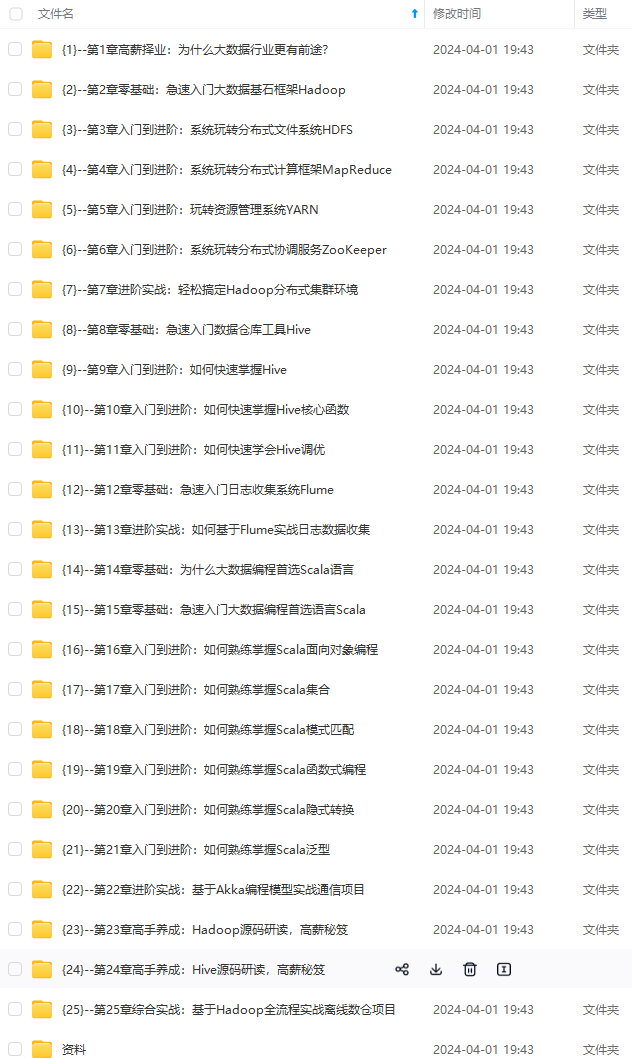

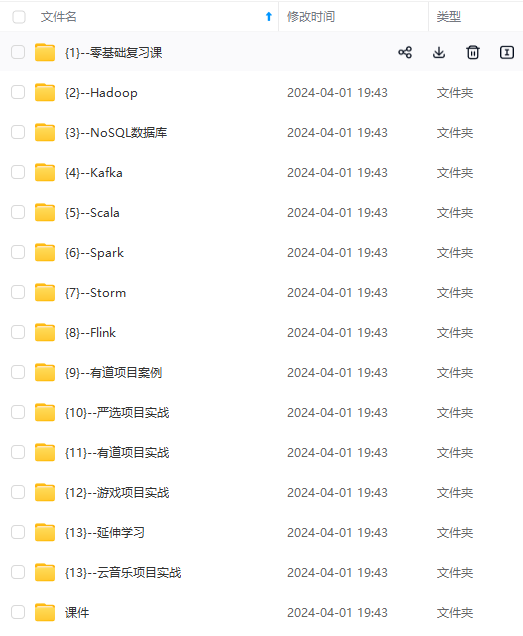

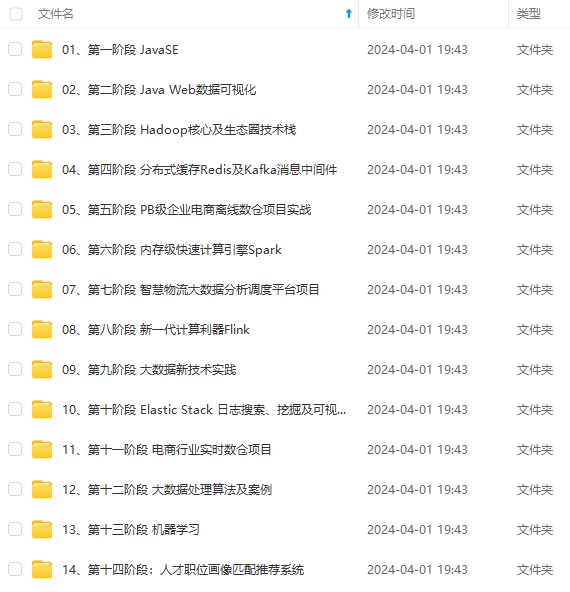

因此收集整理了一份《2024年最新大数据全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip204888 (备注大数据)

正文

为了能看到日志,我们必须手动添加索引:

再回到查询页面的时候我们就可以进行筛选的操作了

3.6:配置

Filebeat提供给我们的配置是非常丰富的,我们可以将收集到的数据写入很多不同的地方

这里我总结了部分常用到的,更多的配置信息我们可以到官网上去查询。

// 输出

filebeat.inputs:

// 类型

- type: filestream

id: my-filestream-id

paths:

- /var/log/*.log

// 模块配置 设置启动模块

filebeat.modules:

- module: nginx

access:

error:

- module: mysql

slowlog:

// 输出到Es

output.elasticsearch:

hosts: ["https://myEShost:9200"]

username: "filebeat_writer"

password: "YOUR_PASSWORD"

index: "%{[fields.log_type]}-%{[agent.version]}-%{+yyyy.MM.dd}"

// 默认行为,当一个事件被 elasticsearch 明确拒绝时,它会被丢弃。

non_indexable_policy.drop: ~

indices:

- index: "warning-%{[agent.version]}-%{+yyyy.MM.dd}"

when.contains:

message: "WARN"

- index: "error-%{[agent.version]}-%{+yyyy.MM.dd}"

when.contains:

message: "ERR"

// 输出到logstash

output.logstash:

hosts: ["localhost:5044", "localhost:5045"]

// 如果设置为 true 并且配置了多个 Logstash 主机,则输出插件会将已发布的事件负载平衡到所有 Logstash 主机上。

// 如果设置为 false,则输出插件将所有事件仅发送到一个主机(随机确定),

// 如果所选主机无响应,则将切换到另一台主机。默认值为假。

loadbalance: true

index: filebeat

proxy_url: socks5://user:password@socks5-proxy:2233

enabled: true

output.kafka:

# initial brokers for reading cluster metadata

hosts: ["kafka1:9092", "kafka2:9092", "kafka3:9092"]

# message topic selection + partitioning 用于生产事件的 Kafka 主题。

topic: '%{[fields.log_topic]}'

partition.round_robin:

reachable_only: false

// 代理要求的 ACK 可靠性级别。0=无响应,1=等待本地提交,-1=等待所有副本提交。默认值为 1

required_acks: 1

// 设置输出压缩编解码器

compression: gzip

// JSON 编码消息的最大允许大小

max_message_bytes: 1000000

3.7:总结:

我们主要完成在Docker环境下部署 Filebeat 日志收集工具,他是搭建ELK日志非常重要的一部分,我们利用Filebeat日志收集完成之后,将数据写入 Elasticsearch 后用 Kibana 进行可视化展示,目前我们已经完成了Fliebeat + Es +Kibana部分。

4:安装logstash

4.1:是什么

Logstash是具有实时流水线能力的开源的数据收集引擎。Logstash可以动态统一不同来源的数据,并将数据标准化到您选择的目标输出。它提供了大量插件,可帮助我们解析,丰富,转换和缓冲任何类型的数据。

4.2:工作方式

管道(Logstash Pipeline)是Logstash中独立的运行单元,每个管道都包含两个必须的元素输入(input)和输出(output),和一个可选的元素过滤器(filter),事件处理管道负责协调它们的执行。

输入和输出支持编解码器,使您可以在数据进入或退出管道时对其进行编码或解码,而不必使用单独的过滤器。如:json、multiline等

inputs(输入阶段):

Logstash 支持各种输入选择,可以同时从众多常用来源捕捉事件。

包括:file、kafka、beats等

filters(筛选阶段):

数据从源传输到存储库的过程中,Logstash 筛选器能够解析各个事件,识别已命名的字段以构建结构,并将它们转换成通用格式,以便进行更强大的分析和实现商业价值。

包括:

- 利用 Grok 从非结构化数据中派生出结构

- 简化整体处理,不受数据源、格式或架构的影响等

outputs(输出阶段):

将事件数据发送到特定的目的地,完成了所以输出处理,改事件就完成了执行。

如:elasticsearch、file、redis等

Codecs(解码器):

基本上是流过滤器,作为输入和输出的一部分进行操作,可以轻松地将消息的传输与序列化过程分开。

4.3:安装

logstash的部署方式有很多种,一般情况下我们可以采用下载 logstash 安装包的方式去启动。

但是官方为我们提供了Docker的部署方式,我比较倾向于利用Docker来进行管理。

#安装

docker pull logstash:7.4.2

#映射

mkdir -p /mydata/logstash/config

mkdir -p /mydata/logstash/pipeline

#创建配置文件

vi logstash.yml

config:

reload:

automatic: true

interval: 3s

xpack:

management.enabled: false

monitoring.enabled: false

#配置文件pipelines.yml(放在/mydata/logstash/config)

vi pipelines.yml

- pipeline.id: logstash_dev

path.config: /usr/share/logstash/pipeline/logstash_dev.conf

#配置文件 logstash_dev.conf(放在/mydata/logstash/pipeline下)

vi logstash_dev.conf

input {

#从filebeat中收集日志

beats {

port => 5047

client_inactivity_timeout => 36000

}

#客户端接入时使用的端口

tcp {

port => 5044

#输入为json数据

codec => json_lines

}

}

filter {

grok {

match => { "message" => "%{COMBINEDAPACHELOG}" }

}

mutate {

convert => {

"bytes" => "integer"

}

}

geoip {

source => "clientip"

}

useragent {

source => "user_agent"

target => "useragent"

}

date {

match => ["timestamp", "dd/MMM/yyyy:HH:mm:ss Z"]

}

}

output {

stdout { }

elasticsearch {

hosts => ["43.138.58.104:9200"]

index => "hkc0327_test_example"

}

}

#启动

#启动

docker run -d -it --restart=always --privileged=true --name=logstash -p 5044:5044 -p 9600:9600 -v /mydata/logstash/pipeline/:/usr/share/logstash/pipeline/ -v /mydata/logstash/config/:/usr/share/logstash/config/ logstash:7.4.2

启动结果:

通过docker logs id 来看logstash是否启动成功:

4.4:修改 filebeat 配置文件

在前面的文章中我们已经将FlieBeat + Es + Kibana 的合并操作

我们只需要修改 filebeat 配置文件 filebeat.yml

将输出地址更改为我们部署的 logstash 地址

filebeat.inputs:

- type: log

enabled: true

paths:

- /usr/share/filebeat/logs/*

output.logstash:

hosts: ["XX.XX.XX.XX:5044"]

#output.elasticsearch:

# hosts: ["XX.XX.XX.XX:9200"]

- 查询是否生成索引

curl http://localhost:9200/_cat/indices?v

- 上Kibana查看

我们主要完成在Docker环境下部署 logstash 日志收集工具,他是搭建ELK日志非常重要的一部分,上一篇文章Filebeat日志收集完成之后,将数据写入 Elasticsearch 后用 Kibana 进行可视化展示,现在我们已经完成了

Filebeat 收集数据写入 logstash处理,再将数据写入 Elasticsearch 后 Kibana 进行可视化展示的全过程。

5:安装kafka

注:kafka能帮助我们削峰。ELK可以使用redis作为消息队列,但redis作为消息队列不是强项而且redis集群不如专业的消息发布系统kafka

5.1:Docker安装zookeeper

Kafka对于zookeeper是强依赖,保存kafka相关的节点数据,所以安装Kafka之前必须先安装zookeeper。

#下载镜像:

docker pull zookeeper:3.4.14

#创建容器

docker run -d --name zookeeper -p 2181:2181 zookeeper:3.4.14

5.2:Docker安装kafka

执行下面命令前,先确认zookeeper端口可以正常访问

#下载镜像:

docker pull wurstmeister/kafka:2.12-2.3.1

#创建容器:

docker run -d --name kafka \

--env KAFKA_ADVERTISED_HOST_NAME=192.168.200.130 \

--env KAFKA_ZOOKEEPER_CONNECT=192.168.200.130:2181 \

--env KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://192.168.200.130:9092 \

--env KAFKA_LISTENERS=PLAINTEXT://0.0.0.0:9092 \

--env KAFKA_HEAP_OPTS="-Xmx256M -Xms256M" \

--net=host wurstmeister/kafka:2.12-2.3.1

部分参数的含义:

KAFKA_BROKER_ID=1 kafka在集群中的唯一标识

KAFKA_ZOOKEEPER_CONNECT=zookeeper:12181 监听zookeeper的地址

KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://192.168.65.7:19092 kafka服务器的地址

5.3:启动kafka的小插曲

因为预算原因,当时我开通的是腾讯云2-2g的服务器,之前我的云服务器上已经安装并启动了redis、ngins、ELK全家桶等,启动kafka的时候会报错内存不够用,如下:

通过free -h命令内存,发现的确没剩多少运行内存了,问题原因找到了:

可以通过swap(内存交换空间)扩容可用的运行内存空间,首先声明扩容的内存容量(本次我扩容大约4G):

# 扩容4G运行内存

# of:空间名称,名为swapfile

# bs:单位,kb

# count:数量(4000000 * 1kb ≈ 4G)

dd if=/dev/zero of=swapfile bs=1024 count=4000000

#设置swap空间:

mkswap swapfile

# 启用

swapon swapfile

然后再启动kafka就没问题了

6:原式版本(ELK)

直接将消息输出到logstash,再输出给es,进而显示在kibana里面:

加入pom依赖。(踩坑点,logstash7.4.2整合的时候,这个版本7.4不能适配,20240326前后几天一直不知道什么问题,后面偶然间把版本改为7.3就可以正常输出日志了)

<!--整合elk-->

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>7.3</version>

</dependency>

新增配置文件logback-spring.xml

<?xml version="1.0" encoding="UTF-8"?>

<configuration scan="true" scanPeriod="60 seconds" debug="false">

<!-- 日志存放路径 -->

<!-- <property name="log.path" value="logs/${project.artifactId}"/>-->

<property name="log.path" value="d:/logs"/>

<!-- 日志输出格式 -->

<property name="console.log.pattern"

value="%red(%d{yyyy-MM-dd HH:mm:ss}) %green([%thread]) %highlight(%-5level) %boldMagenta(%logger{36}%n) - %msg%n"/>

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注大数据)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

path" value="d:/logs"/>

<!-- 日志输出格式 -->

<property name="console.log.pattern"

value="%red(%d{yyyy-MM-dd HH:mm:ss}) %green([%thread]) %highlight(%-5level) %boldMagenta(%logger{36}%n) - %msg%n"/>

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注大数据)**

[外链图片转存中...(img-166Ms33n-1713121543600)]

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

621

621

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?