先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

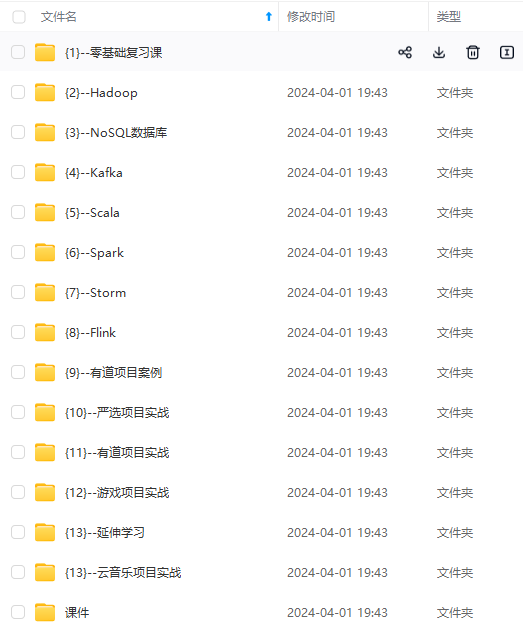

因此收集整理了一份《2024年最新大数据全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip204888 (备注大数据)

正文

flink任务在yarn失败,需要从yarn的归档服务器当中获取运行日志用来排查异常原因,正在运行中的任务日志从当前运行的Node节点中读取,方便监控任务运行信息。

非运行状态的任务日志获取

//构建日志请求对象

ContainerLogsRequest request = new ContainerLogsRequest();

request.setAppId(report.getApplicationId());

request.setAppFinished(report.getYarnApplicationState().equals(YarnApplicationState.FINISHED));

Set<String> logs = new HashSet<>();

request.setLogTypes(logs);

request.setBytes(Long.MAX_VALUE);

request.setAppOwner(report.getUser());

//构建log聚合日志工厂类

LogAggregationFileControllerFactory fileControllerFactory = new LogAggregationFileControllerFactory(configuration);

LogAggregationFileController fileController = fileControllerFactory.getFileControllerForRead(report.getApplicationId(), report.getUser());

//获取日志信息

List<ContainerLogMeta> logMetas = fileController.readAggregatedLogsMeta(request);

//打印容器日志信息,并且将容器所有内容放入其中

logMetas.forEach(containerLogMeta -> {

System.out.println(String.format("容器id:%s 节点id:%s", containerLogMeta.getContainerId(), containerLogMeta.getNodeId()));

containerLogMeta.getContainerLogMeta().forEach(fileInfo -> {

System.out.println(String.format("文件名称:%s,文件大小:%s bytes", fileInfo.getFileName(), fileInfo.getFileSize()));

logs.add(fileInfo.getFileName());

});

});

//读取日志

fileController.readAggregatedLogs(request, System.out);

运行中状态的任务日志获取

YarnConfiguration configuration = YarnClientUtil.buildConfig();

YarnClientImpl client = YarnClientUtil.client(configuration);

//获取yarn上app的状态

ApplicationReport report = client.getApplicationReport(ApplicationId.fromString(appId));

OkHttpClient okHttpClient = new OkHttpClient();

okHttpClient.setConnectTimeout(3, TimeUnit.SECONDS);

okHttpClient.setReadTimeout(15, TimeUnit.SECONDS);

//获取当前任务的集群状态

List<ApplicationAttemptReport> attempts = client.getApplicationAttempts(report.getApplicationId());

//遍历集群,获取集群下当前容器的报告

for (ApplicationAttemptReport attempt : attempts) {

List<ContainerReport> containers = client.getContainers(attempt.getApplicationAttemptId());

//获取当前容器下的日志列表

for (ContainerReport containerReport : containers) {

//构造获取容器下的日志文件请求

Request logReq = new Request.Builder().url(String.join("/", new String[]{containerReport.getNodeHttpAddress(), "ws", "v1", "node", "containers"

, containerReport.getContainerId().toString(), "logs"}))

.get().header("Accept", "application/json").build();

Call call = okHttpClient.newCall(logReq);

Response response = call.execute();

Map<String,List<ContainerLogFileInfo>> logType = new HashMap<>();

if (response.isSuccessful()) {

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注大数据)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

3541

3541

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?