批量写数据,使用es bulk提交数据,数据刷新间隔时间30s(近实时)。

| 数据量 | 总耗时 | 平均每张耗时 |

| 340507 | 170s | 0.5ms |

写入数34万,耗时170s。

最佳查询性能

最终的性能如下表,千万级别的检索可以在毫秒级别。经历了两轮优化。

| 数据规模 | 检索 top-N | 平均耗时 | 最长耗时 |

| 34w (512维度) | 检索 top-1 | [3] ms | [110] ms |

| 检索 top-10 | [6] ms | [150] ms | |

| 检索 top-100 | [26] ms | [810] ms | |

| 1000W (512维度) | 检索 top-1 | [14] ms | [390] ms |

| 检索 top-10 | [22] ms | [220] ms | |

| 检索 top-100 | [42] ms | [73] ms |

~ps 最长耗时是非常重要的指标,要重点关注。这很可能是用户在第一次点击搜索的时候出现的情况。短板效应。

检索优化过程

说明:使用ES原生KNN检索,尝试做了三轮优化。第一轮是对写入的数据,进行一次合并优化;第二轮使用使用开源的插件elastiknn进行优化。第三轮是将数据放在SSD磁盘的机器上。每轮提升两倍。整体性能提升近10倍。(测试结果会受到了Linux os cache的影响,磁盘上的数据从磁盘读取到os cache中 )如果追求检索性能,应该增加内存,来达到将更多的数据放在缓存中去做检索的目的。

ps~ 以下相同颜色做对比。第一轮对比,是forceMerge的优化。第二轮是插件优化。第三轮在千万数据集下做测试,接近生产需求,并且包含了三项优化一起做的场景。把三种优化,放在一起,带来更多的提升!

其中forceMerge优化,只能对不再发生变化的数据做优化。比如昨天入库的数据不再新增和修改,则优化可以生效。但是不适用于实时入库的数据!

| 数据规模 | 优化项 | 检索 top-N | 调用次数 | 总耗时 | 平均耗时 | 最长耗时 |

| 30W | 不优化 | 检索 top-2 | 22727 | [1148351] ms | [50] ms | - |

| force Merge | 检索 top-2 | 22727 | [698089] ms | [30] ms | - | |

| 不优化 | 检索 top-10 | 22727 | [1962618] ms | [86] ms | [5183] ms | |

| 插件优化 | 检索 top-10 | 22727 | [795893] ms | [35] ms | [360] | |

| force Merge | 检索 top-10 | 22727 | [1385920] ms | [60] ms | [2016] ms | |

| 1000W | 不优化(HDD) | 检索 top-10 | - | - | 10 - 20 s | 20s |

| SSD 优化 | 检索 top-10 | 22727 | [2781526] ms | [122] ms | 5s | |

| SSD + 插件 优化 | 检索 top-10 | 22727 | [1046376] ms | [46] ms | 5s | |

| SSD + 插件 + merge优化 | 检索 top-10 | 22727 | [] ms | [22] ms | [220] ms |

使用elastiknn插件优化检索(只看插件优化)

| 数据合并 | 检索 top-N | 调用次数 | 总耗时 | 平均耗时 | 最长耗时 |

| 优化前 | 检索 top-10 | 22727 | [1161129] ms | [51] ms | [387] |

| 优化后 | 检索 top-10 | 22727 | [795893] ms | [35] ms | [360] |

| 优化后 | 检索 top-100 | 22727 | [5776099] ms | [254] ms | [8759] |

华为云es + 自研插件 性能(性能比原生好10倍左右)

测试数据集

DataSet1:SIFT开源数据集,维度128,Base数据集100万条

DataSet2:SIFT10M开源数据集,维度128,Base数据集1100万条

DataSet3:GIST开源数据集,维度960,Base数据集100万条

检索性能

| 数据 | 索引类型 | 查询Top1 | 查询Top10 | 查询Top100 |

| Rec | RT | QPS | ||

| SIFT | GRAPH | 0.992 | 2.63 | 6200 |

| SIFT10M | GRAPH | 0.998 | 3.20 | 5000 |

| GIST | GRAPH | 0.971 | 10.0 | 1500 |

| GIST | GRAPH_PQ | 0.954 | 4.06 | 4000 |

说明:

Rec表示Topk召回率,RT表示平均查询时延(毫秒),QPS表示查询吞吐量;

由于GIST的维度较高,通过使用GRAPH_PQ加速能够极大地提升查询性能,以损失精准度为代价,来提升速度

三、索引结构

以下索引,30万数据规模用一个分片即可。1000万数据规模,给3个分片。

“knn_image_index”: {

“aliases”: {},

“mappings”: {

“properties”: {

“my_image_vector”: {

“type”: “dense_vector”,

“dims”: 512,

“index”: true,

“similarity”: “l2_norm”

},

“pic”: {

“type”: “keyword”

},

“pic_path”: {

“type”: “keyword”

}

}

},

“settings”: {

“index”: {

elastiknn": “true”,

“routing”: {

“allocation”: {

“include”: {

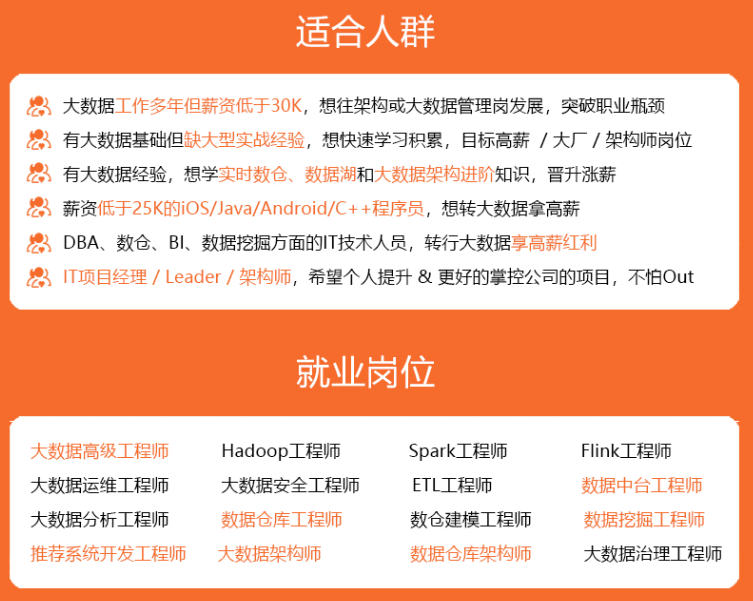

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数大数据工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年大数据全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

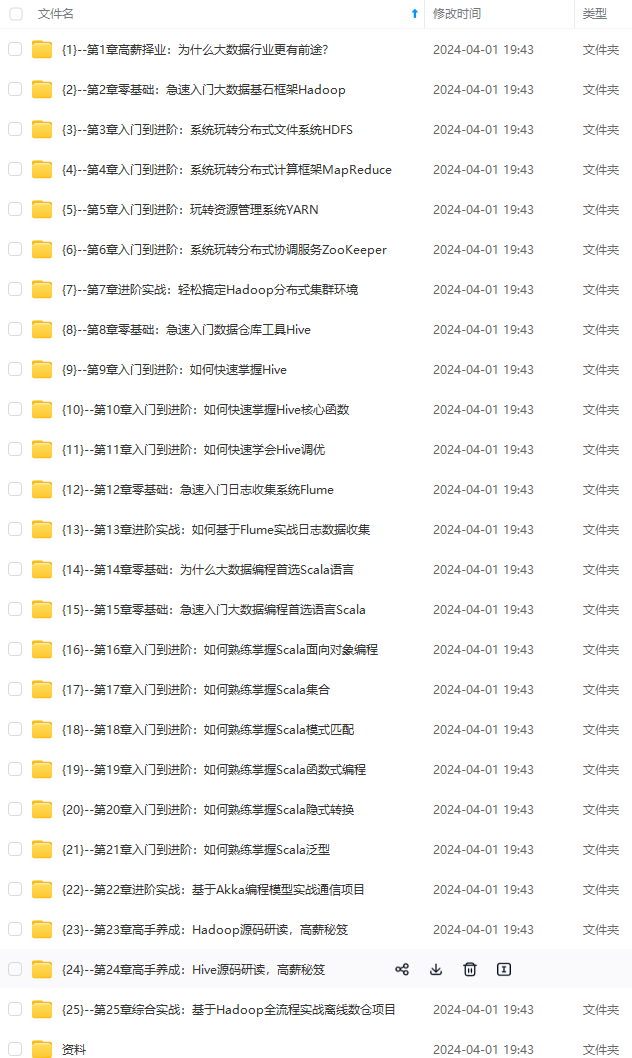

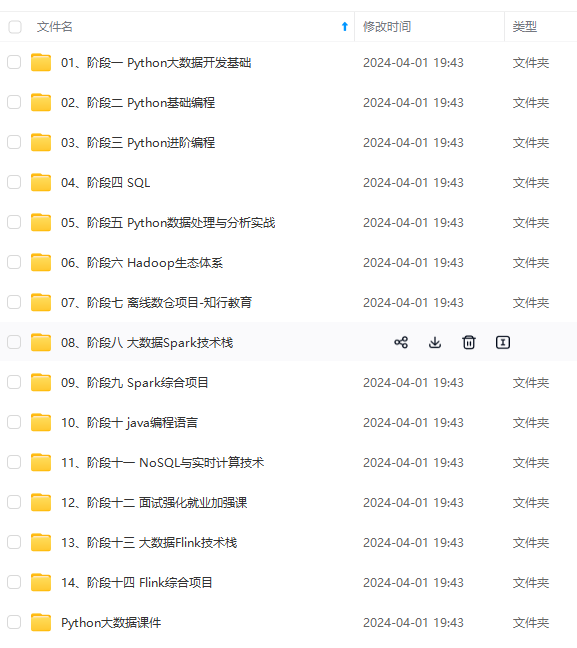

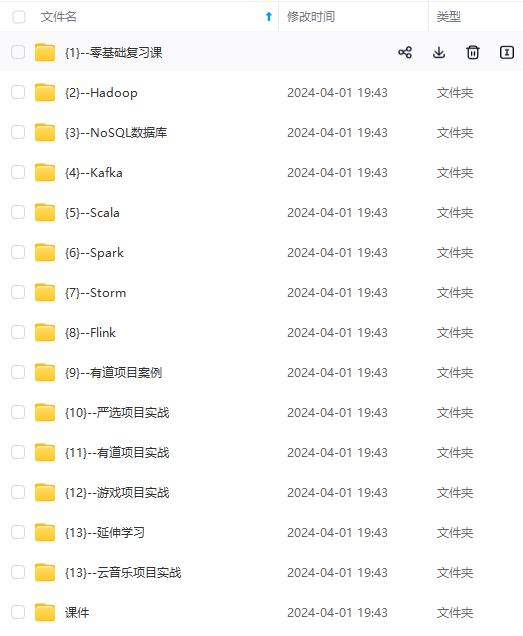

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上大数据开发知识点,真正体系化!

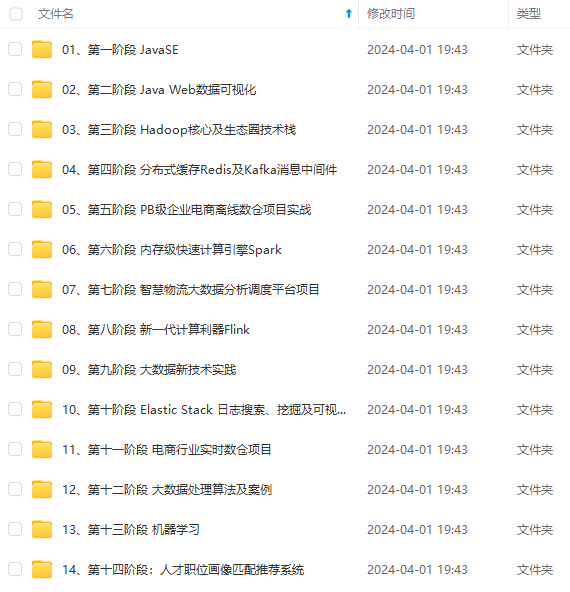

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加VX:vip204888 (备注大数据获取)

点,真正体系化!**

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加VX:vip204888 (备注大数据获取)

[外链图片转存中…(img-4Cr4JoBw-1712516915734)]

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?