先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

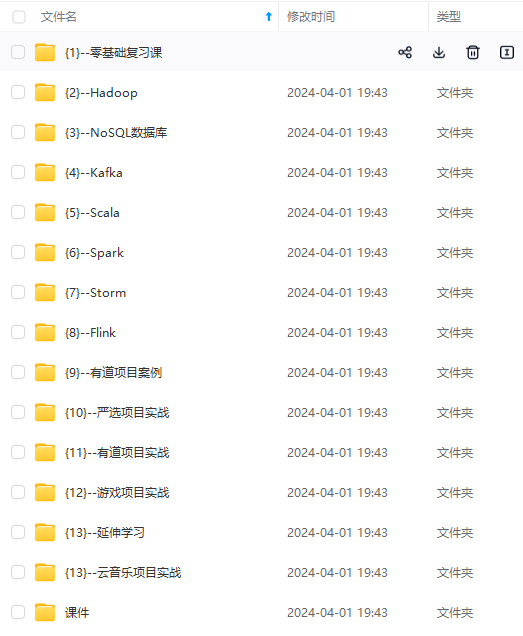

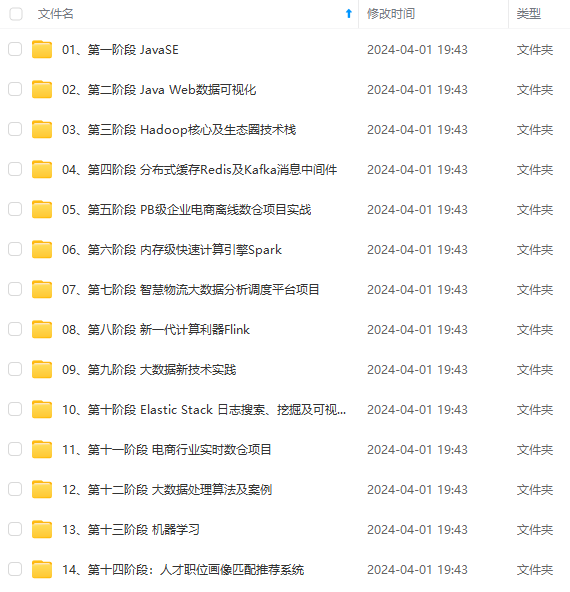

因此收集整理了一份《2024年最新大数据全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip204888 (备注大数据)

正文

在这里,apt(Advanced Packaging Tool)是一个Ubuntu中的Shell前端软件包管理器。apt命令提供了查找、安装、省级、删除某一个/一组甚至全部软件包的命令,且命令非常简洁易记忆。

在使用

h

a

d

o

o

p

hadoop

hadoop用户登录后,要先更新一下apt,因为后续需要用到apt安装软件。我们可以使用下面这条代码:

$ sudo aptget update

如果出现问题,可以参考一下林子雨老师的视频进行配置。

后续我们还需要更改一些配置文件,一般有两种方法:1.使用vim。2.使用gedit。gedit用起来感觉更偏向于windows的txt,对于刚接触Linux系统的同学比较友好。一般来说,linux系统都是默认带有gedit的。gedit的一个坏处是:如果文件更改完不及时关闭gedit程序,会导致终端被占用而无法使用终端。如果需要使用到vim,可以输入下面的代码:

$ sudo apt-get install vim

vim的使用可以参考这篇教程:(4条消息) Linux Vim编辑器的基本使用__HsForPyp的博客-CSDN博客

安装SSH、配置SSH无密码登陆

集群、单节点模式都需要用到SSH登陆(类似于远程登陆),Ubuntu默认已经安装了SSH client,此外还需要安装SSH server:

$ sudo apt-get install openssh-server

安装后,可以使用如下命令登陆本机:

$ ssh localhost

如果你是首次登陆,会出现以下提示,只需要输入yes然后根据题示输入密码,即可登录到本机。

但是这样每次登陆都是需要输入密码,相对来说比较繁琐,将SSH配置成无密码登陆会比较方便。

然后我们可以退出刚才的SSH:

$ exit

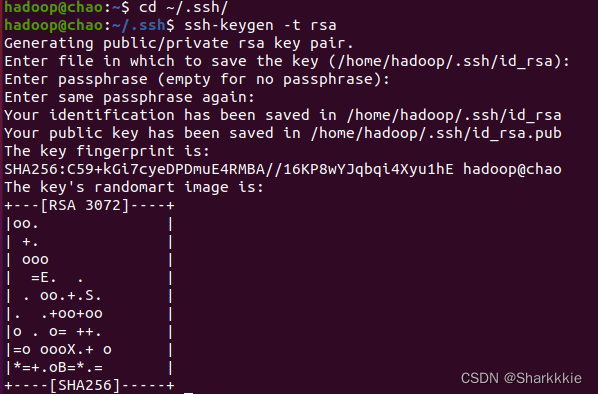

在回到原先的终端窗口后,我们就可以利用SSH-keygen生成密钥,并且将密钥加入到授权中:

$ cd ~/.ssh/

$ ssh-keygen -t rsa #会有提示,一直摁回车就好

$ cat .id_rsa.pub >> ./authorized_keys #加入授权

此时再使用ssh localhost命令,无需输入密码就可以直接登陆了:

安装Java环境

因为我们需要安装的是Hadoop3.1.3,其需要的JDK版本在1.8以上。我们要先在JDK官网下载JDK1.8的安装包并保存到本地,然后手动安装。

在Linux命令行界面中,我们执行如下命令就可以实现安装包的解压缩:

$ cd /usr/lib

$ sudo mkdir jvm #该位置用于存放JDK文件

$ cd ~ #进入到hadoop用户的主目录

$ sudo tar -zxvf ./jdk-8u162-linux-x64.tar.gz -C /usr/lib/jvm #解压JDK文件到jvm目录下

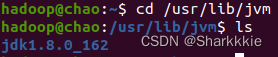

JDK文件解压缩后,我们可以执行如下命令去jvm目录查看一下:

$ cd /usr/lib/jvm

$ ls

看到上图中的结果之后就说明JDK文件已经解压成功。下面继续执行如下命令,设置环境变量:

$ cd ~

$ vim ~/.bashrc

在该文件中,输入上图中四条export语句。要注意JAVA_HOME变量的位置一定要是JAVA安装路径的具体地址,否则后面会卡步骤。

保存.bashrc文件后并退出vim编辑器。然后继续执行如下命令使修改的文件立刻生效:

$ source ~/.bashrc #使文件立刻生效

$ java -version #查看是否安装成功

如果屏幕上返回上图中的信息,则说明JAVA环境安装成功。

Hadoop安装

这个和安装JDK一样,先去Hadoop官网下载相关压缩包即可。

$ sudo tar -zxf ~/hadoop-3.1.3.tar.gz -C /usr/local #解压代码

$ cd /usr/local/

$ sudo mv ./hadoop-3.1.3/ ./hadoop #将文件夹名改为hadoop

$ sudo chown -R hadoop ./haoop #修改文件权限

Hadoop解压之后即可使用,可以通过下面的代码检查其是否可用:

$ cd /usr/local/hadoop

$ ./bin/hadoop version

Hadoop伪分布式配置

如果Hadoop在单节点上以伪分布式的方式运行,Hadoop进程以分离的JAVA进程来运行,节点既可以作为NameNode也可以作为DataNode,同时,该模式下读取的是HDFS中的文件。

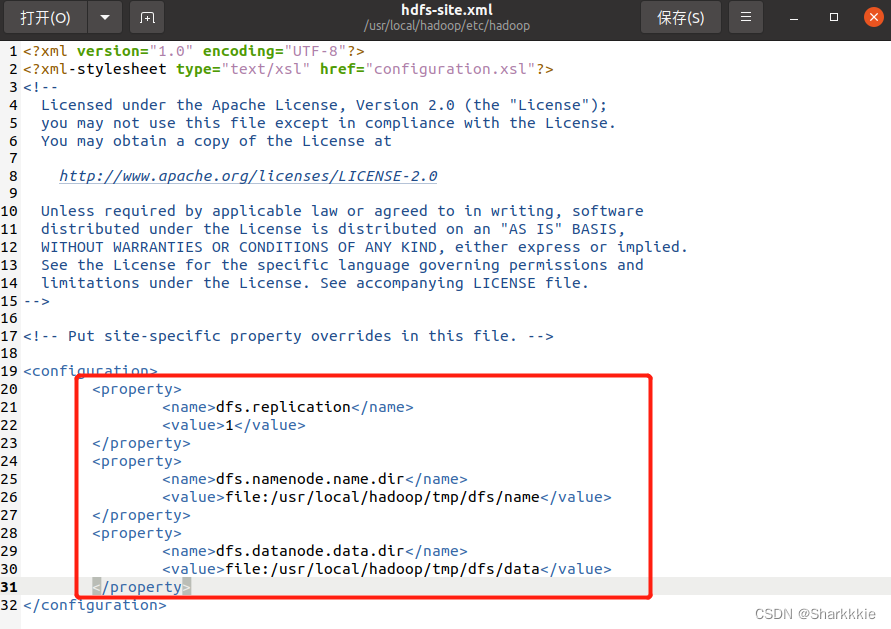

伪分布式需要修改两个配置文件

c

o

r

e

−

s

i

t

e

.

x

m

l

core-site.xml

core−site.xml和

h

d

f

s

−

s

i

t

e

.

x

m

l

hdfs-site.xml

hdfs−site.xml。Hadoop的配置文件是xml形式,每个配置以声明property的name和value的方式来实现。这里的修改会比较多,建议采用gedit编辑会相对来说比较容易上手,方便初学者学习。

需要在两个配置文件中补充上述两张图中红色方框内的内容即可。

配置完成后,我们可以执行NameNode的格式化:

$ cd /usr/local/hadoop

$ ./bin/hdfs namenode -format

成功的话,可以看到如下界面:

成功启动后,我们还可以访问Web界面http://localhost:9870查看Namenode和Datanode信息,还可以在线查看HDFS中的文件。

如果启动中遇到问题,可以先看林子雨老师的相关课程,其中有一些问题的解答。

Hadoop运行实例

HDFS文件读写

我们本文采用的是伪分布式运行模式,可以读取HDFS上的数据。而要使用HDFS上的数据,首先要在HDFS中创建用户目录:

$ ./bin/hdfs dfs -mkdir -p /user/hadoop

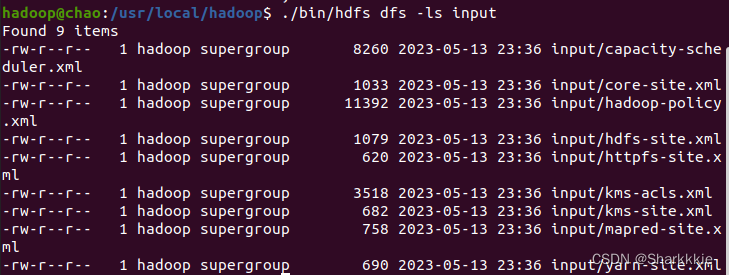

接着我们将本地的xml文件作为输入文件复制到分布式文件系统HDFS中:

$ ./bin/hdfs dfs -mkdir input

$ ./bin/hdfs dfs -put ./etc/hadoop/*.xml input

$ ./bin/hdfs dfs -ls input #复制完成之后,我们可以通过这条命令查看文件列表

伪分布式运行MapReduce作业的方式跟单机模式相同,区别在于伪分布式读取的是HDFS中的文件,我们可以通过单机步骤创建本地input文件夹,输出结果output文件夹都删掉来验证这一点:

可以看到,本地文件的修改并不影响伪分布式读取的结果,伪分布式读取的文件不属于本地,而是HDFS中的文件。

我们也可以将运行结果取回本地:

如果要关闭Hadoop,我们可以运行下面的代码:

$ ./sbin/stop-dfs.sh

否则下次启动hadoop会出现这样的情况:

MAPREDUCE任务运行

如果想知道hadoop是否是开启状态,我们可以输入以下命令进行查看:

jps

可以看到,目前是有四个Java进程正在运行,根据我们的配置情况来看,hadoop目前是开启状态的。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注大数据)

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

如果想知道hadoop是否是开启状态,我们可以输入以下命令进行查看:

jps

可以看到,目前是有四个Java进程正在运行,根据我们的配置情况来看,hadoop目前是开启状态的。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注大数据)

[外链图片转存中…(img-I6xIMDAo-1713129863982)]

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

2871

2871

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?