对于系数

:

例:已知x、y之间的一组数据:

| x | 0 | 1 | 2 | 3 |

| y | 1 | 3 | 5 | 7 |

求y与x的回归方程:

答案 : 其实连起来就是一条线段

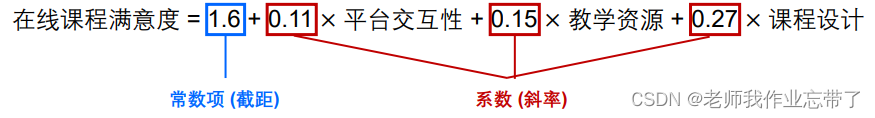

一、什么是回归分析

Regression

回归分析我们通常叫做 Regression ,它其实是一大类方法。我们之前了解到的Predicition它即包括了Regression也包括了Classification,即回归和分类。像是决策树适合的离散型输出,我们一般叫做分类;而对于连续型输出的问题,比如用户的满意度、一个家庭一年的开销或者是用户星级的评价、用户的点击又或是一些概率等等,就要用到这次介绍的Regression方法。

回归分析是描述变量间关系的一种统计分析方法

• 例:在线教育场景

• 因变量 Y:在线学习课程满意度

• 自变量 X:平台交互性、教学资源、课程设计

• 预测性的建模技术,通常用于预测分析

• 预测的结果多为连续值(但也可以是离散值,甚至是二值)

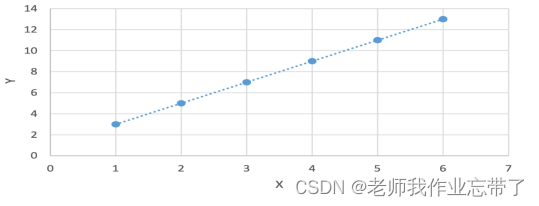

二、简单线性回归

线性回归 (Linear regression)

因变量和自变量之间是线性关系,就可以使用线性回归来建模

线性回归的目的即找到最能匹配(解释)数据的截距和斜率

- 有些变量间的线性关系是确定性的

| x | 1 | 2 | 3 | 4 | 5 | 6 |

| y | 3 | 5 | 7 | 9 | 11 | 13 |

所以当 x=7时,我们预测为15.

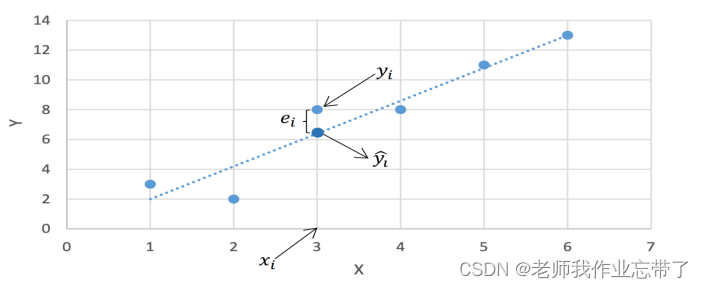

- 然而通常情况下,变量间是近似的线性关系

| x | 1 | 2 | 3 | 4 | 5 | 6 |

| y | 3 | 2 | 8 | 8 | 11 | 13 |

我们要解决的问题就是如何得到一条直线能够最好地解释数据?

拟合数据

- 假设只有一个因变量和自变量,每个训练样例表示 (𝑥𝑖 , 𝑦𝑖)

- 用

表示根据拟合直线和 x𝑖 对 𝑦𝑖 的预测值:

- 定义

为误差项/残差

这里引入了一个新的定义:误差项,它是用样本的真实值减去样本的估计值。

我们的目标就是得到一条直线使得对于所有训练样例的误差项尽可能小

线性回归的基本假设

我们假设:

- 假设自变量与因变量间存在线性关系

- 数据点之间独立

输出结果y1,y2,y3…没有关系

- 自变量之间无共线性,相互独立

对于走路累不累:如果特征是 伞 和 书包 伞和书包这两个变量没什么关系

如果是 天气 伞 书包 则 天气 和 伞 我们认为并不是相互独立的

- 残差独立、等方差、符合正态分布

error独立、等方差(面对同一个问题,也是同分布的)

根据中心极限定理:设从均值为μ、方差为σ2;(有限)的任意一个总体中抽取样本量为n的样本,当n充分大时,样本均值的抽样分布近似服从均值为μ、方差为σ2/n 的正态分布。

三、损失函数(loss function)的定义

多种损失函数都是可行的,凭直觉就可以想到:

- 所有误差项的加和

- 所有误差项绝对值的加和

考虑到优化等问题,最常用的是基于误差平方和的损失函数

• 用误差平方和作为损失函数有很多优点

• 损失函数是严格的凸函数,有唯一解

• 求解过程简单且容易计算

• 同时也伴随着一些缺点

• 结果对数据中的“离群点”(outlier)非常敏感

• 解决方法:提前检测离群点并去除

• 损失函数对于超过和低于真实值的预测是等价的

• 但有些真实情况下二者带来的影响是不同的

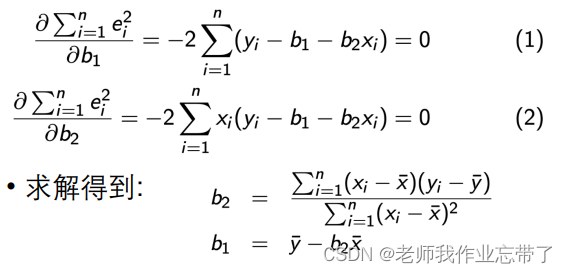

我们需要求出合适的参数b1、b2使得误差平方和最小。

最小二乘法(Least Square, LS)

为了求解最优的截距和斜率,可以转化为一个针对损失函数的 凸优化问题,称为最小二乘法:

我们分别对b1、b2求偏导:

这就是我们文章最开始回忆的线性回归方程,我们使用时当然不用去求偏导了,直接用。

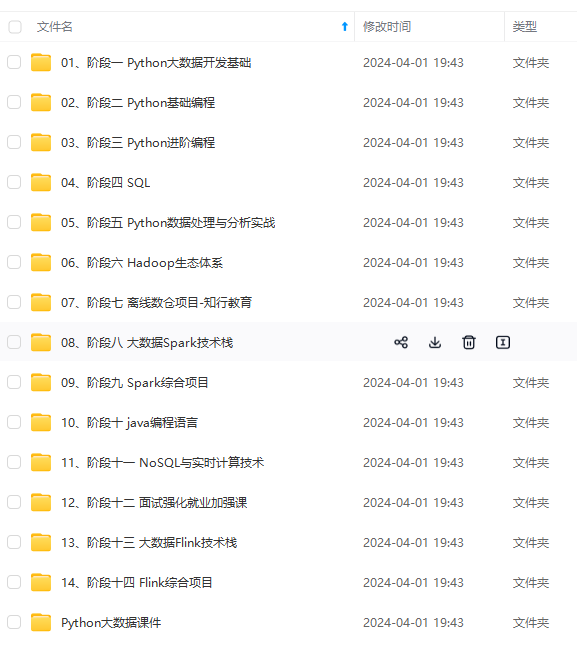

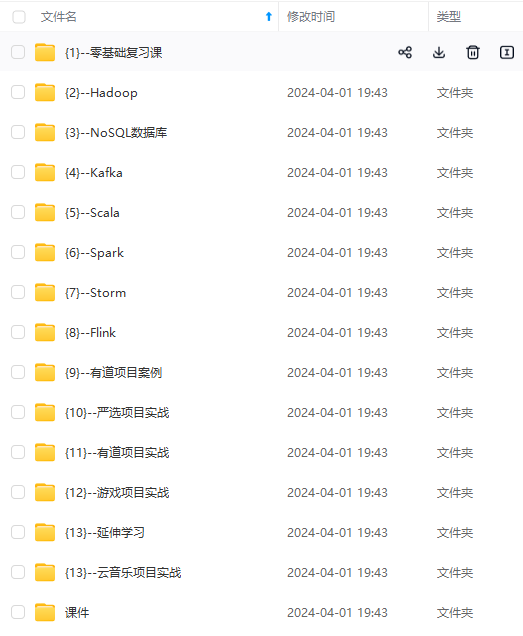

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?