SQL执行顺序:

(1)FROM

<表名> # 选取表,将多个表数据通过笛卡尔积变成一个表。

(2)ON

<筛选条件> # 对笛卡尔积的虚表进行筛选

(3)JOIN <join, left join, right join…>

<join表> # 指定join,用于添加数据到on之后的虚表中,例如left join会将左表的剩余数据添加到虚表中

(4)WHERE

<where条件> # 对上述虚表进行筛选

(5)GROUP BY

<分组条件> # 分组

(6)<SUM()等聚合函数> # 用于having子句进行判断,在书写上这类聚合函数是写在having判断里面的

(7)HAVING

<分组筛选> # 对分组后的结果进行聚合筛选

(8)SELECT

<返回数据列表> # 返回的单列必须在group by子句中,聚合函数除外

(9)DISTINCT # 数据除重

(10)ORDER BY

<排序条件> # 排序,如非必要尽量不用

(11)LIMIT

<行数限制>

SQL语句顺序:

(8) SELECT (9)DISTINCT < 去重列 >

(1) FROM < 左表 >

(3) < 连接类型 > JOIN < 右表 >

(2) ON <连接条件>

(4) WHERE < 筛选条件 >

(5) GROUP BY < 分组列 >

(6) WITH {CUBE|ROLLUP}

(7) HAVING < 分组筛选 >

(10) ORDER BY < 排序列 >

(11) LIMIT < 行数限制 >

注:这里大家注意,(4)WHERE 筛选的是连接后的新表。

通过SQL的语法顺序和执行顺序很容易就看出,这和我们一步一步一个语句实现一个效果不同。要是我们按照面向过程来编程。那肯定首先是from先拿出表格,再考虑是否根据条件连接其他表格实现多表格联合处理。但是我们写的时候不能这么写,所以会感觉比较不适。了解了原理之后我们便可真正开始进行单表操作了。

二、单表操作

1.自连接

创建

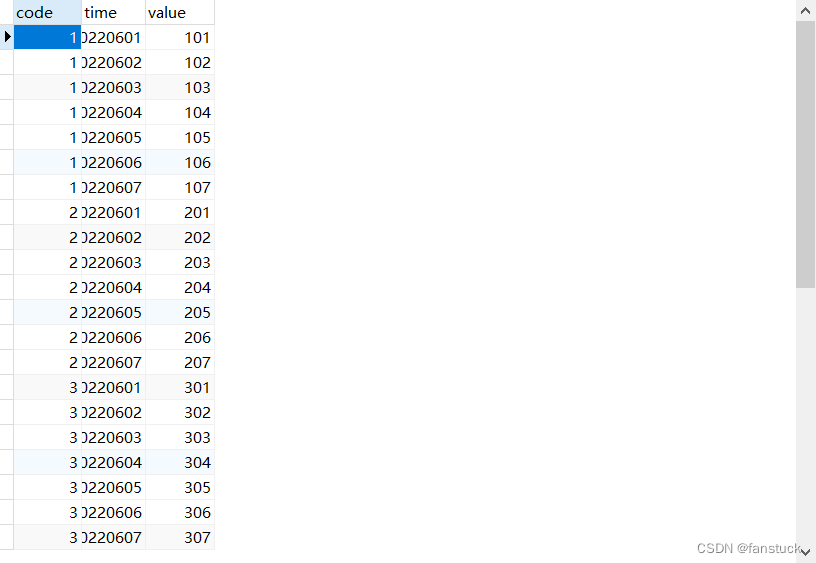

为了方便演示这里创建一张value_test:

CREATE TABLE `value_test` (

`code` int(20) NOT NULL,

`time` bigint(124) NOT NULL,

`value` bigint(124) NOT NULL,

PRIMARY KEY (`value`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb3;

插入数据:

INSERT INTO value_test(`code`,time,`value`) VALUES('1','20220601','101');

INSERT INTO value_test(`code`,time,`value`) VALUES('1','20220602','102');

INSERT INTO value_test(`code`,time,`value`) VALUES('1','20220603','103');

INSERT INTO value_test(`code`,time,`value`) VALUES('1','20220604','104');

INSERT INTO value_test(`code`,time,`value`) VALUES('1','20220605','105');

INSERT INTO value_test(`code`,time,`value`) VALUES('1','20220606','106');

INSERT INTO value_test(`code`,time,`value`) VALUES('1','20220607','107');

INSERT INTO value_test(`code`,time,`value`) VALUES('2','20220601','201');

INSERT INTO value_test(`code`,time,`value`) VALUES('2','20220602','202');

INSERT INTO value_test(`code`,time,`value`) VALUES('2','20220603','203');

INSERT INTO value_test(`code`,time,`value`) VALUES('2','20220604','204');

INSERT INTO value_test(`code`,time,`value`) VALUES('2','20220605','205');

INSERT INTO value_test(`code`,time,`value`) VALUES('2','20220606','206');

INSERT INTO value_test(`code`,time,`value`) VALUES('2','20220607','207');

INSERT INTO value_test(`code`,time,`value`) VALUES('3','20220601','301');

INSERT INTO value_test(`code`,time,`value`) VALUES('3','20220602','302');

INSERT INTO value_test(`code`,time,`value`) VALUES('3','20220603','303');

INSERT INTO value_test(`code`,time,`value`) VALUES('3','20220604','304');

INSERT INTO value_test(`code`,time,`value`) VALUES('3','20220605','305');

INSERT INTO value_test(`code`,time,`value`) VALUES('3','20220606','306');

INSERT INTO value_test(`code`,time,`value`) VALUES('3','20220607','307');

得到了这张表格:

自连接

自连接可以这么理解,我们把原始表value_test作为镜像再去生成另一张一模一样的表,也就是自身的映射,该表设定命名为其他的名字,这样以来便存在两张表可以连接作用。但是因为存在着两张表,那么我们select的字段也不能写原始表的字段,因为两张表存在着相同的字段名称会报错:

select code,time,value

from value_test as v1,value_test as v2

所以需要指定两张某一张表的字段。

select v1.code,v1.time,v1.value

from value_test as v1,value_test as v2

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

.csdn.net/topics/618545628)**

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

655

655

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?