先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

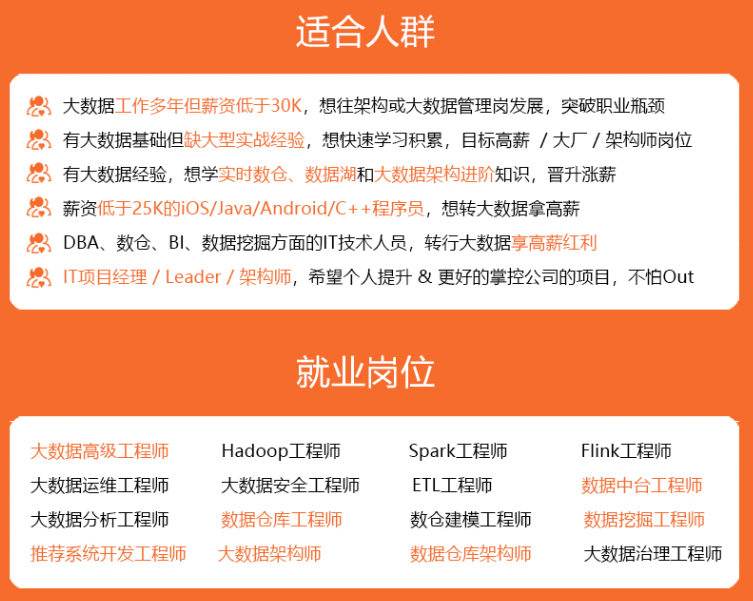

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

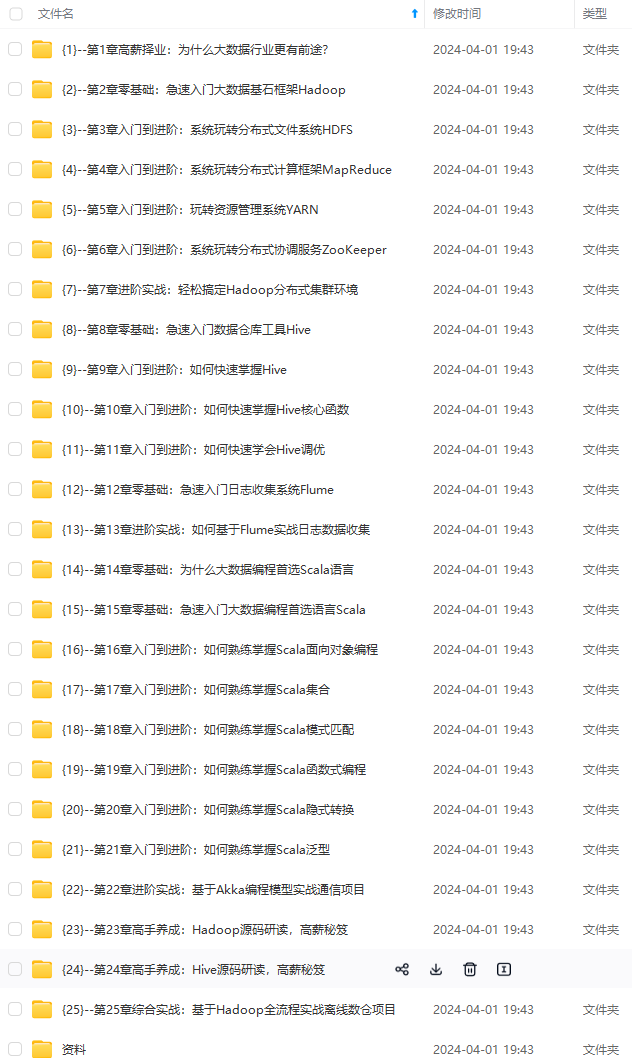

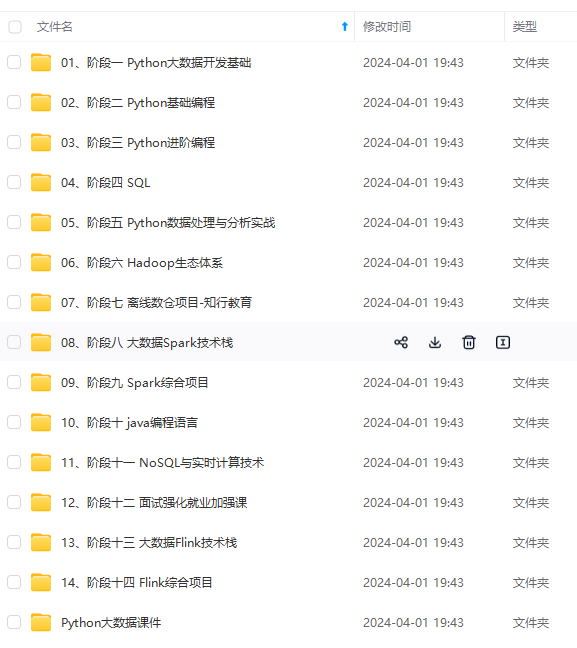

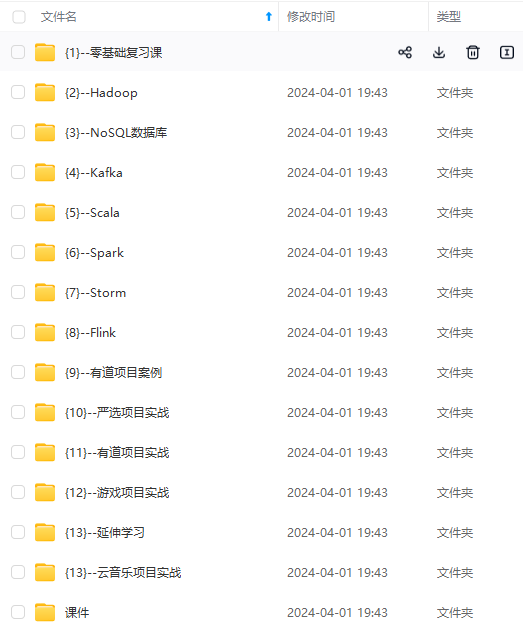

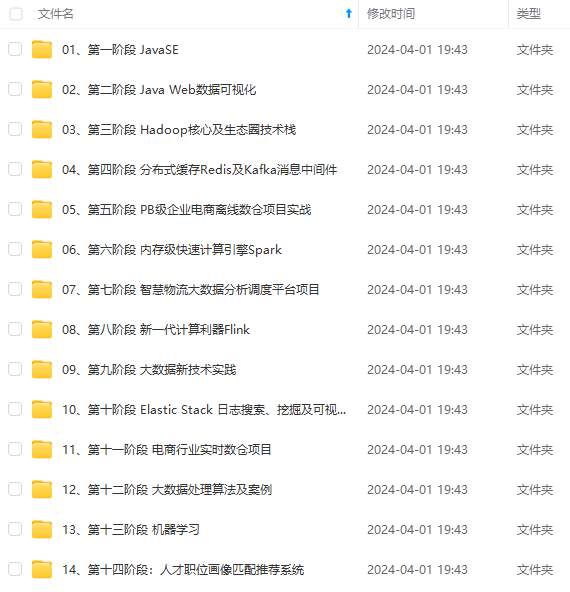

因此收集整理了一份《2024年最新大数据全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip204888 (备注大数据)

正文

)

\operatorname{Cost}(W)=-\sum_{i=1}^{N} \sum_{j=1}^{K} 1_{j}\left(y_{i}\right) \ln \left(\frac{e^{W j^{T} X_{i}}}{\sum_{k=1}^{K} e{W_{k}{T} X_{i}}}\right)

Cost(W)=−i=1∑Nj=1∑K1j(yi)ln(∑k=1KeWkTXieWjTXi)

该代价函数也是凸函数,依然可以使用梯度下降法进行最小化的优化。

三、原理证明

多分类对数几率回归的代价函数为凸函数

同前面的证明一样,只需证明当函数的黑塞矩阵是半正定的,则该函数就为凸函数。

(1)代价函数对 W 求梯度,推导时需要注意下标

(2)可以将代价函数中的第二个连加操作拆成两个式子,前面一个为连加中的第 j 个式子,后面为连加项但不包括第 j 项,这时的下标用 l 表示

(3)将除法的对数写成对数的减法

(4)第一个连加操作对求梯度不影响,直接写到最外层。指示函数对求梯度也没有影响,利用求导公式分别对后面几项求梯度

(5)整理后可以看到后面两项又可以合成同一个连加

(6)由于 y 的取值必然会在 1 - K 中,指示函数的从 1 - K 连加必然等于 1

∂

Cost

(

W

)

∂

W

j

=

∂

∂

W

j

(

−

∑

i

=

1

N

∑

j

=

1

K

1

j

(

y

i

)

ln

e

W

j

T

X

i

∑

k

=

1

K

e

W

k

T

X

i

)

(

1

)

=

∂

∂

W

j

(

−

∑

i

=

1

N

(

1

j

(

y

i

)

ln

e

W

j

T

X

i

∑

k

=

1

K

e

W

k

T

X

i

∑

l

≠

j

K

1

l

(

y

i

)

ln

e

W

l

T

X

i

∑

k

=

1

K

e

W

k

T

X

i

)

)

(

2

)

=

∂

∂

W

j

(

−

∑

i

=

1

N

(

1

j

(

y

i

)

(

W

j

T

X

i

−

ln

∑

k

=

1

K

e

W

k

T

X

i

)

∑

l

≠

j

K

1

l

(

y

i

)

(

W

l

T

X

i

−

ln

∑

k

=

1

K

e

W

k

T

X

i

)

)

)

(

3

)

=

−

∑

i

=

1

N

(

1

j

(

y

j

)

(

X

i

−

e

W

j

T

X

i

X

i

∑

k

=

1

K

e

W

k

T

X

i

)

∑

l

≠

j

K

1

l

(

y

i

)

(

0

−

e

W

j

T

X

i

X

i

∑

k

=

1

K

e

W

k

T

X

i

)

)

(

4

)

=

−

∑

i

=

1

N

(

X

i

(

1

j

(

y

i

)

−

∑

j

=

1

K

1

j

(

y

i

)

e

W

j

T

X

i

∑

k

=

1

K

e

W

k

T

X

i

)

)

(

5

)

=

−

∑

i

=

1

N

(

X

i

(

1

j

(

y

i

)

−

e

W

j

T

X

i

∑

k

=

1

K

e

W

k

T

X

i

)

)

(

6

)

\begin{aligned} \frac{\partial \operatorname{Cost}(W)}{\partial W_{j}} &=\frac{\partial}{\partial W_{j}}\left(-\sum_{i=1}^{N} \sum_{j=1}^{K} 1_{j}\left(y_{i}\right) \ln \frac{e{W_{j}{T} X_{i}}}{\sum_{k=1}^{K} e{W_{k}{T} X_{i}}}\right) & (1) \ &=\frac{\partial}{\partial W_{j}}\left(-\sum_{i=1}^{N}\left(1_{j}\left(y_{i}\right) \ln \frac{e{W_{j}{T} X_{i}}}{\sum_{k=1}^{K} e{W_{k}{T} X_{i}}}+\sum_{l \neq j}^{K} 1_{l}\left(y_{i}\right) \ln \frac{e{W_{l}{T} X_{i}}}{\sum_{k=1}^{K} e{W_{k}{T} X_{i}}}\right)\right) & (2) \ &=\frac{\partial}{\partial W_{j}}\left(-\sum_{i=1}{N}\left(1_{j}\left(y_{i}\right)\left(W_{j}{T} X_{i}-\ln \sum_{k=1}^{K} e{W_{k}{T} X_{i}}\right)+\sum_{l \neq j}^{K} 1_{l}\left(y_{i}\right)\left(W_{l}^{T} X_{i}-\ln \sum_{k=1}^{K} e{W_{k}{T} X_{i}}\right)\right)\right) & (3) \ &=-\sum_{i=1}{N}\left(1_{j}\left(y_{j}\right)\left(X_{i}-\frac{e{W_{j}^{T} X_{i}} X_{i}}{\sum_{k=1}^{K} e{W_{k}{T} X_{i}}}\right)+\sum_{l \neq j}^{K} 1_{l}\left(y_{i}\right)\left(0-\frac{e{W_{j}{T} X_{i}} X_{i}}{\sum_{k=1}^{K} e{W_{k}{T} X_{i}}}\right)\right) & (4) \ &=-\sum_{i=1}{N}\left(X_{i}\left(1_{j}\left(y_{i}\right)-\sum_{j=1}{K} 1_{j}\left(y_{i}\right) \frac{e{W_{j}{T} X_{i}}}{\sum_{k=1}^{K} e{W_{k}{T} X_{i}}}\right)\right) & (5) \ &=-\sum_{i=1}{N}\left(X_{i}\left(1_{j}\left(y_{i}\right)-\frac{e{W_{j}^{T} X_{i}}}{\sum_{k=1}^{K} e{W_{k}{T} X_{i}}}\right)\right) & (6) \end{aligned}

∂Wj∂Cost(W)=∂Wj∂(−i=1∑Nj=1∑K1j(yi)ln∑k=1KeWkTXieWjTXi)=∂Wj∂⎝⎛−i=1∑N⎝⎛1j(yi)ln∑k=1KeWkTXieWjTXi+l=j∑K1l(yi)ln∑k=1KeWkTXieWlTXi⎠⎞⎠⎞=∂Wj∂⎝⎛−i=1∑N⎝⎛1j(yi)(WjTXi−lnk=1∑KeWkTXi)+l=j∑K1l(yi)(WlTXi−lnk=1∑KeWkTXi)⎠⎞⎠⎞=−i=1∑N⎝⎛1j(yj)(Xi−∑k=1KeWkTXieWjTXiXi)+l=j∑K1l(yi)(0−∑k=1KeWkTXieWjTXiXi)⎠⎞=−i=1∑N(Xi(1j(yi)−j=1∑K1j(yi)∑k=1KeWkTXieWjTXi))=−i=1∑N(Xi(1j(yi)−∑k=1KeWkTXieWjTXi))(1)(2)(3)(4)(5)(6)

(1)代价函数对 W 求黑塞矩阵

(2)第一项对 W 来说为常数,只需对第二项求导

(3)利用求导公式求出对应的导数

(4)整理结果,分子为连加中去掉第 j 项

∂

2

Cost

(

W

)

∂

W

j

∂

W

j

T

=

∂

∂

W

j

(

−

∑

i

=

1

N

(

X

i

(

1

j

(

y

i

)

−

e

W

j

T

X

i

∑

k

=

1

K

e

W

k

T

X

i

)

)

)

(

1

)

=

∑

i

=

1

N

∂

∂

W

j

(

e

W

j

T

X

i

∑

k

=

1

K

e

W

k

T

X

i

X

i

)

(

2

)

=

∑

i

=

1

N

∑

k

=

1

K

e

W

k

T

X

i

e

W

j

T

X

i

X

i

−

e

W

j

T

X

i

e

W

j

T

X

i

X

i

(

∑

k

=

1

K

e

W

k

T

X

i

)

2

X

i

(

3

)

=

∑

i

=

1

N

∑

k

≠

j

K

e

W

k

T

X

i

e

W

j

T

X

i

(

∑

k

=

1

K

e

W

k

T

X

i

)

2

X

i

X

i

T

(

4

)

\begin{aligned} \frac{\partial^{2} \operatorname{Cost}(W)}{\partial W_{j} \partial W_{j}^{T}} &=\frac{\partial}{\partial W_{j}}\left(-\sum_{i=1}{N}\left(X_{i}\left(1_{j}\left(y_{i}\right)-\frac{e{W_{j}^{T} X_{i}}}{\sum_{k=1}^{K} e{W_{k}{T} X_{i}}}\right)\right)\right) & (1)\ &=\sum_{i=1}^{N} \frac{\partial}{\partial W_{j}}\left(\frac{e{W_{j}{T} X_{i}}}{\sum_{k=1}^{K} e{W_{k}{T} X_{i}}} X_{i}\right) & (2)\ &=\sum_{i=1}^{N} \frac{\sum_{k=1}^{K} e{W_{k}{T} X_{i}} e{W_{j}{T} X_{i}} X_{i}-e{W_{j}{T} X_{i}} e{W_{j}{T} X_{i}} X_{i}}{\left(\sum_{k=1}^{K} e{W_{k}{T} X_{i}}\right)^{2}} X_{i} & (3)\ &=\sum_{i=1}^{N} \frac{\sum_{k \neq j}^{K} e{W_{k}{T} X_{i}} e{W_{j}{T} X_{i}}}{\left(\sum_{k=1}^{K} e{W_{k}{T} X_{i}}\right)^{2}} X_{i} X_{i}^{T} & (4) \end{aligned}

∂Wj∂WjT∂2Cost(W)=∂Wj∂(−i=1∑N(Xi(1j(yi)−∑k=1KeWkTXieWjTXi)))=i=1∑N∂Wj∂(∑k=1KeWkTXieWjTXiXi)=i=1∑N(∑k=1KeWkTXi)2∑k=1KeWkTXieWjTXiXi−eWjTXieWjTXiXiXi=i=1∑N(∑k=1KeWkTXi)2∑k=jKeWkTXieWjTXiXiXiT(1)(2)(3)(4)

同前面的证明,黑塞矩阵前面的常数必然大于零,则对应的黑塞矩阵矩阵为正定矩阵,说明其代价函数为凸函数,证毕。

对数几率回归是多分类对数几率回归的特例

(1)当 K 的值为 2 时,带入到多分类对数几率回归的假设函数

(2)将分子分母同时乘以 e 的

−

W

1

-W_1

−W1 次幂

(3)e 的零次幂为 1,化简可得

(4)将

W

2

−

W

1

W_2-W_1

W2−W1 视为新的 w,这时会发现假设函数就为二分类的对数几率回归的假设函数

h

(

x

)

=

1

e

W

1

T

x

e

W

2

T

x

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注大数据)

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

∑

i

=

1

N

∑

k

≠

j

K

e

W

k

T

X

i

e

W

j

T

X

i

(

∑

k

=

1

K

e

W

k

T

X

i

)

2

X

i

X

i

T

(

4

)

\begin{aligned} \frac{\partial^{2} \operatorname{Cost}(W)}{\partial W_{j} \partial W_{j}^{T}} &=\frac{\partial}{\partial W_{j}}\left(-\sum_{i=1}{N}\left(X_{i}\left(1_{j}\left(y_{i}\right)-\frac{e{W_{j}^{T} X_{i}}}{\sum_{k=1}^{K} e{W_{k}{T} X_{i}}}\right)\right)\right) & (1)\ &=\sum_{i=1}^{N} \frac{\partial}{\partial W_{j}}\left(\frac{e{W_{j}{T} X_{i}}}{\sum_{k=1}^{K} e{W_{k}{T} X_{i}}} X_{i}\right) & (2)\ &=\sum_{i=1}^{N} \frac{\sum_{k=1}^{K} e{W_{k}{T} X_{i}} e{W_{j}{T} X_{i}} X_{i}-e{W_{j}{T} X_{i}} e{W_{j}{T} X_{i}} X_{i}}{\left(\sum_{k=1}^{K} e{W_{k}{T} X_{i}}\right)^{2}} X_{i} & (3)\ &=\sum_{i=1}^{N} \frac{\sum_{k \neq j}^{K} e{W_{k}{T} X_{i}} e{W_{j}{T} X_{i}}}{\left(\sum_{k=1}^{K} e{W_{k}{T} X_{i}}\right)^{2}} X_{i} X_{i}^{T} & (4) \end{aligned}

∂Wj∂WjT∂2Cost(W)=∂Wj∂(−i=1∑N(Xi(1j(yi)−∑k=1KeWkTXieWjTXi)))=i=1∑N∂Wj∂(∑k=1KeWkTXieWjTXiXi)=i=1∑N(∑k=1KeWkTXi)2∑k=1KeWkTXieWjTXiXi−eWjTXieWjTXiXiXi=i=1∑N(∑k=1KeWkTXi)2∑k=jKeWkTXieWjTXiXiXiT(1)(2)(3)(4)

同前面的证明,黑塞矩阵前面的常数必然大于零,则对应的黑塞矩阵矩阵为正定矩阵,说明其代价函数为凸函数,证毕。

对数几率回归是多分类对数几率回归的特例

(1)当 K 的值为 2 时,带入到多分类对数几率回归的假设函数

(2)将分子分母同时乘以 e 的

−

W

1

-W_1

−W1 次幂

(3)e 的零次幂为 1,化简可得

(4)将

W

2

−

W

1

W_2-W_1

W2−W1 视为新的 w,这时会发现假设函数就为二分类的对数几率回归的假设函数

h

(

x

)

=

1

e

W

1

T

x

e

W

2

T

x

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注大数据)

[外链图片转存中…(img-8WmqHEys-1713412021877)]

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

1010

1010

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?