hdfs://bigdata2021master:9000

- 输入:vi hadoop-env.sh 修改文件,找到文件中的以下内容(红框的内容是文件中的原文内容,后部分要自己根据存储的jdk、hadoop文件路径进行修改),并修改成以下内容:

- 输入:vi hdfs-site.xml 修改文件,在文件中的和添加以下内容:

dfs.name.dir

/root/hadoop/dfs/name

Path on the local filesystem where theNameNode stores the namespace and transactions logs persistently.

dfs.data.dir

/root/hadoop/dfs/data

Comma separated list of paths on the localfilesystem of a DataNode where it should store its blocks.

dfs.replication

2 #表示副节点的个数

dfs.permissions

false

need not permissions

- 输入:mapred-site.xml 修改文件,在文件中的和添加以下内容(注:黄色部分要改成自己的主机名)

mapred.job.tracker

bigdata2021master:49001

mapred.local.dir

/root/hadoop/var

mapreduce.framework.name

yarn

- 输入:yarn-site.xml 修改文件, 在文件中的和添加以下内容(注:黄色部分要改成自己的主机名)

yarn.resourcemanager.hostname

bigdata2021master

The address of the applications manager interface in the RM.

yarn.resourcemanager.address

${yarn.resourcemanager.hostname}:8032

The address of the scheduler interface.

yarn.resourcemanager.scheduler.address

${yarn.resourcemanager.hostname}:8030

The http address of the RM web application.

yarn.resourcemanager.webapp.address

${yarn.resourcemanager.hostname}:8088

The https adddress of the RM web application.

yarn.resourcemanager.webapp.https.address

${yarn.resourcemanager.hostname}:8090

yarn.resourcemanager.resource-tracker.address

${yarn.resourcemanager.hostname}:8031

The address of the RM admin interface.

yarn.resourcemanager.admin.address

${yarn.resourcemanager.hostname}:8033

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.scheduler.maximum-allocation-mb

2048

每个节点可用内存,单位MB,默认8182MB

yarn.nodemanager.vmem-pmem-ratio

2.1

yarn.nodemanager.resource.memory-mb

2048

yarn.nodemanager.vmem-check-enabled

false

- 输入:vi workers 修改文件配置,在该文件中,加上三个机器的用户名:

四、克隆两个子节点

1、克隆虚拟机

(1)选择对应左侧虚拟机的名称,右击选择管理–>克隆;

(2)接下来直接选择默认选项即可,但注意其中一步必须选择如下图的选项。

2、修改子节点机器的相关配置

因为克隆机器后的两个子节点和主机点的信息完全一致,因此要把两个子节点的用户名、ip地址根据之前修改的hosts文件改掉,方法和前面一致。

♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣

特别说明:有的时候需要用scp命令将主机上的hadoop文件传输到副机上去,这里可以先新建两个虚拟机并且和前面一样配置好相关信息,再在终端中输入:scp -r 源hadoop文件路径 机器用户名:目标路径位置后,即可传输,比较麻烦,建议没有要求的情况下使用克隆虚拟机的方法。

♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣♣

五、设置免密登录(三个节点都需要进行此操作)

1、关闭防火墙和禁止启动防火墙

(1)关闭防火墙,终端中输入:systemctl stop firewalld.service

(2)关闭开机时自动开启防火墙 :systemctl disable firewalld.service

2、生成密钥

在终端中输入:ssh-keygen -t rsa ,一直按回车键即可

3、分配密钥

(1)在终端中输入以下指令(中途根据提示输入yes、密码):

ssh-copy-id bigdata2021master

ssh-copy-id bigdata2021slave1

ssh-copy-id bigdata2021slave2

(2)验证是否能够免密成功登录,终端输入:ssh 机器名称,若能够成功登录其他机器则免密登陆设置成功

六、启动hadoop集群

1、格式化hadoop集群

(1)切换到 下载的hadoop文件中的 bin 目录下

(2)格式化hadoop集群,在终端中输入:./hadoop namenode -format ,若在 /root/hadoop/dfs/name中出现一个current目录并有一些列文件,即表示格式化成功,注意不要多次格式化会出错。

(3)修改下列启动和停止集群的配置文件(在主节点修改即可)

- 切换到下载的hadoop文件下的 /sbin目录下修改文件

- 在start-dfs.sh、stop-dfs.sh 中开头中加上内容(用vi命令操作):

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=root

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

- 在start-yarn.sh、stop-yarn.sh中开头加上以下内容(用vi命令操作):

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=root

YARN_NODEMANAGER_USER=root

2、启动hadoop集群 (在主节点启动)

(1)在终端输入:start-all.sh;

(2)三个节点分别输入jps查看进程(注意都要切换到管理员权限,并切换到hadoop文件下的bin目录下),出现下列结果(关键是看主机点的进程中是否有NameNode进程、子结点中是否有DataNode进程),则表明搭建集群成功;(注:必须都为管理员权限下进入hadoop目录下的bin路径下才能查看到启动的进程)

- 主节点:

- 子节点1:

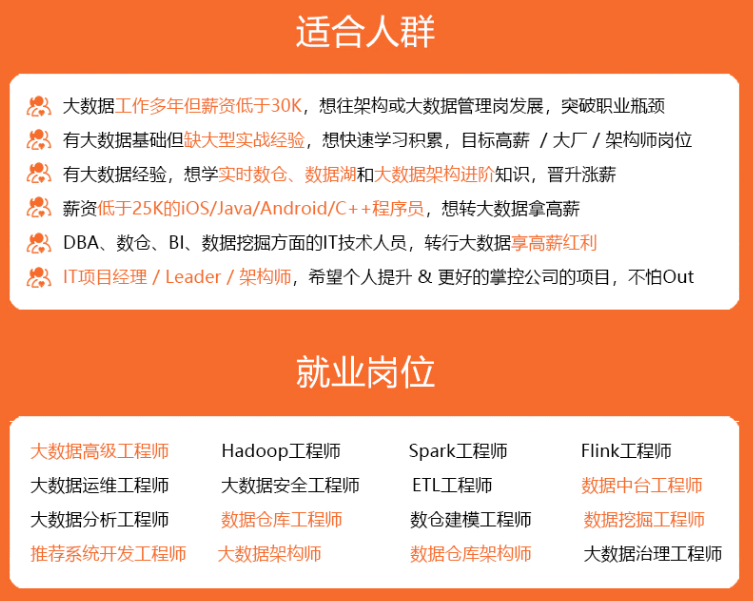

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

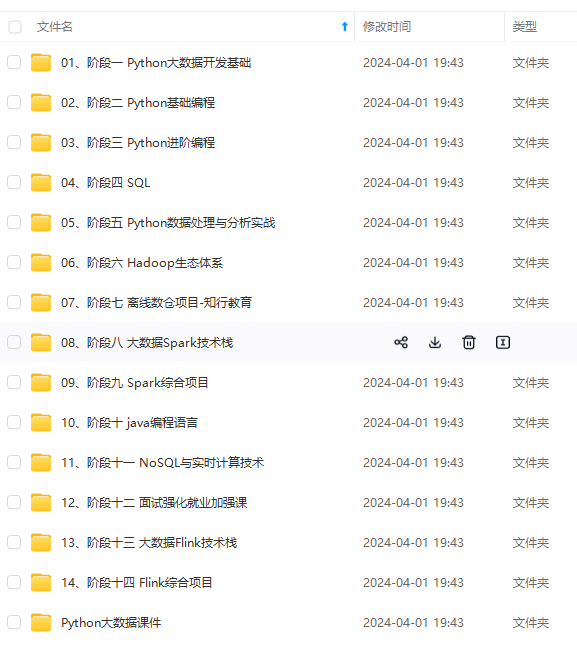

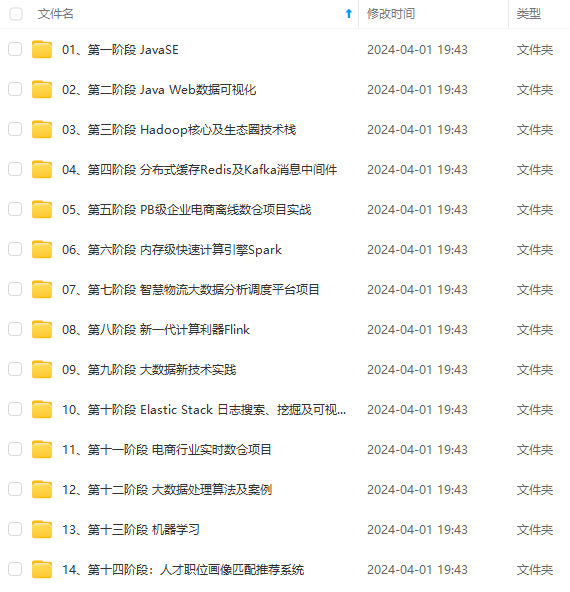

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

dnimg.cn/5afa3e6a3f0b459880e0c05714457880.png)

- 子节点1:

[外链图片转存中…(img-o7TpG6iz-1714762239036)]

[外链图片转存中…(img-YAqdnBcM-1714762239036)]

[外链图片转存中…(img-PaGONvPq-1714762239036)]

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

510

510

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?