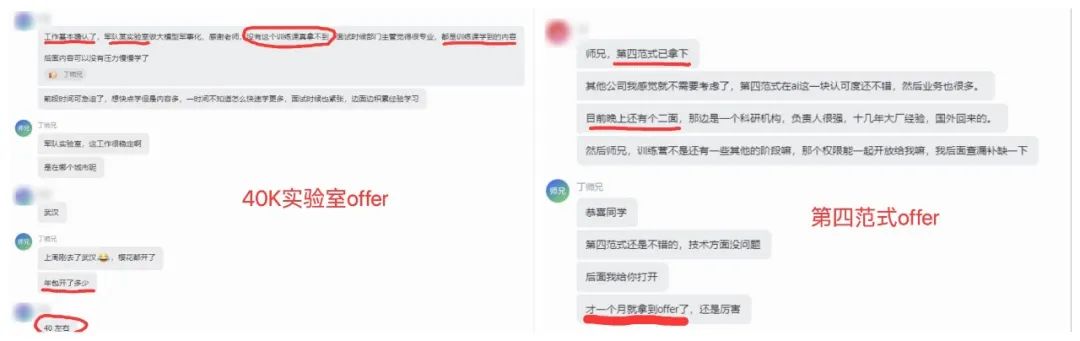

金三银四春招季,又有两位训练营同学斩获大模型offer!一个是40k某军实验室offer,另一个是第四范式~恭喜两位同学成功上岸!

随着DeepSeek爆火,面试中也越来越高频出现,因此训练营也更新了DeepSeek系列技术的深入拆解。包括MLA、MTP、专家负载均衡、FP8混合精度训练,Dual-Pipe等关键技术,力求做到全网最硬核的解析~

DeepSeek 对 MoE 架构做了哪些改进?跟 Mixtral 的 MoE 有什么不同?这个是我的学员最近面试某个大模型独角兽遇到的一道面试题。

01

面试官心理分析

这篇文章,我们就从面试官的角度来分析一下,如果你在面试现场被问到这个题目,应该如何作答?

面试官问这个问题,它其实是想考你什么?

-

第一,Mixtral 大模型采用的 MoE 架构长什么样?

-

第二,就是 DeepSeek 的 MoE 做了哪些改进,这样改进的动机是什么?

02

面试题解析

要回答 DeepSeek 的 MoE 改进,我们先来看看,最原始的 MoE 网络长什么样子?以及它是怎么工作的?

这张图是 Mixtral 8x7B 的 MoE 架构:

其核心思想很直观,它实际上用了 8 个7B的“专家”模型,当 MoE 与Transformer 相结合时,会用稀疏 MoE 层替换掉某些前馈层。

MoE 层包含了一个路由网络,用于选择将输入 token 分派给哪些专家处理,Mixtral 模型为每个词元选择 top-K 个专家,那在图中是选择两个。

因为每次只激活部分的专家,所以其解码速度能做到与 14B 模型相当,也就极大的提高了模型的推理效率。

好,了解了最原始的 MoE 架构,我们再来看看,DeepSeek 是怎么改进的?

看这张图,其实 DeepSeek 的主要改动点,就是把专家分成了两拨,分别是 Shared Expert 和 Routed Expert。

通俗来讲,就好比学校的常驻教授和客座教授,常驻教授是一直在的,而客座教授则经常会变,不同的教学主题,有不同的客座教授。

在 DeepSeek 的 MoE 中,Shared Expert 是一直激活的,也就是输入的 token 会被 Shared Expert 计算,Routed Expert 和普通的 MoE 一样,要先计算相似度,也就是专家的得分,再选择 top-k 进行推理。

但是我们分析 DeepSeek 的源码可以发现,代码实际在计算 top-k 时,会先将 N 个 Expert 进行分组 n_groups,将每个组中 top-2 个专家的相似度得分加起来,算出得分最高的那些 top_k_group 组,然后在这些组里选择 top-k 个专家。

最后将所有的 Shared Expert 输出和 Routed Expert 输出做加权相加,得到 MoE 层的最终输出。

这里 Deepseek-v3 和 Deepseek-R1 采用了 256 个 Routed Expert 和 1个 Shared Expert,并在 Router 中选出 8 个来,参数量是 671B,而实际激活的参数量只有 37B。

好,现在我们答出了 DeepSeek 对 MoE 架构的改进点,面试官可能会继续追问:那它为什么要这样改进呢?这样改进有什么好处?

实际上这种设计主要是基于以下两点考虑:

第一,原始的 MoE 会产生较多的冗余,一个想法就是抽取一个 Shared Expert 出来处理通用知识,其他的 Routed Expert 来处理差异性的知识。

通过隔离 Shared Expert,以减轻 Routed Expert 所需要学习的知识量,从而减少路由专家之间的冗余。

第二个考虑是高效计算的层面,MoE 模型在训练的时候,会花费大量的时候来做通讯,因为 expert 会分散到不同的设备上,从而降低巨大的总参数量带来的显存消耗。

一种解决思路是:在通讯流处在工作状态的时候,同时用计算流进行后续的运算,从而隐藏掉部分通讯时间。

Shared Expert 的计算与 Routed Expert 通讯是不依赖的,因此可以使用通讯隐藏,从而比普通的 MoE 结构计算更高效。

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集***

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?