今天,英伟达、南京大学、香港理工大学、罗格斯大学团队合作推出一项最新成果:Eagle 2.5,简单来说这是一种用于长上下文多模态学习的视觉语言模型(VLM),为现有VLM打破局限性提供了一个创新解决方案。

为了应对行业中长视频理解和高分辨率图像理解方面的挑战,英伟达团队引入了适用于这两项任务的一种通用框架,该框架还在长上下文数据训练的流程中纳入了多项效率优化措施。

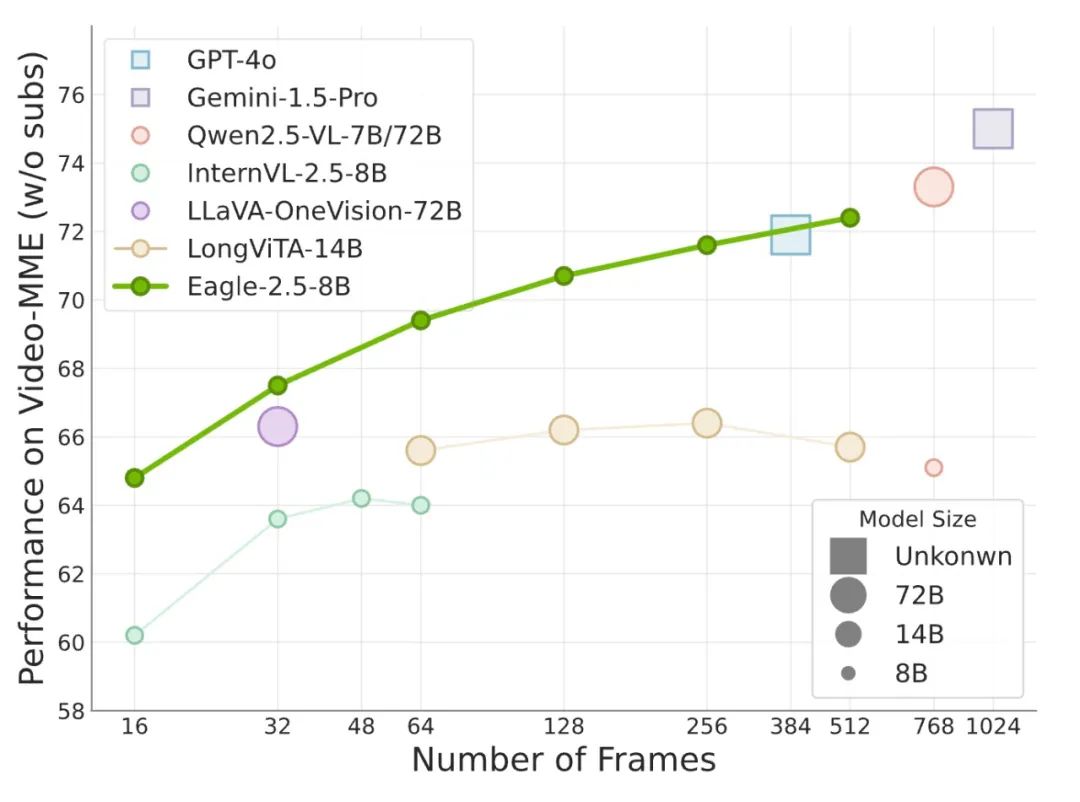

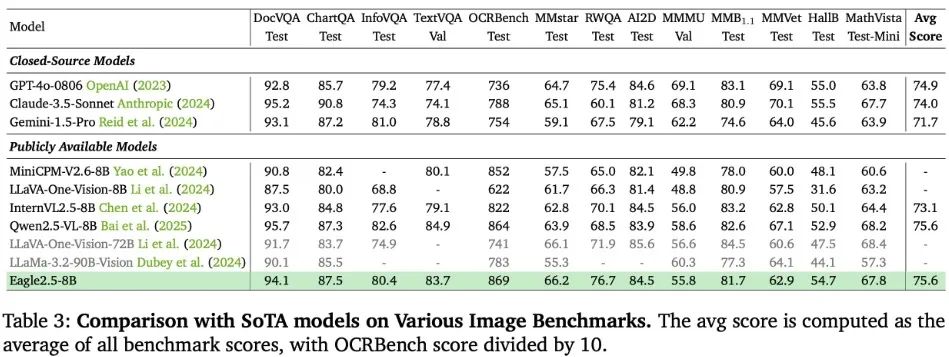

从测试结果来看,Eagle 2.5在长上下文多模态基准测试中展现了显著的性能,测试版本Eagle 2.5-8B在512个输入帧的Video-MME上实现了72.4%的成绩,与GPT-4o等顶级商业模型媲美,现已在开源社区上线。

3点创新提升性能战绩

关于Eagle 2.5,英伟达团队总结了三点关键创新:

1、信息优先采样。图像区域保留(IAP):优化图像平铺以保留大部分原始图像区域和纵横比,保留细粒度的细节;自动降级采样(ADS):动态平衡视觉和文本输入,确保完整的文本保留,同时在上下文长度限制内最大化视觉内容。

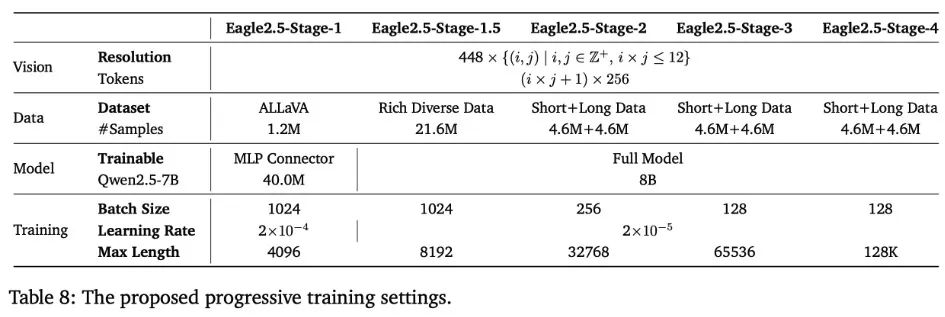

2、渐进式混合后训练:在训练期间逐渐增加上下文长度,增强模型处理不同输入大小的能力,并提高静态采样的信息密度。

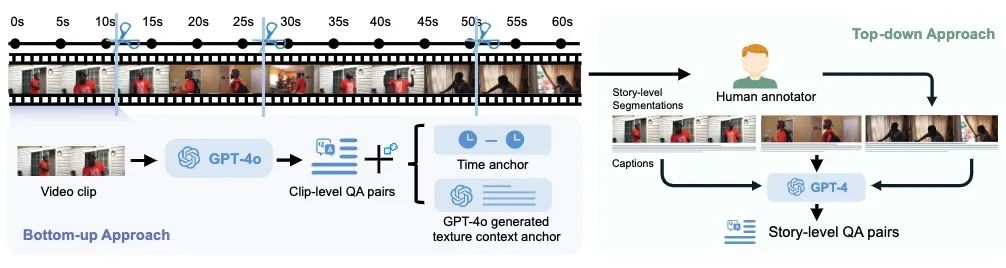

3、多样性驱动的数据配方:将开源数据(人工注释和合成)与自行策划的Eagle-Video-110K数据集相结合,该数据集通过多样性驱动策略收集,使用故事级和剪辑级QA对进行注释。

在Video-MME 基准测试中,Eagle 2.5与领先的视觉语言模型GPT-4o、Qwen2.5-VL-72B和InternVL2.5-78B等进行了性能对比,结果显示,随着输入帧数的增加,Eagle 2.5展现出了持续的性能提升和竞争力水准,而且参数规模也小得多。

目前,业内开发者们在多模态学习领域已经取得了重大进展,但许多视觉语言模型(VLM)仍然专注于短上下文任务,对长上下文理解的探索还不够深入,对扩展视觉上下文的处理仍然是一个有待解决的挑战,这种扩展上下文涵盖了多幅图像、较长的视频序列、高分辨率媒体,或者是它们的组合。

虽然这些方法有效地避免了扩展视觉语言模型上下文长度的需求,但常常会增加额外的计算开销或能力限制,可能会制约模型的性能。

与那些仅仅为了处理长多模态序列而进行优化却未提升性能的模型不同,Eagle 2.5受益于更长的输入长度,除了能够处理更长的输入之外,还能带来持续的性能提升。

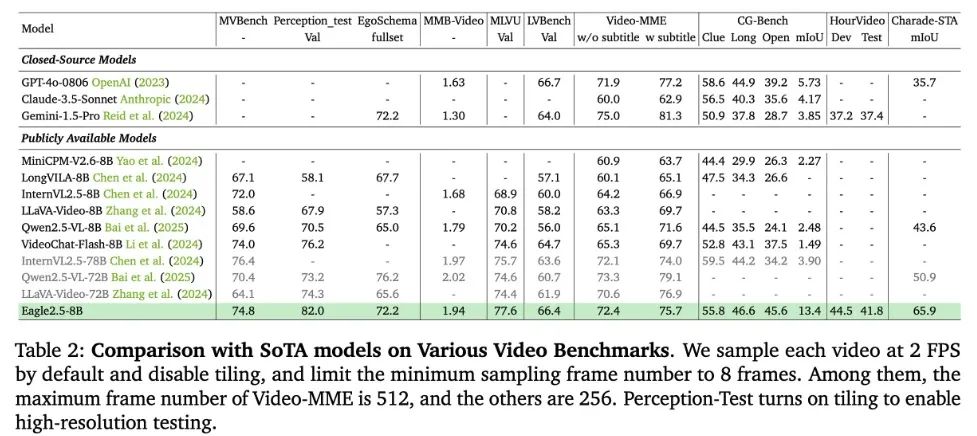

Eagle2.5-8B在多个视频基准测试中展现出卓越的性能,在MVBench上达到74.8分,在Perception_test上达到82.0分,在EgoSchema上达到72.2分,超越了InternVL2.5-8B(72.0)分和Qwen2.5-VL-8B(69.6分、70.5分、65.0分)等类似规模的模型。

此外,它在长视频理解方面尤其出色,在MLVU上达到77.6分,在 LongVideobench上达到66.4分,甚至超越了InternVL2.5-78B(75.7分、63.6分),在VideoMME(无字幕)测试中,Eagle 2.5达到了72.4分,非常接近72B参数规模的模型。

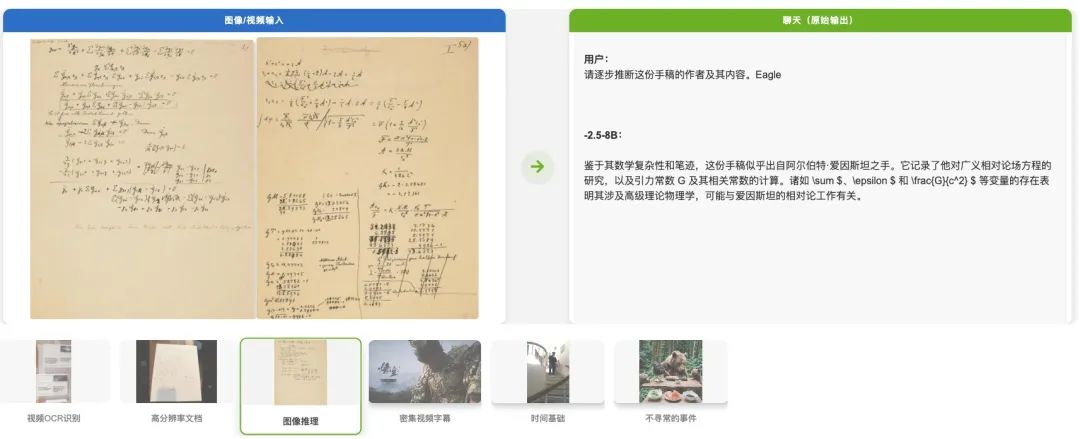

同时,Eagle2.5-8B也展现出全面的图像理解能力,涵盖文档理解(DocVQA 94.1,ChartQA 87.5)、信息提取(InfoVQA 80.4,TextVQA 83.7)和光学字符识别(OCRBench 869),该模型在一般感知和推理任务、领域特定知识、视觉幻觉评估以及数学推理方面也展现出均衡的能力。

具体的训练方法一览

研究人员表示,在整理训练数据集时采用了“先求多样,再求质量”的原则,数据集用了双重标注方法,包括:

1、自上而下的故事层面标注方法。这种方法利用人工标注的章节作为有意义的片段,而非传统的镜头层面分割方式。它会生成密集的字幕,这些字幕构成了全面的长篇问答对的基础,能够捕捉到整个视频的叙事结构;

2、自下而上的互补式片段层面标注方法。该方法使用GPT-4o针对短视频片段生成聚焦的问答对,且问题类型丰富多样。为了应对将局部片段标注扩展到完整长度视频标注的挑战,他们设置了锚点,这些锚点纳入了时间参考信息和上下文元素,同时不会透露答案,从而使模型既能理解视频的总体叙事内容,又能理解视频中精确的时空细节。

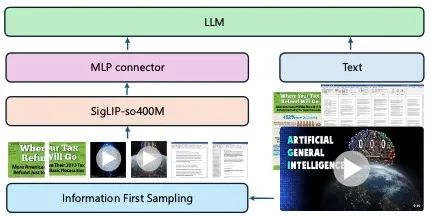

在模型架构方面,研究人员创建了一个功能多样的多模态系统,它能够高效地处理长上下文信息,而不是一个仅仅为处理扩展的多模态输入而专门优化的模型,为了确保该模型在各种不同任务中都具有适应性和泛化能力,他们特意避免加入那些可能会限制模型灵活性的定制压缩模块。

遵循LLaVA的架构,英伟达团队采用一个多层感知机(MLP)投影层,将来自SigLIP的视觉嵌入与大型语言模型(LLM)的表示空间对齐,为了有效地处理任意分辨率的图像,他们采用了图像分块策略,这一策略受到了业内模型LLaVA-1.5和InternVL的启发。

关于训练策略,包含两个实现有效长上下文训练的关键要素:其一,是一种信息优先的采样策略,它确立了最优的采样标准;其二,是基于这一策略制定的渐进式训练计划,该计划指导着整个模型的训练过程。

此外,还有一个全面的后训练框架,由两种互补的策略组成:

混合后训练:ADS方法自适应地将每个训练样本调整到最大序列长度,从而提供与帧无关的训练范式。研究人员实施了一种长度平衡打包的混合训练策略,以在整个上下文长度范围内均匀地优化性能。

渐进式混合后训练:对于最大序列长度值较大的场景,他们提出了一种渐进式混合训练方法,该方法逐渐将模型暴露于越来越大的序列长度,系统地增强其处理扩展上下文的能力。

创新改进的数据集

关于全新的数据集Eagle-Video-110K,主要解决了行业现有数据集中视频长度不足的问题。

Eagle-Video-110K通过从Vidchapters、MiraData、InternVid-10M、Panda-70M、Vript、Shot2story、ViTT和WebVid-10M等多个来源精选出多样化的长视频,解决了这一限制,采用基于CLIP嵌入和相似度阈值的多样性驱动策略,识别并筛选出能够显著延长训练和评估平均时长的新颖视频。

Eagle-Video-110K显著提升了模型在主流长视频和短视频基准测试中的表现,它通过为训练数据提供此前开源训练集中缺失的长视频,显著提升了模型处理高帧数(≥128帧)的能力。

研究人员表示,凭借先进的训练策略和多样化的数据,Eagle 2.5和Eagle-Video-110K有望为未来行业创新突破奠定基础,为在复杂的现实场景中开发高效且功能多样的视觉语言模型铺平了道路。

如何学习AI大模型?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?