…

def call(self, inputs):

…

return output

build()将输入张量的形状作为参数,我们将使用此信息来确保创建正确形状的变量。构建图层时,此函数仅运行一次。我们可以通过声明不可训练的变量或常量来创建掩码,以使TensorFlow知道它不需要梯度来反向传播:

def build(self, input_shape):

self.w = self.add_weight(shape=[self.kernel,

self.kernel,

input_shape[-1],

self.filters],

initializer=‘glorot_normal’,

trainable=True)

self.b = self.add_weight(shape=(self.filters,),

initializer=‘zeros’,

trainable=True)

mask = np.ones(self.kernel**2, dtype=np.float32)

center = len(mask)//2

mask[center+1:] = 0

if self.mask_type == ‘A’:

mask[center] = 0

mask = mask.reshape((self.kernel, self.kernel, 1, 1))

self.mask = tf.constant(mask, dtype=‘float32’)

call()用来执行前向传递。在掩膜卷积层中,在使用低级tf.nn API执行卷积之前,我们将权重乘以掩码后将下半部分的值设为零:

def call(self, inputs):

masked_w = tf.math.multiply(self.w, self.mask)

output=tf.nn.conv2d(inputs, masked_w, 1, “SAME”) + self.b

return output

网络架构

PixelCNN架构非常简单。在使用A型掩膜的第一个7 x 7 conv2d图层之后,有几层带有B型掩膜的残差块:

Model: “PixelCnn”

Layer (type) Output Shape Param #

=================================================================

input_2 (InputLayer) [(None, 28, 28, 1)] 0

masked_conv2d_22 (MaskedConv (None, 28, 28, 128) 6400

residual_block_7 (ResidualBl (None, 28, 28, 128) 53504

residual_block_8 (ResidualBl (None, 28, 28, 128) 53504

residual_block_9 (ResidualBl (None, 28, 28, 128) 53504

residual_block_10 (ResidualB (None, 28, 28, 128) 53504

residual_block_11 (ResidualB (None, 28, 28, 128) 53504

residual_block_12 (ResidualB (None, 28, 28, 128) 53504

residual_block_13 (ResidualB (None, 28, 28, 128) 53504

conv2d_2 (Conv2D) (None, 28, 28, 64) 8256

conv2d_3 (Conv2D) (None, 28, 28, 1) 65

=================================================================

Total params: 389,249

Trainable params: 389,249

Non-trainable params: 0

下图说明了PixelCNN中使用的残差块架构:

交叉熵损失

交叉熵损失也称为对数损失,它衡量模型的性能,其中输出的概率在0到1之间。以下是二进制交叉熵损失的方程,其中只有两个类,标签y可以是0或1, p ( x ) p(x) p(x)是模型的预测:

B C E = − 1 N ∑ i = 1 N ( y i l o g p ( x ) + ( 1 − y i ) l o g ( 1 − p ( x ) ) ) BCE = -\frac1N\sum_{i=1}^N(y_ilogp(x)+(1-y_i)log(1-p(x))) BCE=−N1i=1∑N(yilogp(x)+(1−yi)log(1−p(x)))

在PixelCNN中,单个图像像素用作标签。在二值化MNIST中,我们要预测输出像素是0还是1,这使其成为使用交叉熵作为损失函数的分类问题。

最后,编译和训练神经网络,我们对损失和度量均使用二进制交叉熵,并使用RMSprop作为优化器。有许多不同的优化器可供使用,它们的主要区别在于它们根据过去的统计信息调整学习率的方式。没有一种最佳的优化器可以在所有情况下使用,因此建议尝试使用不同的优化器。

编译和训练pixelcnn模型:

pixelcnn = SimplePixelCnn()

pixelcnn.compile(

loss = tf.keras.losses.BinaryCrossentropy(),

optimizer=tf.keras.optimizers.RMSprop(learning_rate=0.001),

metrics=[ tf.keras.metrics.BinaryCrossentropy()])

pixelcnn.fit(ds_train, epochs = 10, validation_data=ds_test)

接下来,我们将根据先前的模型生成一个新图像。

采样生成图片

训练后,我们可以通过以下步骤使用该模型生成新图像:

-

创建一个具有与输入图像相同形状的空张量,并用

1填充。将其馈入网络并获得 p ( x 1 ) p(x1) p(x1),即第一个像素的概率。 -

从 p ( x 1 ) p(x_1) p(x1)进行采样,并将采样值分配给输入张量中的像素 x 1 x_1 x1。

-

再次将输入提供给网络,并对下一个像素执行步骤2。

-

重复步骤2和3,直到生成 x N x_N xN。

自回归模型的一个主要缺点是它生成速度慢,因为需要逐像素生成,而无法并行化。以下图像是我们的PixelCNN模型经过100个训练周期后生成的。它们看起来还不太像正确的数字,但我们现在可以凭空生成新图像。可以通过训练更长的模型并进行一些超参数调整来生成更好的数字。

import tensorflow as tf

from tensorflow.keras import layers

from tensorflow.keras.activations import relu

from tensorflow.keras.models import Sequential

import tensorflow_datasets as tfds

import numpy as np

import matplotlib.pyplot as plt

import warnings

warnings.filterwarnings(‘ignore’)

print(tf.version)

(ds_train, ds_test), ds_info = tfds.load(

‘mnist’,

split=[‘test’, ‘test’],

shuffle_files=True,

as_supervised=True,

with_info=True)

fig = tfds.show_examples(ds_train, ds_info)

def binarize(image, label):

image = tf.cast(image, tf.float32)

image = tf.math.round(image/255.)

return image, tf.cast(image, tf.int32)

ds_train = ds_train.map(binarize)

ds_train = ds_train.cache() # put dataset into memory

ds_train = ds_train.shuffle(ds_info.splits[‘train’].num_examples)

ds_train = ds_train.batch(128)

ds_test = ds_test.map(binarize).batch(128).prefetch(64)

class MaskedConv2D(layers.Layer):

def init(self, mask_type, kernel=5, filters=1):

super(MaskedConv2D, self).init()

self.kernel = kernel

self.filters = filters

self.mask_type = mask_type

def build(self, input_shape):

self.w = self.add_weight(shape=[

self.kernel,

self.kernel,

input_shape[-1],

self.filters],

initializer=‘glorot_normal’,

trainable=True)

self.b = self.add_weight(shape=(self.filters,),

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

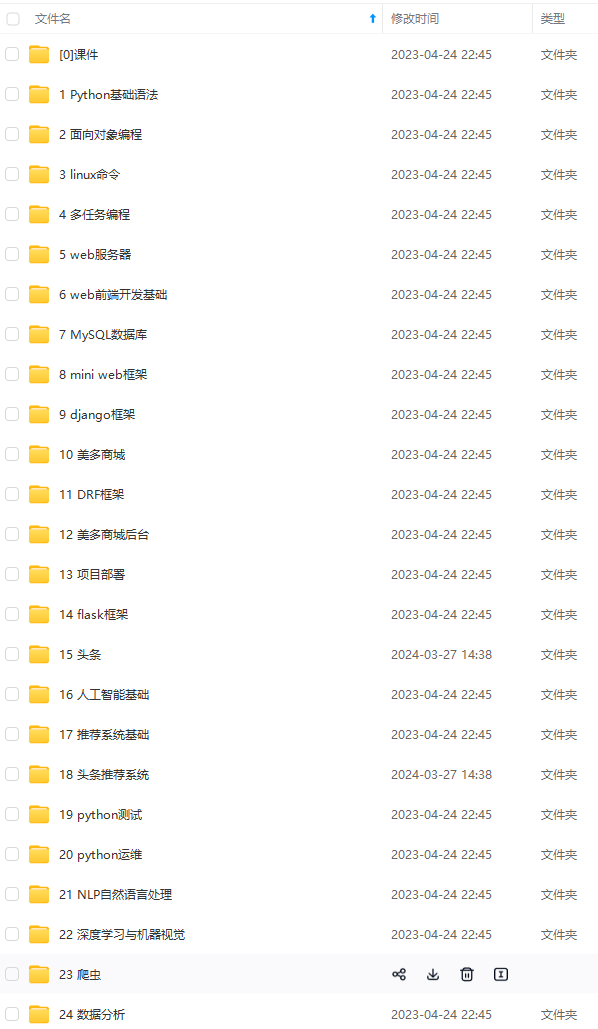

深知大多数Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Python开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加V获取:vip1024c (备注Python)

6381401c05e862fe4e9.png)

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Python开发知识点,真正体系化!

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加V获取:vip1024c (备注Python)

[外链图片转存中…(img-2iZ6RHc2-1712841649592)]

本文详细介绍了如何在TensorFlow中构建和实现PixelCNN架构,包括MaskedConv2D层的使用,残差块的设计,以及如何使用交叉熵损失函数训练模型以生成新的图像。着重讨论了自回归模型的优缺点和训练过程中的关键步骤。

本文详细介绍了如何在TensorFlow中构建和实现PixelCNN架构,包括MaskedConv2D层的使用,残差块的设计,以及如何使用交叉熵损失函数训练模型以生成新的图像。着重讨论了自回归模型的优缺点和训练过程中的关键步骤。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?