最小二乘法推导

多元线性回归的写法

与数学中不同的是,在机器学习中,系数w和截距b是需要求得的未知数,而特征x和标签y则是已知的。

将上边的方程写成矩阵形式便是

此时的,w和x都是矩阵,,

普通线性回归中的目标便是求的w和b两个参数,w其实是weight的简写,意为自变量的权重。

-

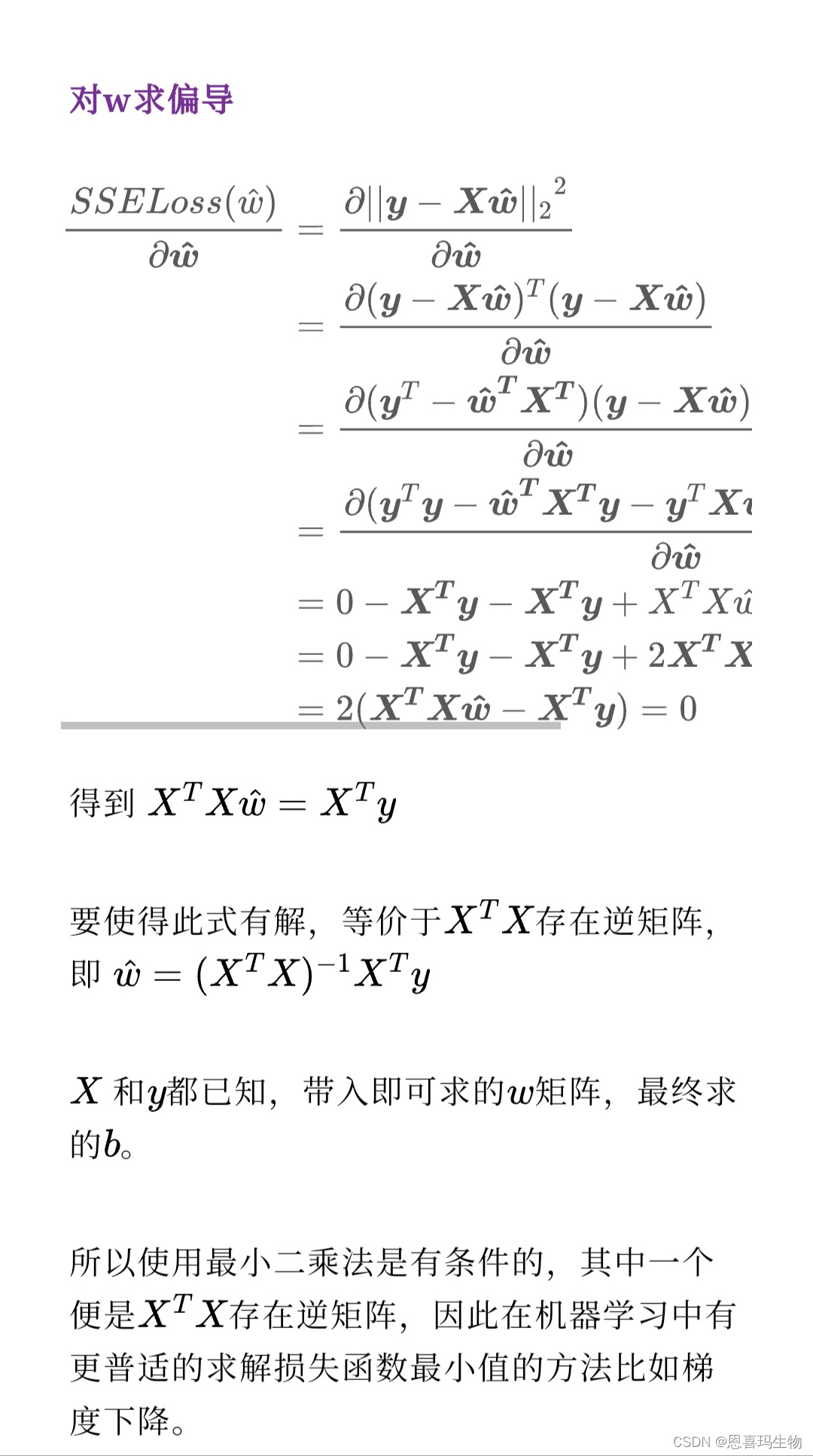

普通线性回归常用的损失函数(L)是SSE(误差平方和),即(真实值-预测值)的平方之和

其中 称为2范数,不过在这里暂时用不到。可以看到,损失函数是关于参数w的函数。目标是对损失函数求最小值,因此可以让其偏导数=0

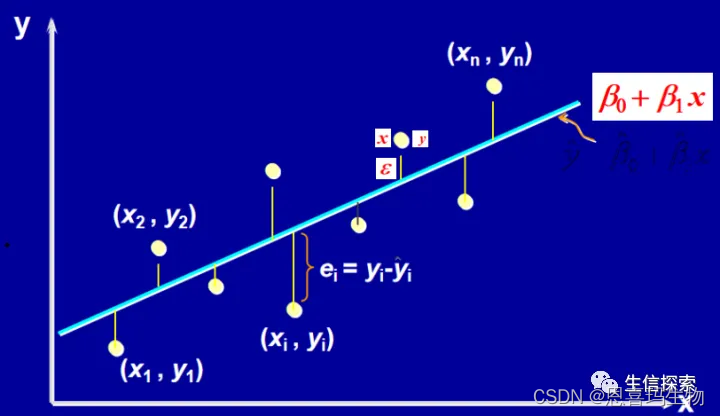

如果只有一个特征那么可以在二维图中展示:

可以看到,模型使用一条直线拟合散点,损失函数就是真实值到预测值的欧式距离的和,求损失函数最小值即是使直线尽可能拟合到更多的点。

对w求偏导

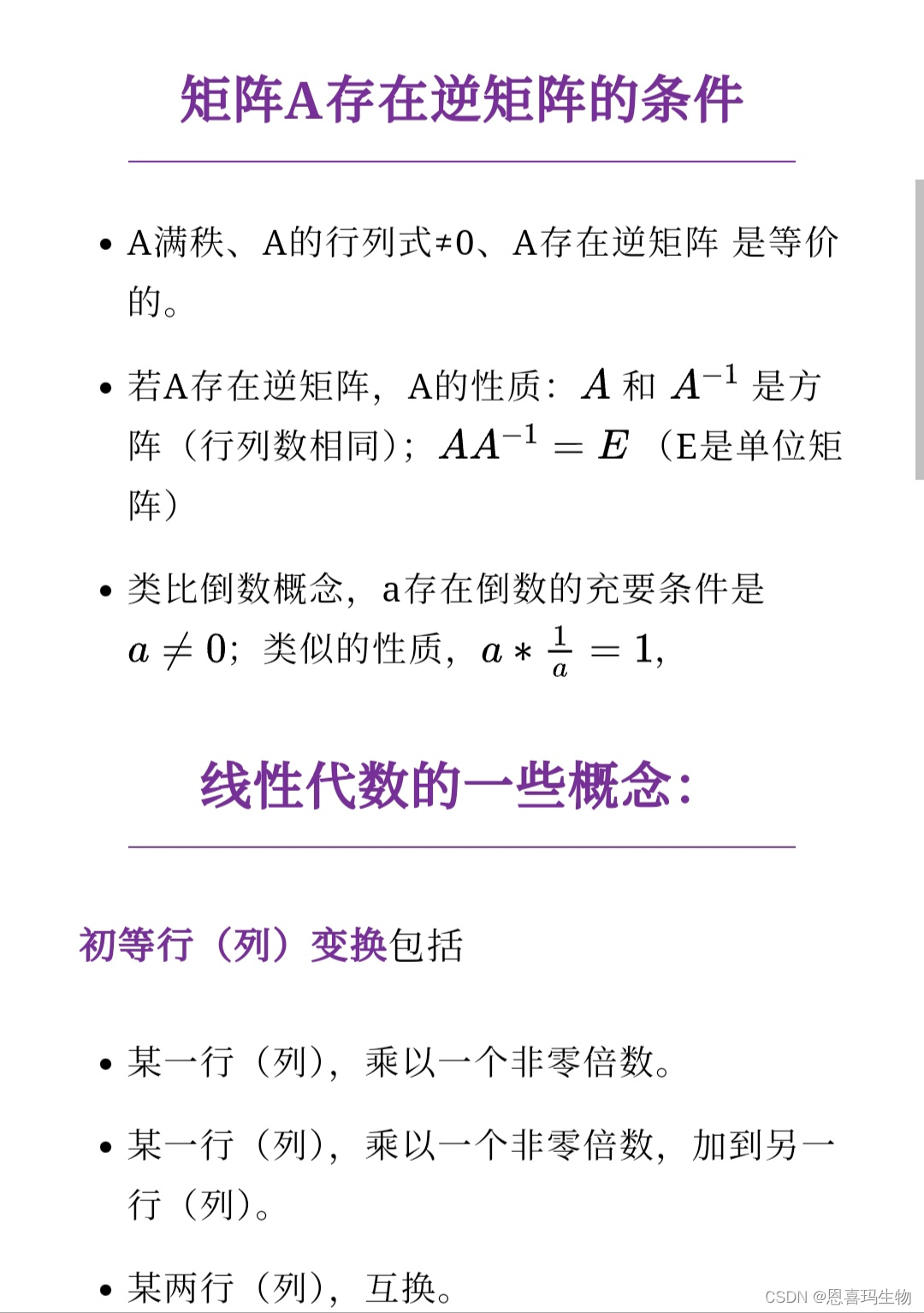

阶梯型矩阵:所给矩阵为行阶梯型矩阵,则矩阵中每一行的第一个不为零的元素的左边及其所在列以下全为零。

矩阵的秩(rank):把矩阵经过初等行变换成阶梯型矩阵,非0行的个数即为其秩。

满秩:矩阵的秩=其行数,或者说阶梯型矩阵没有非0行,或者说其行列式≠0

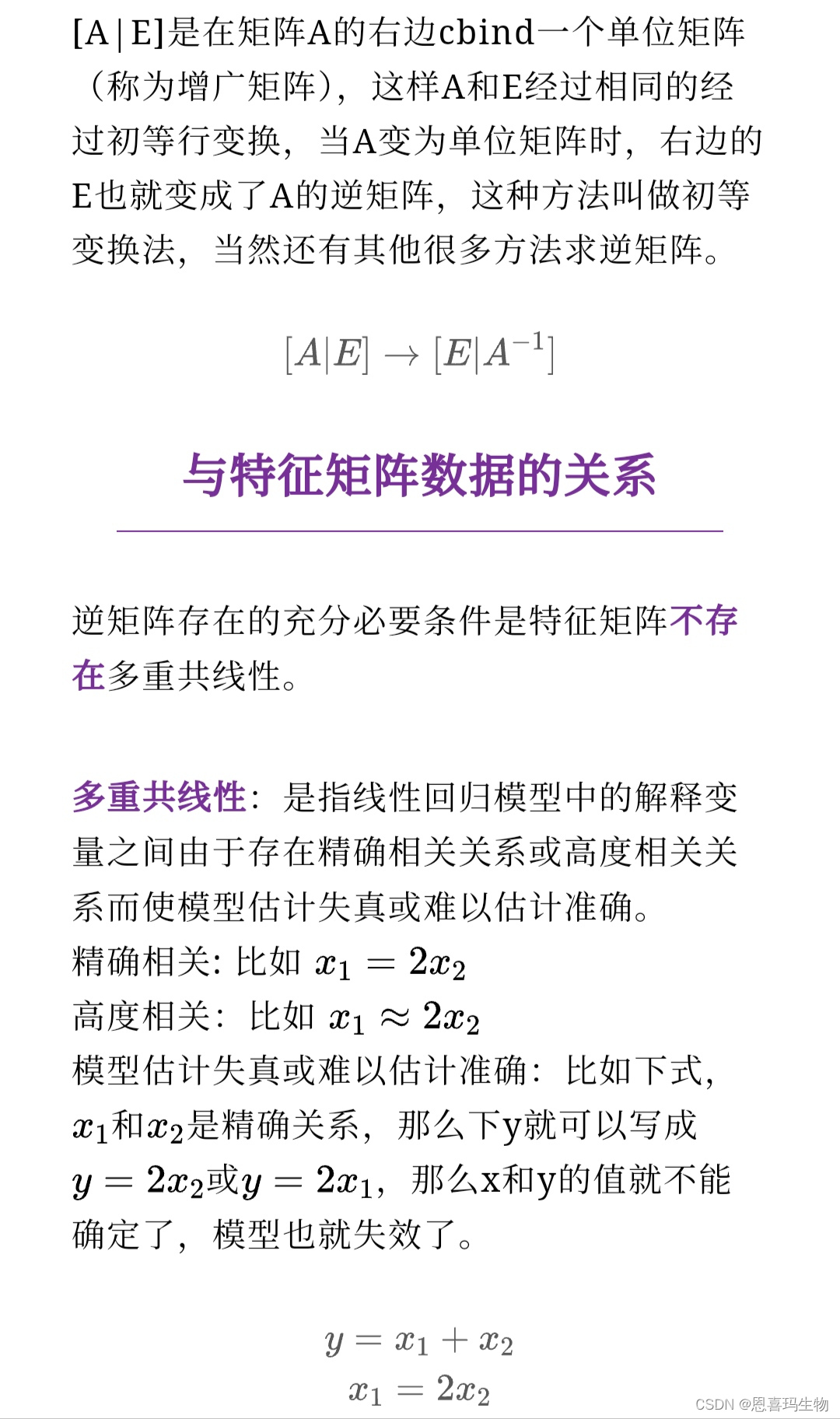

求A的逆矩阵

因此,比如我们的两个基因表达量相关性过高,就会造成多重共线性,建模中解决多重共线性的方法是可以对损失函数加上惩罚项,比如拉索回归、岭回归和弹性网络。

参考:https://baike.baidu.com/item/%E5%A4%9A%E9%87%8D%E5%85%B1%E7%BA%BF%E6%80%A7/10201978?fr=aladdin

https://www.bilibili.com/video/BV1UU4y1M73o?vd_source=d18945ce98e39afc8362968bf50c8dde

https://www.bilibili.com/video/BV1vJ41187hk?p=59&vd_source=d18945ce98e39afc8362968bf50c8dde https://zhuanlan.zhihu.com/p/355241680

https://zhuanlan.zhihu.com/p/486971703

生信探索

分享收藏23

发消息

人划线

1452

1452

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?