前言

本地搭建Stable Diffusion,文生图再也不用求别人了

1. 简介

Stable Diffusion 是一种深度学习模型,用于生成高质量的图像。它基于一种名为扩散过程的生成方法,能够在给定条件的情况下生成具有丰富细节的图像。

看看本文的搭建步骤,成功部署 Stable Diffusion 模型,文生图从此不求人,不用找各种代理和第三方付费的资源了。

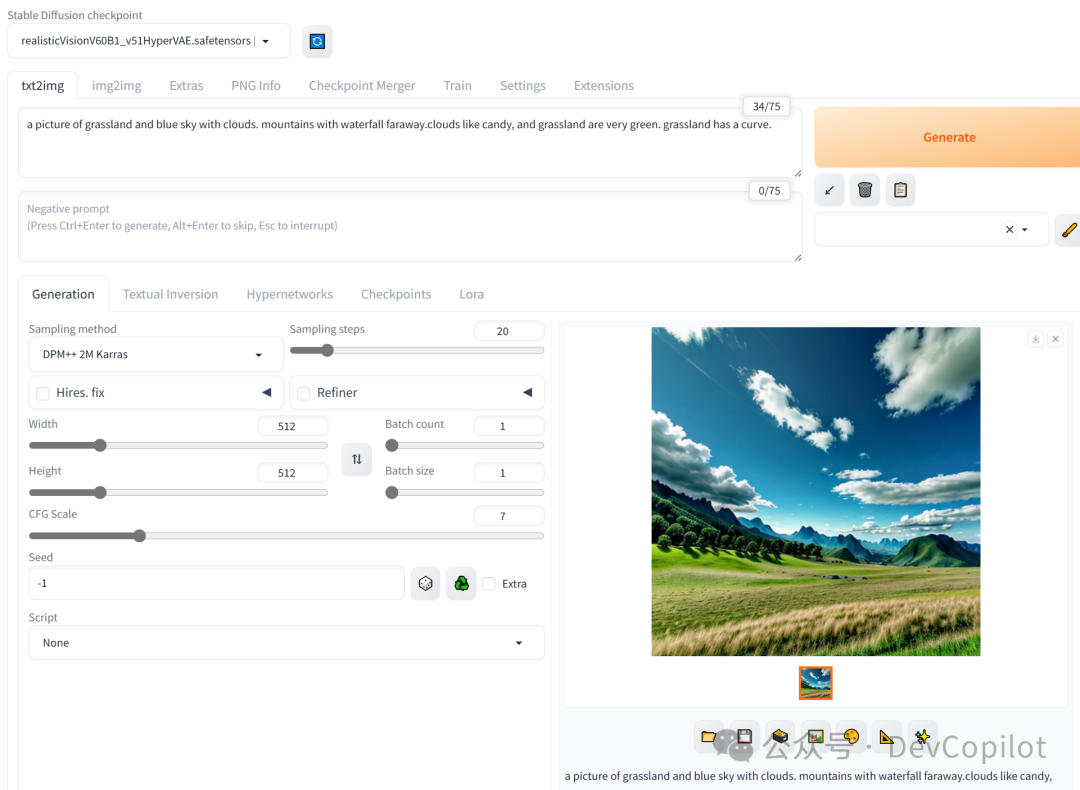

2. SD,启动!

(SD的提示词仅支持英文,用中文亲测了一点也不准确)

下面是同样的中文测试结果(中文提示词跑出来的过于恐怖奇葩,仅供图一乐):

我把启动和效果,放到了最前面,方便大家看看要不要继续看后面的详细部署的过程。

这是我针对自己电脑多次踩坑后测试出来的可启动的配置

python.exe D:\AI\stable-diffusion-webui-1.8.0\webui.py --opt-split-attention --enable-insecure-extension-access

亲测SD对于低显存还是比较友好的,像我这个机器,不知道为什么,就是不适用显卡进行计算,把我的内存都占满了。

看看哈,实际测试的结果,GPU只给我占了1G多,峰值也就不到3G;而内存给我快干爆了。

相对来说,执行计算也不是很慢,基本半分钟一张图吧。

3. 环境准备

在开始搭建 Stable Diffusion 模型之前,请确保您的计算机满足以下要求:

-

• 操作系统:我是Windows10,理论上Linux之类的应该好点儿

-

• GPU:NVIDIA GPU(本机是NVIDIA 1080 6G的老古董,最好是整个4090啊)

-

• CUDA:12.0 或更高版本

-

• cuDNN:11.0 或更高版本

-

• Python:3.8 或更高版本

-

• PyTorch:2.0 或更高版本

4. 下载代码

首先,把stable-diffusion-webui的代码下载下来

解压完成后,安装对应的依赖

5. 安装依赖项

接下来,安装 Stable Diffusion Webui中模型所需的依赖项。在代码仓库的根目录下,执行以下命令:

pip install -r requirements.txt

6. 下载预训练模型

模型的下载,是SD部署成功最关键的核心,我因为模型的问题,整了好久都没整出来,如果遇到错误,还是多百度百度。

Stable Diffusion 模型提供了预训练的权重,可以从官方提供的链接下载。下载完成后,将权重文件放置在代码仓库的 models\Stable-diffusion 目录下。

在我国的话还是直接从modelscope下载吧;有科学上网的话,也可以从huggingface官网或者其他第三方网站下载:https://civitai.com/

我是从这下载的

from modelscope import snapshot_download model_dir = snapshot_download('AI-ModelScope/clip-vit-large-patch14')

7. 生成图像

打开网页,默认的模型还是差强人意,可以下载第三方的模型再试试

默认的模型生成的图像

第三方模型生成的图像,可以说,相当逼真了。

这里直接将该软件分享出来给大家吧~

1.stable diffusion安装包

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

2.stable diffusion视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入坑stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.SD从0到落地实战演练

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名SD大神的正确特征了。

这份完整版的stable diffusion资料我已经打包好,需要的点击下方插件,即可前往免费领取!

2549

2549

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?