大家好,我是程序员超超。

在上篇笔记中简单了解了一下FLUX这个模型比起其他市面上模型较为不错的点,例如在庞大的训练集辅助下FLUX有着强大的关键元素提取能力,简单来说就是更加“听话”,能够准确捕捉到提示词中的关键信息。

当然具体成图怎么样还是得自己体验跑图试试,让我来看看FLUX模型是否能撼动Stable Diffusion模型的地位,所以今天这篇文章就说一下怎么下载模型以及如何操作。

模型下载

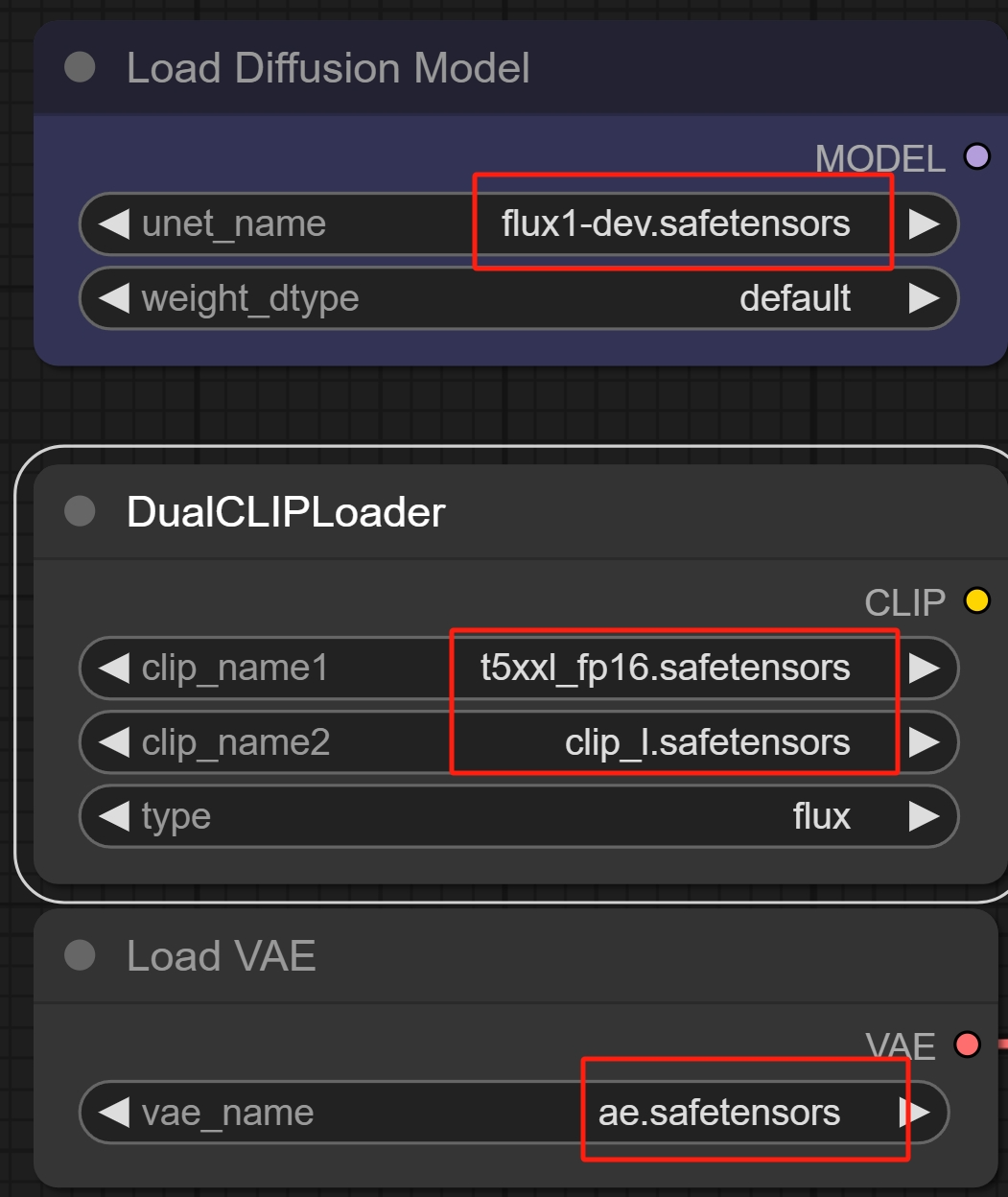

虽说FLUX是开源的,不过也是需要“三件套”才能顺利运行起来,分别需要下载基础模型、文本编码器和VAE(编解码器)。

这些都是可以在huggingface下载到的,需要准备约55G左右的空间:

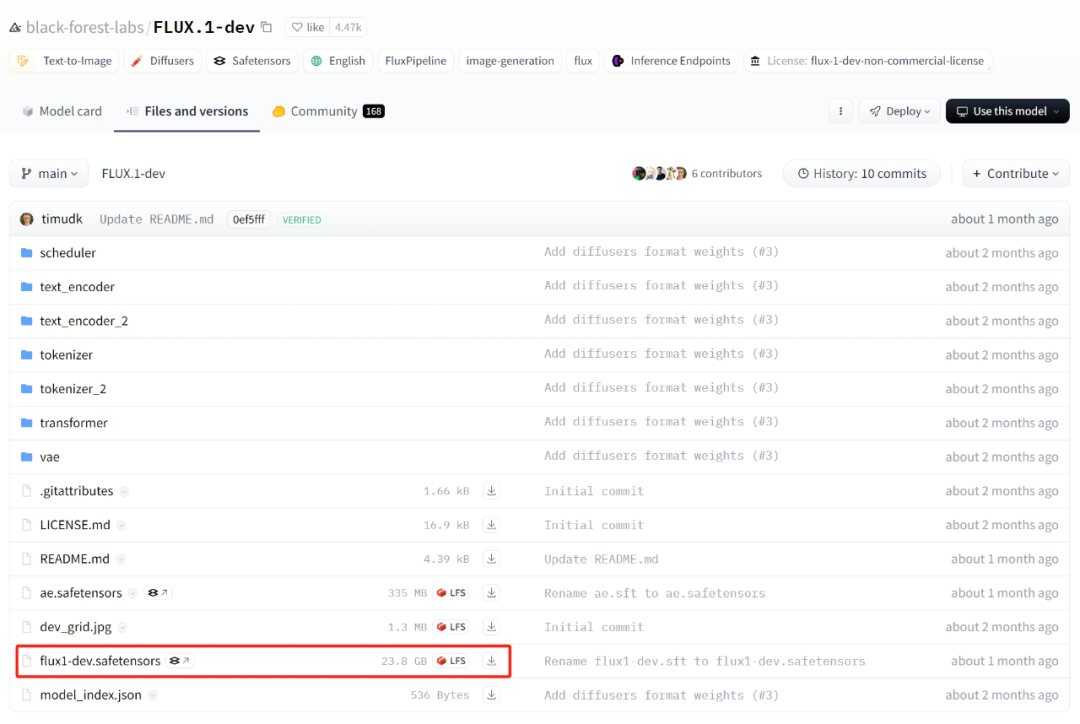

Dev模型:https://huggingface.co/black-forest-labs/FLUX.1-dev/tree/main

文件名:flux1-dev.safetensors(23.8GB)

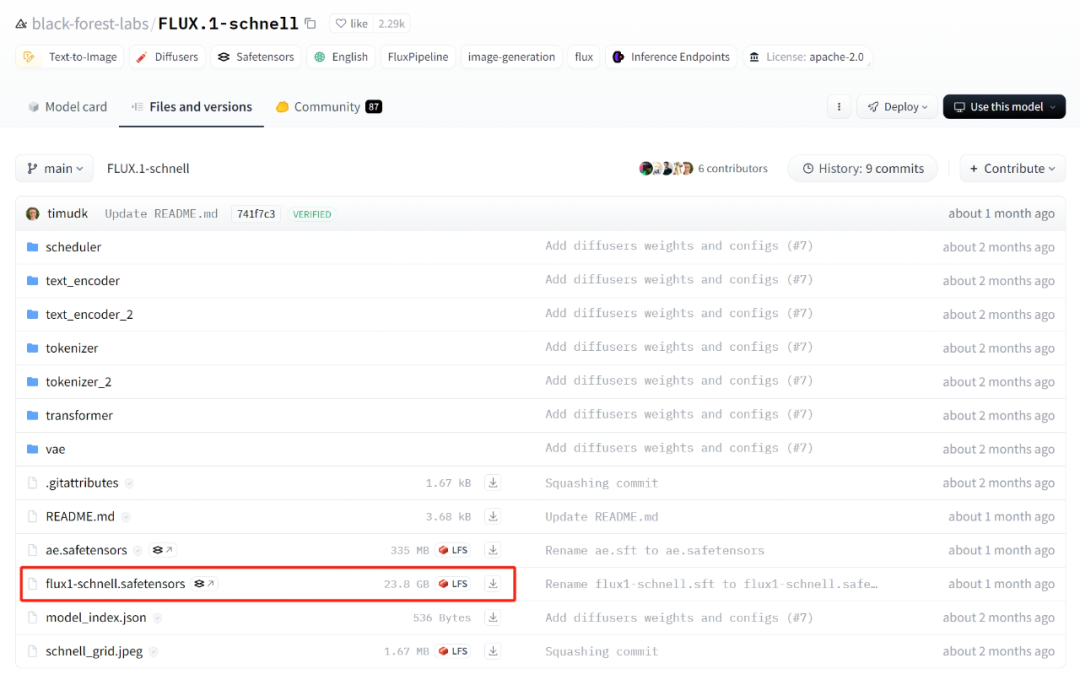

Schnell模型:https://huggingface.co/black-forest-labs/FLUX.1-schnell/tree/main

文件名:flux1-schnell.safetensors(23.8GB)

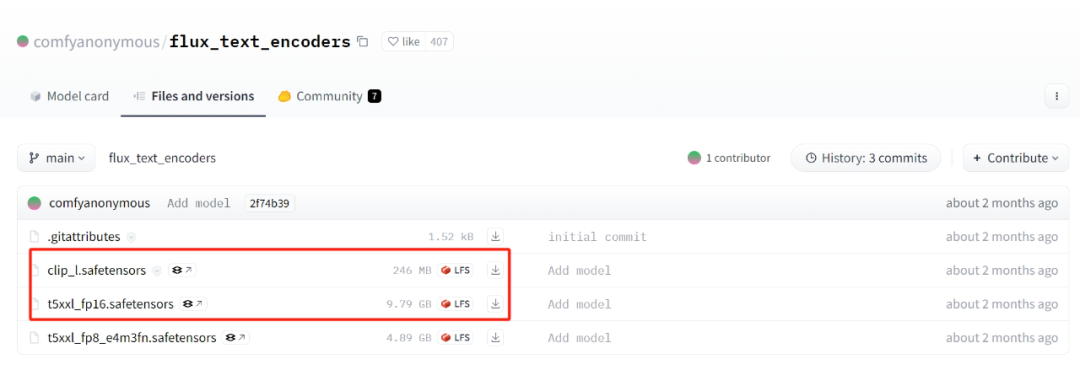

文本编码器: https://huggingface.co/comfyanonymous/flux_text_encoders/tree/main

文件名:

clip_l.safetensors(234MB)

t5xxl_fp16.safetensors(9.79GB)

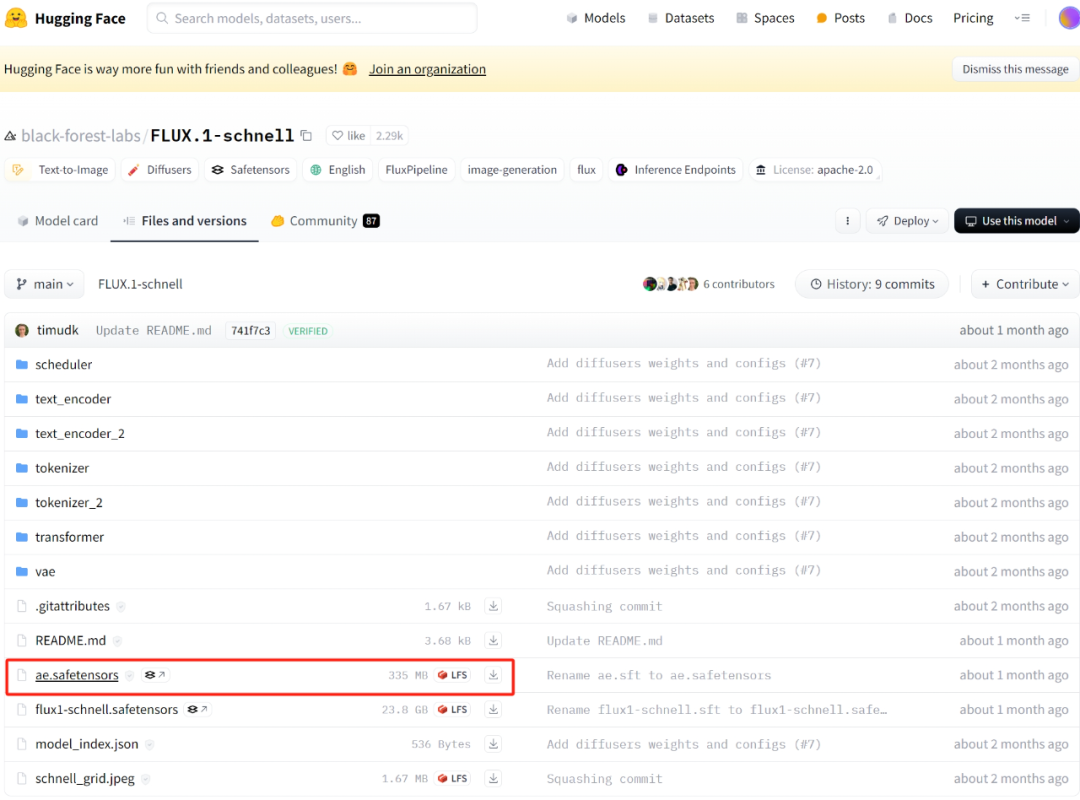

VAE编码器:https://huggingface.co/comfyanonymous/flux_text_encoders/tree/main

文件名:ae.safetensors(335MB)

目前来说在本地运行FLUX模型最优选是在ComfyUI上,ComfyUI是目前最为流行的节点是AI绘画应用。

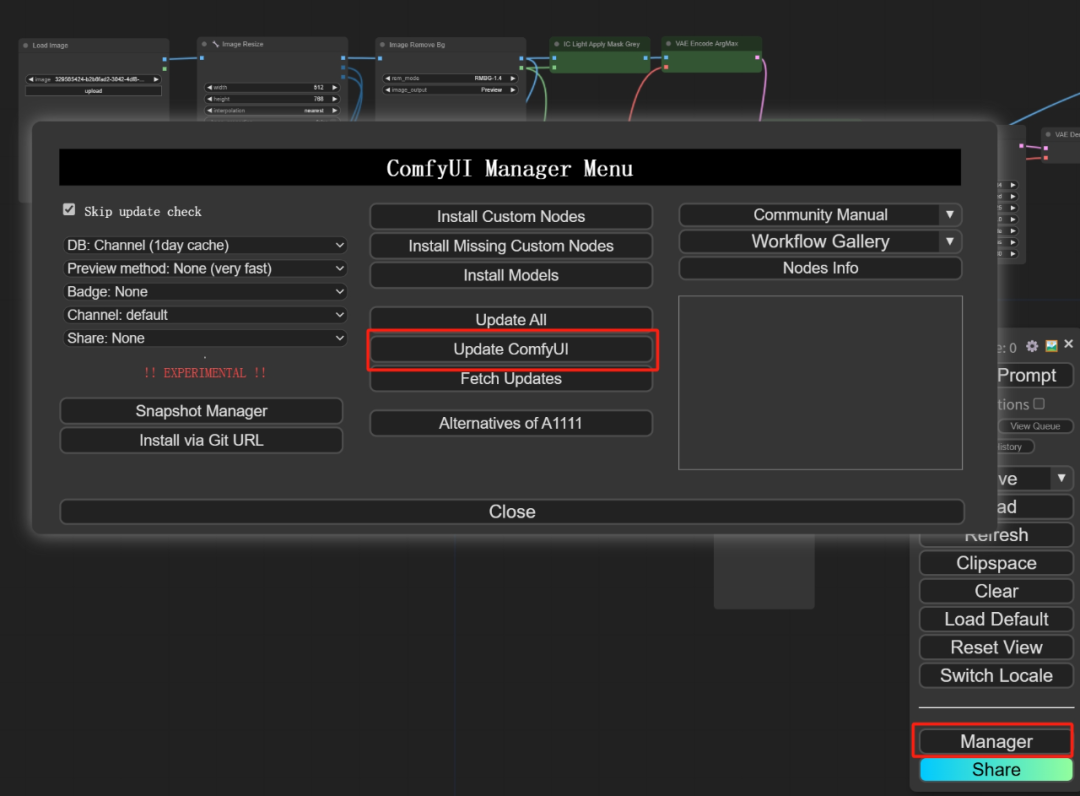

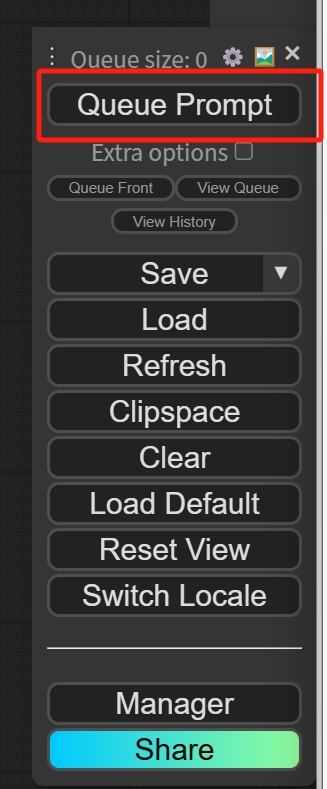

不过在使用FLUX之前最好先将ComfyUI更新至最新版本,直接在ComfyUI界面中更新即可。

还有一点要注意的是刚刚下载的那些文件都是需要放到ComfyUI的根目录文件下方:

- 两个20多GB的基础模型放在路径: ComfyUI/models/unet

2. 两个文本编码器放在路径:ComfyUI/models/clip

3. VAE编解码器放在路径:ComfyUI/models/vae

在放置好上述文件之后就可以完全关闭(包括后台)并重启ComfyUI

FLUX的操作

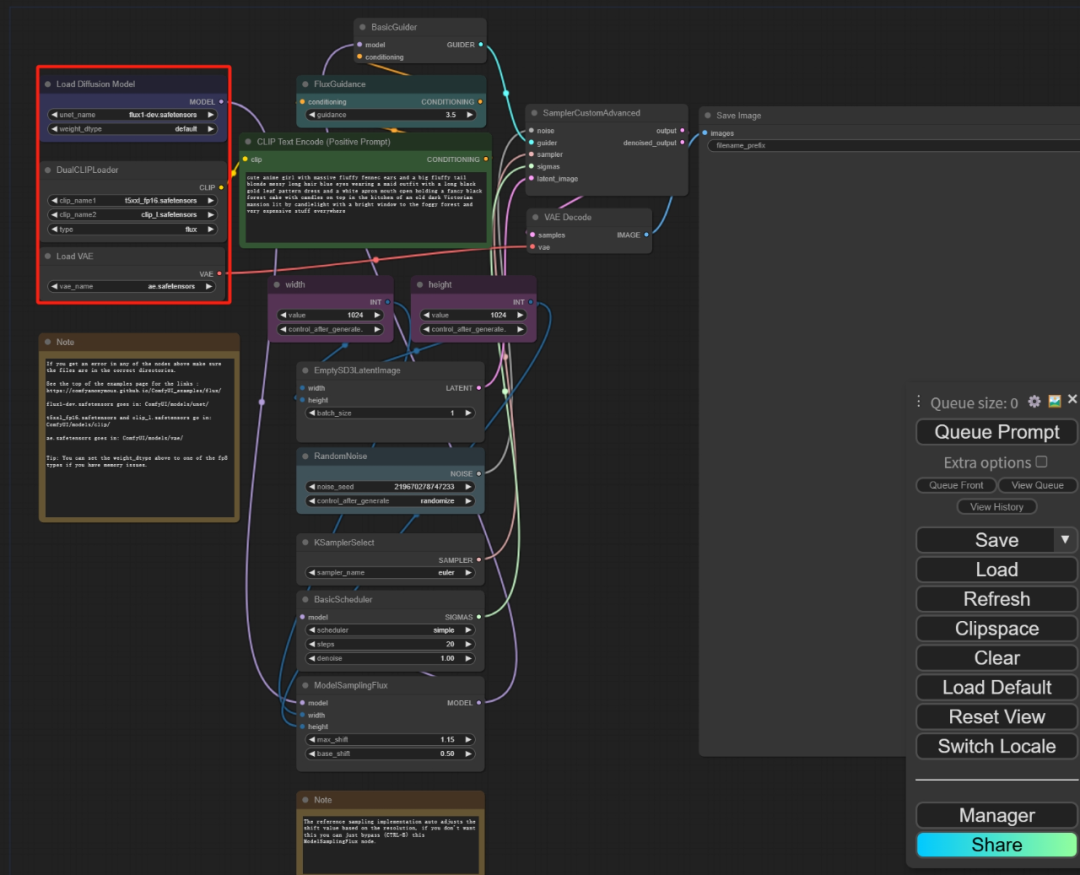

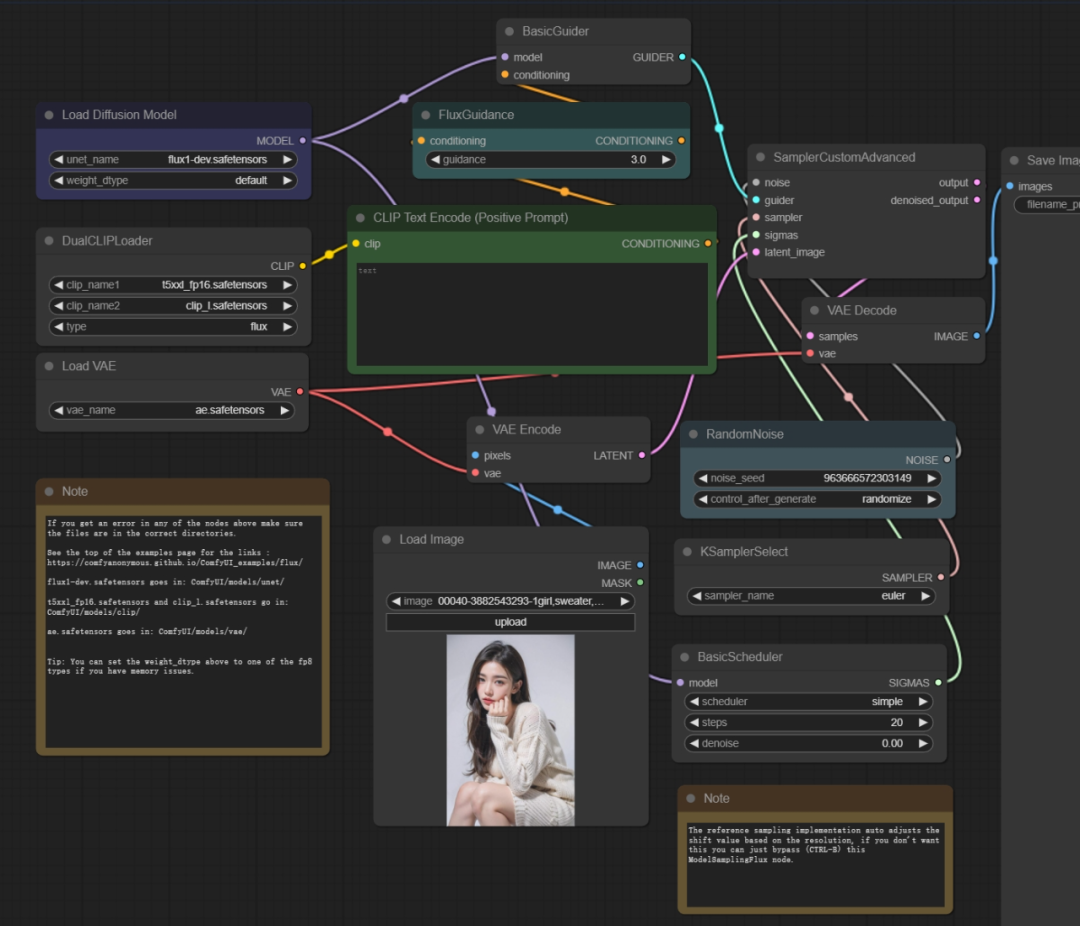

ComfyUI官方也提供了FLUX模型的标准工作流,获取方式也很简单,直接来到这个GitHub页面,然后将图片直接拖拽到ComfyUI中即可。

https://comfyanonymous.github.io/ComfyUI_examples/flux/

这个是一个DEV模型的标准工作流,至于如何操作嘛。

第一步 :首先在右上角找到红框处这三个节点,分别加载刚下载完的扩散模型Unet、VAE和文本编码器CLIP。

第二步: 找到这个绿色的文本编码器框,也就是输入提示词的地方用英文输入想要生成的内容,如果不知道写什么可以参考下面这段话:

A filmic upper body portrait of a young woman in black forest, holding a paper showing words “FLUX Dev”

在这个绿色的节点上方还有一个FluxGuidance也就是FLUX引导系数数值,用于控制提示词的强度,数值越低AI发挥越自由,反之越忠实。

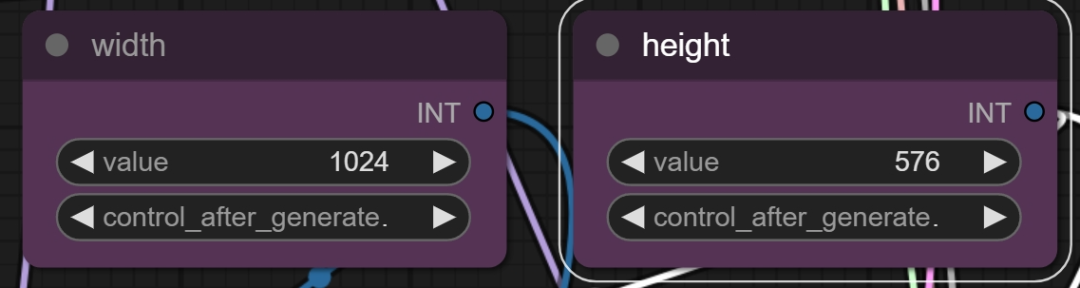

第三步: 在下方有两个节点分别填写生成图片的宽和高,根据自己需求决定,也可以照图中的参数更改。

宽1024 高576

第四步: 下方这些参数会部分影响生成结果,有些用过WebUI的小伙伴就很熟悉了,但是以防万一我这里再提示一下(以下设置全部维持默认即可)。

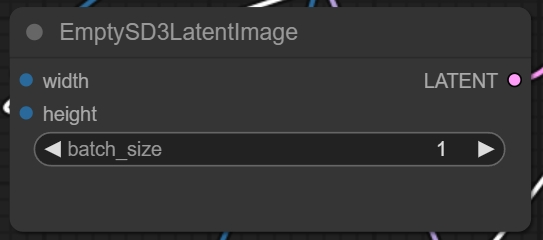

batch_size(批次大小):指一次性生成图片的数量,数值高会显著提高占用数值,一般默认1.

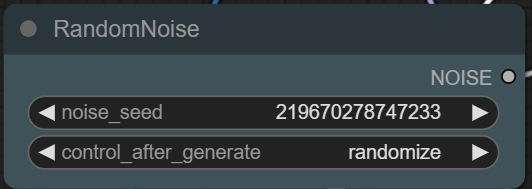

noise_seed(随机种子):决定生成图片的初始噪声,同一提示词下相同的随机种子可以生成相似的图片,如果要固定种子的话讲第二个选项从randomize改为fix

KSamplerSelect(采样器选择):决定模型去噪生成图片的方式,一般维持默认。

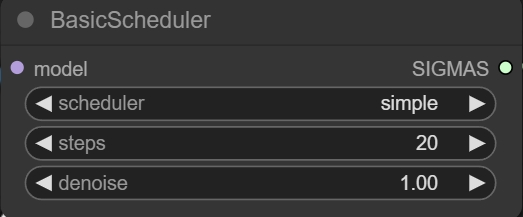

Scheduler(调度器):同样用于决定好模型去噪生产图片的方式,一般维持默认。

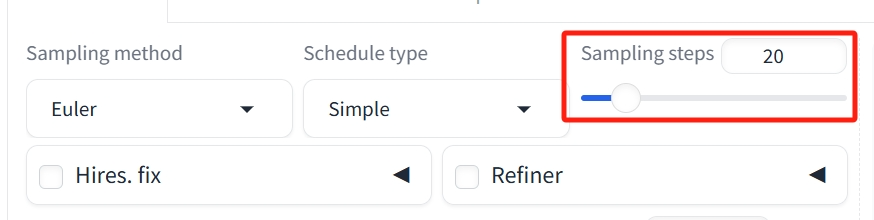

Steps(步数):模型去噪生产图片的步数,Dev模型一般为20步,如果是Schnell模型的话只需要4步即可。

Denoise(降噪):默认按1设置,在图生图等输入原图的流程中可以用于控制“重绘”的幅度(即与原图的相似度)。范围一般在0-1间,为0时与原图完全一致。

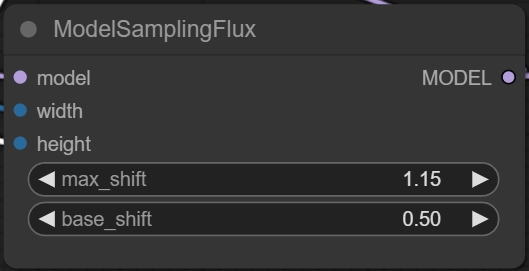

max_shift&base_shift(最大偏移&基础偏移):一个用以稳定图像生成过程的设置,默认流程下会自动调整。

第五步:在完成上述操作之后可以点击生成图片了。

然后在最右侧的输出节点那里就可以看到生成的图片啦!

这就是在ComfyUI中使用Dev模型的流程,Schnell模型大同小异,只需要把生成的Steps步数设置为4步即可,其生成速度会很快但是质量就不如Dev了。

ComfyUI有个不错的点就是更改下几个节点就可以从文生图变成图生图流程。

我是按照原教程UP的视频截图更改的,公众号图片这里可能比较小看不太清楚,推荐感兴趣的小伙伴直接去文末原教材链接的简介中进行下载。

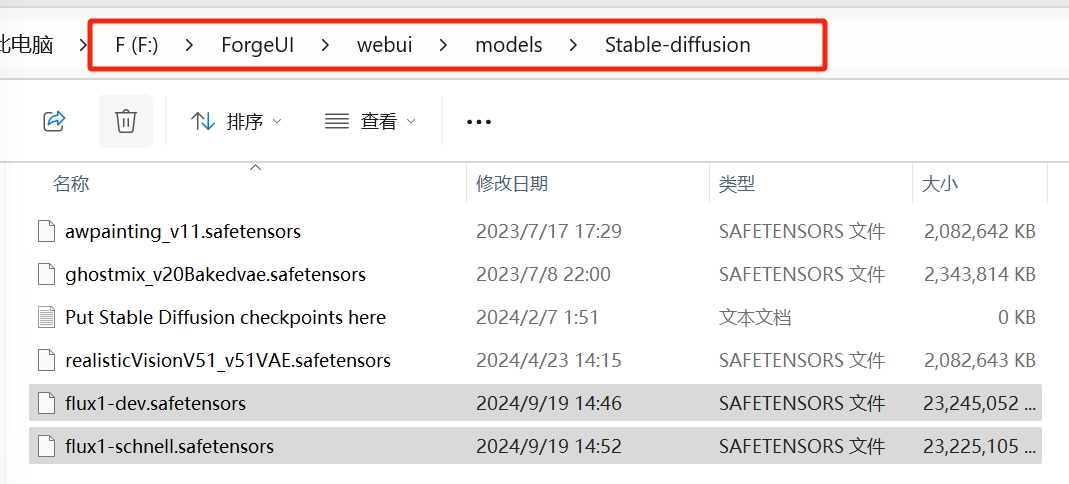

当然除了ComfyUI以外还有SD WebUI Forge也可以使用FLUX,这个Forge相当于是一个SD WebUI 的改良版本。

当然上面下载的三件套也是需要复制粘贴到ForgeUI下方的。

flux1-dev.safetensors和flux1-schnell.safetensors放到这个路径:

WebUI/models/stable-diffusion

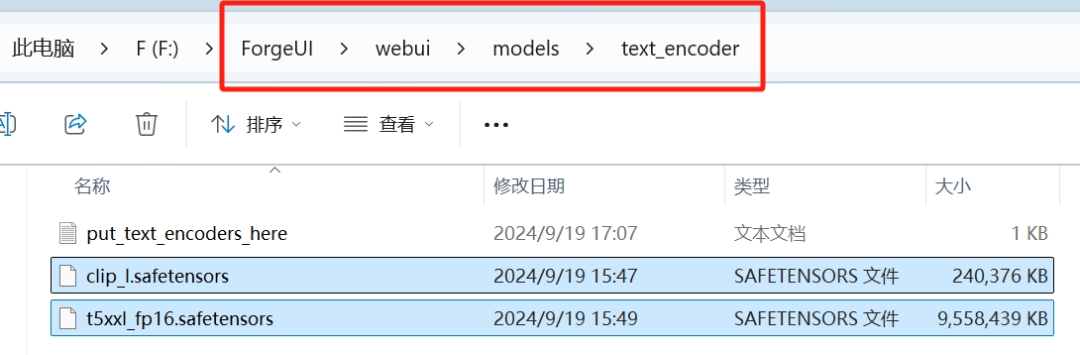

clip_l.safetensors和t5xxl_fp16.safetensors放到这个路径:

WebUI/models/text_encoder

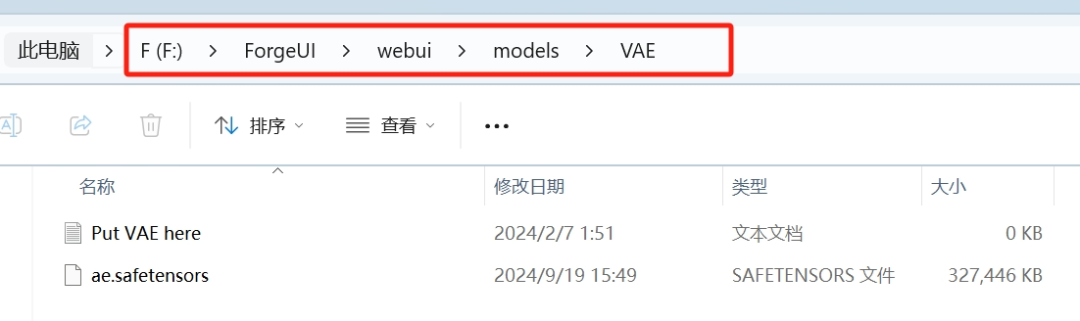

ae.safetensors放到这个路径:

**WebUI/models/VAE

**

将这些文件都放好后就可以点击run.bat来启动ForgeUI了

打开后主界面的左上角有四个UI选项,选择FLUX。

Checkpoint选项选择flux1-dev.safetensors选项

VAE/Text Encoder选项选择时按住键盘Ctrl将ae.safetensors、clip_1.safetensors和t5xxl_fp16.safetensors都选上。

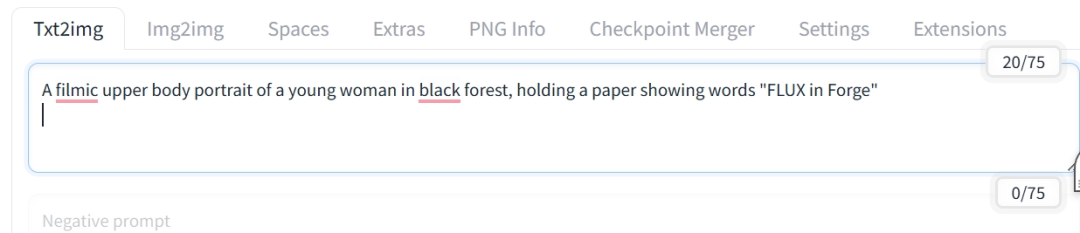

然后在下面的框中简单输入提示词:

A filmic upper body portrait of a young woman in black forest, holding a paper showing words “FLUX in Forge”

然后点击右侧的Generate就可以生成图片啦!

不过有小伙伴可能发现了下方的Negative prompt是锁定的,这是因为FLUX是不需要负面提示词来限制的。

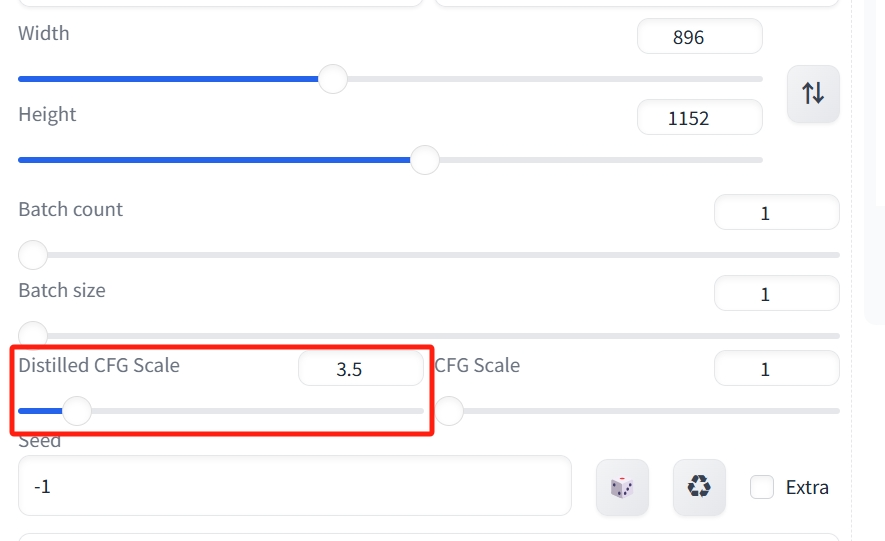

下方的Distilled CFG Scale就是之前提到的FLUX引导数值

这样就可以简单地用FLUX在本地生成图片了,如果选择的是Schnell模型的话记得把采样迭代步数从20改为4。

今天的内容就到这里啦!

可以先多试试看FLUX的生成结果看看哪个模型是自己比较喜欢的,至于FLUX和Stable Diffusion究竟谁更适合我还需要几篇笔记的时间来验证。

之后几篇笔记会尝试一下如何降低显存和结合LoRA、ControlNet等插件来看看效果。

大伙就下篇笔记见啦,拜了个拜!

写在最后

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

感兴趣的小伙伴,赠送全套AIGC学习资料和安装工具,包含AI绘画、AI人工智能等前沿科技教程,模型插件,具体看下方。

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

在这里插入图片描述

若有侵权,请联系删除

1350

1350

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?