前言

由于个人工作环境时常需要在内网中,无法连接互联网调用满血模型,正好笔记本自备RTX4060,膨胀一下,本地部署玩玩。另外最近Manus很火,搞不上验证码也本地部署一下国人复刻的open Manus玩玩,体验一下Ai Agent 。

部署环境:Windows 11,i9-13900H,48G内存,RTX4060 8G显存

一、 本地部署模型

先考虑模型部署,直接下载业界大哥草泥马,用来地运行和管理大型语言模型。安装过程中没有什么可以给你选择的选项,一路next。

https://ollama.com/download

安装好草泥马后,要考虑电脑性能本地运行多大规格量的模型,可以用下面这个站查看一下。

https://tools.thinkinai.xyz/

确定好能运行的模型,然后去下载模型,草泥马官网有模型仓库,可以直接拉取,拉不动需要科学上网。

https://ollama.com/search

这里我先拉取了一个deepseek的8b模型,这里要注意,deepseekR1目前还不支持function call,说白了就是不支持调用外部工具的能力,所以如果你要是准备玩manus那就不要拉取deepseek,我后面测试使用了qwen2.5:14b可以跑起来。我这里记录一下这个坑,不需要直接划过。

ollama run deepseek-r1:8b

拉取完后会自动跑起来,然后就可以直接与其对话了,退出可以按Ctrl+D。

二、部署openmanus

根据openmanus作者在github(https://github.com/mannaandpoem/OpenManus)发布页上的写的内容来看,有两种部署方式,我选择了使用conda的虚拟环境,直接杀到anaconda的官网下载一份。

https://www.anaconda.com/products/ai-navigator#downloads

安装完成后,在cmd窗口中运行conda可以返回命令帮助信息的即为成功。

使用conda创建一个虚拟环境,可以使用列语句创建到指定位置,并指定python版本是3.12

注意需要先把指定位置的文件夹建好,不然会报错。

conda create --prefix G:\openManus\env\open_manus python=3.12

创建好后,去激活虚拟环境,返回下图中所在目录前有括号路径的提示符样式则为进入虚拟环境成功。

conda activate G:\openManus\env\open_manus

使用git命令下载openmanus包。

git clone https://github.com/mannaandpoem/OpenManus.git

没有装git程序可以直接进入页面下载,然后解压到自定义位置。

进入openmanus安装包根目录下,可以看到requirements.txt文件,里面放着需要验证的依赖包,使用pip命令下载安装依赖,-i可以使用指定镜像源,这里使用清华镜像源。

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

安装好依赖包,作者GitHub上没写这一步,需要安装playwright爬虫模块和内嵌的浏览器。

playwright installplaywright install-deps

准备工作做好后,就可以修改openmanus的配置文件了,部署包config目录下有自带的配置文件样例,复制出来按下图改名。

打开改好名字的配置文件,修改下面红框内容:

使用ollama本地部署的模型调用base_url都是”http://127.0.0.1:11434/v1”;

api_key都是”ollama”;

model这里,你准备让openmanus调用你发布哪个模型就填哪个模型的名字;

配置好后,打开一个新cmd,先激活虚拟环境

conda activate G:\openManus\env\open_manus

然后在虚拟环境中进入openmanus的安装路径

cd G:\openManus\OpenManus

使用python main.py命令启动。

启动完成后会让你输入内容,我这里让他生成一个名字叫123的txt文档,文档内容写hello word,最后保存到桌面,然后如下图,报了400。

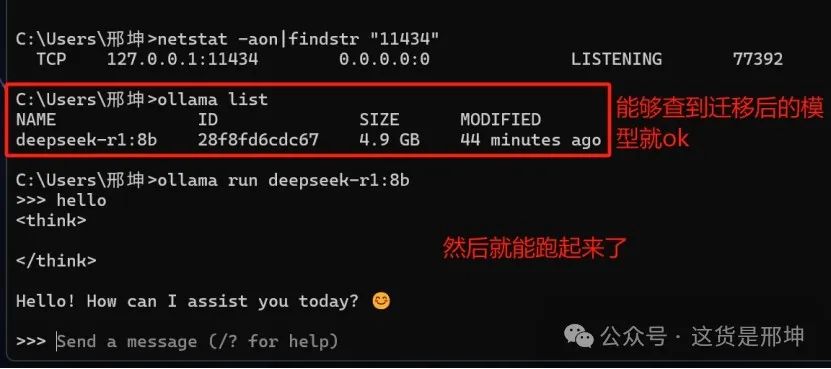

可以先测试一下你的ollama是否启动成功,直接访问你配置中的地址,注意没有后面的v1

上图就是启动成功了,至于模型名可以在cmd中使用ollama list去确认。

Deepseek模型不能调用三方组件,所以后来我又下载了千问模型

ollama run qwen2.5:14b

然后重新修改openmanus的配置文件。

再打开一个新cmd,先激活虚拟环境

conda activate G:\openManus\env\open_manus

然后在虚拟环境中进入openmanus的安装路径

cd G:\openManus\OpenManus

使用python main.py命令启动。

然后我再让他帮我编写一个名叫123的txt文档,文档内容是“hello word!” 这次速度倒是很快,他在根目录中生成了我要的文件。

然后我又让他帮我打开淘宝网搜索潜水艇马桶,等我登录后,帮我查找前十个产品的价格和图片,帮我做个2页的ppt。

这次风扇开始工作了,但是我这个14b的模型智商还是有点儿低,一开始尝试去爬搜索框和按钮,爬了好几次没爬到,最后直接get请求去找马桶,然后也没有做出来ppt,可以说他有智力但不多。

怎么说呢,应了我前同事张峰的话:“风扇哇哇响,一看屏幕打开个word都未响应了。”

三、结论:

用openmanus调用本地模型的方法还是不是很靠谱,可能也是我电脑性能不足以支撑更大参数模型的原因,不过看了看网上其他人分享的经验,70b参数之下的模型智商都比较抽搐哈哈。

离线的openmanus我这电脑是不抱希望了,至于本地模型,我觉得之后可以把项目上的资料规整一下建立本地的知识库试试。

最后,我也衷心的希望AI可以帮我洗碗,好AI一生平安!

四、分享一些其他玩法:

1.本地openmanus调用在线大模型

不过如果工作环境允许使用互联网的情况下,可以去注册硅基流动的账号,送14块钱,直接就能薅羊毛,够用一段时间。把openmanus配置文件改一下就可以直接调用在线模型了。

2.字节跳动扣子

或者压根不想在本地部署又想体验AI智能体,最近字节跳动发布了一款线上AI agent 扣子。体验了一下官方示例,通过输入城市名,自动查询天气后生成城市天气图片与气温播报。

官方的示例复制可以查看他的工作流

按照他的玩法,我们初心不忘继续去淘宝搜索潜水艇马桶并返回ppt,分分钟返回了下载链接。

下载下来看了看,没调整格式,丑的一比,哈哈。

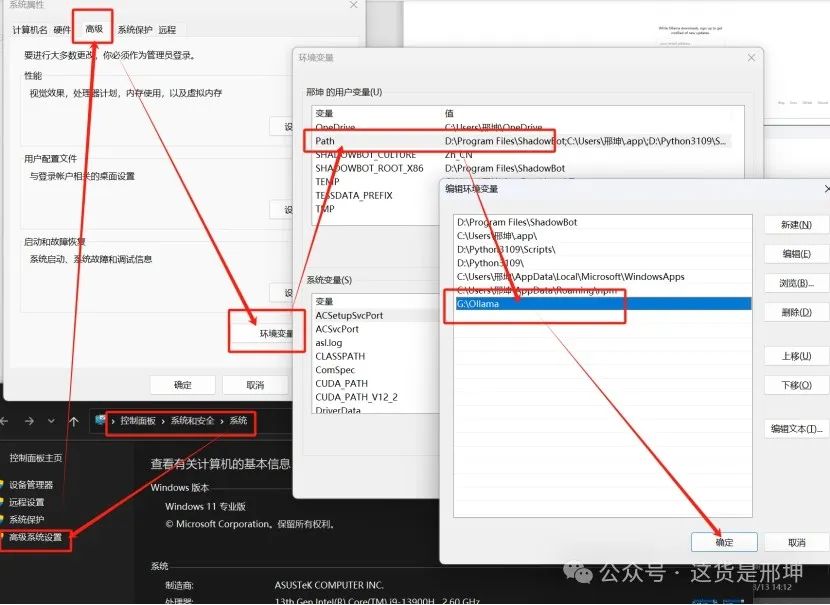

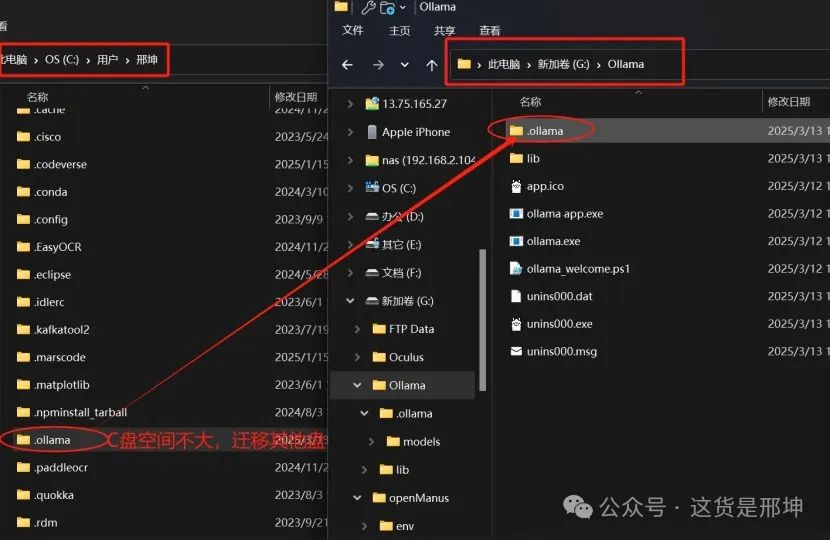

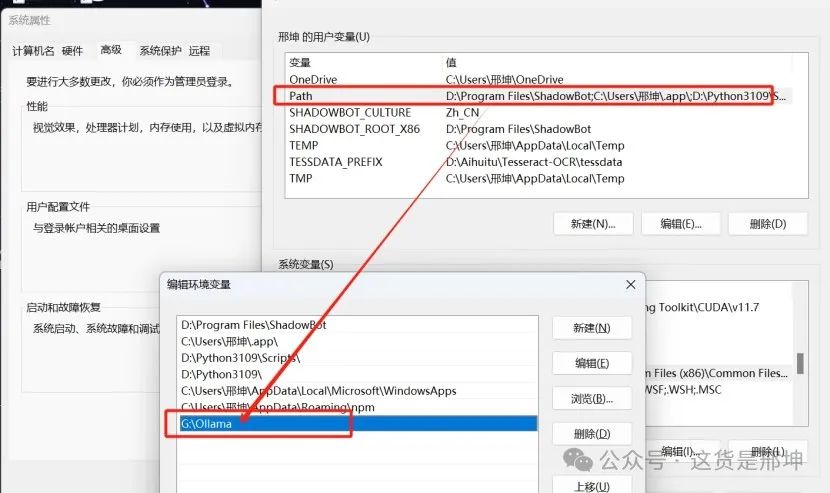

Ps: 改掉ollama默认安装C盘的坏毛病,迁移ollama安装目录和默认模型下载目录,记录一下。

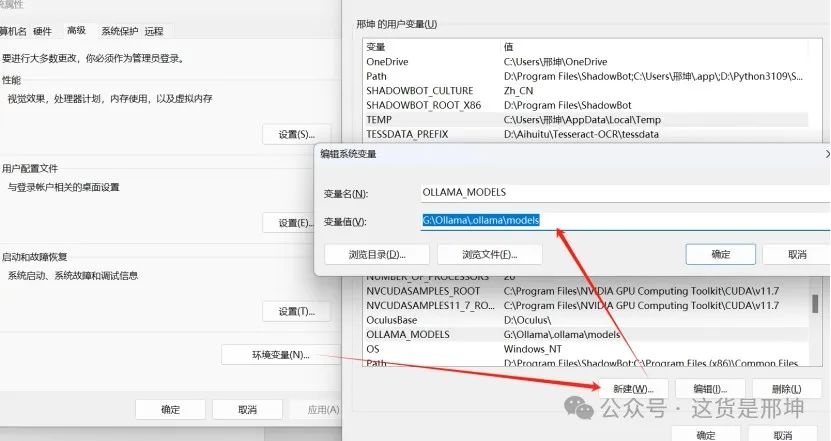

修改模型默认存放位置,新建系统变量。

OLLAMA_MODELS

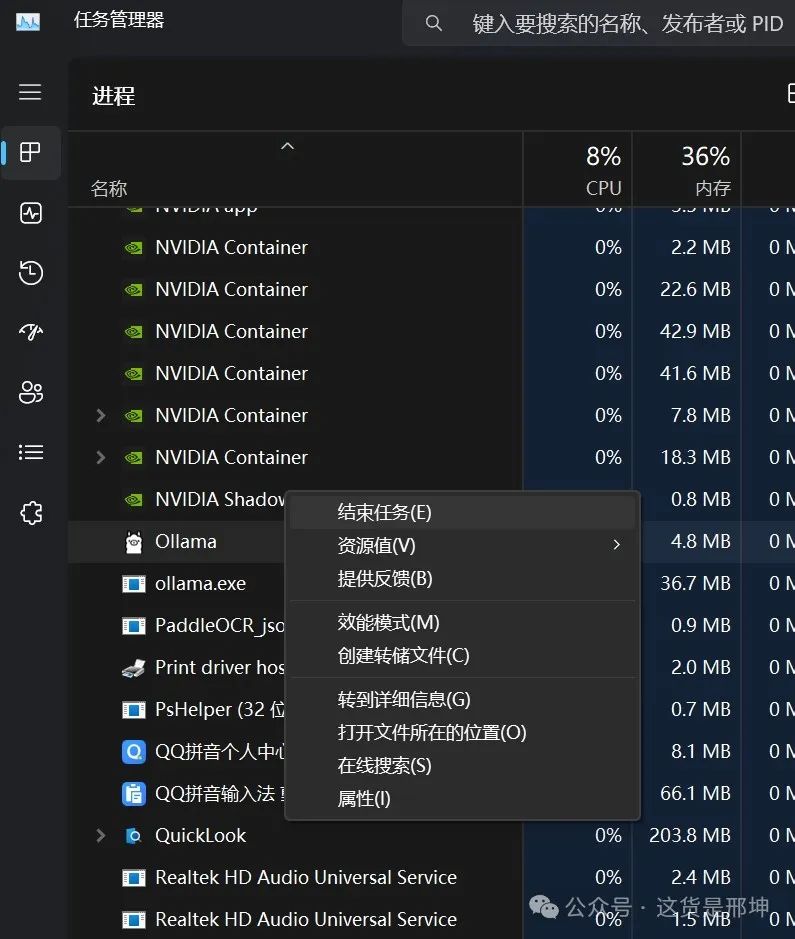

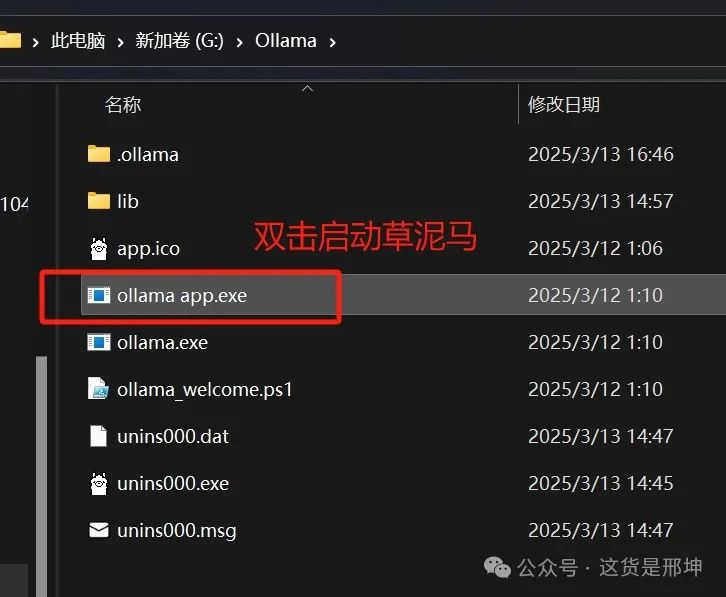

迁移ollama程序

迁移完需要重启ollama程序,可以在根目录双击exe程序启动,也可以直接在cmd里run模型启动。

最后的最后

感谢你们的阅读和喜欢,作为一位在一线互联网行业奋斗多年的老兵,我深知在这个瞬息万变的技术领域中,持续学习和进步的重要性。

为了帮助更多热爱技术、渴望成长的朋友,我特别整理了一份涵盖大模型领域的宝贵资料集。

这些资料不仅是我多年积累的心血结晶,也是我在行业一线实战经验的总结。

这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。如果你愿意花时间沉下心来学习,相信它们一定能为你提供实质性的帮助。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?