matlab R2024a以上

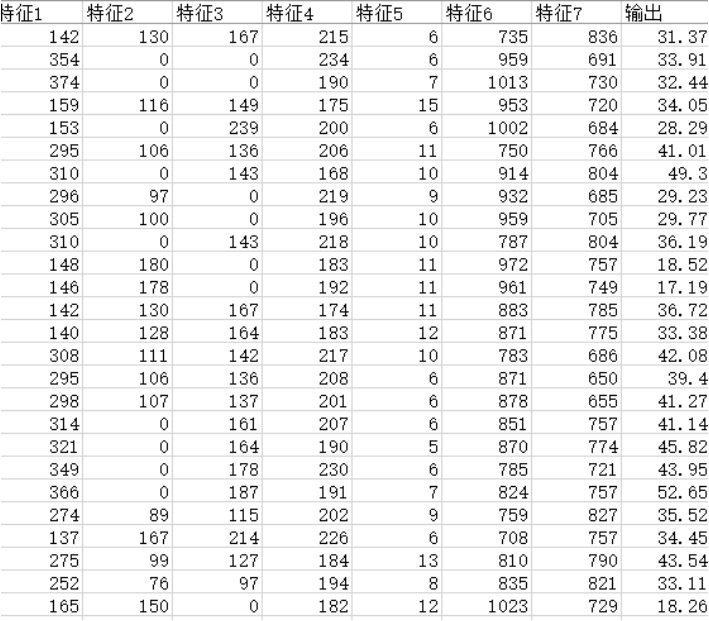

一、数据集

二、霜冰优化算法RIME

2023 年,H Su 等人受到自然界霜冰生长机制启发,提出了霜冰优化算法(Rime Optimization Algorithm, RIME)。

霜冰优化算法(RIME,Frost and Ice Melting Optimization Algorithm)是一种新型的群体智能优化算法。该算法模拟了自然界中霜和冰的形成及融化过程,主要用于解决复杂的优化问题。以下是霜冰优化算法的主要特点和工作原理。

霜冰优化算法的特点

- 启发式策略:该算法通过模仿霜和冰的动态变化过程,利用启发式策略来探索和开发搜索空间,寻找全局最优解。

- 多样性维护:通过模拟霜和冰在不同温度下的形成和融化过程,算法能够维持种群的多样性,避免陷入局部最优。

- 参数少:RIME算法的参数较少,便于调试和应用。

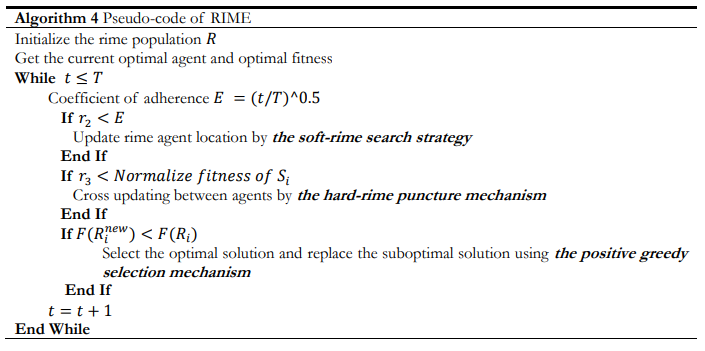

霜冰优化算法的伪代码

霜冰优化算法的优势

- 全局搜索能力强:通过模拟霜和冰的形成及融化过程,算法能够在全局范围内搜索最优解,避免陷入局部最优。

- 适应性强:能够处理各种复杂的优化问题,包括多峰值问题和高维问题。

- 易于实现:算法结构简单,易于理解和实现,且参数调节较少,便于在实际问题中应用。

应用领域

霜冰优化算法可以应用于多个领域,包括但不限于:

- 工程优化:如结构优化、参数优化等。

- 机器学习:用于优化神经网络的参数和超参数。

- 数据挖掘:用于特征选择和数据聚类。

- 资源调度:如生产调度、任务分配等。

霜冰优化算法通过模拟自然界的霜和冰的形成与融化过程,提供了一种新的优化策略,具有良好的全局搜索能力和适应性,适用于解决多种复杂的优化问题。

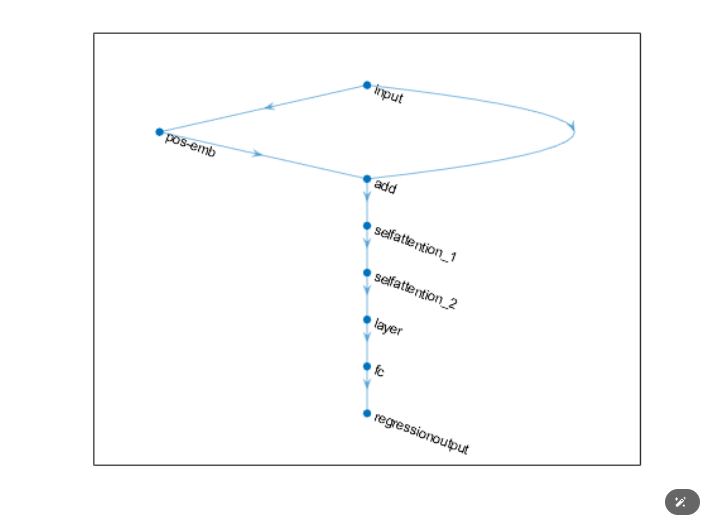

三、Transformer模型

Transformer模型是一种用于处理序列数据的深度学习模型,最初由Vaswani等人在2017年提出。它在自然语言处理(NLP)领域取得了巨大的成功,并成为许多语言模型的基础,如BERT、GPT系列等。以下是Transformer模型的详细介绍:

Transformer模型由编码器(Encoder)和解码器(Decoder)两部分组成,每一部分都由多个层(Layers)堆叠而成。每一层包括两个主要组件:多头自注意力机制(Multi-Head Self-Attention Mechanism)和前馈神经网络(Feed-Forward Neural Network)。

编码器

编码器负责将输入序列转换为一组隐含表示(Hidden Representations)。每个编码器层包括:

- 多头自注意力机制(Multi-Head Self-Attention):通过计算输入序列中每个位置的自注意力分数,捕捉输入序列的全局依赖关系。

- 前馈神经网络(Feed-Forward Neural Network):对每个位置的隐含表示进行非线性变换,增强模型的表达能力。

- 残差连接和层归一化(Residual Connection and Layer Normalization):这些技术帮助训练更深的网络,保持梯度稳定。

解码器

解码器负责生成输出序列,每个解码器层包括:

- 掩蔽多头自注意力机制(Masked Multi-Head Self-Attention):类似于编码器的自注意力机制,但只关注之前生成的输出位置,防止信息泄露。

- 编码器-解码器注意力机制(Encoder-Decoder Attention):将解码器的隐含表示与编码器的隐含表示进行结合,捕捉输入与输出之间的依赖关系。

- 前馈神经网络和残差连接、层归一化:与编码器相同。

关键组件

- 注意力机制(Attention Mechanism):Transformer模型的核心,通过计算查询(Query)、键(Key)和值(Value)之间的点积注意力分数来实现。注意力机制允许模型在处理当前位置时关注整个序列,从而捕捉长距离依赖关系。

- 多头注意力(Multi-Head Attention):通过将注意力机制扩展为多个头(Heads),模型可以在不同的子空间中并行计算注意力,从而捕捉更丰富的特征。

- 位置编码(Positional Encoding):由于Transformer不包含循环神经网络(RNN)或卷积神经网络(CNN)等顺序信息处理机制,位置编码用于为输入序列中的每个位置添加顺序信息。

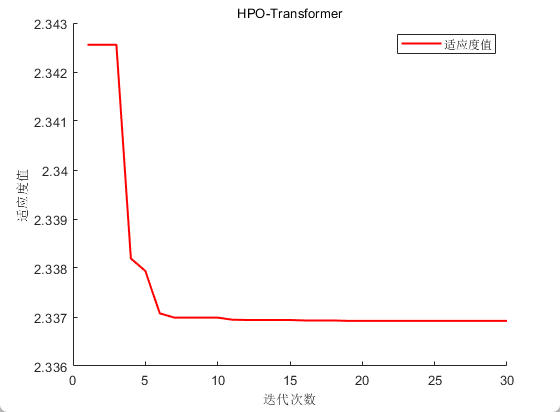

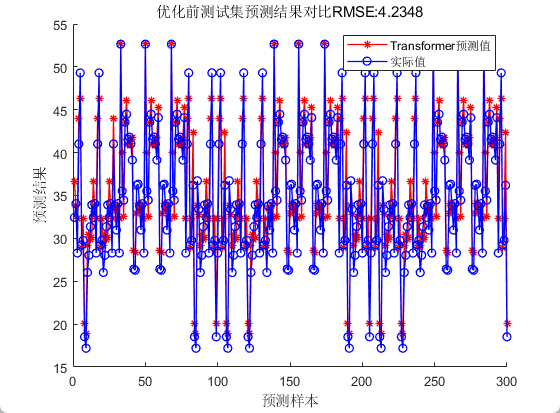

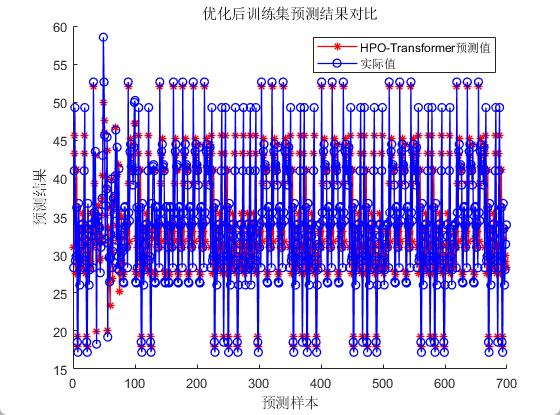

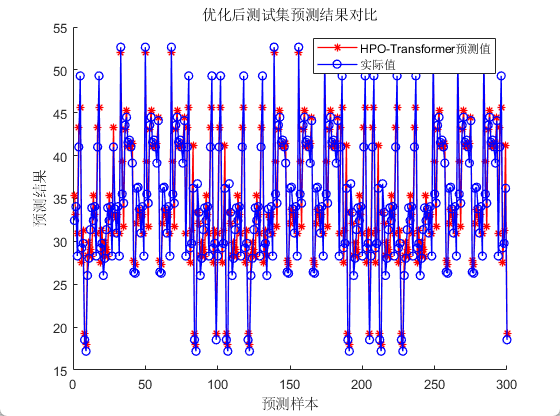

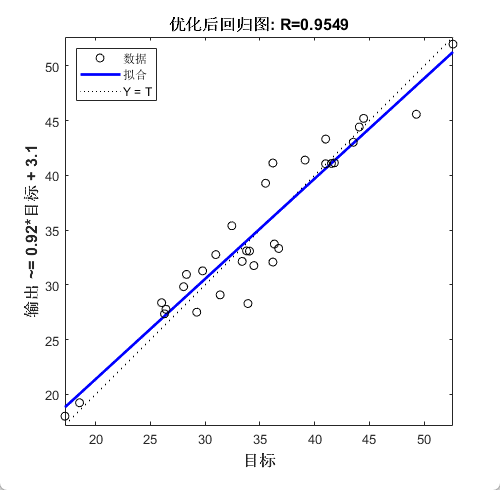

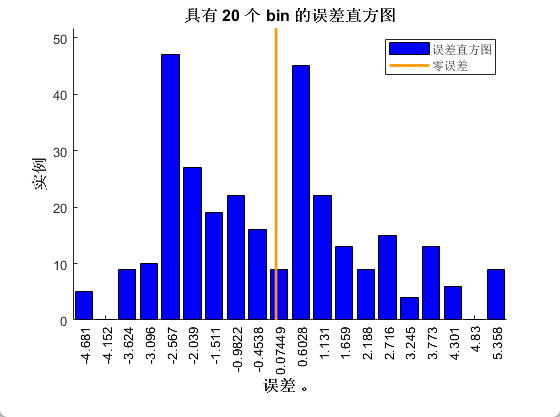

四、效果展示

五、代码获取

感兴趣的朋友可以关注最后一行

% 参数设置

options0 = trainingOptions('adam', ...

'Plots','none', ...

'MaxEpochs', 100, ...

'MiniBatchSize', 32, ...

'Shuffle', 'every-epoch', ...

'InitialLearnRate', 0.01, ...

'L2Regularization', 0.002, ... % 正则化参数

'ExecutionEnvironment', "auto",...

'Verbose',1);

%% https://mbd.pub/o/bread/mbd-ZpmWmp9u

463

463

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?