PySpark编程环境

PySpark开发环境的搭建:

通过pip命令将pyspark库安装到Python3.6运行环境中:

(◇ 安装pyspark,指定的版本与这里的Spark一致

◇ py4j允许Python动态访问Java对象,Java程序也能够回调Python对象,是Python和Java互操作的一个中间桥梁)

测试

打开一个Linux终端并输入python命令进入Python3.6交互编程环境(python3命令对应默认安装的Python3.8,python命令被设置为对应Python3.6)。

◇ 切换到当前主目录,如已进入则忽略

◇ python链接指向的是python3.6执行程序,故运行python或python3.6命令是等价的

◇ pyspark库是通过pip命令安装的,针对的是Python3.6语言环境。pip3命令对应Python3.8语言环境

然后接着输入下面的代码片段进行测试:

◇ pyspark即为安装的pyspark库

◇ SparkContext意为Spark上下文,参数'local[1]'表示在本地1个cpu核上运行,第二个参数是给这一段应用程序设置的名字

◇ Spark的大部分功能都是通过sc对象来调用的

Ctrl+D退出

Jupyter Notebook编程环境

安装Jupyter Notebook 和findspark

按以下步骤开始Jupyter Notebook的安装过程:

◇ 切换到当前主目录,如已进入则忽略

◇ 通过pip安装jupyter库,需要一点时间

安装findspark库,其作用是使pyspark库在Jupyter Notebook网页像一个正常Python模块那样导入使用。

启动Jupyter Notebook,这是一个Web网页应用,因此会自动打开一个浏览器来显示网页界面。

◇ 切换到当前主目录,如已进入则忽略

◇ jupyter是一个执行程序,notebook代表打开一个“笔记本”

测试

稍候片刻,浏览器中会显示Jupyter Notebook的初始界面:

在Jupyter Notebook页面中编写代码的方式,与普通的python编程环境中基本一样,唯一不同的是,在代码执行之前,必须先运行一次findspark.init()方法,只需在当前Jupyter Notebook页面中执行一次即可,不用重复执行。

初始化代码,协助pyspark库导入

测试pyspark库的导入

使用pyspark库编写代码

PyCharm集成开发环境

安装PyCharm

执行下面的命令将PyCharm安装包文件解压到/usr/local目录,然后切换到安装目录,执行bin目录下面的pycharm.sh脚本启动PyCharm集成开发环境。

放入文件:

新打开一个终端

◇ 切换到/usr/local主目录,准备安装到这个位置

◇ 切换到/usr/local/pycharm-community-2022.3.1/主目录

◇ 启动pycharm.sh脚本程序

随后会显示一个接受用户使用条款的窗体,勾选同意并继续。

配置PyCharm

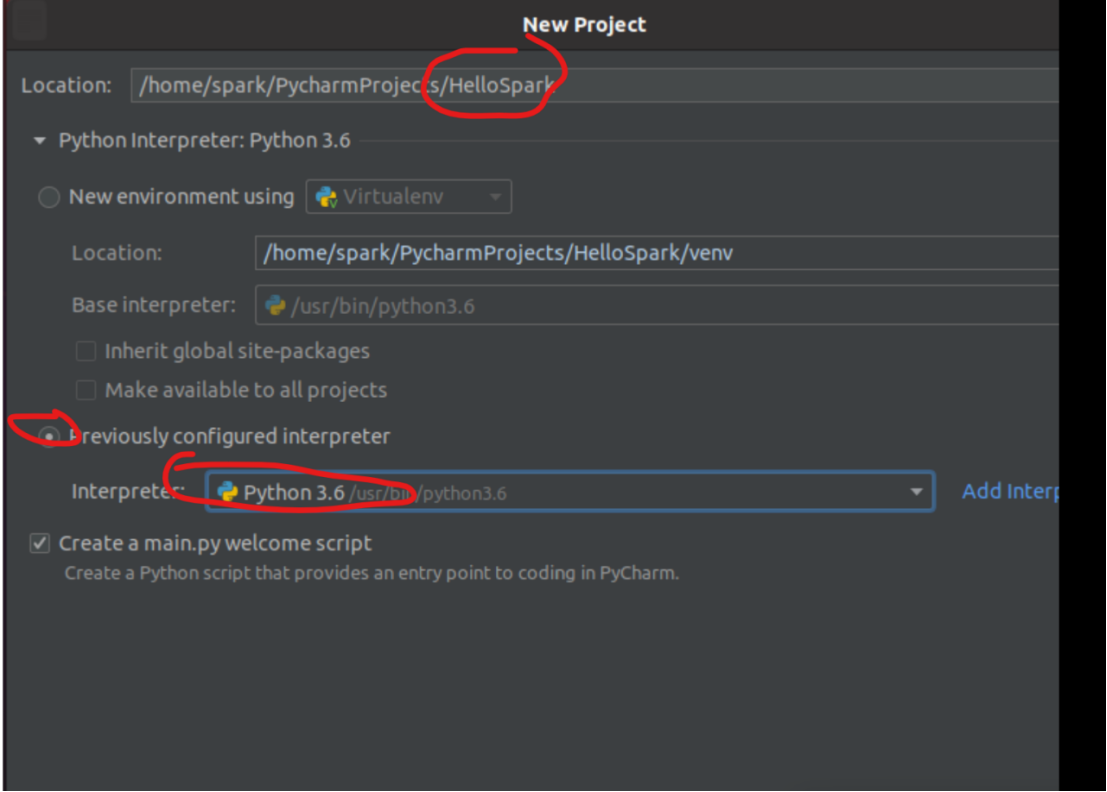

选择PyCharm初始化窗体左侧的Projects选项,然后单击右侧的New Project按钮启动新建Python项目,项目创建完毕,PyCharm会切换至项目开发窗体。

Interpreter改为3.6版本

Enter进入

清除main.py原有代码,写入以下spark测试代码

测试

运行main.py

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?