LLM安全:探索大型语言模型的安全挑战与防御策略

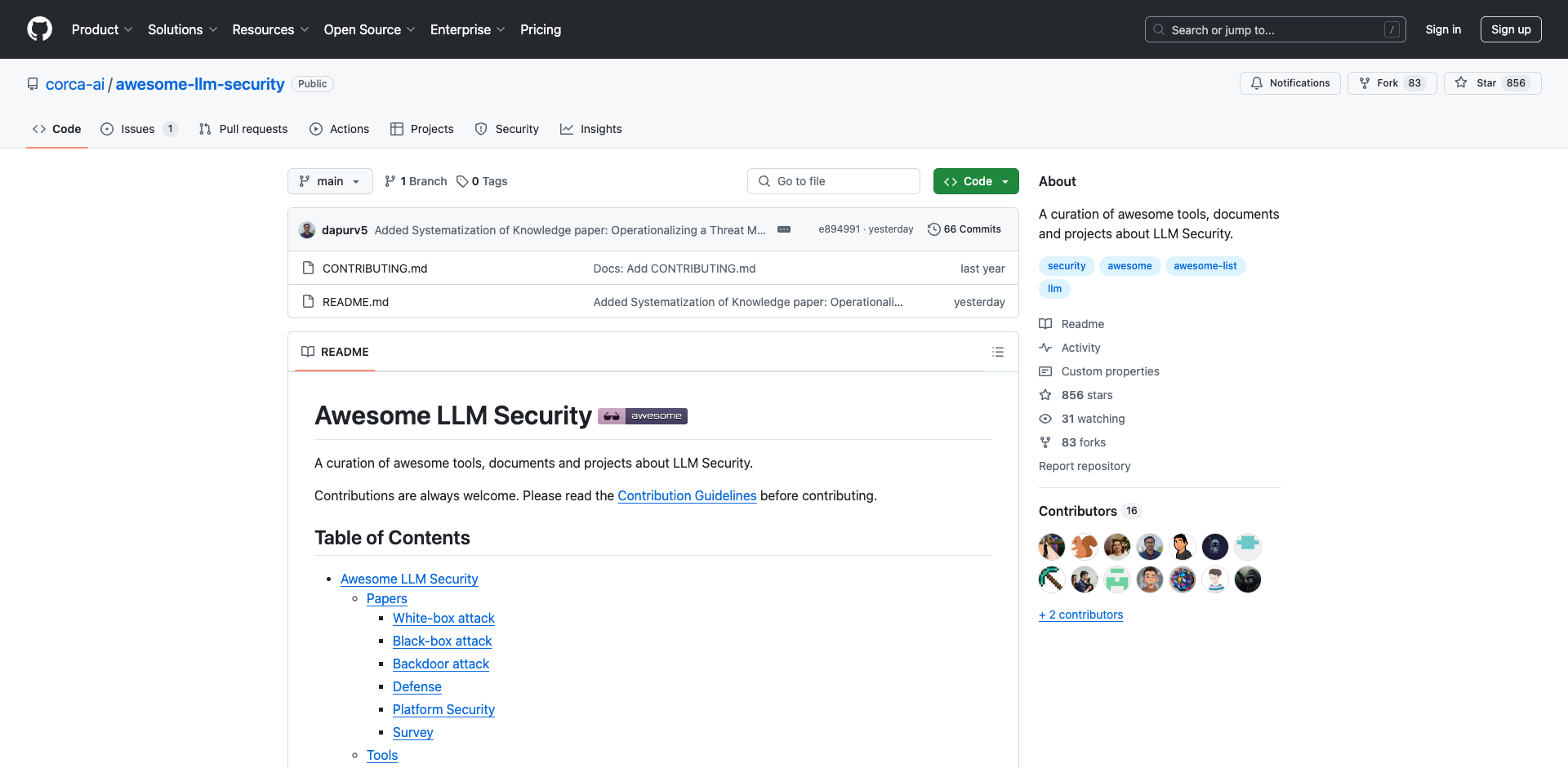

近年来,随着ChatGPT等大型语言模型(LLM)的迅速发展和广泛应用,LLM安全问题也日益引起学术界和产业界的关注。本文将全面介绍LLM安全领域的最新研究进展、实用工具和相关资源,为读者提供一个全面的LLM安全概览。

LLM面临的主要安全威胁

提示注入攻击

提示注入是目前LLM面临的最主要安全威胁之一。攻击者通过精心设计的提示,可以绕过LLM的安全限制,使其产生有害或不当的输出。例如:

- 白盒攻击:通过分析LLM的内部结构设计攻击提示

- 黑盒攻击:通过反复尝试找到有效的攻击提示

- 间接提示注入:利用外部数据源进行攻击

研究人员提出了多种提示注入攻击方法,如Universal and Transferable Adversarial Attacks、AutoDAN等。这些方法可以有效地绕过LLM的安全机制,产生有害输出。

后门攻击

后门攻击是指攻击者在LLM训练阶段植入后门,使模型在特定输入下产生预设的错误输出。相关研究包括:

- BITE:通过迭代触发器注入实现文本后门攻击

- 虚拟提示注入:在指令微调阶段注入后门

后门攻击难以检测,对LLM的长期安全构成严重威胁。

模型窃取

随着开源LLM的兴起,模型窃取也成为一个新的安全问题。攻击者可能通过API访问或其他方式,尝试重建或窃取专有LLM模型。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

552

552

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?