点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

01

MiniCPM-V: A GPT-4V Level MLLM on Your Phone

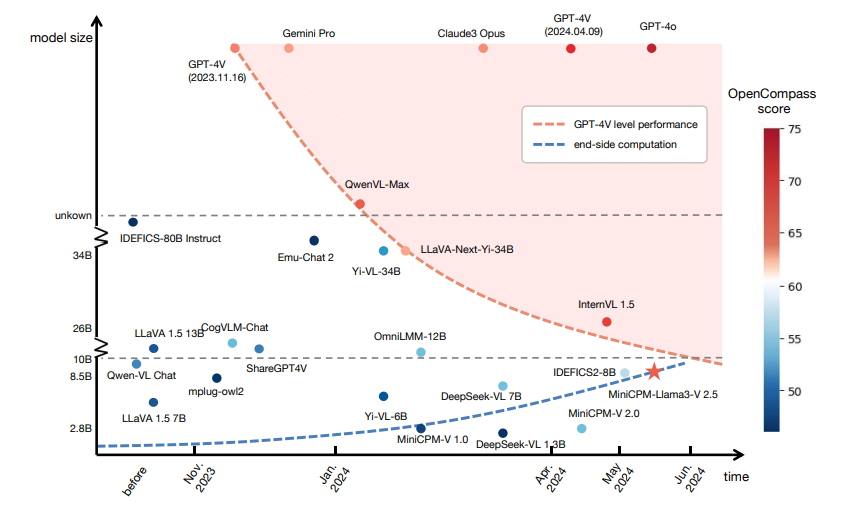

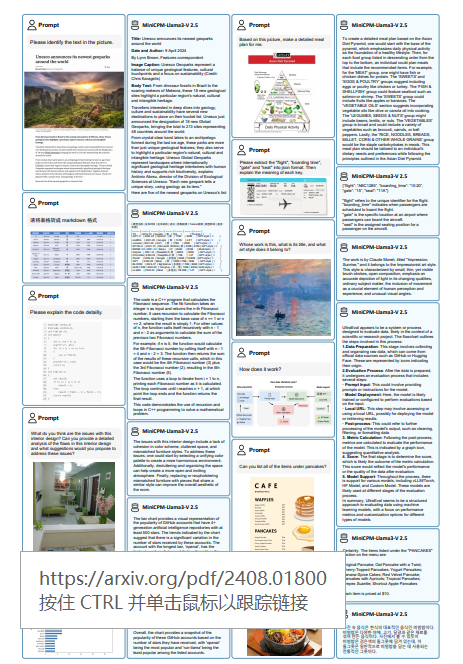

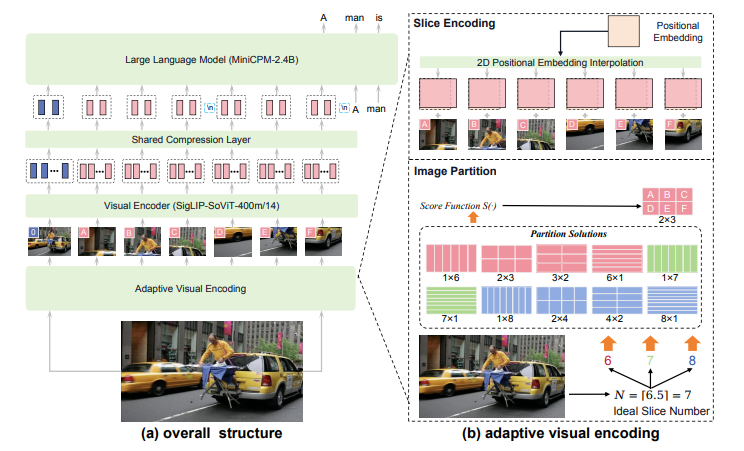

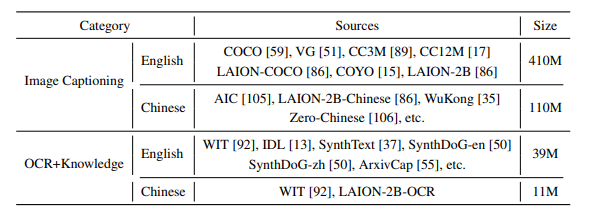

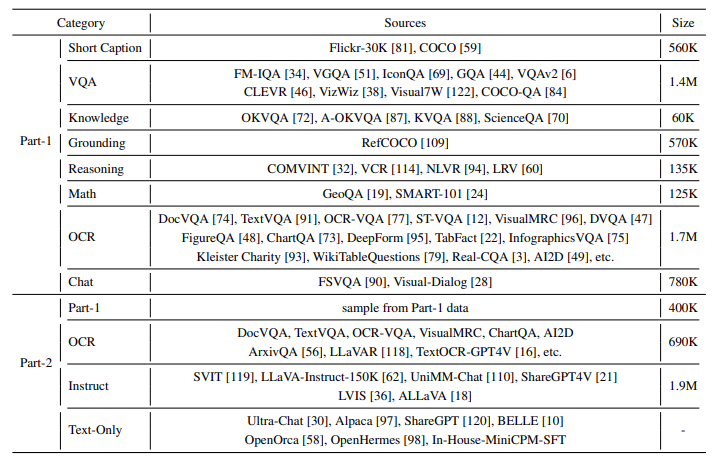

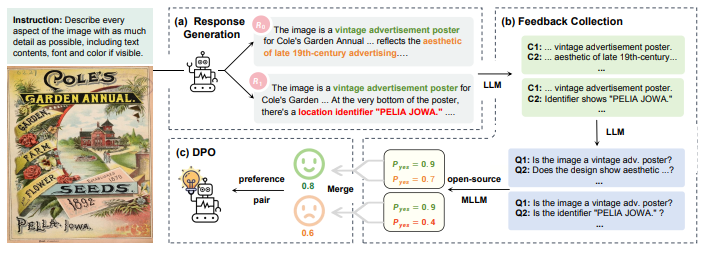

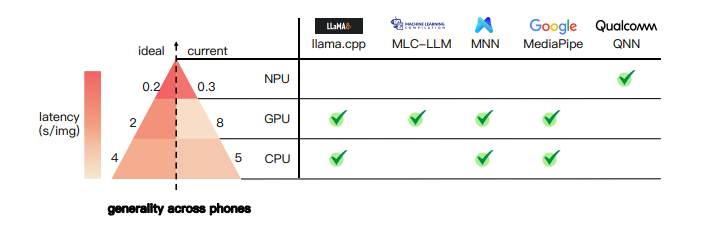

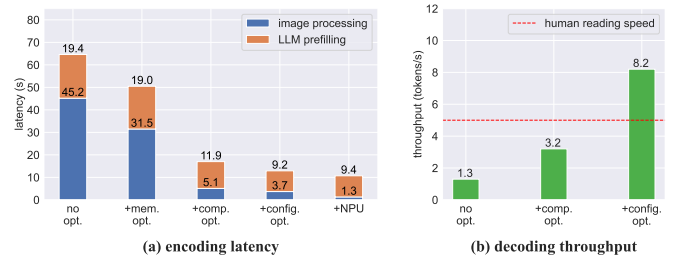

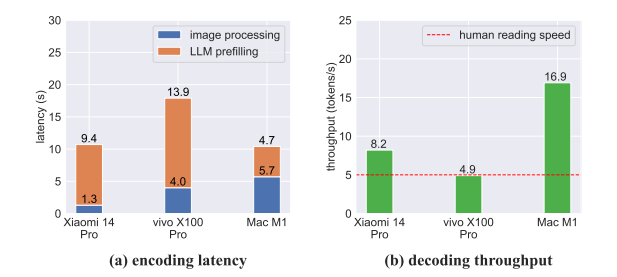

近期多模态大型语言模型(MLLMs)的快速发展,从根本上改变了人工智能研究和产业的格局,为实现人工智能的下一个重要突破指明了充满希望的方向。然而,MLLMs在现实世界应用中仍面临重大挑战。最主要的挑战来自于运行具有庞大参数量和高计算需求的MLLMs所需的巨大成本。因此,大多数MLLMs需要部署在高性能的云服务器上,这在很大程度上限制了它们在移动设备、离线环境、能耗敏感和注重隐私保护的应用场景。在这项研究中,提出了MiniCPM-V,这是一系列可在终端设备上部署的高效MLLMs。通过融合最新的MLLM架构、预训练和对齐技术,最新的MiniCPM-Llama3-V 2.5具备以下几个显著特点:(1) 出色的性能,在OpenCompass上的表现超越了GPT-4V-1106、Gemini Pro和Claude 3,OpenCompass是一个覆盖11个流行基准测试的全面评估平台;(2) 强大的OCR能力,能够处理任何纵横比下的180万像素高分辨率图像;(3) 可信的行为表现,低幻觉率;(4) 支持30多种语言;(5) 可在手机上高效部署。更重要的是,MiniCPM-V可以看作是一种有希望趋势的代表(见图1):实现可用性能(例如GPT-4V级别)所需的模型尺寸正在迅速减小,同时终端计算能力也在迅速增长。这表明,在终端设备上部署GPT-4V级别的MLLMs正变得越来越可行,预示着在不久的将来将有更广泛的现实世界AI应用被解锁。

文章链接:

https://arxiv.org/pdf/2408.01800

02

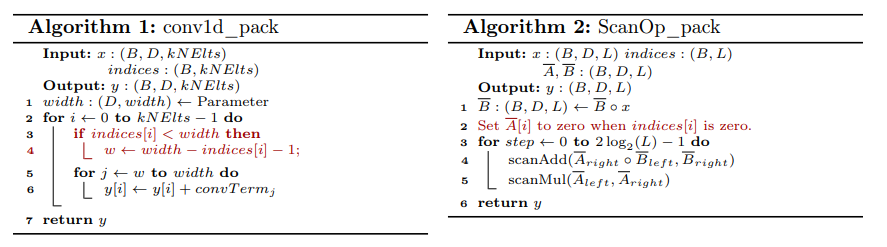

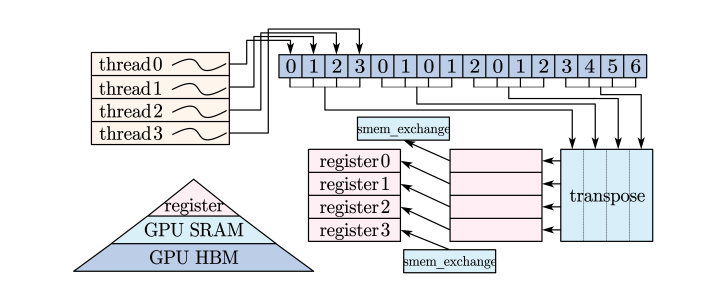

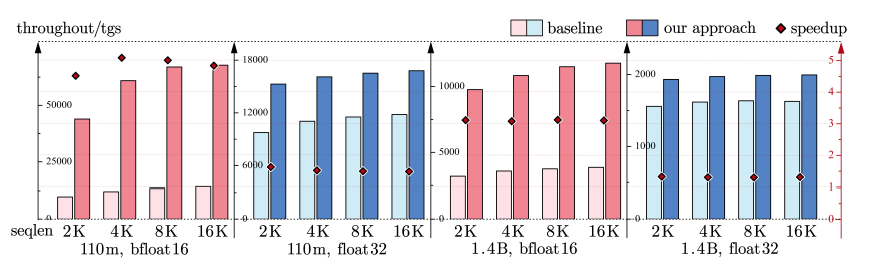

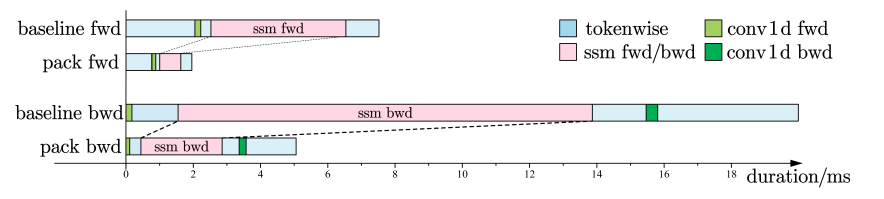

PackMamba: Efficient Processing of Variable-Length Sequences in Mamba training

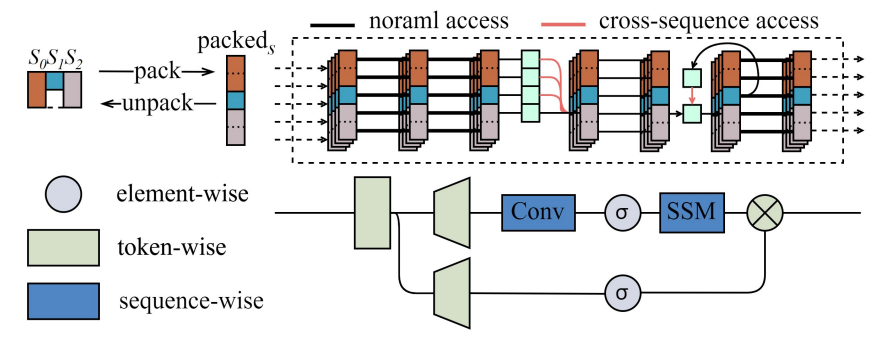

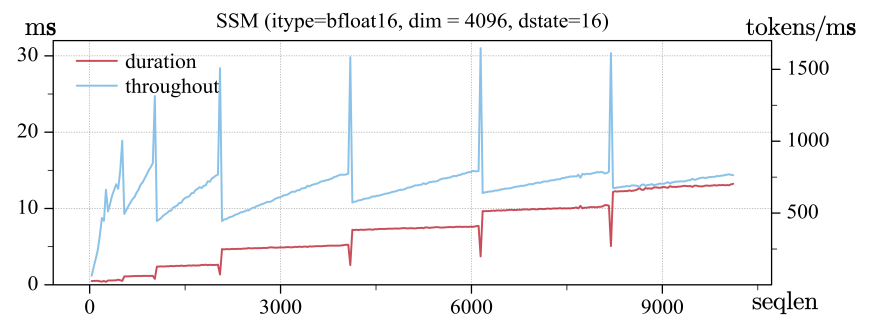

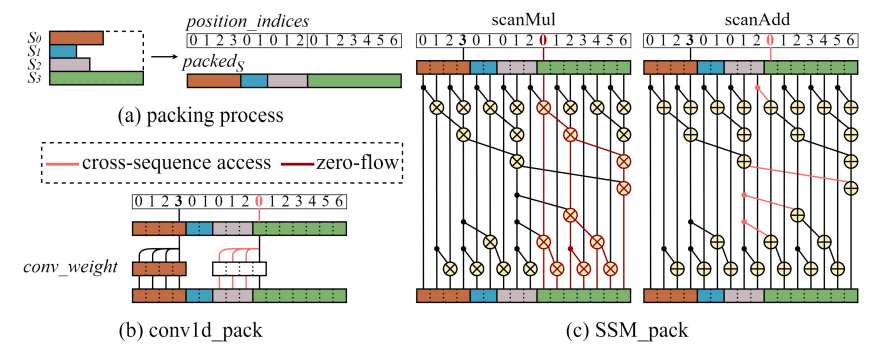

随着大型语言模型的发展,由于计算量与序列长度呈二次方增长,传统的Transformer模型在处理长序列时变得计算密集。Mamba作为生成人工智能领域的一项创新架构,显示出在降低计算和内存复杂性的同时,有效处理长序列的能力。然而,Mamba的现有训练框架在处理可变长度序列输入时存在效率问题。单一序列训练导致GPU利用率不足,或者将可变长度序列批量处理至固定最大长度则会带来显著的内存和计算负担。为了解决这个问题,研究者分析了Mamba在不同张量形状下的瓶颈操作性能,并提出了PackMamba,这是一个高吞吐量的Mamba变体,能够高效地处理可变长度序列。深入探究状态空间模型(SSMs),研究者改进了并行操作,避免在序列间传递信息,同时维持了高性能。通过软硬件协同优化,这一改进确保了对位置索引的连续内存访问,避免了额外的核心开销。在NVIDIA A100 GPU上的实验结果显示,与基线单序列处理方案相比,吞吐量得到了显著提升:1.4B模型的速度提升了3.06倍,2.8B模型的速度提升了2.62倍。

文章链接:

https://arxiv.org/pdf/2408.03865

03

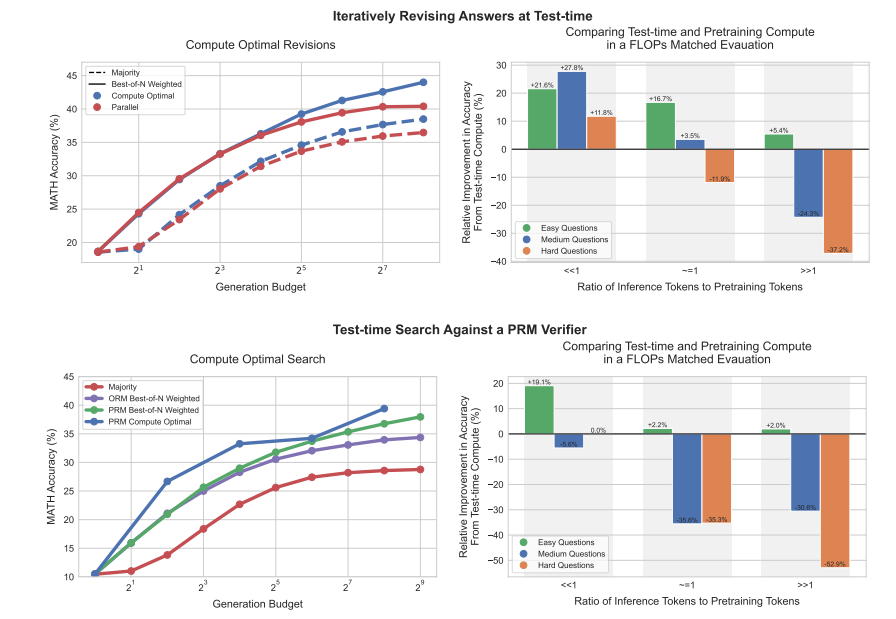

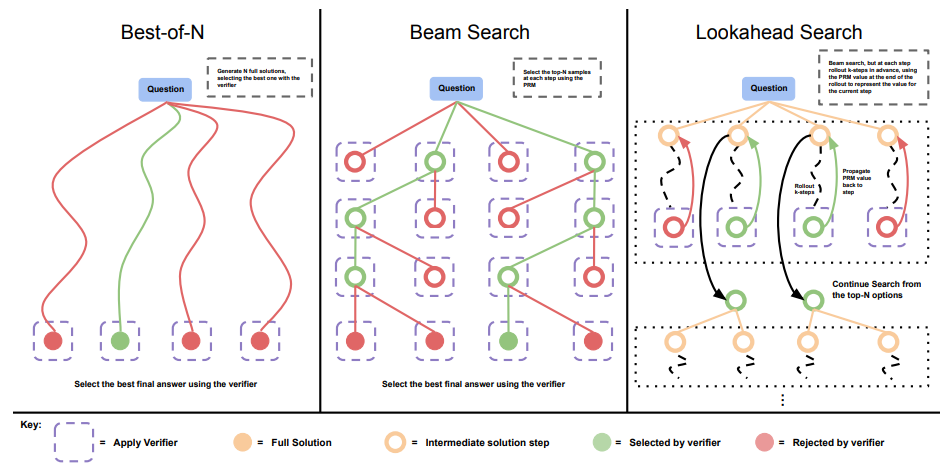

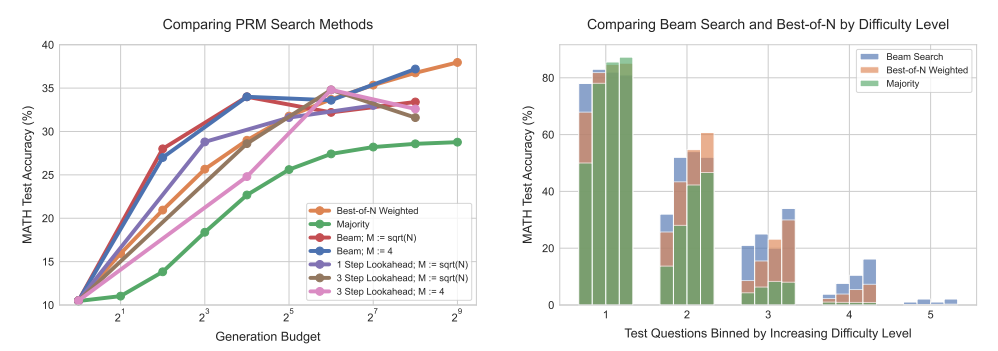

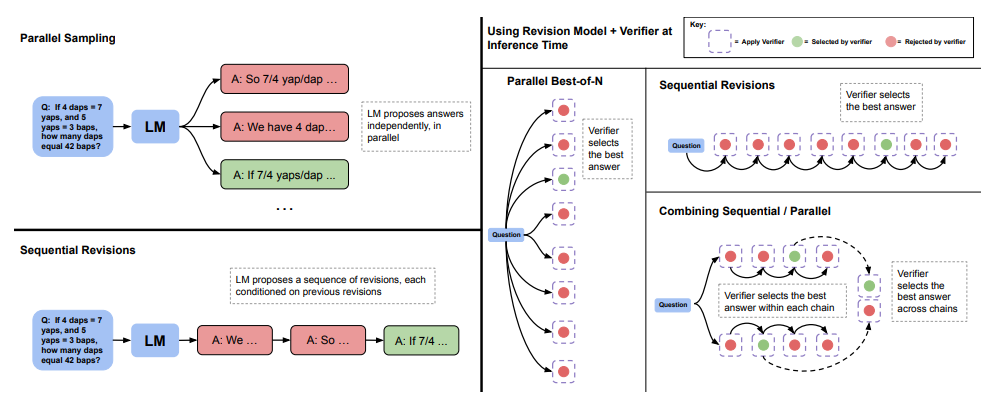

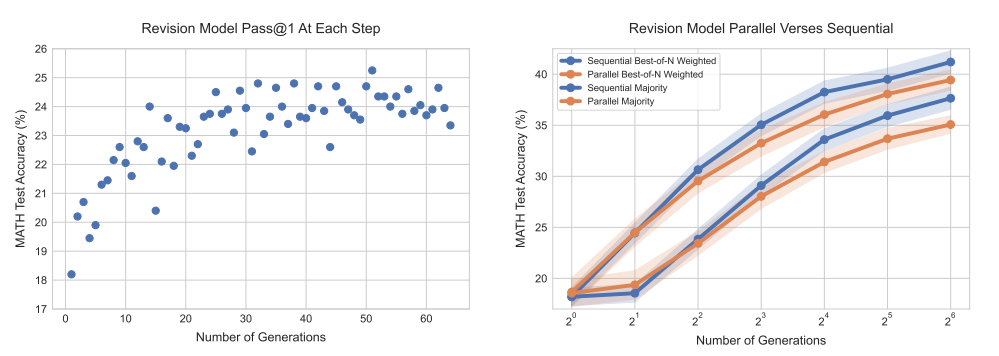

Scaling LLM Test-Time Compute Optimally can be More Effective than Scaling Model Parameters

使大型语言模型(LLMs)能够通过使用更多的测试时计算来改进其输出,是构建能够处理开放式自然语言的通用自我改进代理的关键一步。在本文中,研究了LLMs在推理时计算的扩展,重点关注回答以下问题:如果允许LLM使用固定但非平凡的推理时计算量,它能在应对具有挑战性的提示时将性能提高多少?回答这个问题不仅对LLMs可达到的性能有影响,而且对未来的LLM预训练以及如何在推理时间和预训练计算之间进行权衡也有影响。尽管这个问题很重要,但很少有研究尝试理解各种测试时推理方法的扩展行为。此外,目前的工作主要为这些策略中的许多提供了负面结果。在这项工作中,分析了两种主要的扩展测试时计算的机制:(1) 针对基于处理的密集验证者奖励模型进行搜索;(2) 根据测试时的提示,适应性地更新模型对响应的分布。发现在这两种情况下,不同方法扩展测试时计算的有效性关键地取决于提示的难度。这一观察激发了应用一种“计算最优”的扩展策略,该策略能够最有效地适应性地为每个提示分配测试时计算。使用这种计算最优策略,我们可以将测试时计算扩展的效率提高4倍以上,与N个最佳基线相比。此外,在FLOPs匹配的评估中,发现在较小的基础模型获得某种非平凡成功率的问题上,可以使用测试时计算来超越一个大14倍的模型。

文章链接:

https://arxiv.org/pdf/2408.03314

04

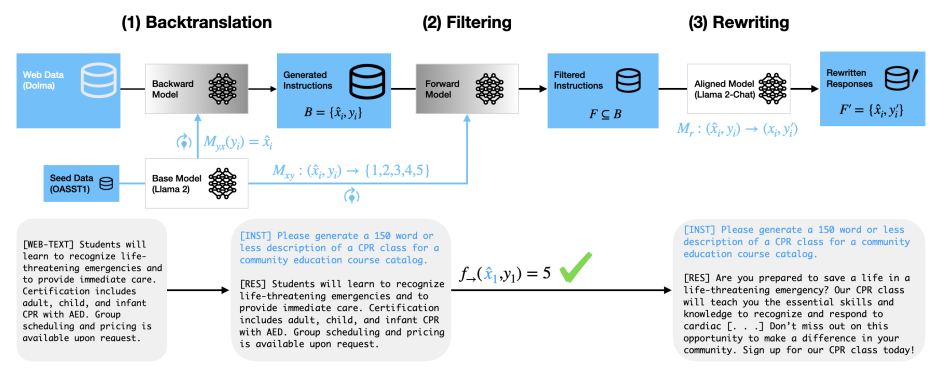

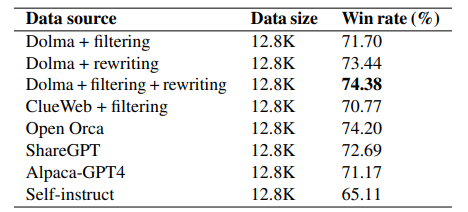

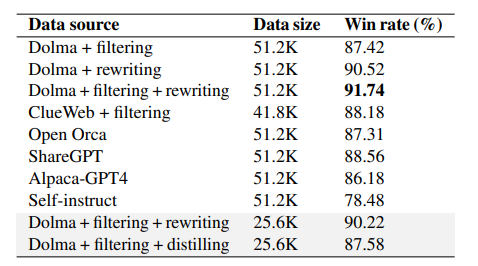

Better Alignment with Instruction Back-and-Forth Translation

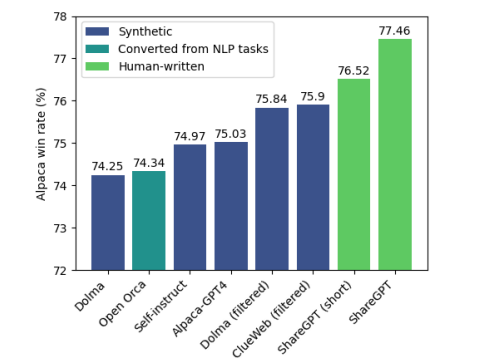

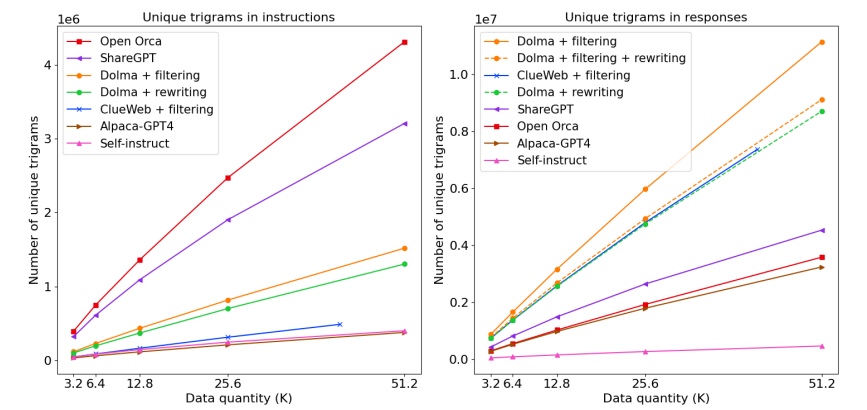

本文提出了一种新的方法,即指令来回翻译,用于构建基于世界知识构建高质量的合成数据,以对齐大型语言模型(LLMs)。给定来自网络语料库的文档,使用Li等人(2023a)提出的回翻译方法生成和策划合成指令,并根据初始文档进一步改写响应以提高其质量。使用生成的(回翻译指令,改写响应)对进行微调,在AlpacaEval上的胜率高于使用其他常见的指令数据集,如Humpback、ShareGPT、Open Orca、AlpacaGPT4和Self-instruct。研究还表明,使用LLM重写响应的表现优于直接蒸馏,且两种生成的文本分布在嵌入空间中表现出显著差异。进一步的分析显示,来回翻译指令的质量优于其他合成指令来源,而该方法的响应比蒸馏得到的响应更加多样化和复杂。总体而言,作者发现指令来回翻译结合了两个世界的优点——利用网络上发现的信息多样性和数量,同时确保响应的质量,这对于有效的对齐是必要的。

文章链接:

https://arxiv.org/pdf/2408.04614

05

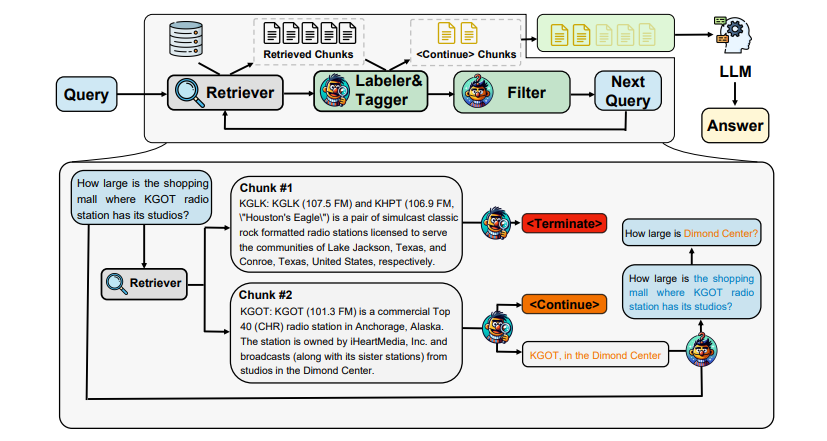

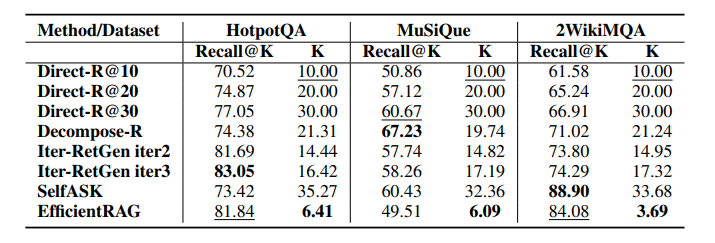

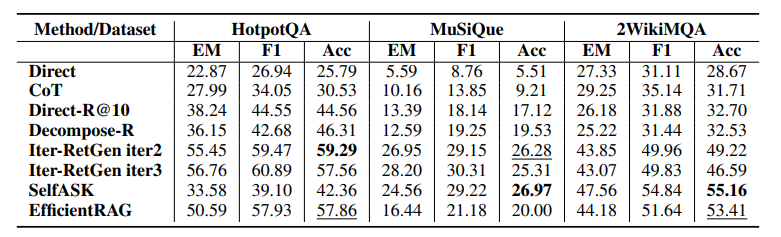

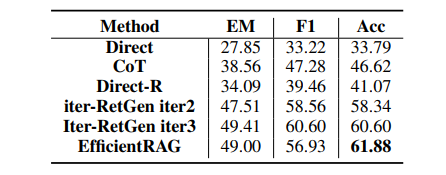

EfficientRAG: Efficient Retriever for Multi-Hop Question Answering

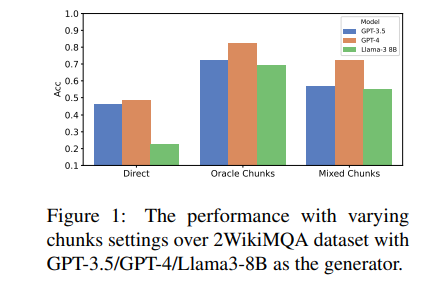

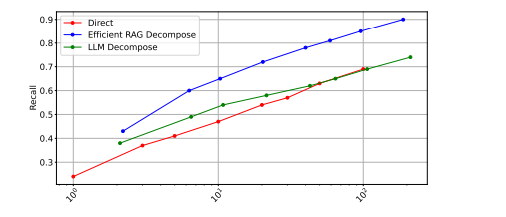

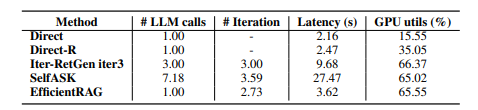

检索增强生成(RAG)方法在处理复杂问题,如多跳查询时遇到难题。虽然迭代检索方法通过收集额外信息提高了性能,但当前方法通常依赖于多次调用大型语言模型(LLMs)。在本文中,介绍了EfficientRAG,一种用于多跳问答的高效检索器。EfficientRAG通过迭代生成新查询,无需在每次迭代中调用LLMs,同时过滤掉不相关信息。实验结果表明,EfficientRAG在三个开放域多跳问答数据集上超越了现有的RAG方法。

文章链接:

https://arxiv.org/pdf/2408.04259

06

From Data to Story: Towards Automatic Animated Data Video Creation with LLM-based Multi-Agent Systems

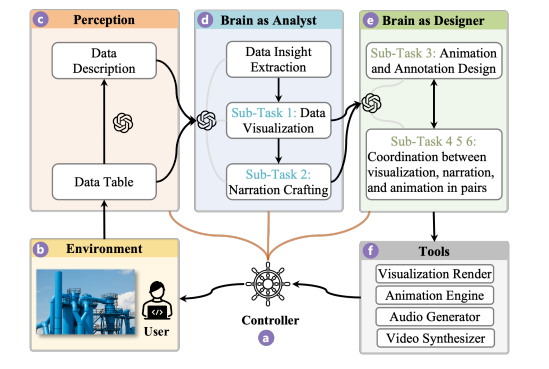

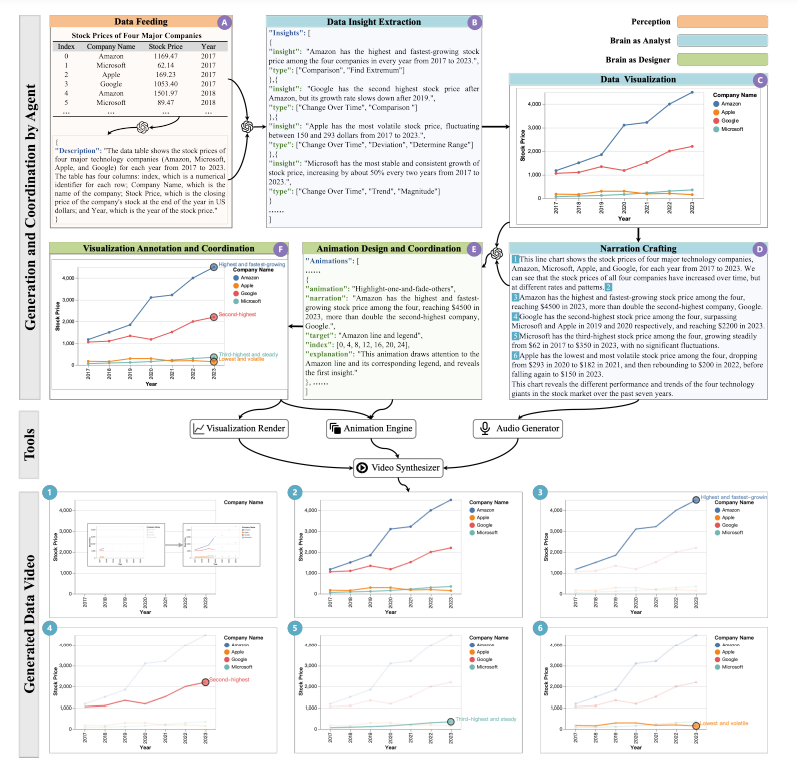

从原始数据中创建数据故事是一项挑战,因为人类的注意力有限,且需要专业技能。近期在大型语言模型(LLMs)方面的进步为开发具有自主代理的系统提供了巨大机会,以简化数据故事讲述的工作流程。尽管多代理系统具有诸如完全实现LLM潜力、为各个代理分解任务等优点,但设计这类系统也面临着任务分解、子任务性能优化和工作流程设计的挑战。为了更好地理解这些问题,作者开发了Data Director,这是一个基于LLM的多代理系统,旨在自动化创建动画数据视频——数据故事的一个代表性类型。Data Director解释原始数据,分解任务,设计代理角色以自动做出明智决策,并无缝集成数据视频的不同组成部分。一个案例研究证明了Data Director在生成数据视频方面的有效性。在整个开发过程中,从解决挑战中学到了教训,这些教训指导了数据故事讲述中自主代理的进一步发展。本文还展望了全局优化、人在循环中的设计,以及应用先进的多模态LLMs的未来方向。

文章链接:

https://arxiv.org/pdf/2408.03876

07

Scaling Laws for Data Poisoning in LLMs

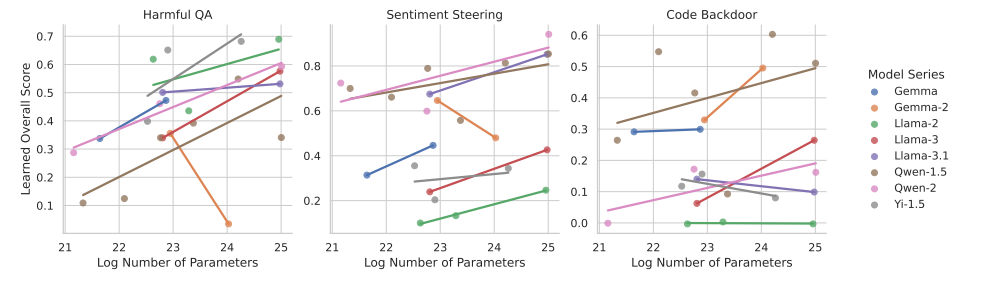

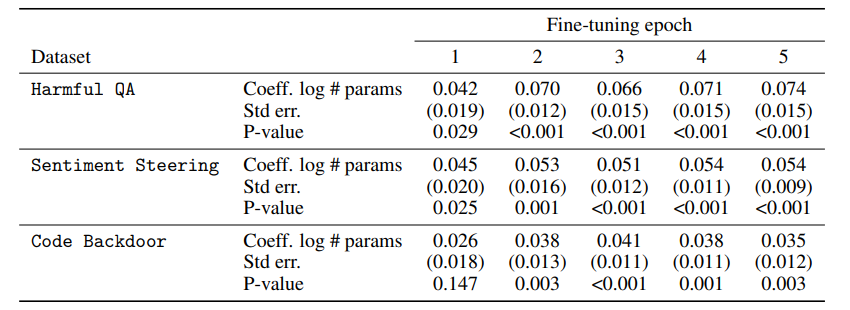

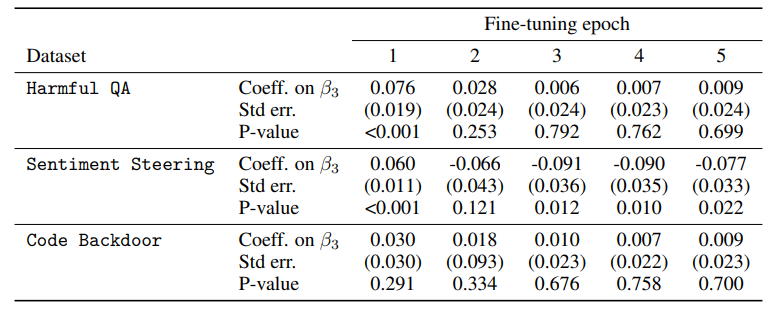

近期的研究表明,大型语言模型(LLMs)容易受到数据投毒的影响,即它们在部分损坏或有害数据上进行训练。投毒数据难以检测,破坏了防护措施,并导致不良和有害的行为。鉴于领先的实验室在训练和部署越来越大、越来越能干的LLMs方面的密集努力,关键的问题是数据投毒的风险是否会自然地被规模所缓解,或者它是否是一个日益增长的威胁。作者考虑了数据投毒可能发生的三种威胁模型:恶意微调、数据管理不完善和故意数据污染。本文的实验评估了数据投毒对23个前沿LLMs的影响,这些模型的参数范围从15亿到720亿,涵盖了三个数据集,分别对应文中的每种威胁模型。作者发现,较大的LLMs越来越容易受到攻击,即使在最小的数据投毒情况下,它们学习有害行为(包括潜伏代理行为)的速度也显著快于较小的LLMs。这些结果强调了对较大的LLMs进行数据投毒防范的强有力的保障措施的必要性。

文章链接:

https://arxiv.org/pdf/2408.02946

本期文章由陈研整理

往期精彩文章推荐

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了1800多位海内外讲者,举办了逾600场活动,超700万人次观看。

我知道你

在看

提出观点,表达想法,欢迎

留言

点击 阅读原文 查看更多!

549

549

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?