点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

转载来源:机器之心(编辑:张倩)

转载请联系出处

80 多篇论文搞懂「机器人+3D」研究进展。

前段时间,多家媒体报道称 ,著名 AI 学者、斯坦福大学教授李飞飞的创业公司 World Labs 在短短三个月内已经完成了两轮融资,其中最新一轮融资中筹到了约 1 亿美元,公司估值已超过 10 亿美元,成为新晋独角兽。

World Labs 的发展方向聚焦于「空间智能」,即开发能够理解三维物理世界的模型,模拟物体的物理特性、空间位置和功能。李飞飞认为「空间智能」是 AI 发展的关键一环,她的团队正在斯坦福大学实验室里训练计算机和机器人在三维世界中采取行动,例如使用大型语言模型让一个机械臂根据口头指令执行开门、做三明治等任务。(详情请参见《李飞飞解读创业方向「空间智能」,让 AI 真正理解世界》)

为了解释「空间智能」这一概念,李飞飞展示了一张猫伸出爪子将玻璃杯推向桌子边缘的图片。她表示,在一瞬间,人类大脑可以评估「这个玻璃杯的几何形状,它在三维空间中的位置,它与桌子、猫和所有其他东西的关系」,然后预测会发生什么,并采取行动加以阻止。

其实,除了李飞飞,现在有很多研究团队都在关注 3D 视觉 + 机器人这一方向。这些团队认为,当前 AI 存在的很多局限都是因为模型缺乏对于 3D 世界的深刻理解。如果要补全这一拼图,势必要在 3D 视觉方向投入更多的研究精力。此外,3D 视觉提供了对环境的深度感知和空间理解能力,这对于机器人在复杂三维世界中的导航、操作和决策至关重要。

那么,有没有一份系统的研究资料可以供这一方向的研究者参考呢?机器之心最近就找到了一份:

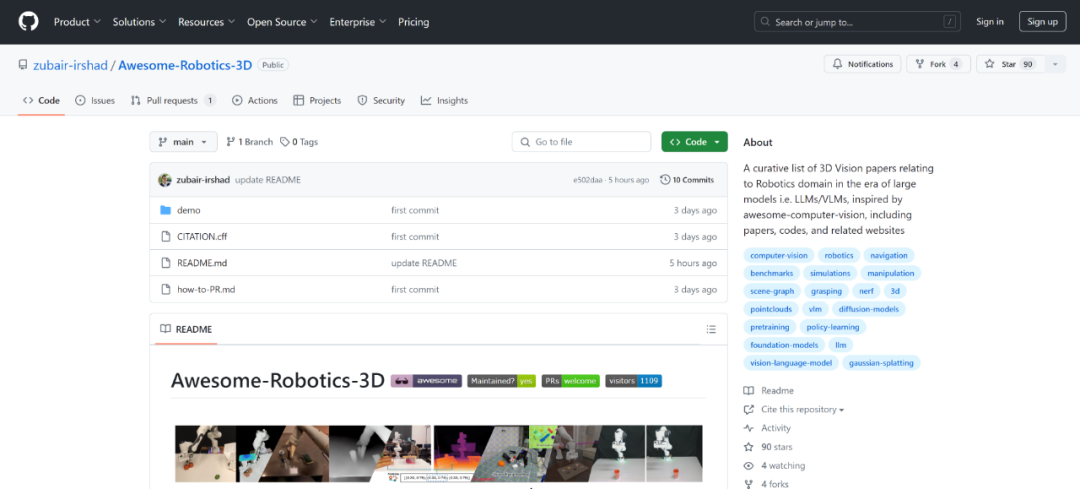

项目链接:https://github.com/zubair-irshad/Awesome-Robotics-3D

这个名叫「Awesome-Robotics-3D」的 GitHub 存储库总共收集了 80 多篇「3D 视觉 + 机器人」方向的论文,大部分论文都给出了相应的论文、项目、代码链接。

这些论文可以分为以下几个主题:

策略学习

预训练

VLM 和 LLM

表示

模拟、数据集和基准

这些论文既有 arXiv 预印本,也有 RSS、ICRA、IROS、CORL 等机器人学顶会以及 CVPR、ICLR、ICML 等计算机视觉、机器学习领域的顶会论文,含金量非常高。

每部分的论文列表如下:

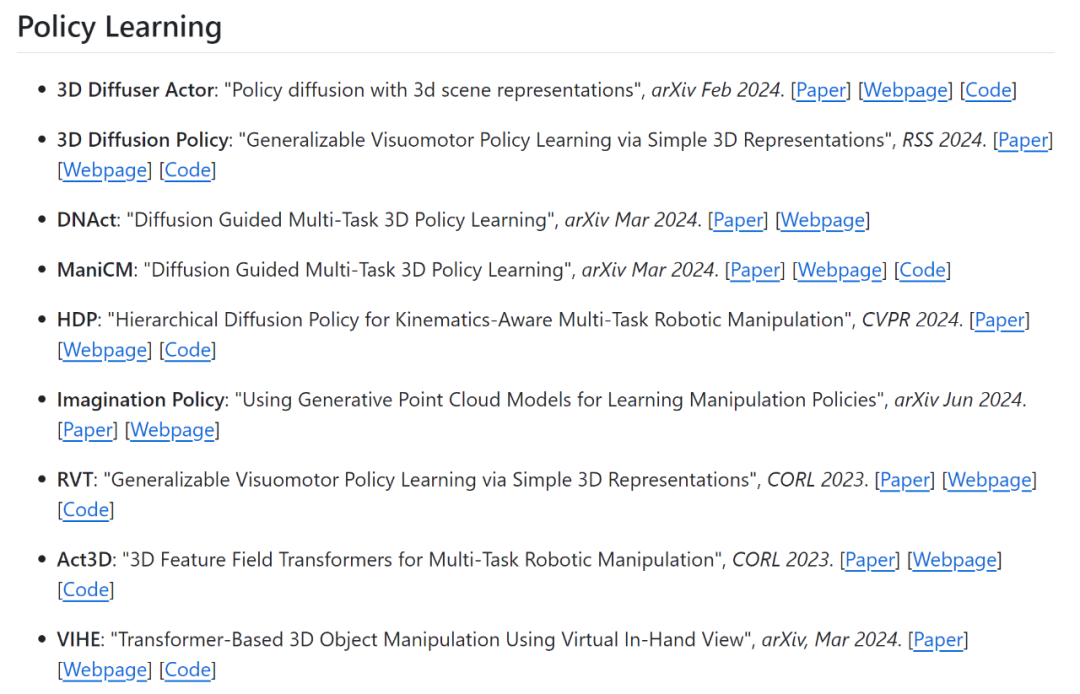

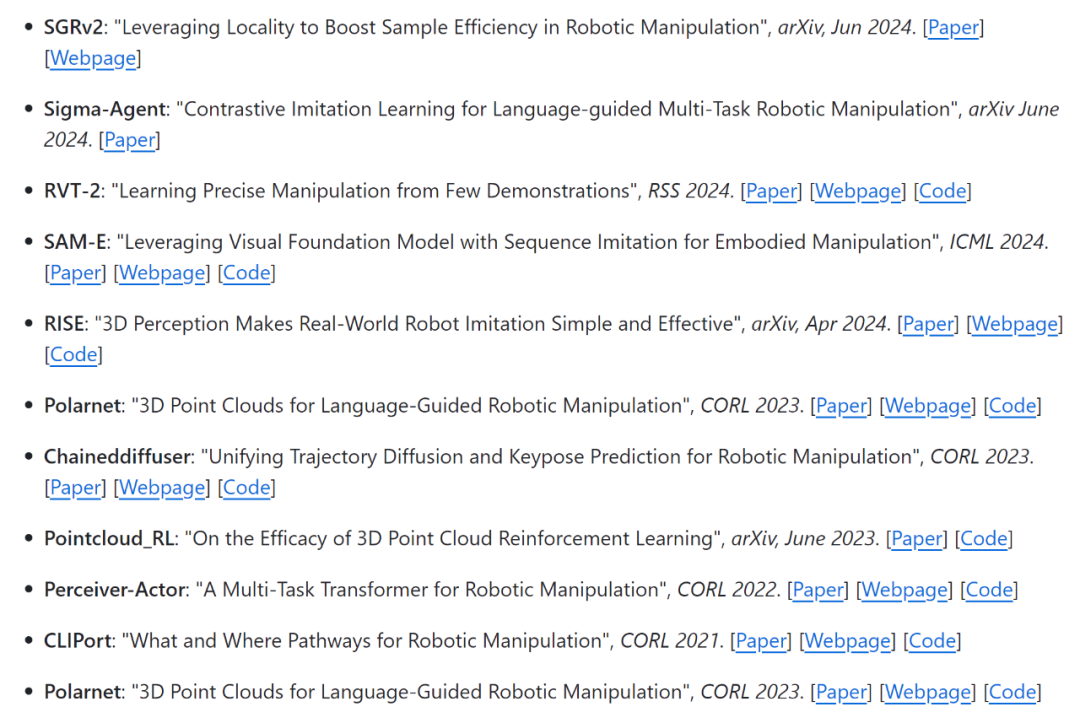

1、策略学习

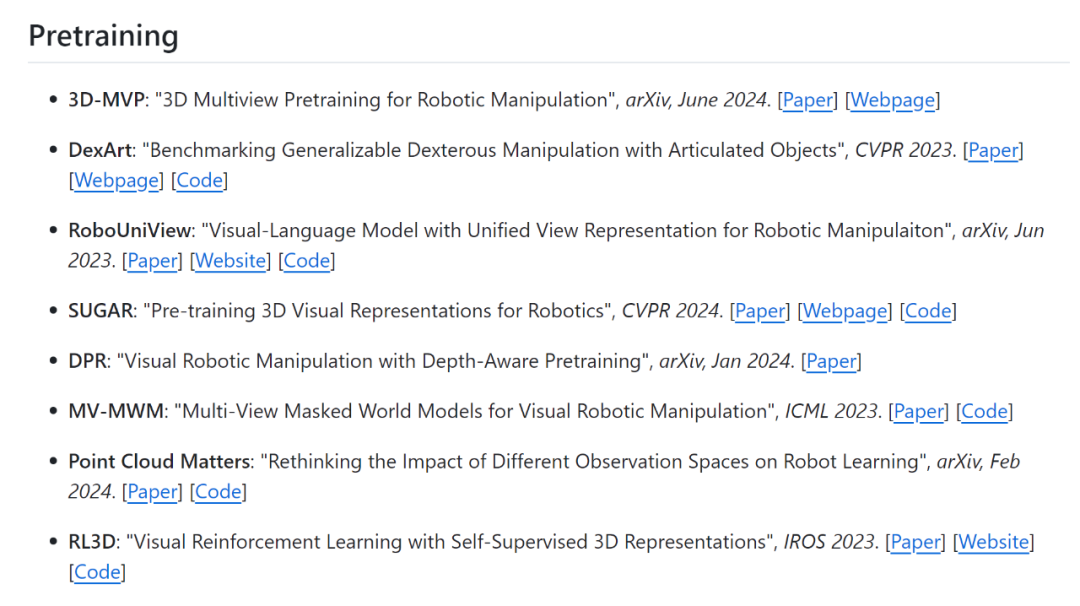

2、预训练

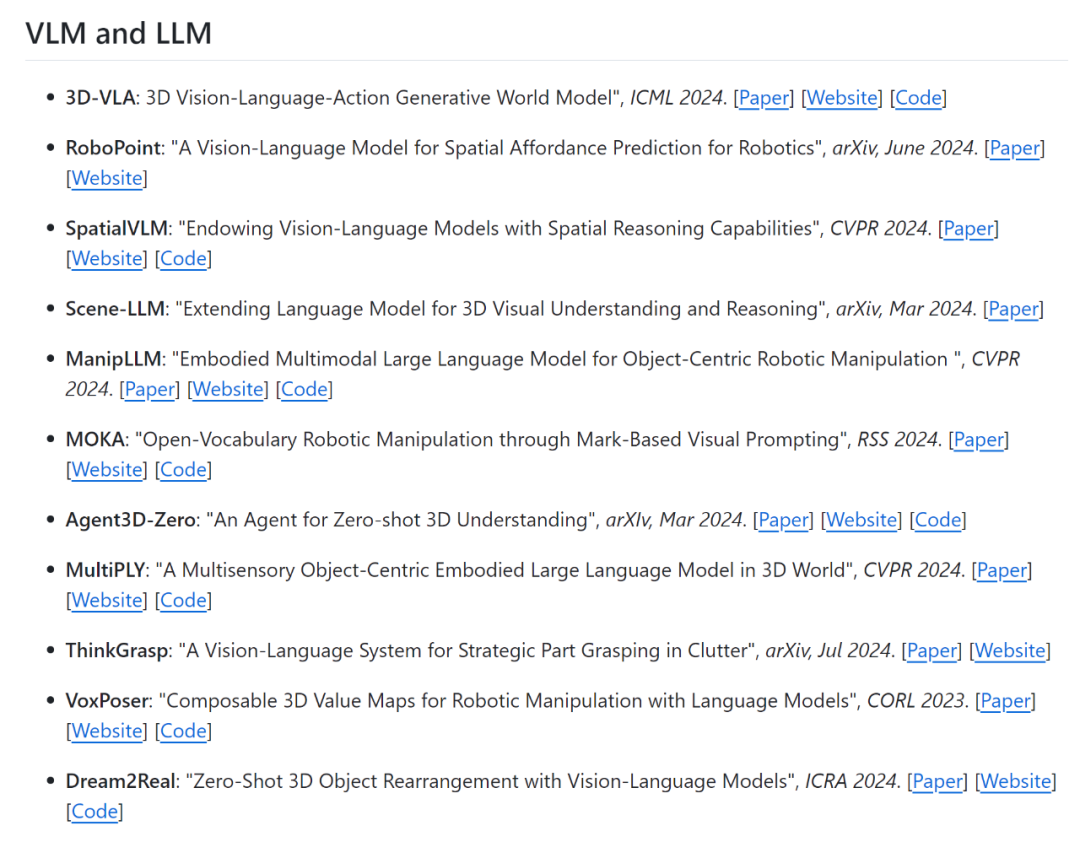

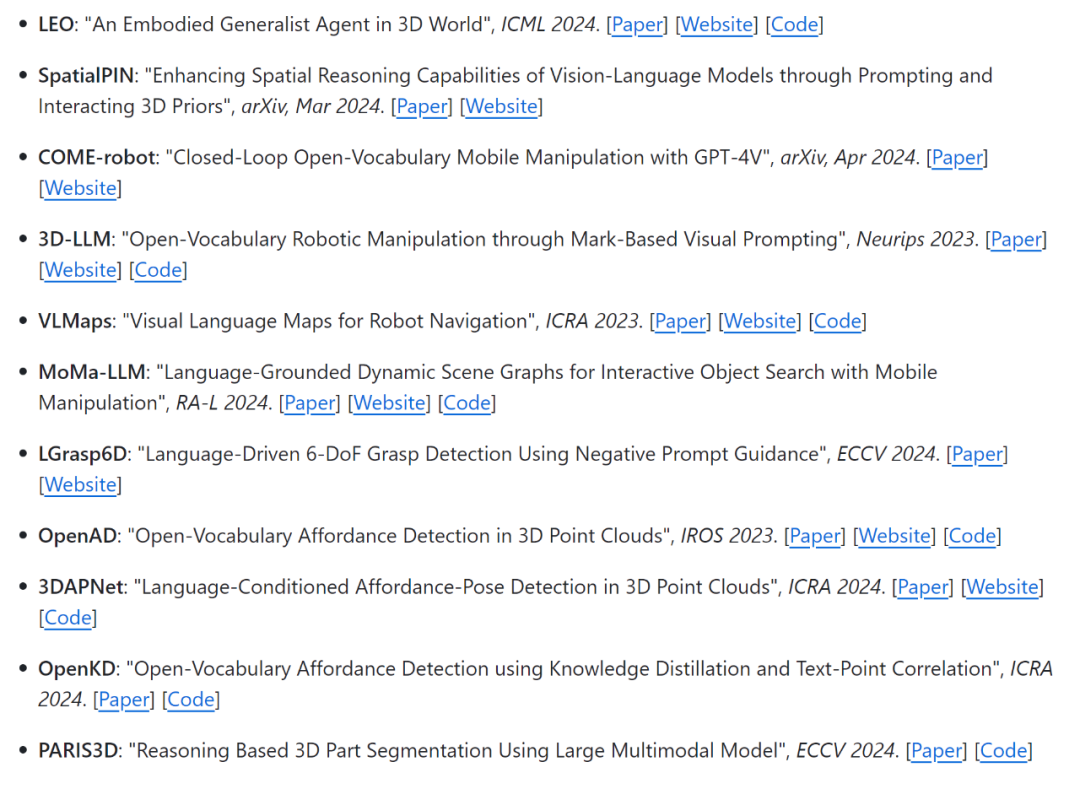

3、VLM 和 LLM

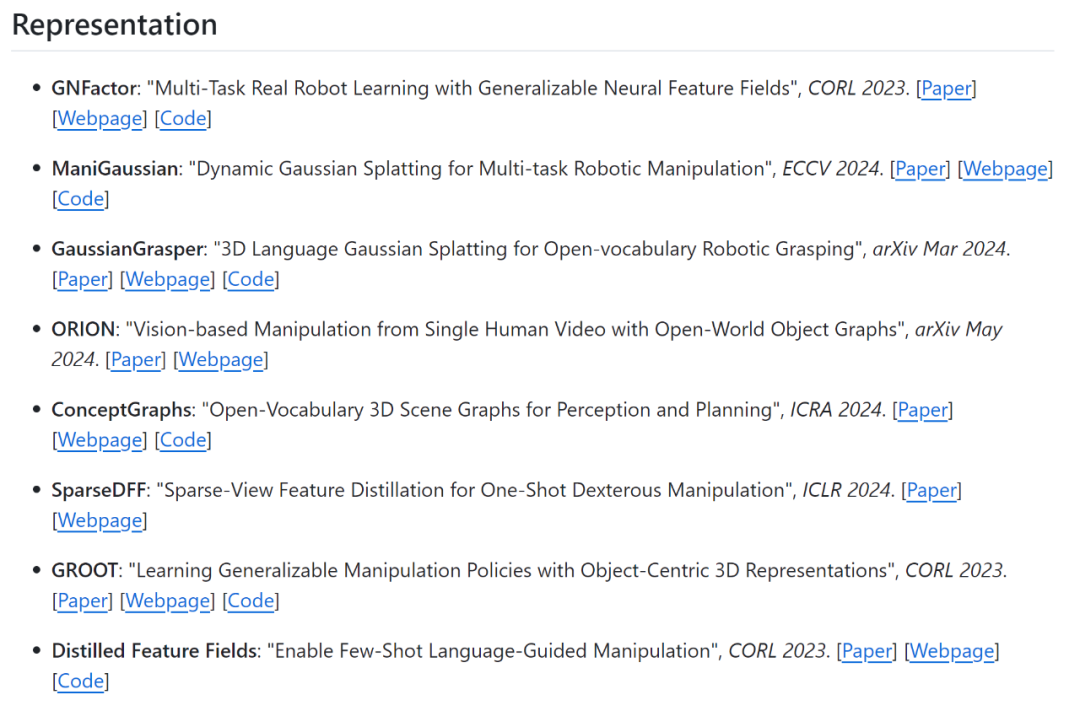

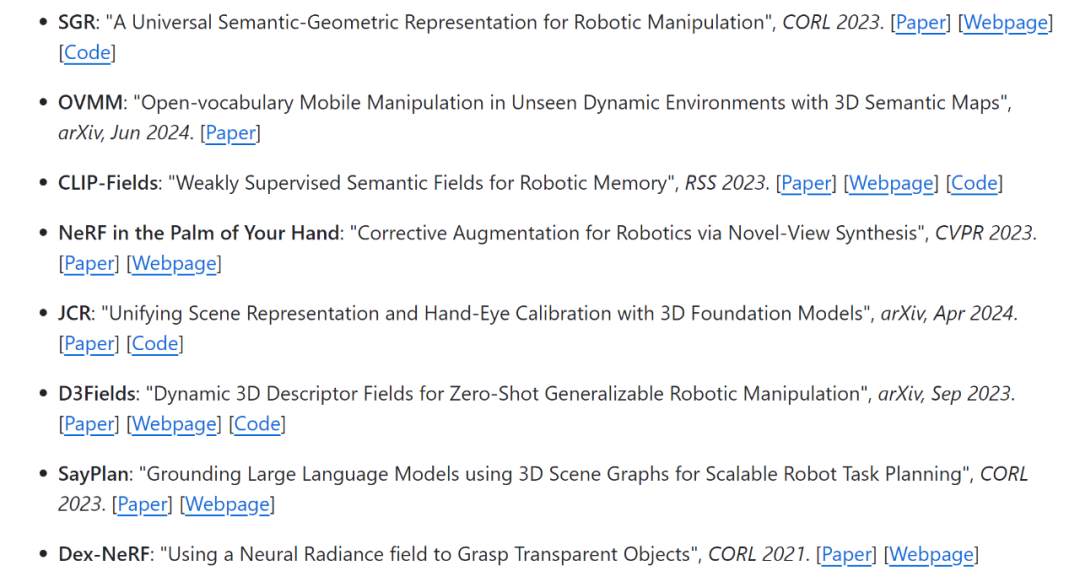

4、表示

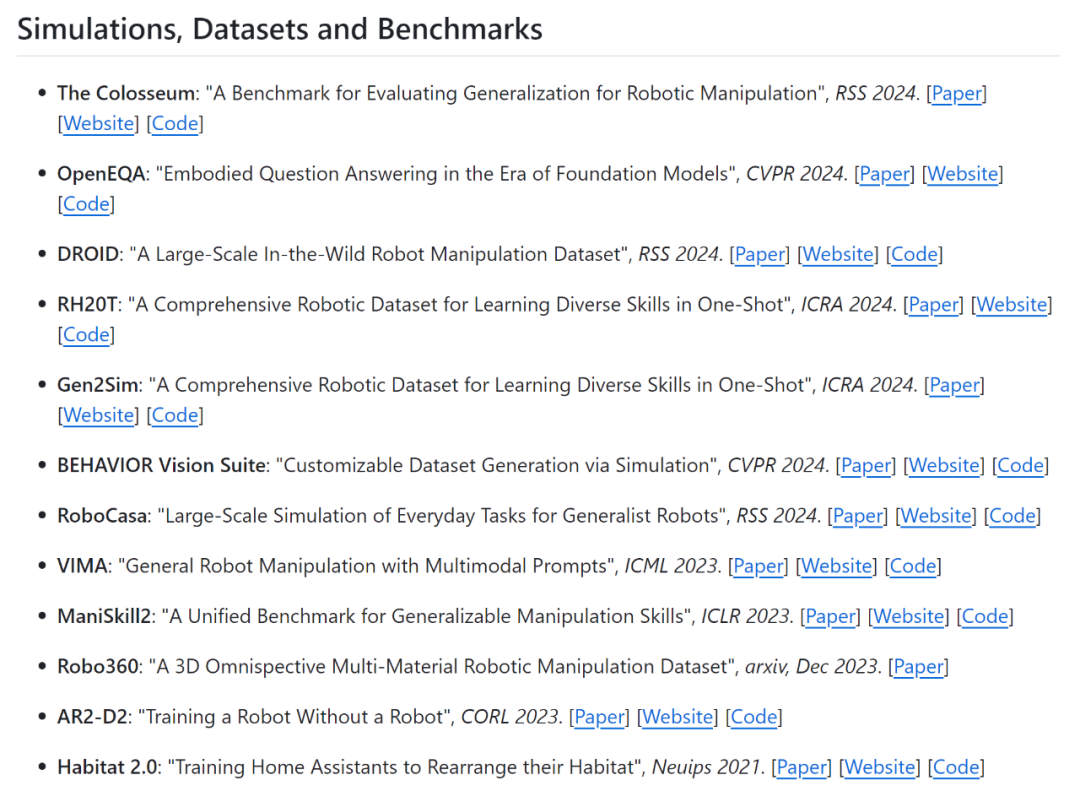

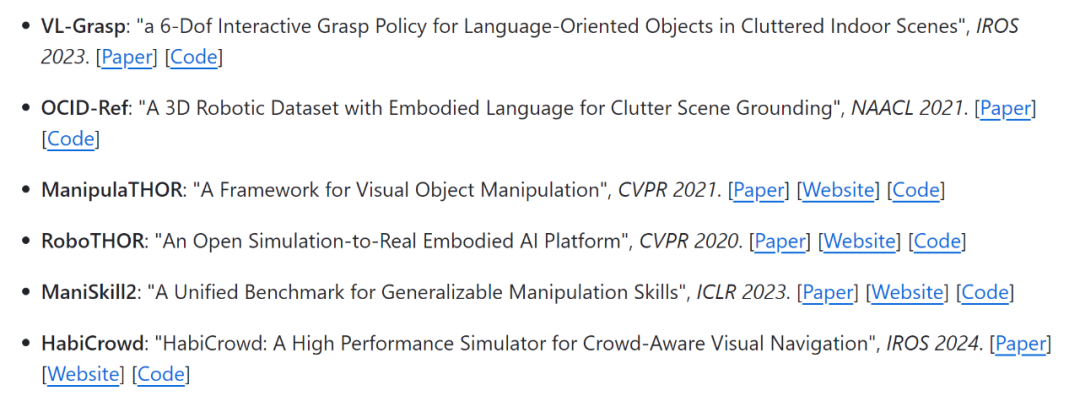

5、模拟,数据集和基准

此外,作者还给出了两篇可以参考的综述论文:

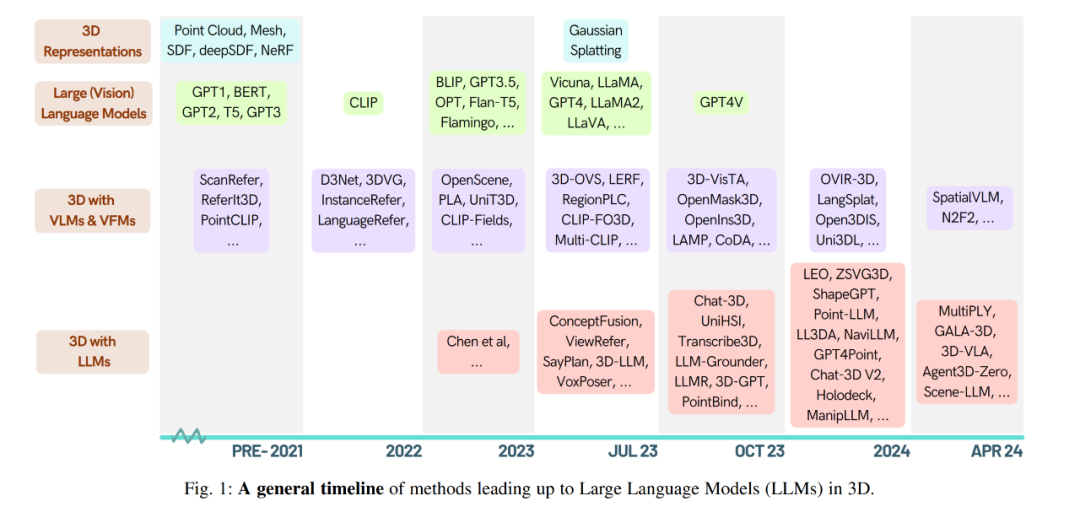

论文 1:When LLMs step into the 3D World: A Survey and Meta-Analysis of 3D Tasks via Multi-modal Large Language Models

论文链接:https://arxiv.org/pdf/2405.10255

论文介绍:这篇论文全面概述了使 LLM 能够处理、理解和生成 3D 数据的方法论,并强调了 LLM 的独特优势,例如 in-context learning、step-by-step 推理、开放词汇能力和广泛的世界知识,这些优势有望显著推进具身人工智能系统中的空间理解和交互。研究涵盖了从点云到神经辐射场(NeRF)的各种 3D 数据表示方法,并考察了它们与 LLM 的集成,用于 3D 场景理解、描述生成、问答和对话,以及基于 LLM 的代理进行空间推理、规划和导航等任务。此外,论文还简要回顾了其他将 3D 和语言进行整合的方法。通过对这些研究的元分析,论文揭示了取得的显著进展,并强调了开发新方法以充分利用 3D-LLM 潜力的必要性。

为了支持这项调查,作者建立了一个项目页面,整理和列出了与主题相关的论文:https://github.com/ActiveVisionLab/Awesome-LLM-3D

论文 2:A Comprehensive Study of 3-D Vision-Based Robot Manipulation

论文链接:https://ieeexplore.ieee.org/document/9541299

论文介绍:这篇文章全面分析了 3D 视觉在机器人操控领域的最新进展,特别是在模仿人类智能和赋予机器人更灵活工作能力方面。文章讨论了传统机器人操控通常依赖的 2D 视觉系统及其局限性,指出了 3D 视觉系统在开放世界中面临的挑战,如在杂乱背景下的一般物体识别、遮挡估计以及类似人类的灵活操控。文章涵盖了 3D 数据获取与表示、机器人视觉校准、3D 物体检测 / 识别、6 自由度姿态估计、抓取估计和运动规划等关键技术。此外,还介绍了一些公开数据集、评估标准、比较分析以及当前面临的挑战。最后,文章探讨了机器人操控的相关应用领域,并对未来的研究方向和开放问题进行了讨论。

感兴趣的读者可以点击阅读原文进入github链接开始学习。

往期精彩文章推荐

ECCV 2024 一作讲者招募 | 报名通道已开启

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了1800多位海内外讲者,举办了逾600场活动,超700万人次观看。

我知道你

在看

提出观点,表达想法,欢迎

留言

点击 阅读原文 开始学习!

5

5

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?