点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

点击 阅读原文 观看作者讲解回放!

作者简介

孙忠祥,中国人民大学博士生

论文简介

Retrieval-Augmented Generation (RAG) 模型通过结合外部知识以减少幻觉问题,但即使检索到准确的上下文,RAG 模型仍可能在生成过程中产生与检索信息相冲突的“幻觉”输出。

我们的研究聚焦于:

1. 幻觉来源

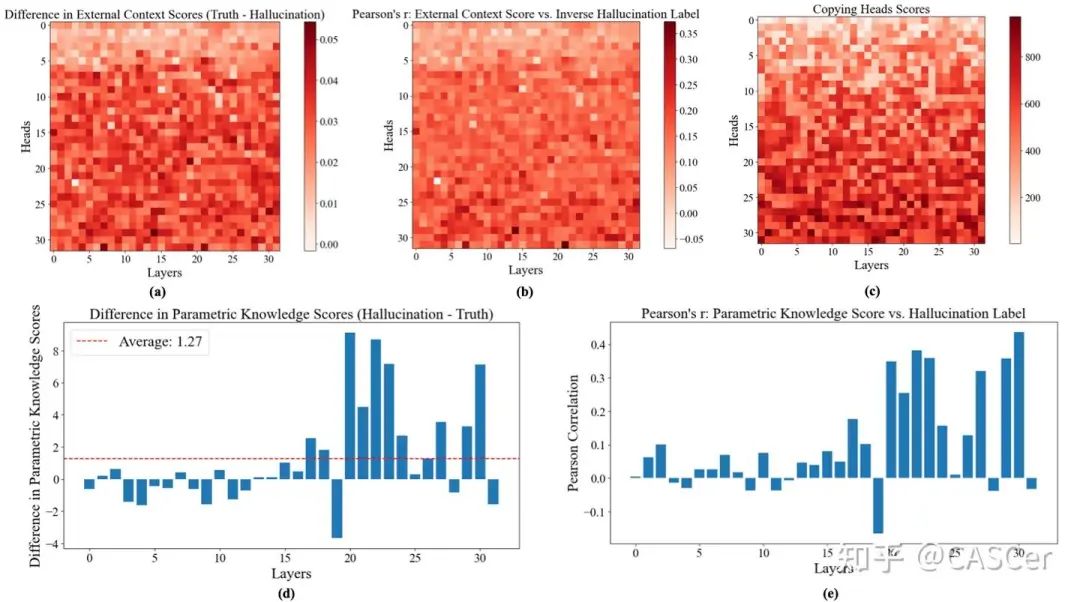

- 通过机制解释性 (Mechanistic Interpretability) 分析 LLM 模型内部的注意力和前馈网络(Feed-Forward Network,FFN),我们发现:

- 某些注意力头(称为 Copying Heads)在获取外部上下文时,经常出现信息丢失或未能有效“拷贝”外部知识的现象。

- 部分深层 FFN(称为 Knowledge FFNs)过度向残差流中注入参数化知识 (Parametric Knowledge),可能“淹没”外部上下文。

2. 提出方法:ReDeEP (Regressing Decoupled External context and Parametric knowledge)

将模型对外部上下文和参数化知识的利用进行显式解耦,并通过多元线性回归来检测幻觉倾向。

提供两种检测粒度:Token-level 和 Chunk-level,兼顾精细度与计算效率。

3.改进模型生成:AARF (Add Attention Reduce FFN)

在推理过程中,无需额外训练,依据实时“幻觉分数”对注意力和 FFN 的输出进行动态加权调控。

引导模型更多依赖外部知识,同时抑制过度依赖内部参数化知识,从而显著降低幻觉。

方法细节速览

我们在 LLaMA2-7B-chat 上进行实验,并基于 RAGTruth 数据集对注意力头与 FFN 的内部机制进行解析,重点关注模型到底如何处理外部上下文与参数化知识。主要步骤如下:

1. 外部上下文与参数化知识的度量

- External Context Score (ECS)

为量化模型对外部检索到的上下文的关注与使用程度,针对指定的注意力头(尤其是 Copying Heads),我们计算其对检索片段的注意力分布,并结合隐状态的语义相似度来得到 ECS。如果注意力在正确的上下文上且能持续被后续层保留,则 ECS 值会更高。

- Parametric Knowledge Score (PKS)

FFN 常被认为存储了模型的内在参数化知识。我们引入类似

的映射函数,对 FFN 前后隐状态对应的词表分布做 Jensen-Shannon 散度

(JSD) 计算,得到模型在此处“额外注入”的知识量。若深层 FFN(Knowledge FFNs)在残差流中插入过多信息,就会让 PKS 值变大。

的映射函数,对 FFN 前后隐状态对应的词表分布做 Jensen-Shannon 散度

(JSD) 计算,得到模型在此处“额外注入”的知识量。若深层 FFN(Knowledge FFNs)在残差流中插入过多信息,就会让 PKS 值变大。

2. Token-level & Chunk-level 检测 —— ReDeEP

3. 减轻幻觉 —— AARF (Add Attention Reduce FFN)

实验成果

- ReDeEP 在幻觉检测

上的显著提升

在 RAGTruth 和 Dolly 数据集上,ReDeEP 相比现有方法在检测准确率和各项衡量指标(如 AUC、F1-score)上均取得突破。多层次回归方法有效减少了对检测的误判。

- AARF 减少幻觉并提升真实性

动态放大关注外部知识的注意力头,同时抑制深层 FFN 的干扰,大幅降低幻觉发生率,提升了文本生成的可靠性与一致性。

- 适用 LLaMA 系列模型的通用性

我们在 LLaMA 系列模型上获得了稳定且显著的效果,证实了方法的可移植性和对不同大语言模型的适配潜力。

亮点

- 1.理论创新

首次从机制解释性的角度,将外部上下文与参数化知识在 RAG 模型中的具体作用进行解耦分析,并借助因果干预实验验证其对幻觉的实质影响。

2.工程实践提供了两种检测粒度(Token-level 与 Chunk-level),并在推理阶段可无缝集成 AARF 算法,无需大规模训练即可直接套用到现有 RAG 流程中。

- 3.应用潜力

在医疗、法律等要求高可信度的文本生成场景中具有广阔应用前景,为后续多模态、多场景的生成式 AI 发展奠定坚实基础。

近期活动推荐

CVPR 2025结果出炉|一作讲者已开启招募,欢迎新老朋友来预讲会相聚!

CVPR 2025结果出炉|一作讲者已开启招募,欢迎新老朋友来预讲会相聚!

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了2000多位海内外讲者,举办了逾700场活动,超800万人次观看。

我知道你

在看

提出观点,表达想法,欢迎

留言

点击 阅读原文 观看作者讲解回放!

8

8

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?