Fully Automated Delineation of Gross Tumor Volume for Head and Neck Cancer on PET-CT Using Deep Learning: A Dual-Center Study

**深度学习在PET-CT上全自动勾画头颈部肿瘤总体积的双中心研究

**

中科院SCI分区:4区 DCNN:二维方法

数据集:22例病人的PET/CT图像 来自医院和肿瘤中心

第一数据库:17例病人 第二数据库: 5例病人

Abstract

purpose

在这项研究中,我们提出了一种自动深度学习(DL)方法,用于在正电子发射断层扫描-计算机断层扫描(PET-CT)图像上绘制头颈部肿瘤体积(GTV)轮廓。

Materials and Methods

采集22例初诊HNC患者的PET-CT图像,其中17例(数据库1)和5例(数据库2)分别来自两个中心。一位肿瘤学家和一位放射科医生以协商一致的方式手动决定了GTV的黄金标准。我们开发了一种深度卷积神经网络(DCNN),并基于训练数据集中的二维PET-CT图像和GTV的黄金标准对网络进行了训练。我们做了两个实验:实验1,只使用数据库1,实验2,同时使用数据库1和2。在实验1和实验2中,我们都使用留一交叉验证策略对所提出的方法进行了评估。我们将实验2的中位数结果(GTVa)与文献中其他方法的性能以及金标准(GTVm)进行了比较。患者在PET-CT图像上共同配准的肿瘤分割任务只用了不到一分钟。实验1和实验2的Dice相似系数分别为0.481∼0.872和0.482∼0.868。GTVa的DSC优于以往的研究。GTVa与GTVm高度相关(R0.99,P<0.001)。GTVm与GTVa的中位容积差(%)为10.9%。差示扫描量热法的中位数为0.785,灵敏度中位数为0.764,精密度中位数为0.789。提出了一种基于双中心DCNN和PET-CT的HNC全自动GTV等高线绘制方法,该方法具有较高的精度和效率。我们提出的方法对临床医生进行HNC管理有一定的帮助。

Introduction

头颈部癌(Head and Neck Cancer,HNC)是一种起源于头颈部组织和器官的癌症,在中国南方发病率较高[1]。放射治疗(RT)是最有效的治疗方法之一,它在很大程度上依赖于医学图像上肿瘤体积的轮廓。然而,手动勾画肿瘤体积是非常耗时的。此外,人工勾画是主观的,其准确性取决于治疗计划员的经验。与人工描述相比,自动分割可以相对客观。目前,已有研究报道使用不同的方法自动分割HNC磁共振图像上的肿瘤病灶[2-10]。

正电子发射断层扫描-计算机断层扫描(PET-CT)在HNC的诊断和治疗中发挥了重要作用,提供了有关肿瘤的解剖和代谢信息。利用机器学习(ML)方法,如k近邻(KNN)[11,12]、马尔可夫随机场(EM-MRF)[13]、带k-均值的自适应随机游动(AK-RW)[14]、决策树算法[15]和主动表面建模[16],对HNC PET-CT或者PET图像上的肿瘤病灶进行了自动或半自动分割。与单独使用PET或者CT图像相比,联合配准的PET和CT图像对肿瘤病灶的分割显示出更好的结果[17,18]。然而,PET-CT的应用增加了图像数据的数量和复杂性(多模态)。此外,为了提出一种健壮和实用的基于ML的自动分割方法,经常需要使用来自多个中心的异构图像数据来训练和测试该方法[19],这使得ML系统的训练和测试更具挑战性。

与传统的最大似然方法相比,深度学习允许自动提取特征,而不是传统的最大似然方法中的主观特征提取和选择,这可能更适合于多模态数据和多中心数据的自动分割。DL可以很容易地识别数据的内在特征[20]。层叠去噪自动编码器(SDAE)[21]和卷积神经网络(CNN)[22-24]等DL技术已成功地应用于肿瘤分割,提高了分割精度。

目前还没有将深度卷积神经网络(DCNN)应用于PET-CT图像上HNC患者GTV自动勾画的研究报道。在本研究中,我们提出了一种基于DL和双中心PETCT图像的HNC实时规划GTV自动绘制方法,旨在提高效率和准确性。

Materials and Methods

简而言之,我们的方法包括黄金标准的勾画,DL模型的训练和测试,以及评估我们训练的模型的性能。在检查了MRI、CT和PET图像后,肿瘤学家和放射科医生一致决定了GTV的轮廓,并将其作为我们方法后续训练和测试的金标准。我们开发了一种用于HNC肿瘤病变分割的深度卷积神经网络(DCNN),然后在训练数据集中以PET-CT图像和GTV的黄金标准为基础对网络进行训练。在测试步骤中,我们将测试数据集输入到网络中,它会自动绘制GTV的等高线。为了检验这种自动化方法的准确性,我们将我们的方法的结果与文献中其他方法的结果以及与黄金标准的结果进行了比较。

Structure of Our DCNN Model

受完全卷积网络[25]和U-net[26]的启发,我们设计了一个用于GTV描述的DCNN模型。我们提出的DCNN模型的TE结构如图1所示。TIS网络由两个阶段组成:特征表示阶段和分数图重构阶段。

Feature Representation Phase

特征表示阶段的主要目的是提取PET图像和CT图像的特征信息,将低层特征与语义信息相结合来表示高层特征。特征表示阶段包含5个下采样块、4个卷积(Conv)层和4个整流线性单元(RELU)层(图1)。下采样块包括卷积层、RELU层和池化层。第一卷积层通过5×5个体素的滤波器分别提取PET图像和CT图像的低层特征,并将它们融合在一起。我们能够融合这些特征,因为PET和CT图像是以相同的黄金标准同时输入的。在接下来的4个卷积层中,我们对低层特征进行了排列和组合的卷积,以获得更多具有语义信息的高层特征。**在所有5个下采样块中,卷积层之后是一个池化层。我们采用了2×2的滤波器和2个步长的池化,使特征图的长度和宽度减少了50%。它可以减少连接参数的数量和计算时间,并提供位置不变性和更多的全局信息。**在较小的图像上使用不变的滤波器可能会导致较大的局部感受野,而这些扩大的局部感受野可以提取更多的全局特征。在每一卷积层之后,我们使用RELU层作为激活层,以增加网络的非线性,加速收敛。

图1:提出的CNN模型的体系结构。提出的网络包括两个阶段:特征表示阶段和分数图重构阶段。特征表示阶段由5个下采样块(卷积ReLU池化层)、4个卷积层和4个ReLU层组成。Score MAP重建阶段由5个上采样块(DECOV-CONCAT-CONV-COV-REU层)、一个卷积层和一个RELU层组成。K,卷积核大小;P, zero padding;S,stride。

特征图的长度和宽度在下采样块后减少了50%。**特征图尺寸缩小到16×16后,再与16×16滤波器的卷积层相连。**这意味着下一层中的每个神经元都与上一层中的所有神经元相连,以模仿传统分类网络中的完全连通层。**该卷积层后特征图的大小为1×1像素。**采用2层1×1滤波器的卷积层对这些特征进行排列和组合,以获得更抽象的信息。最终获得1×1的分数图,作为分数图重建阶段的输入。

Scores Map Reconstruction Phase

分数图重建阶段的主要目的是通过上采样将分数图重建成相同大小的输入图像。重建阶段由5个上采样块、一个卷积层和一个REU层组成。上采样块由反卷积(Deconv)层、级联(Concat)层、卷积层和RELU层组成。反卷积层设计用于上采样。第一反卷积层由32×32的卷积核将1×1的分数图重建至32×32的特征图。然而,我们发现反卷积会导致图像中高分辨率信息的丢失。为了克服这一问题,我们利用拼接层将以前的池化层或卷积层中的特征地图与反卷积层中的当前特征地图进行融合。我们认为这些跳层设计可以捕捉更多的多尺度上下文信息,提高分割的准确性。为了逐个像素地融合低分辨率和高分辨率信息,我们将所有后续卷积层的滤波器设置为1×1。

对于所有的上采样块,我们最终将分数映射到大小为512×512的输出图像,与输入的PET或CT图像相同。为了优化网络,我们通过计算金标准和重建的肿瘤病变之间的欧几里得距离来估计损失[27,28]。通过从损失反向传播来迭代和更新网络的参数。在我们的实验中,我们决定使用欧几里德距离来估计损失,因为它显示出比Ronneberger等[26]的其他一些研究中使用的交叉熵损失更好的性能。

Training of our DCNN Model

Data Preprocessing

其中17例(男13例,女4例,年龄31到68岁)来自中山大学第一附属医院(中心1),5例(均为男性,44∼63岁)来自中山大学肿瘤中心(中心2)。伦理委员会免除了从患者那里获得知情书面同意的必要性。两个中心的TEPET-CT扫描都是从头顶到肩部。每个床位PET采集时间为2.5min。使用Discovery STE(GE Healthcare,美国密尔沃基,GE Healthcare,美国密尔沃基)对中心1患者进行扫描,大多数CT图像的空间分辨率和图像矩阵分别为0.49×0.49×2.5mm3和512×512×63,PET图像的空间分辨率和图像矩阵分别为1.56×1.56×3.27 mm3和256×256×47。中心1的PET扫描在三维模式下采集,并采用有序子集期望最大化迭代算法进行重建。使用Discovery 690型PET-CT扫描仪(美国密尔沃基GE Healthcare)对中心2的患者进行扫描,CT图像的空间分辨率和图像矩阵分别为0.59×0.59×3.27 mm3和512×512×47,PET图像的空间分辨率和图像矩阵分别为1.17×1.17×3.27 mm3和256×256×47。中心2采用三维模式采集PET扫描图像,采用VPFXS重建方法进行重建。

为了利用PET图像和CT图像的信息,我们在SPM8(英国伦敦惠康成像神经科学部)中通过对PET图像进行线性插值采样来进行PET与CT图像的联合配准。最后,对于作为数据库1的中心1的17名患者和作为数据库2的中心2的5名患者,我们有934个样本(一个样本包括一个CT图像切片和一个共配准的PET图像切片,两者的矩阵大小均为512×512)。

使用ITK-SNAP软件(http://www.itksnap.org)参考MRI、PET和CT图像,由经验丰富的肿瘤学家在注册的PET/CT上手动勾勒出初级GTV的轮廓,并由经验丰富的肿瘤学家对其进行复查[29]。合成的GTV轮廓被用作我们所提出的模型的训练和测试的金标准,并与自动分割在体积和几何重叠方面进行了比较。具体地说,我们根据放射科医生的建议,通过考虑PET图像中的部分体积效应(PVE),丢弃了肿瘤大小小于0.5cm2的图像(在二维图像中)。当肿瘤大小小于重建图像分辨率半高全宽(FWHM)的3倍时,PVE会影响小肿瘤病变的成像准确性[30]。

我们用我们的数据做了两个实验。在实验1中,我们仅使用数据库1中的数据对所提出的方法进行了评估。我们使用留一交叉验证(LOOCV)策略对所提出的方法进行了评估,将一个患者的图像留作测试,将所有其他患者的图像留作训练。为了平衡训练数据集中的正负样本,我们选择了所有有肿瘤病变的切片作为阳性样本,并随机选择了相同数量的无肿瘤病变的切片作为阳性样本。为了满足数字图书馆对海量训练数据的需求,我们通过旋转图像、水平镜像、改变对比度和图像缩放,将训练数据集扩大到近15,000个样本。在实验2中,我们使用了两个数据库(1134个样本),将训练数据集扩大到近1.8万个样本,并使用类似的LOOCV策略对该方法进行了评估。在实验1和实验2的训练和测试之前,所有数据都通过执行最小-最大归一化来归一化。

Network Training

网络训练分为三个阶段。在第一阶段,我们在第三个上采样块(图1)之后获得了输出图像,输出图像的大小为128×128。第二阶段由第一阶段的网络参数进行初始化,得到256×256的得分图。最后,根据第二阶段的网络参数对整个网络进行训练,并利用得分图重建出512×512的输出图像(与输入的PET或CT图像的大小相同)。

模型通过使用adam优化器进行了200,000次迭代的训练,固定学习率为0.00001。我们使用配备在Intel Xeon E5-2650 2.30 GHz×16机器上的图形处理器NVIDIA GeForce GTX 1080 Ti和DL框架Kera进行培训[31]。整个训练过程耗时约24小时。

Performance Evaluation of Our DCNN Method

Evaluation of Automatic GTV Delineation Performance

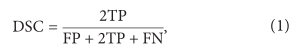

在DCNN模型训练成功后,我们使用测试数据集通过计算Dice相似系数(DSC)来评估我们的方法的分割性能,如下所示:

其中真阳性(TP)表示正确识别的肿瘤区域,假阳性(FP)表示错误识别为肿瘤的正常组织,假阴性(FN)表示错误预测为正常组织的肿瘤区域。DSC描述了金标准和自动分割结果之间的重叠。

Comparison with Other Methods in the Literature

为了促进我们方法的改进,我们还将我们的结果与前人的研究结果进行了比较。**我们尝试在我们的数据库上应用这些前面的方法;但是,性能都低于公布的结果。因此,在DSC方面,我们直接将我们的结果与这些出版物中的结果进行了比较。**尽管它们可能没有合理的可比性,但这些比较在某种程度上为我们的方法如何超越类似的研究提供了洞察力。请注意,为了进行公平的比较,我们使用了实验2中中值性能的结果进行比较。

Comparison with the Gold Standard of GTV

虽然我们重复了几次实验,但为了公平比较,我们使用了实验2中的中位数成绩结果与双中心数据进行比较,结果被记录为GTVa。手工勾画金标准,记录为GTVm。GTVa与GTVm进行Pearson相关分析。为了进一步评估GTVa相对于GTVm的准确性,我们计算了平均表面距离(MSD)、灵敏度和精确度,如下所示:

其中X和Y分别表示自动分割的边界和金标准,(yi1 ,i = 1,……N∈X是X的边界点;yj2,j=1,……M∈Y是Y的边界点)。MSD描述了GTVa和GTVm之间沿边界的平均欧几里得距离。敏感度描述了GTVm中包含了GTVa和GTVm的重叠程度。精度描述了GTVa和GTVm在GTVa中的重叠程度。通过计算GTVa−GTVm[32],估计了GTVa和GTVm之间的绝对差异。

Results

Automatic GTV Delineation Performance

使用我们训练的模型,对一个样本(二维的共配准PET图像和CT图像)的肿瘤分割任务大约需要0.28秒;因此,对于一个拥有大约50个共配准PET/CT图像的HNC患者,我们的方法对于GTV分割大约需要14秒。图2显示了一个高精度分割的例子,其中dsc为0.943。图3和图4显示了两个较差结果的典型示例及其对应的PET图像,其中dsc分别为0.610和0.408。如图5所示,用高代谢的蓝色圆圈标记的区域实际上是一个炎症区域,看起来与肿瘤病变非常相似。我们训练的模型能够了解炎症区域和肿瘤病变之间的区别,并正确地将其识别为非肿瘤区域。

17名患者(数据库1)中实验1的中位数为0.762(范围为0.481∼0.872)。在实验2中,22名患者(数据库1+数据库2)的DSC中位数为0.785(范围,0.482∼0.868),单独使用数据库1的中位数为0.783(范围,0.482∼0.868),单独使用数据库2的中位数为0.793(范围,0.528∼0.863)。实验2中的分割结果被记录为GTVa,并用于下面的比较。

图2:高精度HNC肿瘤分割示例。Dice相似系数(DSC)为0.943(a) PET图像与CT共配准。(b) CT图像。(c) 自动分割结果显示在融合PET-CT图像上(绿线)。(d) 融合PET-CT图像上绘制的肿瘤总体积金标准(红线)。

Comparison with Other Methods in the Literature

表1显示了以往基于PET-CT的头颈癌分割研究结果。在实验2中,22例患者的DSC平均值为0.736。Stefano等人[14]获得了0.848的高密度散射率;然而,他们的方法仅限于PET图像,并且是半自动的。

Comparison with the Gold Standard of GTV

22例患者GTVa与GTVm呈高度相关(R=0.99,P<0.001)。GTVa和GTVm之间的详细比较见表2和图6。GTVa和GTVm之间的平均体积差(%)为12.4%±9.8%,95%的可信区间(CI)为−6.7%∼为31.6%。所有患者的DSC, sensitivity, precision和MSD均值分别为0.736±0.110(95%CI,0.521∼0.951)、0.720±0.128(95%CI,0.468∼0.973)、0.761±0.111(95%CI,0.543∼0.978)和4.7±3.4 mm(95%CI,−1.8∼11.2 mm)。

图6:GTVm和GTVa之间的比较。GTVm,手工勾画大体肿瘤体积(金标准)。GTVa,用提出的方法对大体肿瘤体积进行自动分割。每一点代表一个病人。DSC,戴斯相似系数。(a)GTVm和GTVa之间的区别。GTVa的灵敏度(b)、精度©和DSC(d)(平均值用粗虚线表示)。

Discussion

我们提出了一种基于DL和PET-CT图像的HNC自动化GTV轮廓方法,具有令人鼓舞的分割结果。大多数关于HNC描绘的研究仅基于PET图像[14-17],其中由于与CT或MRI相比空间分辨率低,解剖信息不足[13]。Yang等[13]实现了类似的分割精度(DSC=0.740);然而,他们的方法基于三种模式(PET,CT和MRI)。Stefano等[14]和Song等[17]的方法都是半自动的。Berthon等[15]报道的准确度更高,为0.77;然而,他们的性能评估黄金标准包含了自动分割结果的信息。与这些研究[13-17]仅来自一个中心的数据相比,我们提出的方法在双中心数据上显示出稳定的性能。总而言之,我们提出的方法已经显示出相对较高的准确性并且是全自动的,利用了代谢和解剖信息。

无论是在实验1中还是在实验2中,数据库1的性能都是高且稳定的。这可能表明所提出的DCNN模型是有效的和健壮的。值得注意的是,在实验2中,DSC比实验1要高,这可能是因为随着样本的增加,我们的DCNN模型可以学习更多的特征,从而提高了分割的准确率,这可能是因为随着样本的增加,我们的DCNN模型可以学习更多的特征,从而提高了分割精度。然而,我们在实验2中也观察到,数据库2的准确率低于数据库1。原因可能是这两个数据库之间的特征有所不同。从数据库1和数据库2学习到的特征,主要来自数据库1,可能不适合应用于数据库2。请注意,在只有22名患者的情况下,我们已经取得了如此好的自动配准性能。但是,我们可能会招募更多的数据来进一步验证我们模型的稳健性。

图像特征在基于机器学习的分割任务中是至关重要的。我们使用多模态图像,即PET和CT图像作为DCNN模型的输入,这可能比单独使用PET或CT图像的分割效果更好。这一发现与Song等人[17]或者Bagci等人[18]的研究结果相呼应。**如图2所示,由于肿瘤区域和正常组织之间的代谢明显不同,肿瘤区域与邻近组织的对比度很高,因此在PET图像中很容易检测到肿瘤的位置。然而,PET图像的空间分辨率较低,导致PET图像中肿瘤边界不清晰。在空间分辨率较高的CT图像中,解剖信息对肿瘤边界的检测更为有效。**通过使用PET和CT图像,我们的方法提取并结合代谢和解剖信息作为有效的特征,以便更准确地分割。

我们用来提取特征的DL技术已经显示出比传统的机器学习方法更多的优点(表1)。如图5所示,用高代谢的蓝色圆圈标记的区域实际上是一个炎症区域,看起来与肿瘤病变非常相似。没有经验的临床医生可能会错误地认为这个区域是肿瘤病变,而我们训练的模型能够了解这些炎症区域和肿瘤病变之间的差异,并正确地将其识别为非肿瘤区域。实例表明,我们的DCNN方法能够提取肿瘤病变的固有特征,最终获得更好的GTV轮廓效果。此外,在特征表示阶段和分数图重构阶段,我们使用了跳跃层结构对特征图进行融合,这是对该方法的又一次技术改进。如图7所示,虽然特征表示阶段特征的语义信息比分数图重建阶段的特征语义信息差,但它可以帮助解决重建过程中信息丢失的问题。与Long等人使用的特征地图融合方法进行了比较。[25]在特征融合过程中,我们的方法成功地融合了更多有用的特征。我们认为这种融合通过使用跳跃层结构提高了分割的准确性。

图5:炎症的一个例子。用蓝线标记的炎症区域看起来与肿瘤相似,因此可能很难通过肉眼评估来区分。然而,我们提出的方法(绿线)正确地识别了它。该肿瘤的骰子相似系数为0.848。

GTVa和GTVm之间的比较(图6和表2)表明,GTVa与GTVm相似,接近GTVm。然而,我们的自动化方法仍然存在一些不足之处。首先,GTVa在某些肿瘤中不能令人满意。如图3所示,PET图像中的肿瘤很大,但边界不清;因此,部分肿瘤被错误地识别为正常组织。如图4所示,低代谢区被错误地检测为肿瘤病变,该区域位于一些其他患者经常出现肿瘤病变的区域。如图6(A)所示,两名患者在GTVm和GTVa之间表现出很大的差异。两例TE肿瘤均较大,有大量淋巴结转移。这种类型的肿瘤在我们的数据库中很少,因此,我们的方法无法了解这些类型的肿瘤的特征。其次,我们丢弃了肿瘤体积小于0.5cm2的图像(在二维图像中),因为这样的肿瘤病变在PETimages中很难通过视觉评估来发现。此外,由于PVE.TUS可能会影响小肿瘤病灶的成像准确性,我们的方法在这类小肿瘤上的表现尚不清楚。

图3:HNC肿瘤分割的一个典型例子,准确率较低。Dice相似系数为0.610。(a)与CT共同配准的PET图像。(b)CT图像。©在融合的PET-CT图像(绿线)上显示自动分割结果。(d)大体肿瘤体积的金标准,绘制在融合的PET-CT图像上(红线)。

我们的结果在以下几个方面可以在未来的研究中得到改进。首先,需要招募更多的数据来训练更好的模型,并对性能进行重新测试。特别是,来自不同中心的数据应该更好地平衡。此外,可以采用MRI图像,因为它们提供了更好的软组织对比度,并且可以改善性能。其次,在训练和测试中,只使用了二维图像,丢弃了体积信息。我们将仔细改进网络结构,并调整训练参数以获得更好的分割结果。最后,为了将我们的方法成功地应用于HNC的放射治疗,还应加入危险器官的自动轮廓,并绘制临床靶区体积(CTV)和计划靶区体积(PTV)。

Conclusion

在这项研究中,我们成功地提出并验证了一种基于DCNN和双中心PET-CT图像的健壮的HNC自动GTV分割方法。利用多模态图像,自动、客观地提取人体解剖特征和代谢特征,提高了准确率。DL算法在GTV分割中显示出很好的潜力。所有这些都使得我们的方法与人工绘制轮廓相比具有更高的精确度和效率。我们的方法可能有助于临床医生进行HNC的放射治疗,因此在HNC患者的治疗中具有很大的潜力。未来的研究目标可能是通过更多的训练数据和优化的网络结构来进一步提高分割精度,绘制CTV/PTV,并用多中心的数据来验证我们的方法。

346

346

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?