今天重新学习了一遍SVM的内容,发现好多以前看不懂的推导公式都能理解了,赶紧记录下来。作者属于菜鸟级别,文中如有错误认识还请大家不吝赐教!

SVM(support vector machine,支持向量机),是一种可应用与线性或非线性的一种分类器。以下我们按照SVM的发展顺序以及问题求解依次介绍。

1. 线性支持向量机(LSVM)

我们先假设样本集线性可分,也就是最简单的情况。由于是线性分类器,所以分割平面方程为`w*x+b=0`,和感知器类似。SVM的输出为$+-1$,当点位于超平面上方时输出为+1,下方输出-1.

我们将离超平面最近的点叫做支持向量,支持向量到超平面的距离叫做间距(margin)。SVM分类的特点就是间距最大化,由于能将样本分类的超平面可能有多个,他们对样本的适用性都很好,但是能使间距最大化的超平面会使分类更加公平,从而使测试误差降到最低。

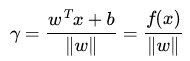

支持向量到超平面距离为

w*x+b=1或w*x+b=-1(实际上通过变化w和b总能实现),这样优化问题变成 后面的约束条件是指保证支持向量在

后面的约束条件是指保证支持向量在w*x+b=+-1上,其他点都都远离支持向量。

由拉格朗日算子αj 乘以约束条件,得到

,对w,b分别求偏导数并令其为0,然后将解出的式子重新代入上式得到

,对w,b分别求偏导数并令其为0,然后将解出的式子重新代入上式得到

这样就通过拉普拉斯算子转化为了对偶问题(dural problem),于是转化为求LD的最值,对α求导得到W,b表达形式

求出w后将其代入任一个支持向量,就可以算出b。

以上是硬分类模型,是指样本完全是线性可分的。当然有硬分类就有软分类,是说当有若干点A类的点跑到B类里去了,你中有我我中有你的情况,造成了不完全线性可分(注意不是非线性),

这时候就要加一些松弛变量,优化公式变成了下面这样

|w*x+b|>1的条件,但是加上松弛变量之后,就可以满足了。

下面仍转化为对偶问题求解

求解后发现LD的表达形式和加松弛变量前没有变化只是α得上限变成了C,也就是松弛项的系数。

2.非线性问题

SVM同时能处理非线性问题,比如

SVM将原来的数据集映射到一个新的空间中去,将一个非线性问题转化为线性问题,于是非线性又变成了熟悉的线性,但往往新的特征空间的维度都要比映射前空间要高。这就出现了两个问题,如何映射才会是非线性问题线性化,以及维度升高使运算更加困难问题。下面我们一一进行解释,事实上映射方式是特定的几个,由核函数来确定。第二在高维向量运算中由于SVM的基本运算是向量内积,而通过数学推导,高维空间的向量内积完全可以等价成变换前空间中向量内积的运算形式,如

常用的核函数有

多项式核对应的SVM是一个d次多项式分类器,高斯核会把数据映射到无穷维,虽然难以想象但我们完全不用管这些,通过核函数便等价在原空间的维度计算了。在不知道使用何种核函数进行映射的时候,我们一般选择径向基(高斯)核函数,准确率比较高,其实当前对核函数选择并没有比较好的方法,以实验为主。

下面有大牛介绍的更好的版本,写完才看到。。

http://blog.csdn.net/alvine008/article/details/9097105

以下是对sklearn库中svm的介绍:

class sklearn.svm.SVC(C=1.0, kernel='rbf', degree=3, gamma='auto', coef0=0.0, shrinking=True, probability=False, tol=0.001, cache_size=200, class_weight=None, verbose=False, max_iter=-1, decision_function_shape=None, random_state=None)参数:

C:

C-SVC的惩罚参数C,也就是优化函数中松弛变量的系数,默认值是1.0。 C越大,相当于惩罚松弛力度越强,(由于惩罚项是加在后面的而且求的是函数最小值),对训练集分类要求更严格,这样对训练集测试时准确率很高,但泛化能力弱。C值小,对误分类的惩罚减小,允许容错,将他们当成噪声点,泛化能力较强。

kernel:

核函数,默认是rbf,可以是‘linear’, ‘poly’, ‘rbf’, ‘sigmoid’, ‘precomputed’

0 – 线性:u'v

1 – 多项式:(gamma*u'*v + coef0)^degree

2 – RBF函数:exp(-gamma|u-v|^2)

3 –sigmoid:tanh(gamma*u'*v + coef0)

degree :多项式poly函数的维度,默认是3,选择其他核函数时会被忽略。

gamma:

‘rbf’,‘poly’ 和‘sigmoid’的核函数参数。默认是’auto’,则会选择1/n_features

coef0 :

核函数的常数项。对于‘poly’和 ‘sigmoid’有用。

923

923

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?