模型训练

目标函数

三类语言模型的目标函数:

只包含解码器(Decoder-only)的模型(例如,GPT-3):计算单向上下文嵌入(contextual embeddings),一次生成一个token

只包含编码器(Encoder-only)的模型(例如,BERT):计算双向上下文嵌入

编码器解码器(Encoder-decoder)模型(例如,T5):编码输入,解码输出

Decoder-only 模型

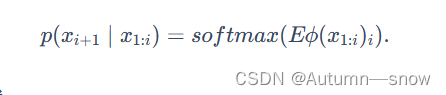

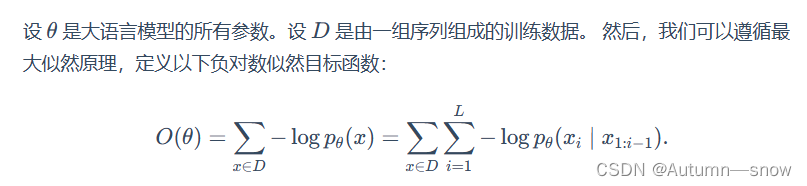

- 最大似然:

Encoder-only 模型

- 单向到双向:使用上述最大似然可以训练得到Decoder-only模型,它会产生(单向)上下文嵌入。但如果我们不需要生成,我们可以提供更强的双向上下文嵌入。

- BERT

- 掩码语言模型(Masked language modeling)

- 下一句预测(Next sentence prediction)

- RoBERTa

- RoBERTa对BERT进行了改进

- 删除了下一句预测这一目标函数(发现它没有帮助)。

- 使用更多数据训练(16GB文本 ⇒ 160GB文本 )。

- 训练时间更长。

- RoBERTa在各种基准上显著提高了BERT的准确性(例如,在SQuAD上由81.8到89.4)。

Encoder-decoder 模型

首先像BERT一样对输入进行双向编码。

然后像GPT-2一样对输出进行自回归解码。

BART (Bidirectional Auto-Regressive Transformers)

- 使用与RoBERTa相同的编码器架构(12层,隐藏维度1024)。

- 使用与RoBERTa相同的数据进行训练(160GB文本)。

- 基于BERT的实验,最终模型进行以下了变换:

- 掩码文档中30%的token

- 将所有子句打乱

T5 (Text-to-Text Transfer Transformer)

- 以分类任务任务为例,不同模型的差异如下:

- BERT使用 [CLS] 的嵌入来预测

- T5、GPT-2、GPT-3等(生成模型)将分类任务转换成自然语言生成

- 注意:

- 论文对整个pipline的许多方面(数据集、模型大小、训练目标等)进行了深入研究。

- 基于这些见解,他们训练了一个11B的模型。

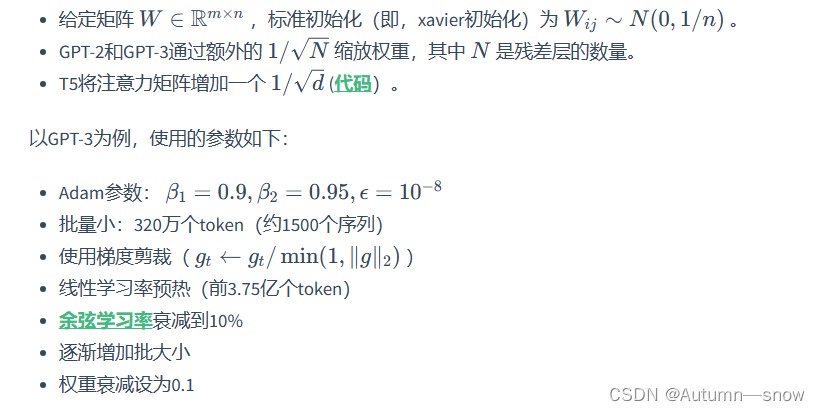

优化算法

随机梯度下降(SGD)

- 针对经典优化:二阶方法、约束优化等。

- 针对机器学习:随机方法、隐式正则化+早停法

- 针对深度学习:初始化、归一化(更改模型架构)

- 针对大语言模型:由于稳定性问题,学习率和一些直觉(例如,二阶方法)仍然有用,但要使大语言模型有效训练,还需要克服许多其他独特的挑战。不幸的是,其中大部分内容都是特别的,人们对此了解甚少。

Adam (adaptive moment estimation)

- Adam算法拥有以下两个创新:

- 引入动量(继续朝同一方向移动)。

- 参数 θ0的每个维度都有一个自适应(不同)的步长(受二阶方法启发)。

AdaFactor

- AdaFactor是一种为减少存储占用的优化算法。它有如下特点:

- 它不储存 m t ,v t这样的 O(m×n) 矩阵,而是存储行和列的和 O(m+n) 并重构矩阵

- 去除动量

- 它被用来训练T5

- AdaFactor可能使训练变得困难(见Twitter thread和blog post)

混合精度训练

- 混合精度训练是另一种减少存储的方法

- 通常来说,默认的精度是:FP32(32位浮点)

- 其他可选精度:FP16(16位浮点),但问题是任何小于 2 −24的值都变为0。

- 解决方案:将主权重存储在FP32中,并在FP16中执行其他所有操作。

- 损失缩放:按比例放大损失,以避免梯度数值太小。

- 结果:存储减少了一半。

学习率

- 通常情况下,学习率会随着时间的推移而衰减。

- 对于Transformer模型,我们实际上需要通过预热(warmup)提高学习率。

- Huang et al., 2020表明,一个潜在的原因是防止层归一化的梯度消失,导致使用Adam优化器训练时不稳定。

2456

2456

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?