An Interactive Multi-Task Learning Network for End-to-End Aspect-Based Sentiment Analysis

简单来说

本文是将aspect extraction和aspect senmetiment classification整合成一个任务,然后同时用document语料进行多任务训练一部分共享参数,解决as问题数据集小的问题。

摘要

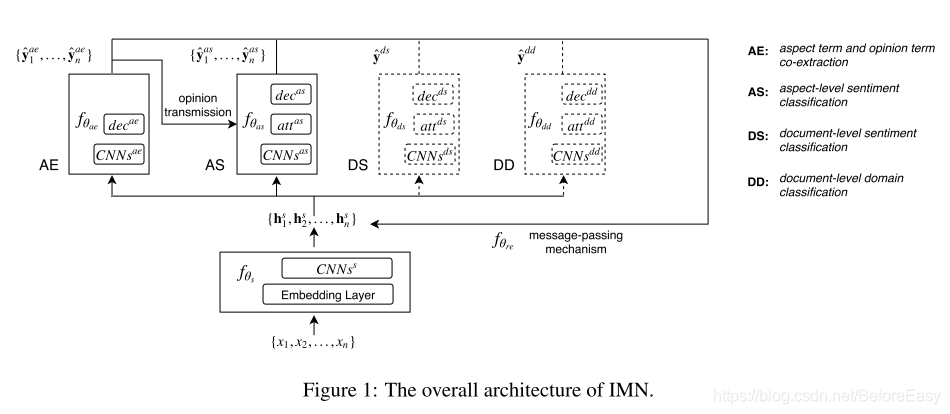

这篇文章提出了一个交互式的多任务学习网络 interactive multi-task learning network,可以同时联合学习多个相关的任务,既有token level 又有document level。不像传统多任务学习方法那样只依赖不同任务的公共特征,IMN引入一种message passing architecture,信息可以同各国一套共享的latent variables迭代的在不同的任务间传递。

实验效果很好。

介绍

常规的处理ABSA的问题是拆成两个问题,pipeline进行,也有一些联合训练的,但是那些联合训练的方法中,两个任务只是通过统一的标签联系在一起,但相互的联系并不明确。此外,还都只从方面级语料中学习,但是方面级语料库又很小,没有好好的利用其他预料的信息,比如相关的文档级情感分析语料,这些语料里又有用的情感相关的语言学知识,而且更容易得到。

这篇文章介绍了IMN,同时解决AE和AS的问题,而且更好的利用了两个任务间的联系。此外,这里AE和AS和文档级别任务一同训练,利用了更大的语料里的信息;还引入了一个比较新的消息传递机制,将有用的信息从不同的任务发送回共享的潜在表示。然后这些信息和共享的潜在表示组合起来,用于后续过程。 这个过程是迭代 进行的,随着迭代次数增加,信息可以在多个链接间被修改和传播。与多数多任务学习相比,IMN不仅允许共享特征,还可以通过这个消息传递机制,显式的建模任务之间的相互作用。

此外IMN还集成了两个文档级别分类任务:情感分类(DS)和领域分类(DD),和AE AS一起训练。

相关工作

多任务学习

传统的多任务学习是用一个共享的网络和两个task specific网络来得到一个共享的特征空间和两个task-specific特征空间。通过使用共享表示并行学习语义相关的任务,在某些情况下,多任务学习可以捕获任务之间的相关性并提高模型泛化能力。

不过传统的多任务学习并没有显式的建模任务间的相互关系——两个任务仅仅通过错误反向传播相互影响,以学习特征,而这种相互作用是不可控的。

IMN就是不仅共享表示,还通过消息传递机制显式建模任务间的关系。

信息传递机制

CV和NLP中都研究过消息传递图形模型推理算法的网络表示。将这些消息传递算法的执行建模为网络会导致递归神经网络体系结构。我们也是类似的在网络中传播信息学习更新,但是设计的结构是为了解决多任务学习问题。我们的算法可以大致堪称是RNN结构,因为每次迭代更新潜在表示用的是相同的网络结构。

proposed method

结构如图1,输入是一组tokens,到

f

θ

s

f_{\theta_s}

fθs中提取特征。

就是用几层CNN在词嵌入的基础上进一步提取了特征。

这一层的输出是

在各个任务之间共享使用。这个表示后面会用从不同的任务中传播过来的信息,进行更新。

这组表示会进而用于不同任务的输入。每个任务组件有自己一套输出,是一组标签序列。在AE任务中,输出每个单词的label表示是否是方面词或情感词;在AS中,标定词的词性。在分类任务中,输出和输入实例有关,DS输出情感,DD输出domain。每次迭代中,恰当的信息会传回上面那组共享的表示。在各个组件之间也能信息传递,尤其是对这个题目而言,把信息从AE任务传递到AS。经过T次信息传递迭代后用output variables做预测。

3.1 aspect-level tasks

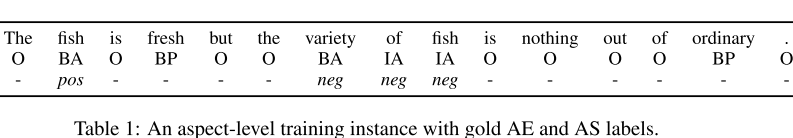

AE要提取所有的aspect和opinion词,用五级标记: ,AS也是序列标注问题,三级标记:

,AS也是序列标注问题,三级标记: ,只标注aspect词。一个例子是这样的:

,只标注aspect词。一个例子是这样的:

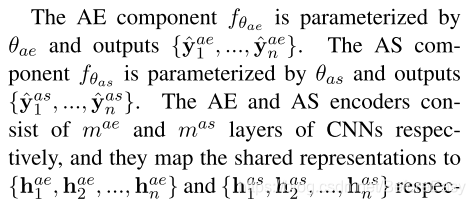

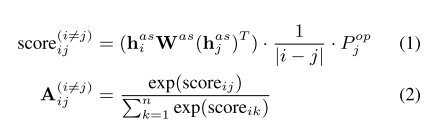

在AS中还有层额外的self-attention,AS层可以得到AE层的输出,这样AS任务可以多少利用AE中提取的opinion word,具体attention计算如下:

在公式1中,第一个因子是衡量两者相关性,第二个是距离,两个词间距离越大这一项越小,第三项表明第j项是opinion word的概率,是通过求和AE输出中BP IP标签来求的。这样,AS直接受AE影响。

在AE中,把word embedding ,初始共享表示和task specific 拼接起来作为最后的第i个token的表示。

在AS中,把共享表示及self-attention之后的表示拼接起来作为最后的表示。每个任务都有全连接层过softmax计算概率。

document-level tasks

为了解决aspect-level 训练数据不足的问题,IMN引入有情感信息的文档级别语料。引入两个文档级分类任务加入联合训练,分别是文档级情感分类和文档级领域分类。

两个都是多层CNN然后attention层 然后decode层,共享表示过了CNN之后,用softmax方式计算attention,最终得到加权和的表示过全连接和softmax

message passing mechanism

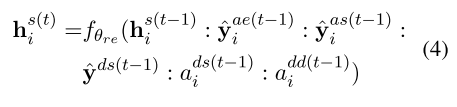

为了利用不同任务之间的交互,消息传递机制汇总了上一次迭代中不同任务的预测,并用这些信息来更新这次迭代中的共享表示。

:表示拼接,f表示ReLu激活的全连接。a表示注意力之后的表示,与情感或领域相关度更高的词更可能成为opinion word或aspect word

learning

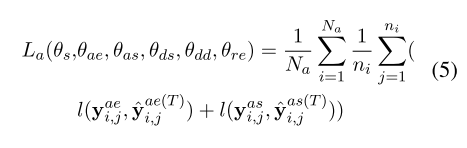

交替在aspect level 和document level上进行训练。在asoect-level:

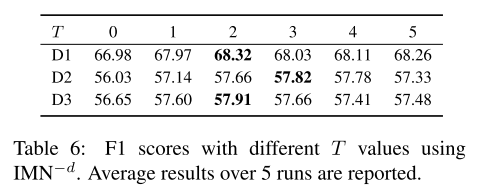

T 是迭代的最大次数,

N

a

N_a

Na表示aspect-levle训练数据总数,ni表示第i个训练实例中的token数,y表示的是各自标签的one-hot编码,l表示cross entropy loss。只考虑aspect term。

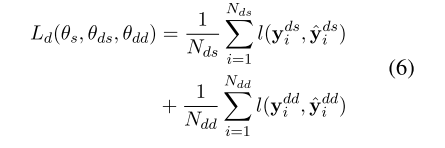

在document-level loss中:

在训练document level时不需要用到message passing mechanism

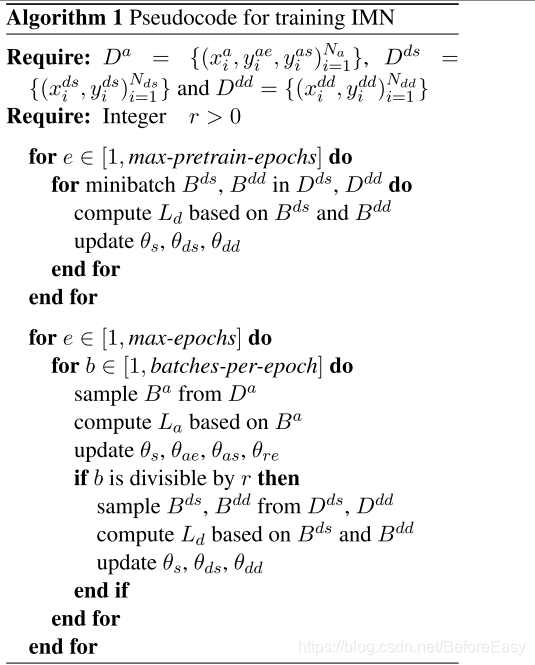

首先用document-level数据预训练网络几轮,然后以比率r在aspect level和 document level交替训练。算法如下:

D表示训练数据

experiments

数据: Semeval2014 Semeval2015,以及两个document-level的数据集。

这部分主要是实验参数设置

结果分析

表3展示了结果。

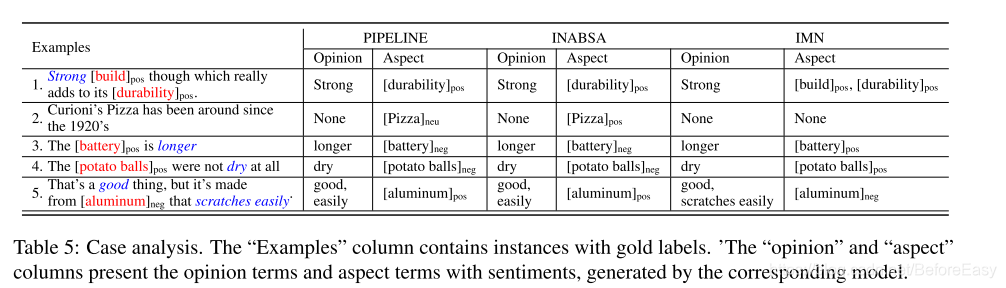

case study的结果:

通过比对,发现document-level引入的信息是很有用的。

结论

提出一个multi-task learning network,联合训练aspect及opinion term的抽取 和aspect 情感分类。提出的IMN还引入了新颖的消息传递机制,更好的利用任务间的联系。此外,还能从其他训练数据集中获得信息,从document-level数据中获得对aspect有价值的信息。这个模型也可以用在一些其他相关的任务中。

704

704

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?