Centos 7 上配置 HDFS(单机版)

一、配置Java环境

二、配置Hadoop

前提是配置好java 环境;

1、配置ssh免密登录

(1)

ssh-keygen

一直回车

(2)将生成的密钥发送到本机地址

ssh-copy-id localhost

(注意:若报错找不到命令则需要安装openssh-clients执行:yum -y install openssh-clients 即可)

(3)测试免登录是否成功

ssh localhost

2、安装hadoop

(1)下载Hadoop

https://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-3.1.3/hadoop-3.1.3.tar.gz

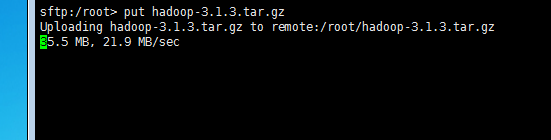

(2)、通过第三方软件 Xshell 将已下载好的Hadoop上传到Centos系统上

首先将下载的包放在Xshell的安装目录下

用 Xshell FTP链接centos

在命令界面输入

put XXX.tar.gz

如下图所示,稍等一会就上传完毕。

(3)开始安装hadoop

解压缩文件

tar -zxvf haddop-XXX.tar.gz

配置hadoop环境变量: 编辑文件 /etc/profile

vim /etc/profile

在文件末尾添加如下(具体位置自看自己目录位置):

export HADOOP_HOME=/opt/hadoop-3.1.3

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

退出编辑后进行保存(该命令只在该命令窗口有效,若使其一直有效,重启系统即可)

source /etc/profile

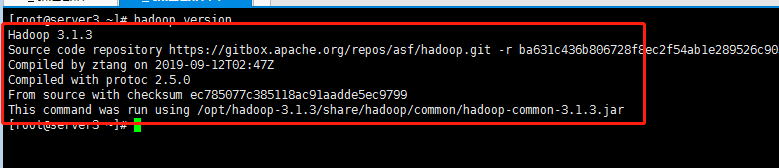

(4)验证hadoop是否安装成功

hadoop version

显示如图所示说明Hadoop安装成功,接下来只需要配置Hadoop 的配置文件即可

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-8ksDGxXB-1574124404790)(5.jpg)]

3、HDFS配置

(1)、Hadoop中的重要目录说明

1)bin目录:存放对Hadoop相关服务(HDFS,YARN)进行操作的脚本

2)etc目录:Hadoop的配置文件目录,存放Hadoop的配置文件

3)lib目录:存放Hadoop的本地库(对数据进行压缩解压缩功能)

4)sbin目录:存放启动或停止Hadoop相关服务的脚本

5)share目录:存放Hadoop的依赖jar包、文档、和官方案例

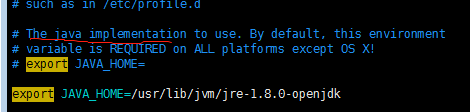

(2)、配置 hadoop下 /etc/hadoop 的 hadoop-env.sh 文件

在该文件中添加Java的JAVA_HOME

export JAVA_HOME=具体目录根据自己的环境配置

如下图所示

(3)、修改 hadoop下 /etc/hadoop 的 core-site.xml 文件

修改如下

<configuration>

<!--这里路径是namenode 、datanode 等存放的公共临时目录-->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/data_hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<!--设置hdfs中服务的主机和端口号-->

<property>

<name>fs.default.name</name>

<value>hdfs://192.168.249.133:9000</value>

</property>

</configuration>

(4)、修改 hadoop下 /etc/hadoop 的 hdfs-site.xml 文件

修改如下

<configuration>

<!--设置hdfs中的namenode文件目录-->

<property>

<name>dfs.namenode.name.dir</name>

<value>/opt/data_hadoop/dfs/name</value>

<final>true</final>

</property>

<!--设置hdfs中的datanode文件目录-->

<property>

<name>dfs.datanode.data.dir</name>

<value>/opt/data_hadoop/dfs/data</value>

<final>true</final>

</property>

<!--设置数据块副本(由于是单机所以1即可)-->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!--hdfs的访问权限设置为false-->

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

<!--web界面访问-->

<property>

<name>dfs.http.address</name>

<value>192.168.249.133:50070</value>

</property>

<!--开启webhdfs-->

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

</configuration>

(5)、格式化namenode

在启动hadoop集群前需要格式化namenode。需要注意的是,第一次安装Hadoop集群的时候需要格式化Namenode,以后直接启动Hadoop集群即可,不需要重复格式化Namenode。

在Hadoop目录下输入如下命令

bin/hdfs namenode -format

(6)、启动

启动前需要在start-dfs.sh加入以下,stop-dfs.sh 也需要加

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

在hadoop目录下输入

sbin/start-dfs.sh

(7)、访问(根据自己的地址来访问)

192.168.249.133:50070

282

282

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?