作者 | 汽车人 编辑 | 自动驾驶与AI

点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

点击进入→自动驾驶之心【3D目标检测】技术交流群

本文只做学术分享,如有侵权,联系删文

❝论文:https://arxiv.org/pdf/2301.01283.pdf

代码:https://github.com/junjie18/CMT

作者单位:旷视科技

论文思路:

本文提出了一种鲁棒三维检测器,命名为Cross Modal Transformer(CMT),用于端到端的三维多模态检测。没有显式的视图转换,CMT将图像和点云tokens作为输入,并直接输出精确的3D bounding boxes。通过将三维点编码为多模态特征,实现多模态tokens的空间对齐。CMT的核心设计相当简单,但其性能却令人印象深刻。它在nuScenes测试集上获得了74.1%的NDS(最先进的single model),同时保持了更快的推理速度。此外,即使缺少LiDAR,CMT也具有很强的鲁棒性。

主要贡献:

本文提出了一种快速鲁棒的三维检测器,这是一个真正的端到端框架,没有任何后处理。它克服了传感器丢失的问题。

3D位置被编码到多模态tokens 中,没有任何复杂的操作,如grid sampling and voxel-pooling。

CMT在nuScenes数据集上实现了最先进的3D检测性能。它为未来的研究提供了一个简单的基线。

网络设计:

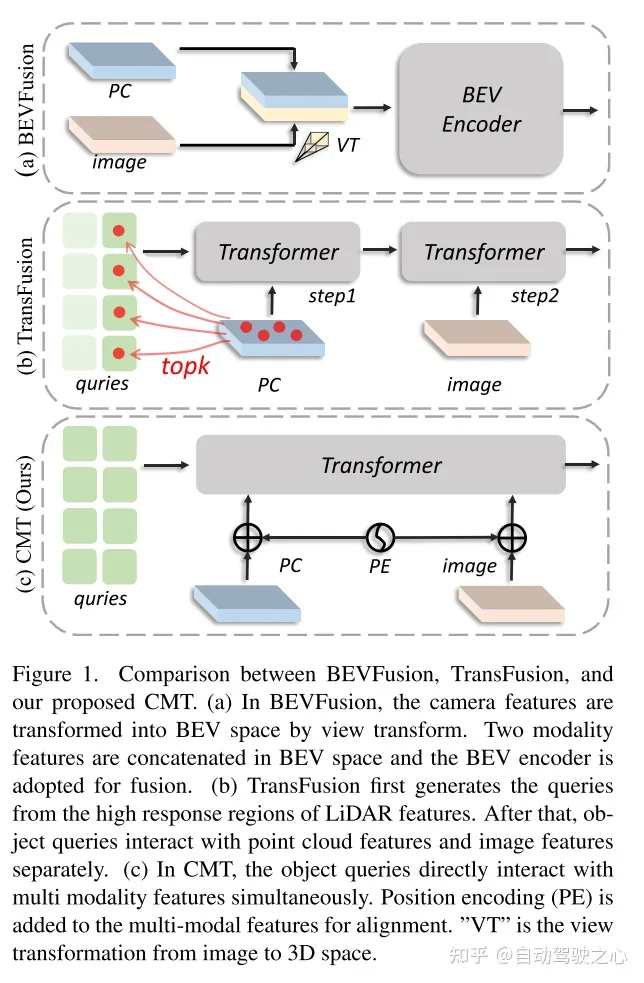

图1。比较BEVFusion,TransFusion,和本文的提出的CMT。(a)在BEVFusion中,通过视图变换将摄像机的特征转化为BEV空间。将两种模态特征串接在BEV空间中,采用BEV编码器进行融合。(b)TransFusion首先从LiDAR特征的高响应区域产生queries。然后,目标queries分别与点云特征和图像特征交互。(c)在CMT中,目标queries直接与多模态特征同时交互。位置编码(PE)被添加到多模态特征进行对齐。VT是指从图像到三维空间的视图转换。

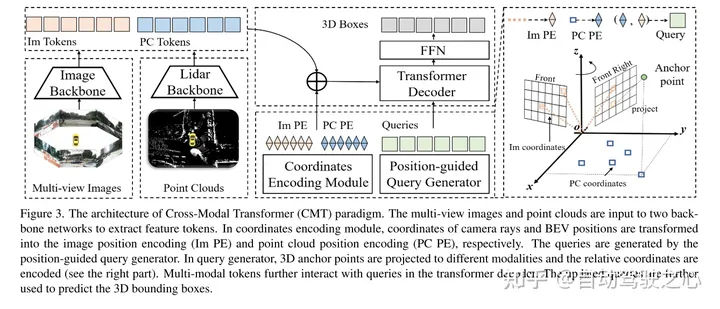

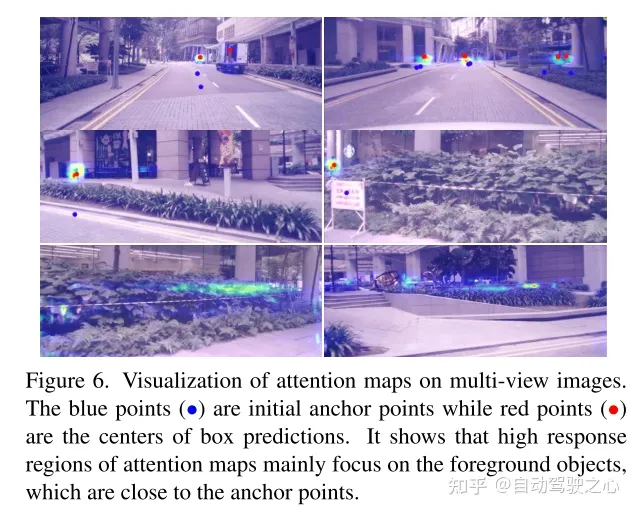

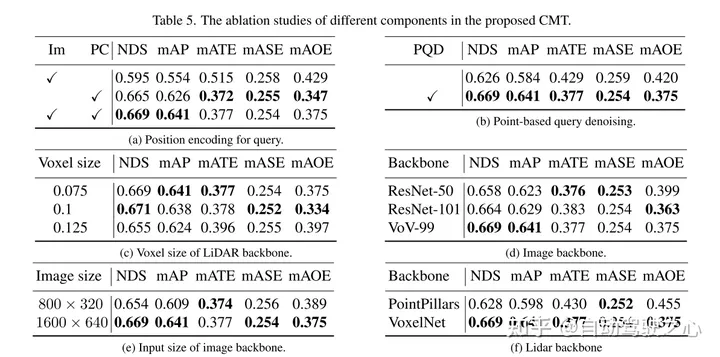

图3。Cross-Modal Transformer(CMT)范式的体系结构。多视图图像和点云被输入到两个主干网中以提取特征tokens。在坐标编码模块中,将摄像机光线坐标和BEV位置分别转换为图像位置编码(Im PE)和点云位置编码(PC PE)。queires是由位置引导的query生成器生成的。在query生成器中,将3D anchor points投射到不同的模态,并对相对坐标进行编码(见右图)。多模态tokens进一步与transformer解码器中的queries进行交互。更新后的queries被进一步用于预测3D bounding boxes。

提出的CMT的总体架构如图3所示。多视图图像和LiDAR点被送入两个单独的骨架提取多模态tokens。通过坐标编码将3D坐标编码到多模态tokens中。使用位置引导的query生成器的queries与transformer解码器中的多模态tokens进行交互,然后预测目标类和3D bounding boxes。整个框架是在完全端到端方式学习,LiDAR骨干是从零开始训练,没有预训练。

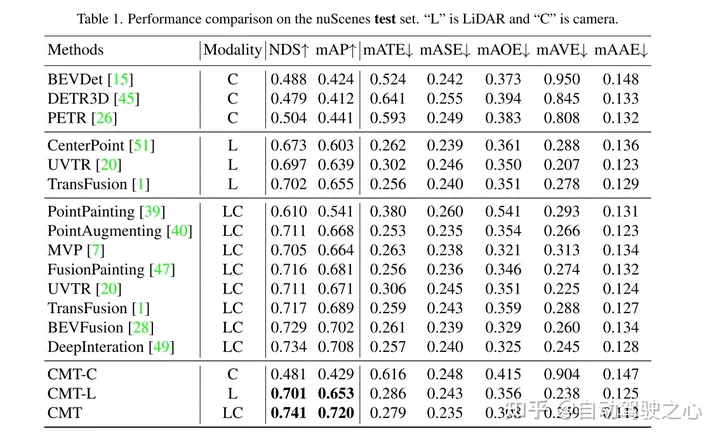

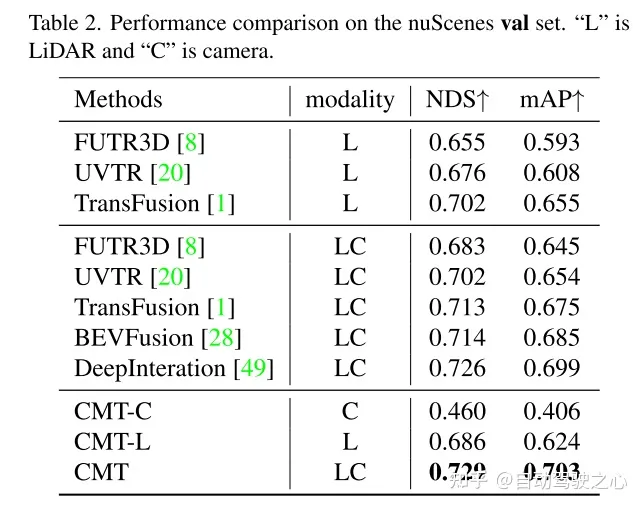

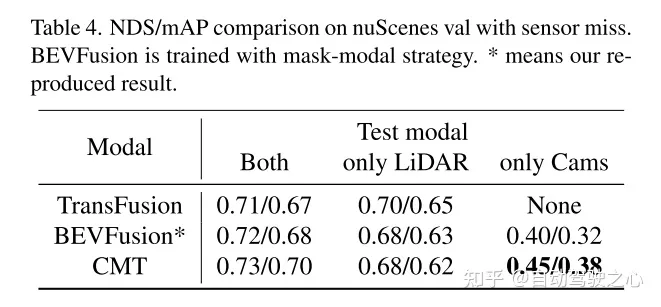

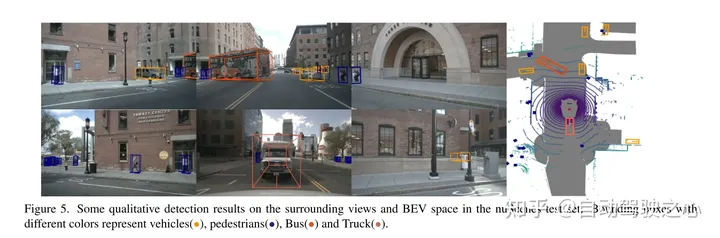

实验结果:

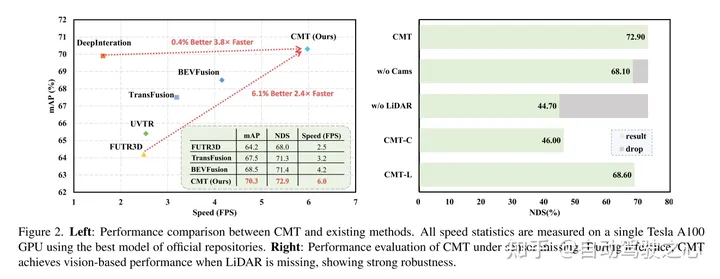

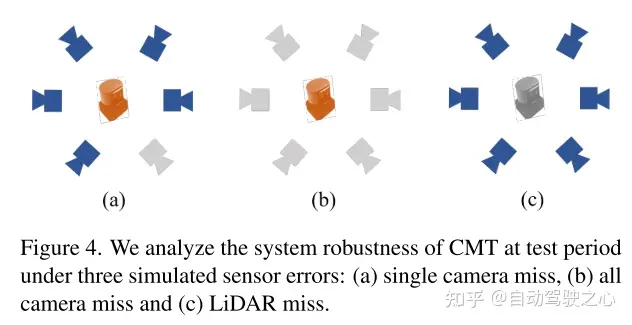

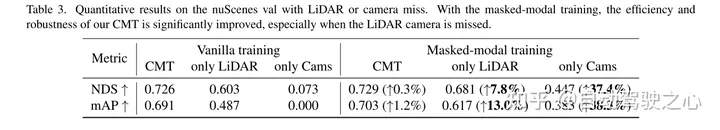

图2。左:CMT与现有方法的性能比较。所有的速度统计数据都是在使用官方存储库中最好的模型的单个 Tesla A100 GPU上测量的。右:缺失传感器下的CMT性能验证。在推理过程中,当LiDAR缺失时,CMT实现了基于视觉的性能,表现出较强的鲁棒性。

① 全网独家视频课程

BEV感知、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、点云3D目标检测、目标跟踪、Occupancy、cuda与TensorRT模型部署、协同感知、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码学习)

视频官网:www.zdjszx.com

视频官网:www.zdjszx.com

② 国内首个自动驾驶学习社区

近2000人的交流社区,涉及30+自动驾驶技术栈学习路线,想要了解更多自动驾驶感知(2D检测、分割、2D/3D车道线、BEV感知、3D目标检测、Occupancy、多传感器融合、多传感器标定、目标跟踪、光流估计)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频,期待交流!

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多模态感知、Occupancy、多传感器融合、transformer、大模型、点云处理、端到端自动驾驶、SLAM、光流估计、深度估计、轨迹预测、高精地图、NeRF、规划控制、模型部署落地、自动驾驶仿真测试、产品经理、硬件配置、AI求职交流等方向。扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】平台矩阵,欢迎联系我们!

357

357

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?