点击下方卡片,关注“自动驾驶之心”公众号

戳我-> 领取自动驾驶近15个方向学习路线

今天自动驾驶之心为大家分享北京交通大学&KargoBot(卡尔动力)最新的工作—UAD!文章提出了一种基于视觉的端到端自动驾驶方法,大幅超越UniAD近40%!如果您有相关工作需要分享,请在文末联系我们!

也欢迎添加小助理微信AIDriver004,加入我们的技术交流群

论文作者 | Mingzhe Guo等

编辑 | 自动驾驶之心

写在前面

动机来源于对当前E2E AD模型仍模仿典型驾驶堆栈中模块化架构的观察,这些模型通过精心设计的监督感知和预测子任务为定向规划提供环境信息。尽管取得了突破性的进展,但这种设计也存在一些缺点:

1)先前的子任务需要大量高质量的3D标注作为监督,给训练数据的扩展带来了重大障碍;

2)每个子模块在训练和推理中都涉及大量的计算开销。

为此,这里提出了UAD,一种使用无监督agent的E2EAD框架,以解决所有这些问题。首先,设计了一种新颖的角度感知预训练任务,以消除对标注的需求。该预训练任务通过预测角度空间的目标性和时间动态来模拟驾驶场景,无需手动标注。其次,提出了一种自监督训练策略,该策略学习在不同增强视图下预测轨迹的一致性,以增强转向场景中的规划鲁棒性。UAD在nuScenes的平均碰撞率上相对于UniAD实现了38.7%的相对改进,并在CARLA的Town05 Long基准测试中在驾驶得分上超过了VAD 41.32分。此外,所提出的方法仅消耗UniAD 44.3%的训练资源,并在推理中运行速度快3.4倍。创新设计不仅首次展示了相较于监督对手无可争辩的性能优势,而且在数据、训练和推理方面也具有前所未有的效率。

开放和闭环评估的代码和模型将在:https://github.com/KargoBot_Research/UAD 上进行发布。

领域背景介绍

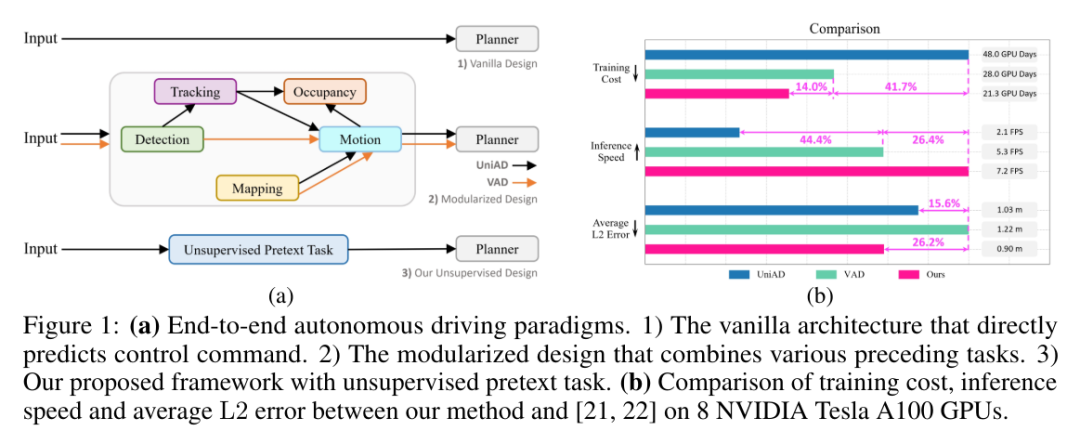

近几十年来,自动驾驶领域取得了突破性的成就。端到端范式,即寻求将感知、预测和规划任务整合到一个统一框架中的方法,已成为一个代表性的分支。端到端自动驾驶的最新进展极大地激发了研究人员的兴趣。然而,之前已在环境建模中证明其效用的手工制作且资源密集型的感知和预测监督子任务,如图1a所示,仍然是不可或缺的。

那么,从最近的进展中获得了哪些启示?我们注意到,其中一个最具启发性的创新在于基于Transformer的pipeline,其中查询作为连接各个任务的纽带,无缝地连接了不同的任务。此外,环境建模的能力也得到了显著提升,这主要归功于监督子任务之间复杂的交互作用。但是,每枚硬币都有两面。与原始设计(见图1a)相比,模块化方法带来了不可避免的计算和标注开销。如图1b所示,最近的UniAD方法的训练需要48个GPU day,并且每秒仅运行2.1帧(FPS)。此外,现有感知和预测设计中的模块需要大量高质量标注的数据。人工标注的财务开销极大地阻碍了带有监督子任务的这种模块化方法利用海量数据的可扩展性。正如大型基础模型所证明的,扩大数据量是将模型能力提升到下一个层次的关键。因此,这里也问自己一个问题:在减轻对3D标注的依赖的同时,设计一个高效且稳健的E2EAD框架是否可行?

本文提出一种创新的端到端自动驾驶(UAD)的无监督预训练任务,展示了答案是肯定的。该预训练任务旨在有效地建模环境。该预训练任务包括一个角度感知模块,通过学习预测BEV(Bird's-Eye View,鸟瞰图)空间中每个扇形区域的目标性来学习空间信息,以及一个角度梦境解码器,通过预测无法访问的未来状态来吸收时间知识。引入的角度查询将这两个模块连接成一个整体的预训练任务来感知驾驶场景。值得注意的是,方法完全消除了对感知和预测的标注需求。这种数据效率是当前具有复杂监督模块化的方法无法实现的。学习空间目标性的监督是通过将一个现成的开放集检测器的2D感兴趣区域(ROIs)投影到BEV空间来获得的。虽然利用了其他领域(如COCO)手动标注的公开可用的开放集2D检测器进行预训练,但避免了在我们的范式和目标域(如nuScenes和CARLA)中需要任何额外的3D标签,从而创建了一个实用的无监督设置。此外,还引入了一种自监督的方向感知学习策略来训练规划模型。具体来说,通过为视觉观测添加不同的旋转角度,并对预测应用一致性损失,以实现稳健的规划。无需额外的复杂组件,提出的UAD在nuScenes平均L2误差方面比UniAD高0.13m,在CARLA路线完成得分方面比VAD高9.92分。如图1b所示,这种前所未有的性能提升是在3.4倍的推理速度、UniAD的仅44.3%的训练预算以及零标注的情况下实现的。

总结来说,贡献如下:

提出了一种无监督的预训练任务,摒弃了端到端自动驾驶中3D手工标注的需求,使得训练数据扩展到数十亿级别成为可能,而无需承担任何标注负担;

引入了一种新颖的自监督方向感知学习策略,以最大化不同增强视图下预测轨迹的一致性,从而增强了转向场景中的规划鲁棒性;

与其他基于视觉的端到端自动驾驶方法相比,提出的方法在开放和闭环评估中都表现出优越性,同时计算成本和标注成本大大降低。

UAD方法介绍

如图2所示,UAD(端到端自动驾驶)框架由两个基本组件组成:1) 角度感知预训练任务,旨在以无监督的方式将E2EAD(端到端自动驾驶)从昂贵的模块化任务中解放出来;2) 方向感知规划,学习增强轨迹的自监督一致性。具体来说,UAD首先使用预训练任务对驾驶环境进行建模。通过在BEV(鸟瞰图)空间中估计每个扇形区域的目标性来获取空间知识。引入的角度查询,每个查询负责一个扇形区域,用于提取特征和预测目标性。监督标签是通过将2D感兴趣区域(ROIs)投影到BEV空间来生成的,这些ROIs是使用现有的开放集检测器GroundingDINO预测的。这种方法不仅消除了对3D标注的需求,还大大降低了训练成本。此外,由于驾驶本质上是一个动态和连续的过程,因此我们提出了一个角度梦境解码器来编码时间知识。梦境解码器可以看作是一个增强的世界模型,能够自回归地预测未来状态。

接下来,引入了方向感知规划来训练规划模块。原始的BEV特征通过添加不同的旋转角度进行增强,生成旋转的BEV表示和自车轨迹。我们对每个增强视图的预测轨迹应用自监督一致性损失,以期望提高方向变化和输入噪声的鲁棒性。这种学习策略也可以被视为一种专门为端到端自动驾驶定制的新型数据增强技术,增强了轨迹分布的多样性。

1)角度感知预训练任务

空间表征学习。模型试图通过预测BEV(鸟瞰图)空间中每个扇形区域的目标性来获取驾驶场景的空间知识。具体来说,以多视图图像作为输入,BEV编码器首先将视觉信息提取为BEV特征。然后,被划分为以自车为中心的K个扇形,每个扇形包含BEV空间中的几个特征点。将扇区的特征表示为,其中N是所有扇区中特征点的最大数量,从而得出角度BEV特征。对于特征点少于N的扇区,应用零填充。

那么,为什么要将矩形的BEV特征划分为角度格式呢?根本原因是,在缺少深度信息的情况下,对应于二维图像中ROI的BEV空间区域是一个扇形。如图3a所示,通过将3D采样点投影到图像上并验证它们在2D ROIs中的存在性,生成了一个BEV对象掩码,表示BEV空间中的目标性。具体来说,落在2D ROIs内的采样点被设置为1,而其他点被设置为0。注意到,在BEV空间中,正扇形不规则且稀疏地分布。为了使目标性标签更加紧凑,类似于BEV特征划分,将M均匀地分为K个等份。与正扇形重叠的段被赋值为1,构成了角度目标性标签。得益于开放集检测的快速发展,通过向二维开放集检测器(如GroundingDINO)输入预定义的提示(例如,车辆、行人和障碍物),方便地获取输入多视图图像的2D ROIs,这种设计是降低标注成本和扩展数据集的关键。

为了预测每个扇区的objectness得分,这里定义了角度查询来汇总。在中,每个角度查询都会通过交叉注意力机制与对应的f进行交互:

最后,使用一个线性层将映射为目标性得分,该得分由监督,并使用二元交叉熵损失(表示为)进行训练。

时间表征学习。这里提出使用角度梦境解码器来捕获驾驶场景的时间信息。如图3b所示,解码器以自回归的方式学习每个扇区的转移动态,类似于世界模型的方式。假设规划模块预测了未来T步的轨迹,那么梦境解码器相应地包含T层,其中每一层都根据学习到的时间动态更新输入的角度查询和角度BEV特征。在第t步,查询首先通过门控循环单元(GRU)从观测特征中捕获环境动态,这生成了(隐藏状态):

在以前的世界模型中,隐藏状态Q仅用于感知观察到的场景。因此,GRU迭代在t步随着最终观测的获取而结束。在我们的框架中,Q也用于预测未来的自车轨迹。然而,未来的观测,例如是不可用的,因为世界模型的设计初衷是仅根据当前观测来预测未来。为了获得,首先提出更新以提供伪观测,

然后,通过方程2以及和作为输入,可以生成。

遵循世界模型中的损失设计,分别将和映射到分布µσ和µσ,然后最小化它们的KL散度。的先验分布被视为对未来动态的预测,而无需观测。相反,的后验分布表示具有观测的未来动态。两个分布之间的KL散度衡量了想象中的未来(先验)和真实未来(后验)之间的差距。我们期望通过优化梦境损失来增强长期驾驶安全性的未来预测能力:

2)方向感知规划

规划头。角度感知预训练的输出包含一组角度查询{}。对于规划,相应地初始化T个自车查询{}来提取与规划相关的信息,并预测每个未来时间步的自车轨迹。自车查询和角度查询之间的交互是通过交叉注意力机制进行的:

规划头以自车特征(来自)和驾驶指令c作为输入,并输出规划轨迹。

方向增强。观察到训练数据主要由直行场景主导,这里提出了一种方向增强策略来平衡分布。如图4所示,BEV特征以不同的角度r ∈ R = {90◦, 180◦, 270◦}进行旋转,产生旋转后的表示{}。这些增强的特征也将用于预训练任务和规划任务,并由上述损失函数进行监督。值得注意的是,BEV目标maskM和真实自车轨迹Gtraj也会进行旋转,以提供相应的监督标签。

此外,我们提出了一个辅助任务来增强转向能力。具体来说,基于自车查询预测自车意图操作的规划方向(即左、直或右),这将映射到三个方向的概率。方向标签是通过将真实轨迹 Gt_traj(x) 的x轴值与阈值δ进行比较来生成的。具体来说,如果-δ < Gt_traj(x) < δ,则被赋值为直行;否则,对于Gt_traj(x) ⩽ -δ/Gt_traj(x) ⩾ δ,则分别被赋值为left/right。使用交叉熵损失来最小化方向预测和方向标签之间的差距,记作。

方向一致性。针对引入的方向增强,这里提出了一个方向一致性损失,以自监督的方式改进增强的规划训练。需要注意的是,增强的轨迹预测包含了与原始预测相同的场景信息,即具有不同旋转角度的BEV特征。因此,考虑预测之间的一致性并调节由旋转引起的噪声是合理的。规划头应更加鲁棒于方向变化和输入干扰。具体来说,首先将旋转回原始场景方向,然后与应用L1损失。

实验对比

在nuScenes数据集上进行了开环评估实验,该数据集包含40,157个样本,其中6,019个样本用于评估。遵循之前的工作,采用了L2误差(以米为单位)和碰撞率(以百分比为单位)作为评估指标。值得注意的是,还纳入了BEV-Planner中提出的与道路边界的交并比(以百分比为单位)作为评估指标。对于闭环设置,遵循之前的工作,在CARLA模拟器的Town05 基准上进行评估。使用路线完成率(以百分比为单位)和驾驶评分(以百分比为单位)作为评估指标。采用基于查询的view transformer从多视图图像中学习BEV特征。开放集2D检测器的置信度阈值设置为0.35,以过滤不可靠的预测。用于划分BEV空间的角度θ设置为4◦(K=360◦/4◦),默认阈值δ为1.2m。等式8中的权重系数分别设置为2.0、0.1、1.0、2.0、1.0。模型在8个NVIDIA Tesla A100 GPU上训练了24个epoch,每个GPU的bs大小为1。

在nuScenes中的开环规划性能。† 表示基于激光雷达的方法,‡ 表示VAD和ST-P3中使用的TemAvg评估协议。⋄ 表示在规划模块中使用自车状态,并遵循BEV-Planner 计算碰撞率。

参考

[1] End-to-End Autonomous Driving without Costly Modularization and 3D Manual Annotation.

投稿作者为『自动驾驶之心知识星球』特邀嘉宾,欢迎加入交流!

① 全网独家视频课程

BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、cuda与TensorRT模型部署、大模型与自动驾驶、Nerf、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

网页端官网:www.zdjszx.com

网页端官网:www.zdjszx.com

② 国内首个自动驾驶学习社区

国内最大最专业,近3000人的交流社区,已得到大多数自动驾驶公司的认可!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(2D/3D检测、语义分割、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型、端到端等,更有行业动态和岗位发布!欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦感知、定位、融合、规控、标定、端到端、仿真、产品经理、自动驾驶开发、自动标注与数据闭环多个方向,目前近60+技术交流群,欢迎加入!扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】全平台矩阵

689

689

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?