目录

前言

上一篇爬虫我们已经提及到了urllib库的使用,为了方便大家的使用过程,这里为大家介绍新的库来实现请求获取响应的库。

一、Requests是什么?

Requests is an elegant and simple HTTP library for Python, built for human beings.

翻译过来就是;Requests 是一个为人类所搭建的PythonHTTP文库,具有优雅而简洁的特点。

二、使用步骤

1.引入库

代码如下(示例):

import requests

2.请求

代码如下(示例):

url='https://www.baidu.com'

headers={

'User-Agent':'这里加入你自己的UA'

}

response=requests.get(url=url,headers=headers)

只需要用库去用GET方法即可,体现出了elegant。

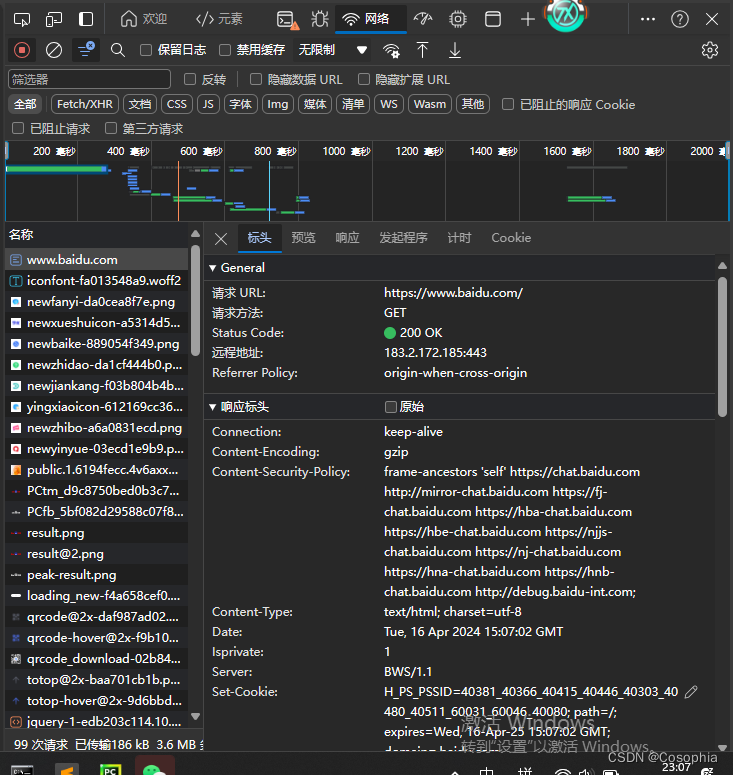

复习一下:首先要定制请求头,讲要请求的URL写到变量里方便get或者post方法的运用,那么对于get或者post请求的选择,具体看开发者工具里“网络”中的请求方式。

3.响应

代码如下(示例):

response.encoding='utf-8'

content=response.text为了能让我们看懂源代码,我们要对响应的结果进行编码('utf-8'),若不是响应结果不是二进制内容,例如图片的存储形式就是二进制,我们就可以用text获取源代码。

*tips

有些网站的反爬处理会十分的严格,一个ip若访问请求了十几次就会对你的ip进行一个封禁,而一些免费的ip并没有起到多大的作用,这里介绍一个提供IP池业务的商家,希望能够帮到大家:

三.总结

以上就是今天要讲的内容,本文仅仅简单介绍了requests的使用,而提供了大量能使我们快速便捷地处理数据的函数和方法。大多数内容跟urllib是没太大区别的,甚至还精简很多,对于爬虫玩家来说是十分友好的,希望你能去尝试一下,巩固一下,这里再做一个预告,在下一次我们将介绍如何使用Xpath对爬到的源代码进行解析,来获取我们想要的内容,敬请期待吧。

572

572

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?