今天分享分享如何通过 Stable Diffusion 快速创造出角色三视图。

这节会涉及到 ControlNet 中的 openpose 模型和 LoRA模型 CharTurnerBeta - Lora (EXPERIMENTAL)(这个模型非必备哈)。

如果你忘了 ControlNet 的使用,可以翻看前面的教程哦。

一 流程介绍

整个流程原理很简单,我们通过使用 ControlNet Openpose 模型根据我们上传的三视图骨骼图进行渲染。结合 CharTurnerBeta

Lora 模型增强效果。最后就能得到一张角色三视图

CharTurnerBeta Lora 的权重在 0.2-0.4 之间

二 使用

第一步:设置基础参数

模型:Deliberate_v2

提示词:(white background:1.5),A photographic style character turnaround of a an 1800's flamboyant pirate captain with a big feather in his hat and a peg leg. Parrot, eyepatch, mustache, grin, highly detailed face. Multiple views of the same character in the same outfit,<lora:mw_charturn3:0.4> charturnbetalora

采样方法:DPM++ 2M SDE Karras

种子:703262763

宽高:880x512

adetail:face_yolov8s.pt

* 1

* 2

* 3

* 4

* 5

* 6

* 7

如果不启用 ControlNet 直接出图看看效果

有一点点效果,但是三视图的效果不是很好,接着我们设置 ControlNet

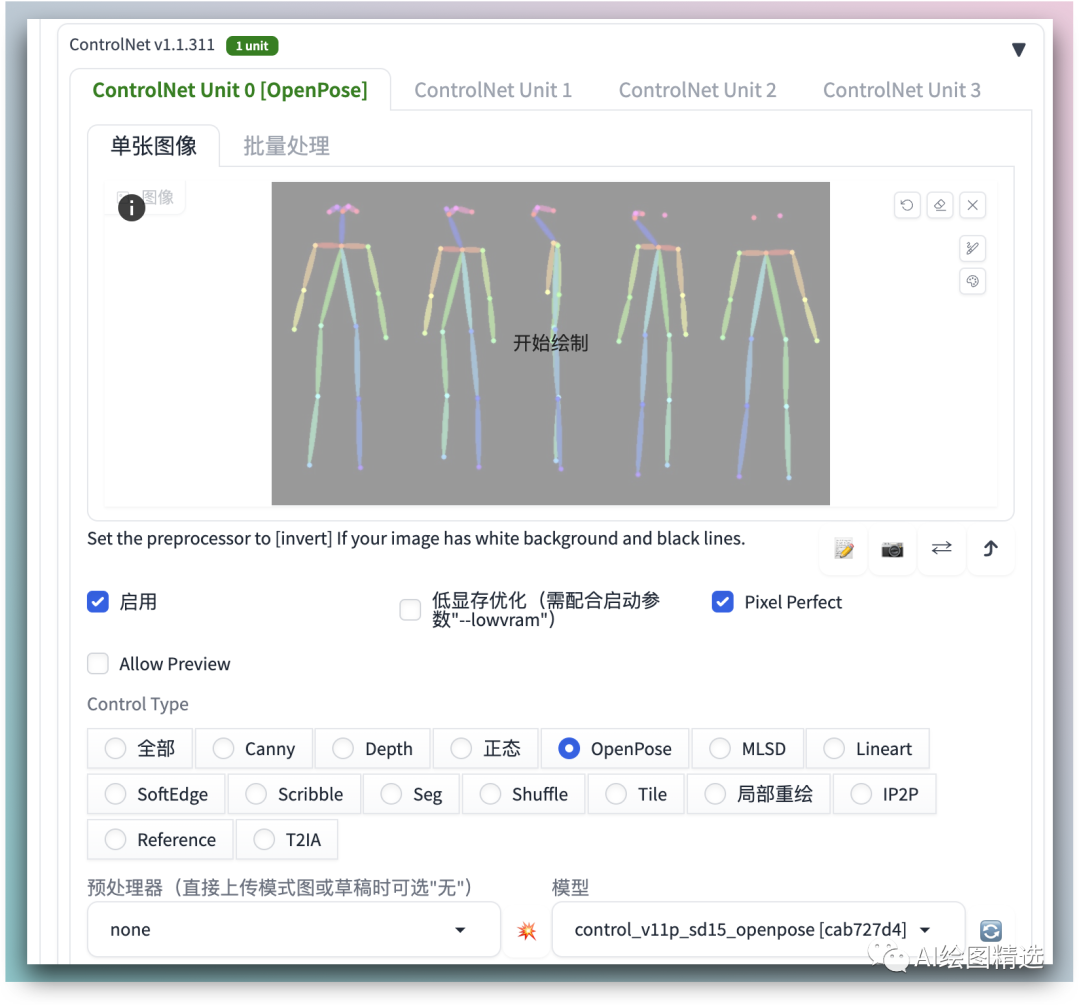

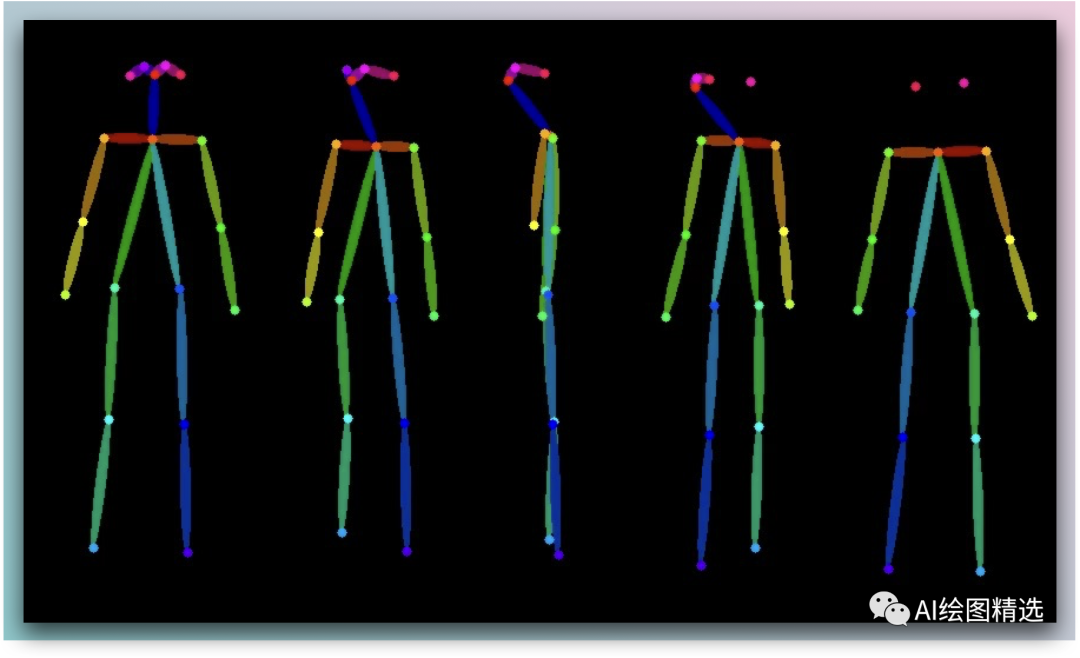

第二步:启用ControlNet

上传三视图特征图(不需要设置

上传三视图特征图(不需要设置

预处理器),只需要将 ControlNet 模型设置为 openpose 模型。原图:https://images-1257364845.cos.ap-

nanjing.myqcloud.com/6461E5A8-C04E-81C2-5CD7-BE8498BAE365.jpeg%60%20-%3E%20%60Image.jpeg

接着我们再次出图看看效果

这一次效果就好很多了。三视图特征图大家也可以通过其它渠道或者自己通过 3d openpose 自己设置。

在来看看其他模型的三视图效果图

如果你觉得课程还不错,别忘了把好内容分享给身边的小伙伴哦 📢

写在最后

感兴趣的小伙伴,赠送全套AIGC学习资料,包含AI绘画、AI人工智能等前沿科技教程和软件工具,具体看这里。

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

4207

4207

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?